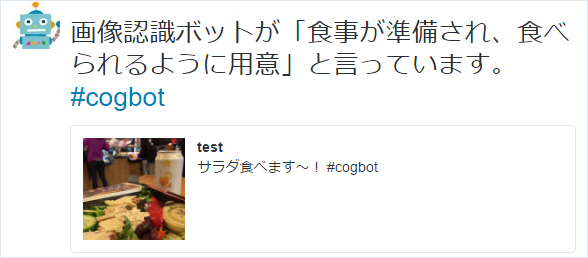

今回は、コーディングレス開発環境であるNode-REDを用いて「Twitterへ投稿された画像に何が写っているか発言する人工知能ジョークボット」を作成しましたので紹介します。本ボットは、Microsoft Cognitive ServicesのComputer Vision APIノードと、WatsonのLanguage Translater APIノードを組み合わせて開発しました。特定のハッシュタグを含む画像付きツイートが投稿されると、下の様に画像に何が写っているかの説明を返信してくれます。

現在、ハッシュタグ#cogbotを付けて画像を投稿すると、ボットが応答するようにしていますので、遊んでみてください。最初にボットの動作デモを掲載します。

目次

(1) 電車の写真

まず、特定のハッシュタグを付けて、下の電車の画像を投稿してみます。

すると、ボットが写真に何が写っているか発言します。「旅客列車が駅に到着」とリプライし、良い感じの認識結末ですね。

(2) カフェの写真

同様にハッシュタグを付けて、カフェの写真を投稿します。

ボットが「サンドイッチとコーヒー1杯」と返しました。右下のフルーツは何か分からなかったようです。

(3) フルーツの写真

次に、フルーツ盛り合わせの写真を投稿します。

「プレートの上のフルーツサラダ」と返ってきました。白いお皿も正しく認識しているようですね。

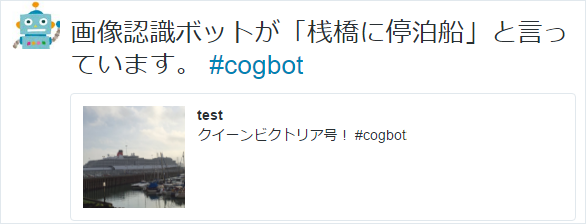

(4) 船の写真

大きな船、クイーンビクトリア号の写真を投稿します。

「桟橋に停泊船」と出力されました。確かに桟橋と船がありますね。手前の小さな船を認識している気もしますが、正解です。

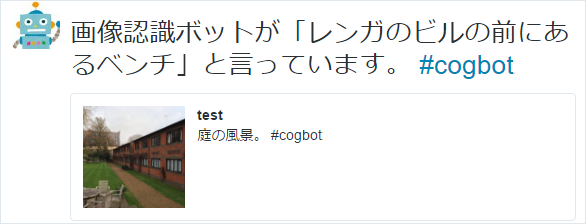

(5) 庭の写真

庭の写真を投稿します。

「レンガのビルの前にあるベンチ」と出力されました。左下の白い椅子のことですね。位置関係も理解している点が素晴らしいです。

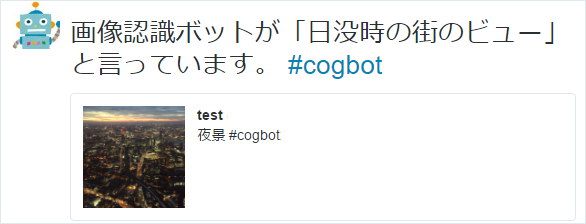

(6) 夜景の写真

夜景の写真を投稿してみます。

「日没時の夜景ビュー」と出力されました。上の方の夕焼けの色を認識して、日没時であることを判定しました。時間帯まで把握する点、凄いです。

(7) お弁当の写真

お弁当の写真をアップロードしてみます。

「さまざまな食材でいっぱいのプラスチック容器」と表示されました。個々の食材を説明すると長くなるので「さまざまな食材」とまとめるざっくり感も人間らしいです。プラスチック容器であることは、光り具合から判定しているのでしょうか。凄いです。

(8) ランチの写真

飯テロすいません。この写真は「さあ、今から食べるぞ。いただきます。」という状況です。

「食事が準備され、食べられるように用意」と出力されました。怖いくらい状況をよく把握していますね。

(9) 時計台の写真

最後に、ロンドンのビックベンの写真を投稿してみます。

「londonの街にそびえる大きな時計塔」と出力されました。ツイート本文にロンドンと書きましたが、本情報は使わず画像のみでロンドンの写真であると回答しています。この様な人工知能APIを手軽に使える素晴らしい時代になりました。

活用した人工知能API

画像から説明文の生成は、Microsoft Cognitive ServicesのComputer Vision API、和訳はBluemix版WatsonのLanguage Translater APIを利用しました。両方のAPIとも1日あたり100ツイート程度の処理量でしたら無料で利用できるため、ぜひ試してみてください。以降でNode-REDを用いた開発方法について説明します。

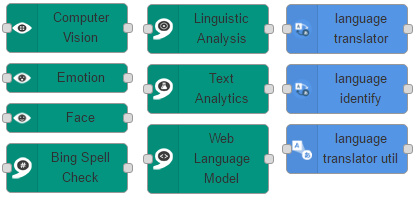

Node-REDへ必要な処理ノードをインストール

今回は、Node-REDがインストールされていることを前提(例えば、Azureへのインストール方法はこちら)とし、Cognitive ServicesノードとWatsonノードをインストールします。Node-REDの右上メニュー->Manage pallette->installを選択した後、下の通り検索キーワードを入力し、必要な処理ノードをインストールします。処理ノード名は、それぞれnode-red-contrib-cognitive-servicesと、node-red-node-watsonです。

ブラウザをリロードすると、左側のパレットにCognitive ServicesノードとWatsonノードが登場します。

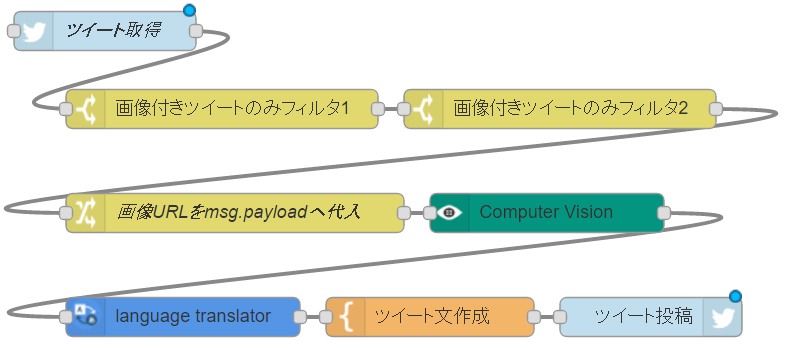

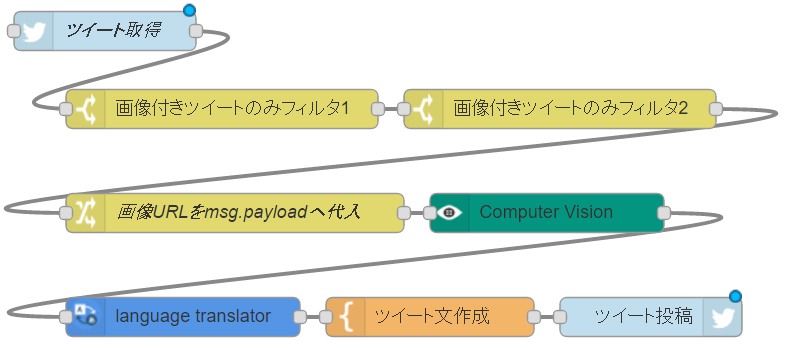

作成した処理フロー

以下の様な処理フローを作成しました。Node-REDはコーディング不要で開発できるため、誰でも30分程で作成することができます。

各処理ノードのプロパティ設定は、以下の通りです。

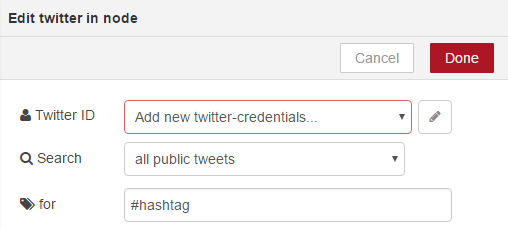

Twitter-inノード(特定のハッシュタグのツイートを収集)

右側に端子があるTwitterノードは、特定のハッシュタグのツイートを収集します。

プロパティ画面では、Twitter IDの右側の鉛筆マークをクリックしてTwitterアカウントと連携させます。次に、forの部分にツイートを取得するハッシュタグを入力します。

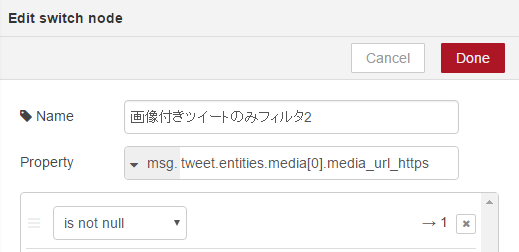

Switchノード(画像が含まれるツイートをフィルタ)

最初2つの黄色のSwitchノードは、Twitter-inノードから受け取ったツイートのうち、画像のURLが含まれるツイートのみに絞り込みます。

上の様に、2回に分けて変数tweet.entities.media[0].media_url_httpsに値が入っているかを判定し、値が入っているツイートのみ次の処理ノードに引き継ぎます。

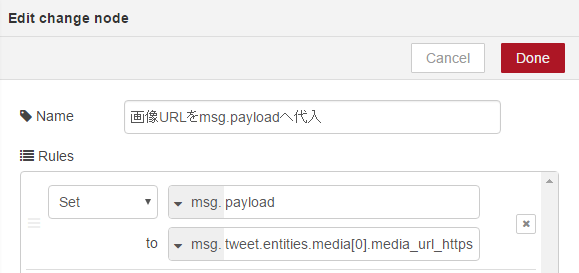

Changeノード(画像のURLを他の変数に格納)

3つ目の黄色の処理ノードであるChangeノードは、画像のURLをmsg.payloadという変数へ格納します。後続のComputer Visionノードは変数msg.payloadの値を入力値として受け付けます。

上の様に、変数tweet.entities.media[0].media_url_httpsに格納されている画像のURLを、変数msg.payloadへコピーします。

Computer Visionノード(画像認識を行い、画像の説明文を取得)

画像のURLをMicrosoft Cognitive ServicesのComputer Vision APIに投げ、画像を解析させ、画像の説明文(英文)を取得します。

プロパティ画面では、OparationとしてDescriptionを選択します。Subscription keyの項目には、Cognitive ServicesのページやAzureポータルから取得したサブスクリプションキーを貼り付けます。(余談ですがOparationの他の項目である、タグ、年齢、性別判定なども人工知能らしさを感じる結果を得ることができますので、ぜひ試してみてください)

Language Translaterノード(英文の説明文を日本語へ翻訳)

説明文は英文のため、その後WatsonのLanguage Translater APIに投げ、日本語化を行います。

プロパティには、必要に応じてBluemixの管理画面から取得したIDとパスワードを貼り付けます。言語は、英語から日本語へ翻訳するよう設定します。

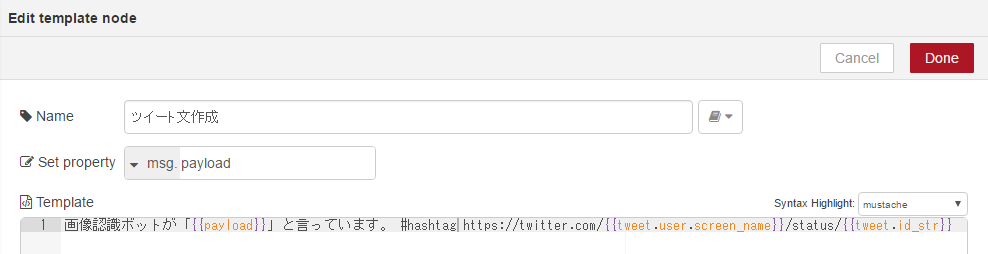

Templateノード(ツイート本文を作成)

Templateノードでは、前のノードから受け取った変数を用いて、ツイート本文を作成します。

mustacheの記述方法を用いて、画像の説明文の日本語訳、元ツイートのURLを生成します。

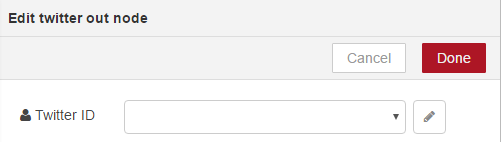

Twitter-outノード(ツイートを投稿する)

最後に、Twitter-outノードを用いて、Templateノードで作成したツイートを投稿します。

プロパティでは、Twitter-inノードと同様に、連携するTwitterアカウントを登録します。

最後に

以上の様にNode-REDを用いることで、人工知能の技術進歩を感じることができる人工知能ボットを、簡単に開発できました。人間が見ると誤認識や誤訳も見つかりますが、人間は人間らしく、人工知能を用いた業務の自動化など、このAPIで実現出来るアイデアを生み出すことが大切と思います。

今回はAzureとBluemixの人工知能APIを組み合わせました。各社人工知能APIは認識精度で比較されがちですが、パッケージ製品売り(翻訳ソフト等)の時代と比較すると、クラウドが主流の現代ではあまり重要ではなくなってきていると考えます。なぜなら、内部の学習モデルは日々改善され、一時期の精度の比較結果は将来大きく変化する可能性が高いからです。また今時の(?)人工知能API提供側は、複雑なアルゴリズムを実装して認識精度を向上させるのではなく、学習データを増やすことと比例して認識精度が向上するようアルゴリズムを組むと思います。そのため、ウェブ上のデータや、ユーザログを大量に持つ企業が有利です。ユーザが人工知能APIを沢山利用すると、ビジネス上でも学習モデル改善の投資優先度が上がりますし、結局、認識精度は開発者が人工知能APIをどれだけ使うかで決まるはずです。

また、各社全く同じ機能を提供している人工知能APIはあまりなく、補完関係にあるものも多いです。そのため、人工知能APIを活用する開発者は、自身のアプリケーションのアイデアを実現するために、各人工知能APIを必要に応じて使えるように知識を付けておくことが重要です。この辺りも各社理解してSDK統一などを行い、開発者に優しく、仲良く市場を広げてほしいですね。

参考

Microsoft Cognitive Servicesについて知りたい方

Microsoft Cognitive Services と Bot Framework を中心に、コグニティブとボットを一緒に勉強する会が毎月開催されているようですよ。さらに詳しく知りたい方は参加してみてはいかがでしょうか?

今回は、「レコメンドする」ことに焦点を当て、Cognitive Services や Azure Machine Learning (Azure ML) を使って実装するための Tips をご紹介いたします。

第5回 Cogbot勉強会! ~ Cognitive や Azure ML でレコメンドを添えよう

https://cogbot.connpass.com/event/50818/