生成ネットワークと識別ネットワークが敵対的に協働することにより実在しない偽画像を生成するGANは、2014年にイアン・グッドフェロー氏らが発表しました。この時発表されたGANにもとづいて、DCGAN、StyleGAN、BigGAN、StackGAN、Pix2pix、Age-cGAN、CycleGANといった様々な派生的GANが生み出されました。その後、GANを使って制作された絵画が有名オークションのクリスティーで落札されたことにより、一躍世間の注目を浴びることとなりました。

もはやAI研究者とAIエンジニアだけのものではなくなったGANは、最近では偽画像とは分からない顔の画像を生成するサイトや動画に移っているヒトの顔を入れ替えるDeepfake動画が発表されたことによって、ますます注目されるとともに悪用への懸念が高まるようになりました。

悪用される可能性があるものも、GANは映画産業をはじめとした様々な業界でのビジネス活用が期待されています。こうしたGANを正しく活用するには、AI業界の関係者さらには社会全体の倫理観が求められていると言えるでしょう。

以下の前編記事では、GANの誕生からGANの派生ネットワークが発表されるまでを解説します。

なお、以下の記事本文はKailash ahirwar氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。

5年前、敵対的生成ネットワーク(Generative Adversarial Network:GAN)はディープラーニングにおける革命を起こし始めた。この革命は、いくつかのメジャーな技術的ブレイクスルーを生み出した。敵対的生成ネットワークは、イアン・グッドフェローとその他の研究者によって著された「敵対的生成ネットワーク」と題された論文― https://arxiv.org/abs/1406.2661 ―によって世に広まった。学会は諸手を挙げてこれを歓迎し、業界もファンファーレを鳴らして迎えた。その後のGANの台頭は、不可避なものであった。

GANに関してもっとも良かった第一のことは、教師なし学習という特徴である。GANはラベル付けされたデータを必要としない。それゆえ、データのラベリングという退屈な仕事が必要されないにも関わらず、GANは強力なものとなるのだ。

第二に、GANの潜在的な使用例がGANをAIにまつわる会話の中心に据えたのだ。GANは高品質の画像を生成でき、写真を強化し、テキストから画像を生成し、画像をある領域からほかの領域に移し替え、顔の画像に写った姿を老化したように変え、さらにもっと多くのことができる。GANができることのリストには終わりがない。この記事では幅広く有名なGANのアーキテクチャを後に採りあげる。

第三に、GANをめぐる際限のない研究があまりにも魅力的だったので、ほかのすべての産業の関心を得られたのだ。この記事の後の節でGANが引き起こした主要な技術的ブレイクスルーについて話そう。

誕生

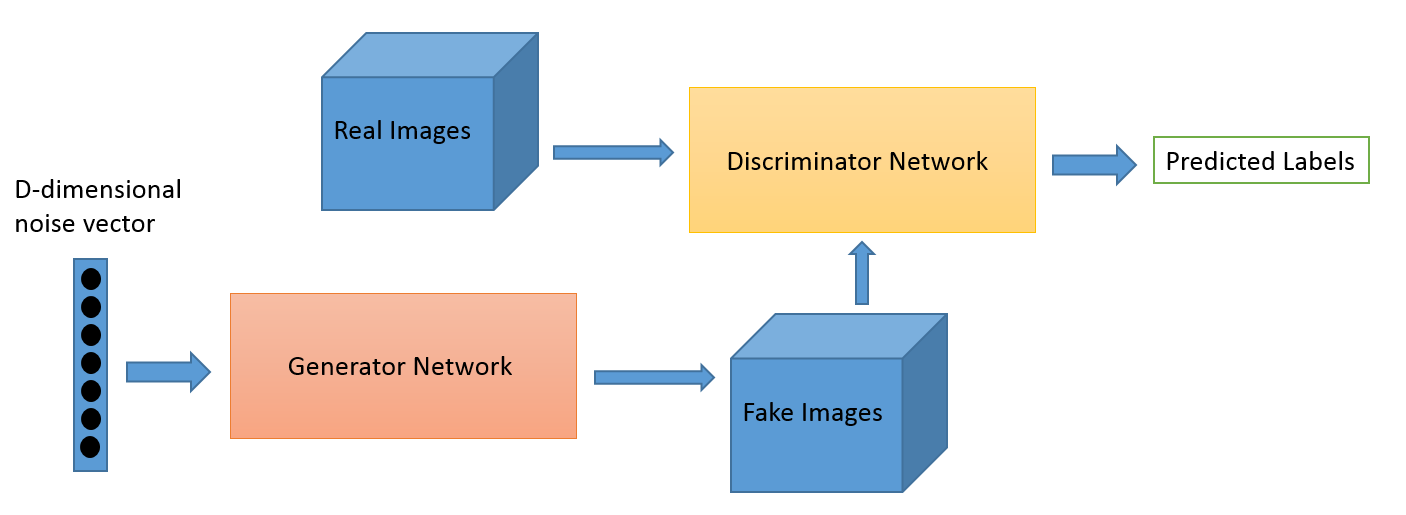

敵対的生成ネットワークあるいは略してGANはふたつのネットワークから構成されており、それらは生成ネットワークと識別ネットワークである。これらふたつのネットワークは、畳み込みニューラルネットワーク、リカレントニューラルネットワーク、そしてオートエンコーダに連なるニューラルネットワークでもあり得る。こうした設定において、ふたつのネットワークは競争的なゲームを行っており、互いを凌駕しようとしている。だがこのゲームは同時にそれぞれの仕事を助けてもいるのだ。何千回もゲームを繰り返した後、それぞれの仕事がすべてうまく行っているならば、生成ネットワークは本物に見えるようなフェイク画像を完璧に生成できるようになり、識別ネットワークは画像がフェイクか本物かを完璧に見分けられるようになるのだ。ほかの術語で言えば、生成ネットワークは潜在空間から採取したランダムなノイズ・ベクトル(すべてのGANのサンプルが潜在空間から採取されるわけではない)を実在するデータセットに見られるひとつのサンプル事例に変形する。GANの訓練は非常に直観的なプロセスだ。両方のネットワークは同時に訓練され、時間の経過とともに両方とも良くなっていく。

GANには画像の生成、アートワークの生成、音楽の生成、そして動画の生成のような数多くの現実世界での使用例がある。同様に画像の品質向上、画像の様式化あるいは色処理、顔の生成、そしてさらに多くの興味深い仕事を実行できるのだ。

クレジット:オライリー

以上に掲げた図は元々のGANネットワークのアーキテクチャを示している。はじめにD次元のノイズ・ベクトルが潜在空間からサンプリングされて、生成ネットワークに与えられる。生成ネットワークはノイズ・ベクトルをあるひとつの画像に変換する。それから生成された画像は、分類のために識別ネットワークに渡される。識別ネットワークは実在するデータセットから得られた画像と生成ネットワークによって生成された画像を保持し続けている。すべてのGANは同じ設計に従っている。以上がGANの誕生である。それではGANの成長ステージを見ていこう。

成長

GANはその成長期においてDCGAN、StyleGAN、BigGAN、StackGAN、Pix2pix、Age-cGAN、CycleGANのような幅広い人気のあるアーキテクチャを生み出した。これらのアーキテクチャは将来有望な結果とともに発表された。こうした結果を見ると、GANが成長期に達したことは明らかなのである。以下では、こうしたアーキテクチャを詳しく見ていく。

DCGAN

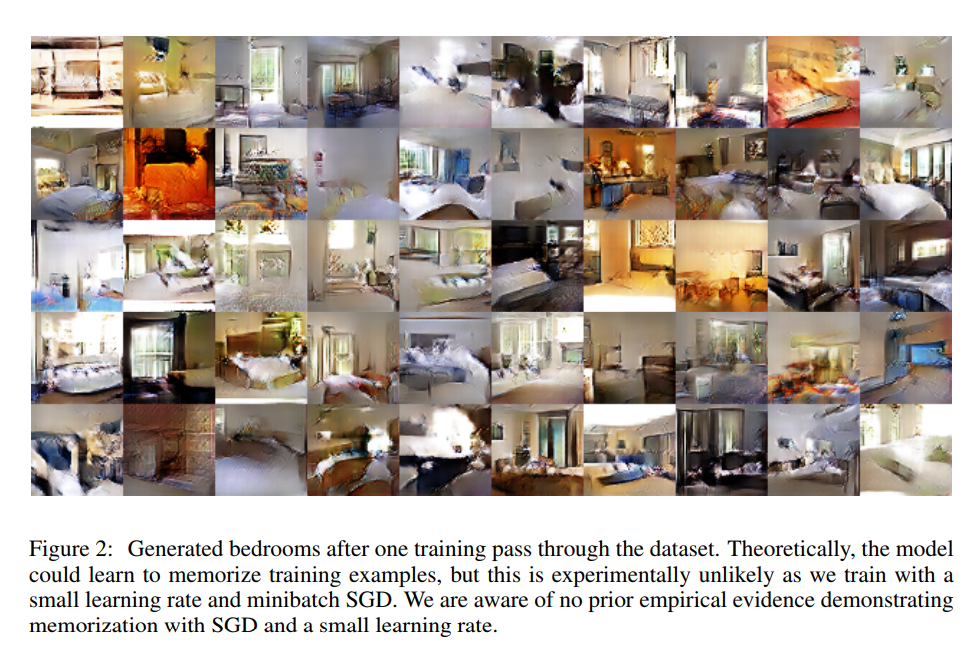

はじめに、畳み込みニューラルネットワークがGANに使われて印象深い結果を出した。これ以前では、CNNは教師ありのコンピュータビジョンのタスクで先例のない成果を示していた。しかしGANの応用分野としては、CNNはまだ探求されていなかった。DCGANはAlec Radford、Luke Metz、Soumith Chintalaが共著した『ディープ畳み込み敵対的生成ネットワークによる教師なし表現学習』という題名の論文で紹介された。この論文では訓練の不安定性、画像様式の崩壊、そして内的な共変量シフト(※訳注1)のような問題に取り組むために大きなアーキテクチャの変化が導入され、この変化の導入がGAN研究におけるメジャーなマイルストーンとなった。この論文以来、数多くのGANのアーキテクチャにはDCGANのそれが基礎として導入された。

ソース: https://arxiv.org/pdf/1511.06434.pdf

ソース: https://arxiv.org/pdf/1511.06434.pdf

画像のキャプションには「データセットを使って1回訓練した後で生成された寝室。理論的にはモデルは訓練した事例を記憶するように学習するのだが、小さい学習率とミニバッチ確率的勾配降下法(stochastic gradient descent:SGD)を使っているので実験上はそうはならない。ミニバッチ確率的勾配降下法と小さい学習率を使っている時には事例を記憶している挙動に関する前提的な経験的証拠は認められなかった」とある。

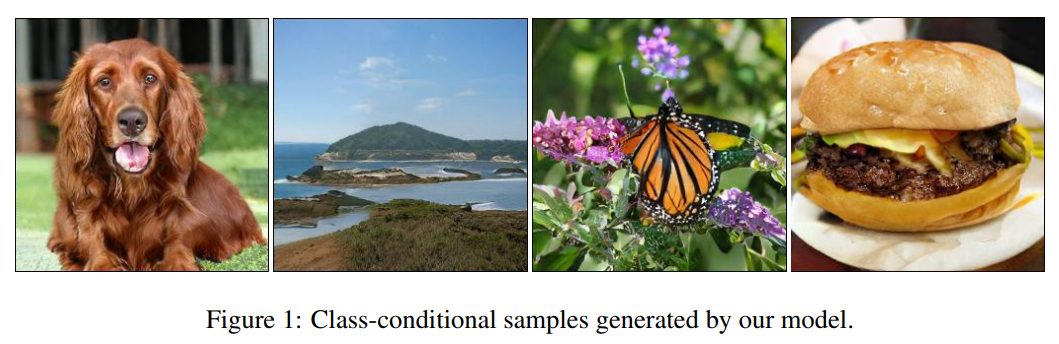

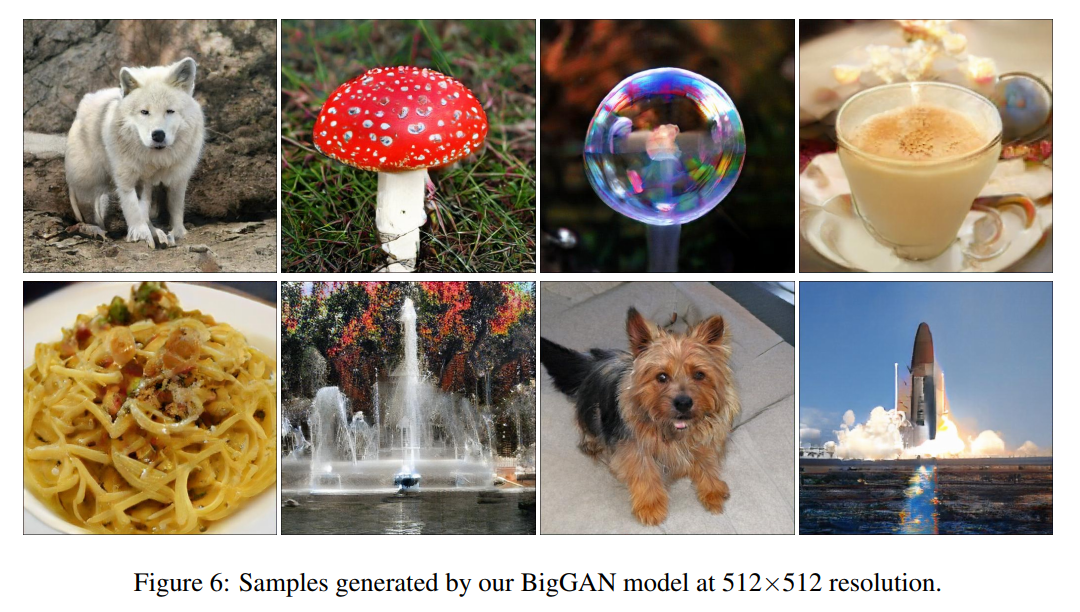

BigGAN

BigGANは画像生成に関するGANの最新の展開である。Googleのインターンと同社傘下のDeepMind所属の研究者は、『高い信頼性をもつニューラル・イメージの統合のための大規模なGANトレーニング』と題された論文を発表した。この論文はhttps://arxiv.org/abs/1809.11096から閲覧できる。この論文はヘリオット・ワット大学所属のAndrew BrockがDeepMind所属のJeff DonahueとKaren Simonyanとコラボレーションしたインターンシッププロジェクトで執筆された。

ソース: https://arxiv.org/pdf/1809.11096.pdf

キャプションには「画像1:われわれのモデルが生成したクラス制約的な事例」とある。

以上の画像はBigGANによって生成されたのだが、その印象的なまでの品質を見れるだろう。GANは高い信頼性をもって画像を生成し、なおかつ画像の(画像のジャンルを意味する)バラエティのあいだでのギャップが少ない。BigGAN発表直前におけるInception最高スコアは52.52だったのだが、BigGANは166.3を達成し、100%もの改善となる。同様にFrechet Inception Distance(FID)を18.65から9.6に改善した(※訳注2)。これらの結果は非常に印象的であり、この領域においてさらなる進展を見たいものである。もっとも重要な改善は、ジェネレータに直交正則化(※訳注3)を使ったことである。

ソース:https://arxiv.org/pdf/1809.11096.pdf

キャプションには「画像6:解像度512 x 512でBigGANモデルによって生成されたサンプル」とある。

以上の画像は印象でしょう!

FIDとは、Inceptionスコアでは考慮されていなかった識別対象としての実在の画像を考慮した指標。値が低ければ高品質となる。

StyleGAN

StyleGANはGAN研究におけるもうひとつのメジャーなブレイクスルーである。StyleGANは『敵対的生成ネットワークのためのスタイルベースの生成アーキテクチャ』という題名でNVIDIAによって発表された。この論文は次のリンクhttps://arxiv.org/pdf/1710.10196.pdfから閲覧可能だ。

StyleGANは顔認識のタスクにおいて新記録を樹立した。この手法における核となるアルゴリズムは、スタイル変異技術あるいはスタイル混合である。顔の生成以外でも、StyleGANはクルマや寝室などに関して高い信頼性のある画像を生成することができる。この手法はGANの研究領域におけるメジャーな進歩であり、ディープラーニングの研究者にインスピレーションを与えた。

StackGAN

StackGANはHan Zhang、Tao Xu、Hongsheng Liとその他の研究者によって共著された『StackGAN:スタックな敵対的生成ネットワークを使ったテキストとフォトリアルな画像の統合』という題名の論文によって提案された。この論文は次のリンク先https://arxiv.org/pdf/1612.03242.pdfから閲覧できる。彼らはテキストと画像の統合を探求するためにStackGANを使い、印象深い結果を出した。StackGANとは、テキストによる記述が与えられた時にリアルに見える画像を生成するネットワークの組である。わたしが出版した書籍『敵対的生成ネットワーク・プロジェクト』には、StackGANを詳述した章がある。

ソース:https://arxiv.org/pdf/1612.03242.pdf

ソース:https://arxiv.org/pdf/1612.03242.pdf

生成画像に与えられたテキストは左の列には「この鳥は頭と翼に黒色があるが白色で、オレンジ色のくちばしがある」、中央列には「この鳥は腹部と足の付け根が黄色、背中と翼が灰色、そして喉元と首筋が茶色で黒い顔を持っている」、右列は「この花は黄色くて短い花糸(かし)の輪を取り囲むようにして重なり合っているとがったピンク色の花びらをもっている」とある。

上の画像を見ればわかるように、鳥について記述されたテキストが与えられた時にStackGANは鳥に見えるリアルな画像を生成する。もっとも重要なのは、与えられたテキストに正確に似ている画像を生成することである。テキストと画像の統合にはテキストによる記述から画像を生成すること、テキストによるストーリー形式からコミック形式に変換すること、そしてテキストの記述に関して内部的な表現を作るような多くの現実世界における応用がある。

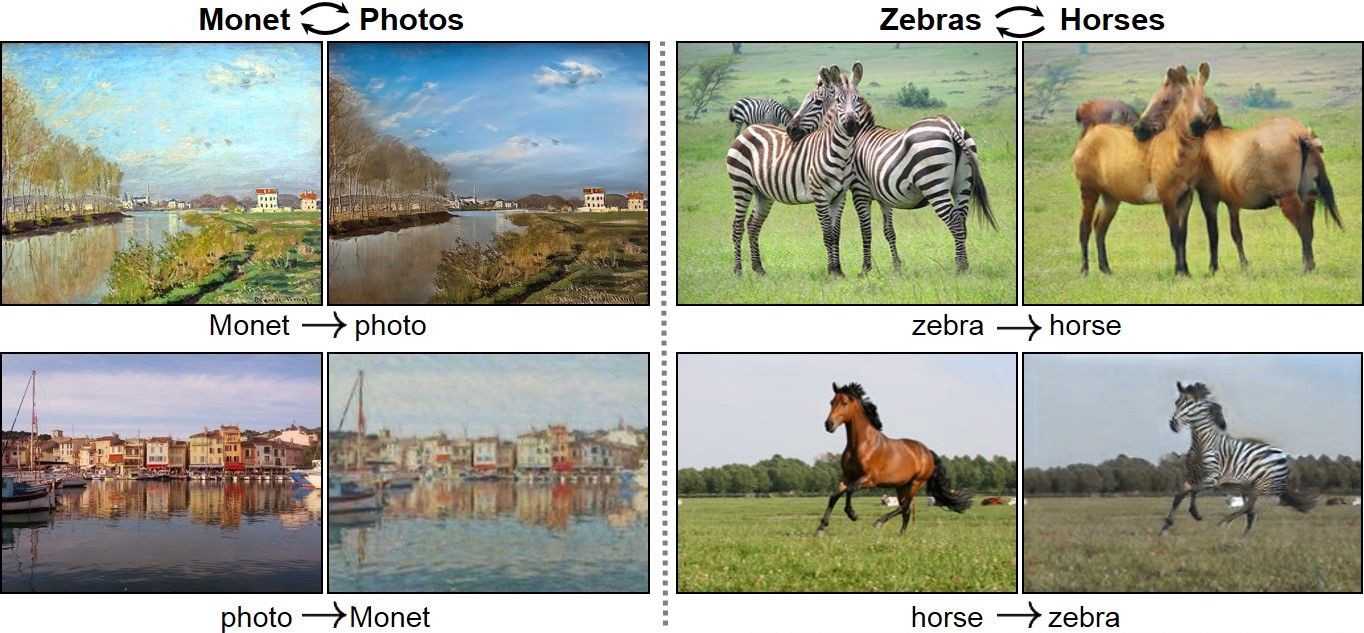

CycleGAN

CycleGANには実に様々な興味深い事例がある。その事例には写真から絵画への相互変換、夏に撮影した画像と冬のそれの相互変換、あるいはウマの画像とシマウマの画像の相互変換といったものだ。CycleGANはJun-Yan Zhu、Taesung Park、Phillip Isola、そしてAlexei A. Efrosが共著した『周期的構成の敵対的ネットワークを使った対となっていない画像から画像への変換』という題名の論文によって提案された。この論文の次のリンクhttps://arxiv.org/pdf/1703.10593.pdfより閲覧できる。CycleGANにおいては、様々な画像から画像への変換事例が探求された。

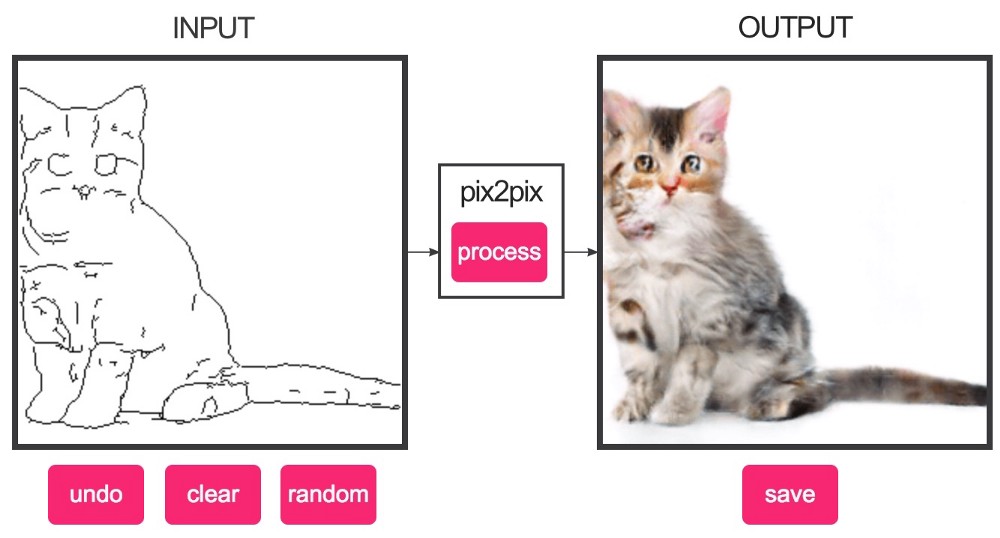

Pix2pix

画像から画像への変換タスクに関しては、Pix2pixも印象深い結果を出している。夜間撮影の画像から日中の画像への相互変換、白黒画像に着彩する、スケッチを画像に変換するような事例すべてにおいて、Pix2pixは優れた結果を出した。Pic2pixはPhillip Isol、Jun-Yan Zhu、Tinghui Zhou、そしてAlexei A. Efrosが共著した『制約的敵対的ネットワークを使った画像から画像への変換』という題名の論文によって提案された。この論文の次のリンクhttps://arxiv.org/abs/1611.07004より閲覧できる。

以上の画像はインタラクティブなデモについての画像である。このデモを使えばスケッチからリアルな画像を生成できる(※訳注5)。

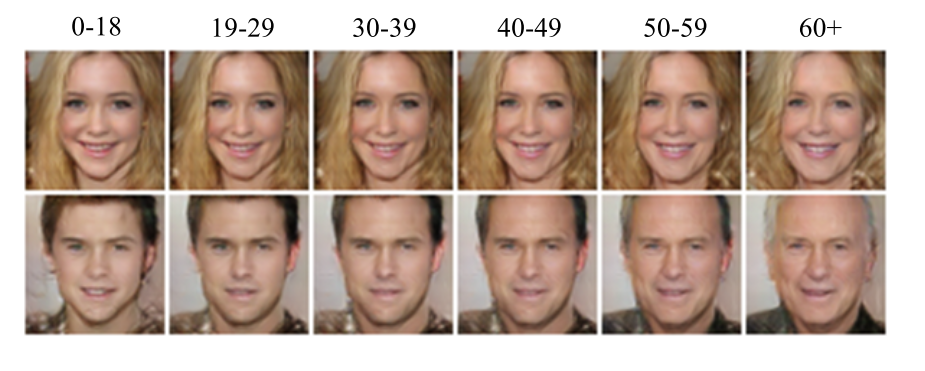

Age-cGAN(年齢制約的敵対的生成ネットワーク)

顔の老化の画像化には年齢を横断する顔認識、迷子の捜索、そしてエンターテインメントを含む様々な産業で活用事例がある。制約的GANを使った顔の老化はGrigory Antipov、Moez Baccouche、そしてJean-Luc Dugelayが共著した制約的敵対的生成ネットワークを使った顔の老化という題名の論文によって提案された。この論文は次のリンクhttps://arxiv.org/pdf/1702.01983.pdfより閲覧できる。

以上の画像は、Age-cGANがどのようにしてソースとなる年齢の顔から目標となる年齢の顔に変換しているかを示している。

以上が幅広い人気のあるGANのアーキテクチャである。以上のほかにも何千というGANアーキテクチャが存在する。GANの研究は、ユーザのニーズに適ったアーキテクチャへの要求に依存している。

(後半に続く…)

原文

『The Rise of Generative Adversarial Networks』

著者

Kailash Ahirwar

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん