CVPR(Computer Vision and Pattern Recognition:コンピュータビジョンとパターン認識)とは、物体検知や画像認識に関する世界的な学会のひとつです。2019年に開催された同学会のカンファレンスでは5,165本の論文が提出され、そのうち1,300本が採択されました。同氏は採択された論文のなかから現在の研究トレンドを代表していると思われる5本の論文を選び、その内容を解説しています。そうした論文は、以下のようなものです。

- カメラと被写体の両方が動く動画における深度評価の研究。学習データにマネキンチャレンジ動画を活用した。

- 動画内のオブジェクトを分割する方法を改善する研究。オブジェクトを分割する精度がもっとも高いコマを基準にするようにした。

- 手のかたちと姿勢を認識するモデルの研究。弱教師あり学習を使って学習データを生成した。

- 100種類以上のカテゴリーを認識するモデルの研究。アーキテクチャにナレッジグラフを導入した。

- 顔誤認攻撃対策に関する研究。13種類の顔誤認攻撃を認識・分類できるようにした。

以上の諸論文より、画像認識の研究トレンドはより複雑なタスクに応用される技術を探求する方向に向かっている、と言えるのではないでしょうか。

以下の後編にあたる記事本文では、上記論文のうち3~5本目の論文を紹介します。

なお、以下の記事本文はPriya Dwivedi氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。

3.単一のRGB画像から3次元的な手のかたちと姿勢を評価する

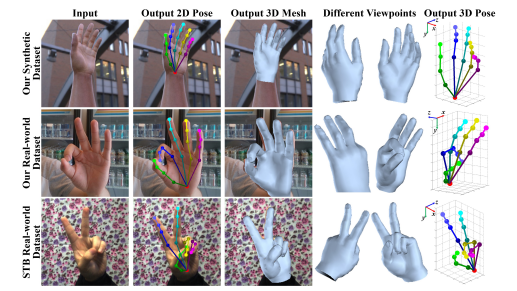

3次元的な手のかたちと姿勢の評価は、近年非常に活発に研究されている領域である。こうした研究は、VRやロボット工学に応用される。以下の画像に示すように、紹介する論文は3次元的な手の姿勢とその手に関する3Dメッシュ(※訳註1)を生成するために単眼カメラで撮影したRGB画像を使っている。

単一の画像から3Dハンドメッシュを生成する

論文では、手に関する完全な3Dメッシュを再構成するためにグラフCNN(※訳註2)を使っている。ここにグラフCNNというトピックに関する良質な導入記事がある。ネットワークを訓練するために、論文の著者は実在の手にもとづいた3Dメッシュと3Dの姿勢情報の両方を含んだ統合的な大規模データセットを作成した。現実の世界を撮影したRBG画像における本物の3Dメッシュに注釈をつけるのは非常に手間と時間がかかる。手間と時間がかかるにもかかわらず、以上のような現実の世界にもとづいた統合的なデータセットで訓練されたモデルは、かたち(メッシュ)と姿勢というふたつの領域のあいだにギャップがあるためにたいてい満足のいかない結果しか出さない。こうした問題を取り組むために、著者は新規の弱教師あり学習(※訳註3)の方法論を提案する。具体的には、3Dメッシュの生成に関する学習に深度マップを使うというものだ。というのも、深度マップは現実の世界から学習データを収集する時にRGB-Dカメラを使って簡単に入手できるからだ。論文では以上のような学習データと訓練プロセス等に関して非常に詳しく論じている。もし手の立体的構造の検知に関する研究領域に興味があるなら、ぜひ論文を読んでみよう。

通常のCNNにおいては各ピクセルは8方向に格子状に並ぶという関係にあるが、グラフCNNにおいてはノードとエッジの位置関係により様々な関係を形成している。グラフCNNは、任意の入力データからグラフ構造を抽出して認識する。

弱教師あり学習は誤ったラベルが付与された学習データを使ってモデルを生成することが可能なため、ラベル付与作業が膨大な場合にそうした作業負担を軽減して活用できる技法と言える。

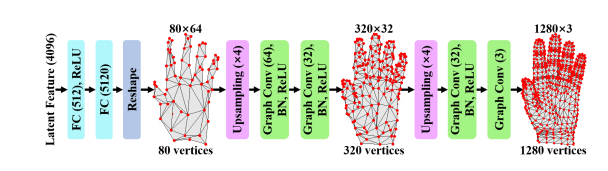

わたしにとって興味深かったのは、メッシュを生成するのに使われているグラフCNNのアーキテクチャである。論じているネットワークに対する入力はRGB画像から隠れベクトル層に送られる。入力データはふたつの完全結合層を通って、80 x 64の特徴量をもった粗いグラフ構造の出力となる。さらにその出力は複数のアップサンプリング層とグラフCNN層を通って、最終的には1,280の頂点をもつ豊かな詳細をもつ出力となる。

3Dハンドメッシュモデルのアーキテクチャ

4.推論RCNN:適応的グローバル推論を大規模な物体検知に統合する

推論RCNNの出力

物体検知は、共通して使われる多くのコンピュータビジョンのアプリが開発されたために大きな人気を博するようになった。Faster RCNN(※訳註4)はよく使われる人気の物体検知モデルである。物体検知とFaster RCNNについて学びたい場合は、このブログ記事をチェックしてほしい。物体検知モデルは人気があるものも、ほとんどのモデルは検知する種類が少ないときに成功している。せいぜい100種類以下だ。紹介する論文は、数千種類ものカテゴリーを伴う大規模な物体検知の問題に取り組んでいる。この問題は、広範囲にわたるデータ分布、深刻な遮蔽性、そして分類クラスの曖昧さのために非常に難しい挑戦となっている。

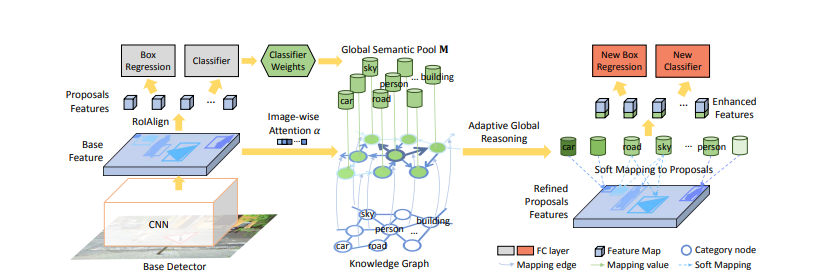

推論RCNN(Reasoning-RCNN)は、一般的なヒトの知覚に関する知識がエンコードされたナレッジグラフを構築することによって大規模な分類を実行する。ナレッジグラフとは何か?ナレッジグラフには、(近さのような)空間的関係、(「運転する(drive)」、「走る(run)」のような)主語-動詞―目的語関係、色、サイズ、材質のような類似性を示す属性にもとづいたオブジェクト間の情報をエンコードしている。下のグラフに示されているように、ナレッジグラフにおいてはそれぞれの分類カテゴリーが視覚的関係で示され、それらが互いに近接しているのだ。

ナレッジグラフ

アーキテクチャの観点から見れば、推論RCNNはFaster RCNNのような標準的な物体検知モデルのうえに推論ネットワークを置いている。前の分類器(つまり標準的な物体検知モデル)における重みは、全カテゴリーをカバーしているグローバル・セマンティック・プールを生成するために集められる。グローバル・セマンティック・プールにおける処理は適応的グローバル推論モジュール(adaptive global reasoning module)に送られる。(適応的グローバル推論モジュールが出力する)強化されたカテゴリーのコンテクストは、ソフトマッピング・メカニズムによって提案された領域に再びマッピングされる。最終的には、特徴が強化されたそれぞれの領域は分類と位置特定の両方のパフォーマンスを隅々まで改善するために使われる。以下の模式図はモデルのアーキテクチャを表している。このアーキテクチャをより詳細に理解するためには論文を参照してください。

モデルは3つの主要なデータを使って訓練と評価が行われた。その3つとはVisual Gnome (3,000 カテゴリー)、 ADE (445カテゴリー) 、そして COCO (80カテゴリー)である(※訳註5)。モデルの評価ではmAPスコア(※訳註6)を測定しVisual Gnomeを16%、ADEを37%、そしてCOCOを15%それぞれ改善した。

ADEとは、マサチューセッツ工科大学が開発した画像をオブジェクトと背景に分けるシーン解析に用いられる画像データセット。学習データセットとして20,210枚の画像が用意されている。

COCO(Common Object in Context)とは、画像分割の学習のために用意されたデータセット。33万枚の画像と80種類のオブジェクトカテゴリーを含んでいる。

mAPとは、様々なオブジェクト認識に関するAPを平均した評価値となる。例えばリンゴの認識に関するAPが0.5、ネコの認識に関するそれが0.7だとすると、この画像認識モデルのmAPは0.6となる。

訓練のソースコードはこちらのリンクでオープンソースになる予定である。まだ利用できない(※訳註7)。

5.ゼロショット顔誤認対策のためのディープラーニング

顔検知は最近数年間でめざましく進歩し、現在、顔検知と顔認識のシステムは多くのアプリに共通して使われている。実際、顔を検知して認識し、その顔の感情を理解するシステムを構築するには8行のソースコードを書くだけで可能だ。その方法に関しては、こちらのブログ記事を参照してほしい。

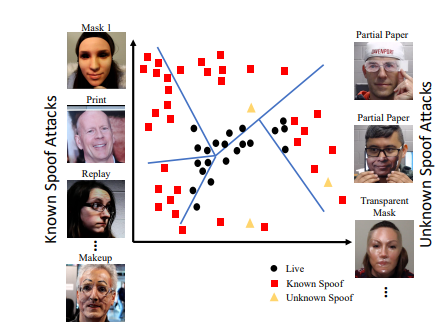

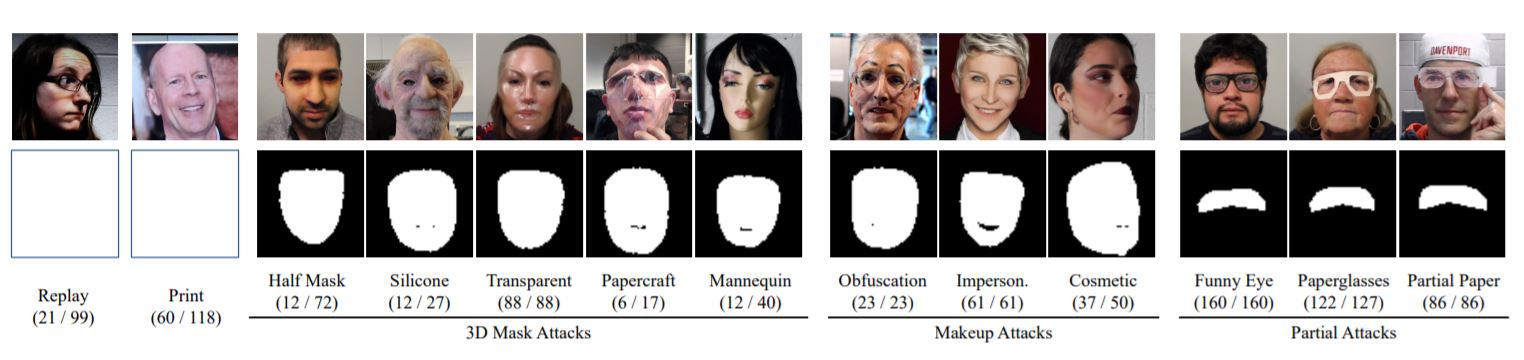

しかし、不正アクセスに成功するために顔検知が欺かれる恒常的な危険性がある。こうした危険性に対して、顔誤認対策は顔認識システムがフェイクの顔を真正なユーザの顔と認識してしまうことを防ぐように設計されている。進化した顔誤認対策の方法が開発されいるものも、新しいタイプの誤認アタックが考案され、既存のすべてのシステムの脅威となっている。紹介する論文では、知られていない顔誤認攻撃を検知する概念としてゼロショット顔誤認対策(Zero-Shot Face Anti-spoofing:略してZSFA)というものを導入している。先行するZSFAの研究ではプリントあるいは再現のような1~2種類の攻撃しか対象にしていないので、ZSFAに関する考察が制限されたものであった。紹介する研究ではZSFA問題として13種類の誤認攻撃を調査している。そうした攻撃にはプリント、再現、3Dマスクなどといったものがある。以下の画像は、様々な種類の顔誤認攻撃を表している(※訳註8)。

| 攻撃名 | 概要 |

|---|---|

| 再現 | 顔マネして認証 |

| プリント | 紙に印刷された顔を認証 |

| ハーフマスク | 顔の前半分だけを覆うマスクで認証 |

| シリコン | シリコン製のマスクで認証 |

| 透明マスク | 半透明のマスクで認証 |

| ペーパークラフト | 紙製のマスクで認証 |

| マネキン | マネキンの顔で認証 |

| 曖昧化 | 顔の一部を影などで分からなくして認証 |

| 没個性化 | 顔の個性を取り除いて認証 |

| 化粧 | 化粧して認証 |

| フルアイ | 眼を覆ったメガネを着けて認証 |

| ペーパーグラス | 紙製のメガネを着けて認証 |

| 部分的ペーパー | 眼の部分を紙で覆って認証 |

13種類の顔過誤認攻撃[/caption]

13種類の顔過誤認攻撃[/caption]

顔誤認には(顔写真をプリントするような)様々な形態のプリント、動画で再現する、3Dマスク、眼を切り抜いた顔写真、化粧、透明マスク等が含まれ得る。論文は、教師なし学習の方法を使って偽画像から有意味な埋め込み情報を学習するディープツリーネットワークを使うことを提案している。この埋め込み情報は、ヒトによる凝視のような意味空間によってモデル化される(※訳註9)。論文では、こうした埋め込み情報を学習するために偽画像のデータセットを作った。論文における検証においては、未知の顔誤認攻撃はもっとも属性が近い顔誤認検知を見つけるためにその埋め込み情報が評価された。

本記事では13種類の顔誤認攻撃をベクトル空間上の情報に変換したもの、という意味で使われている。顔誤認攻撃の埋め込み情報は(生身のヒトの眼があるか否かという)「ヒトの凝視」といった要素等から構成されている。

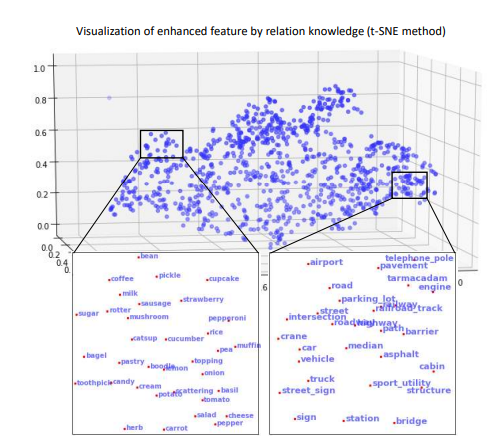

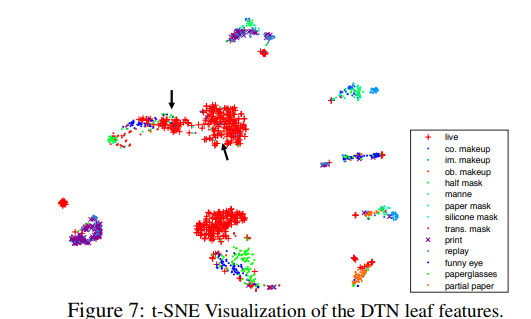

ディープツリーネットワークとそれを訓練するプロセスに関するモデルのアーキテクチャをより知りたい場合は、こちらの論文を読むこと。論文では生身の顔(つまり本物の顔)を様々なタイプの誤認から区別する埋め込み情報を生成している。こうした区別する処理は、以下のt-SNE(※訳註10)でプロットした画像を参照すること。

以上の論文は驚くべきものである。現実的な問題に対処する有望な研究と言える。

結論

コンピュータビジョンに関する最新の研究のすべてに目を通すことは、魅力的である。本記事でシェアした論文は氷山の一角に過ぎない。読者諸氏にはわたしのGitHubを使ってCVPRの論文を分類して自分の興味にあったものを選んでくれることを願っている。

わたしはコンピュータビジョンとディープラーニングの全般について非常に熱狂している。わたしはディープラーニングに関するコンサルティングに従事しており、興味深い問題に取り組むことを好んでいる。わたしは、多くのスタートアップがAIにもとづいた革新的なソリューションを実装することを手助けしてきた。わたしたちの仕事は、次のサイトで調べてくださいーhttp://deeplearninganalytics.org/.

わたしが執筆した他の記事は、以下から読むことができます。

https://medium.com/@priya.dwivedi

もし読者諸氏がわたしたちとコラボレーションできるプロジェクトを持っているならば、わたしのウェブサイトかinfo@deeplearninganalytics.orgを使ってわたしにコンタクトしてください。

参考リンク:

-

- CVPR

- このブログで使った画像は、各論文から引用したものです。

原文

『Latest Computer Vision Trends from CVPR 2019』

著者

Priya Dwivedi

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん