顔写真はwikipedia日本版のユヴァル・ノア・ハラリ、ケビン・ケリー、ニック・ボストロム、レイ・カーツワイルから引用

▼前編記事はこちら

2010年代から始まった第3次AIブームは、その勢いにかげりが生じているのではないかという批判を受けながらも、大局的には現時点でも進行していると言えます。その一方でAIによる差別や監視、さらにはAIによる労働代替が引き起こす失業への懸念といった新しいAI社会問題も注目されるようになりました。

AI社会問題を根本的に解決するには、「AIは社会と歴史にどのような影響を及ぼすのか」というAIに対する深い洞察が必要となるはずです。

近年注目されているAI思想家たちは、AIに対する深い洞察を独自に展開しています。AI思想家たちが説くアイデアのなかにAI社会問題を根本的に解決する糸口があるはずです。

前編・後編から構成されるこの記事の後編では、汎用人工知能(Artficial General Intelligence:AGI)の実現可能性をめぐる問題を「AIのハード・プロブレム」として定式化します。さらにAI社会問題のなかでも重要なAIによる失業、AI開発における倫理的基準、およびスーパーインテリジェンスと安全保障という3つについて、AI思想家のアイデアを援用しながら解決の糸口をさぐっていきます(AI思想家の解説は、前編を参照)。

なお、以下のAI社会問題に関する記述は、見出しごとに独立して読むことも可能です。時間の余裕のない場合は、興味のあるAI社会問題だけ読んでも理解できます。

AIのハード・プロブレム

現在明らかになっているAI社会問題のひとつとして、「汎用人工知能(AGI)は実現可能か」というものがあります。この問題が工学的であると同時に社会的であるのは、もしAGIが実現した場合、人類に多大な影響が及ぶことが明白だからです。この問題にはさまざまな派生形があり、それらには「シンギュラリティは到来するのか」「スーパーインテリジェンスは実現可能か」「意識を工学的に再現可能か」「意識のアップロードは可能か」といったものがあります。

もっとも、AGIの実現可能性に関しては、世界的な思想家たちのあいだでも見解が割れていることからかわるように、AIに関するもっとも難解な問題のひとつと考えられます。この問題の難解さは、知能と意識の関係に不明な点が多いことに由来します。

人間が画像を認識したり計算したりする場合、画像認識や演算といった認知活動が意識経験を伴って体験されます。意識経験という表現で言われているのは、「非物理的な現れを伴った体験」(この現れはクオリアと呼ばれる)という事態です。

機能的には人間と同等以上の画像認識や演算を実行する特化型人工知能は、明らかに人間のような意識経験を伴うことなく認知活動を遂行しています。こうした特化型人工知能を寄せ集めれば、AGIは実現するのでしょうか。この問いかけは、AGIには意識経験が不可欠か否か、というようにとらえ直すことができます。

AGIと意識の関係に関して、ハラリは以下のような3つの可能性を挙げています。

- 仮説1(意識人間局在説):AGIの実現には意識が不可欠である。そして、意識は人体によって実現している有機化学的構造体のみに認められる現象である。したがって、人体を有さないAGIの開発は失敗に終わる。この仮説は、ケリーが支持している。この仮説には映画『ブレードランナー』に登場する人造人間レプリカントのような人体に限りなく酷似した有機化学的存在を開発すれば、AGIが実現するかも知れないという余地がある。しかし、そんな存在を開発するより人間を育成するほうが安上がりだろう、とケリーは指摘している(※脚註1)。

- 仮説2(工学的有意識AGI実現説):AGIの実現には意識が不可欠である。そして、意識は人体だけではなく工学的にも再現可能な現象である。したがって、意識を工学的に再現できる機構を開発できれば、AGIは実現する。こうした機構として、カーツワイルとボストロムは全脳エミュレータを想定している。

- 仮説3(工学的没意識AGI実現説):AGIの実現には意識は不要である。それゆえ、人間のあらゆる認知活動を工学的に実現できれば、AGIは実現する。このAGIは意識をまったく欠いているが、機能的には人間と同等以上の認知活動ができる。ボストロムによれば、この種のAGIは自己進化的機能を実装した「シードAI」を開発することによって実現するかも知れない。

現時点の工学的および哲学的知識にもとづいて、以上の3つの仮説から正しいものを選ぶのは極めて困難だと言わざるを得ません。というのも、これらの仮説の正しさを検証するには、人間の意識発生のメカニズムに関する理論が求められると考えられるからです。

人間の意識発生のメカニズムに関する研究は、哲学者のデカルトが心身二元論を提唱して以来、「心身問題」という哲学的問題として、およそ370年にわたり取り組まれています。20世紀になって、この問題をチャーマーズが「意識のハード・プロブレム」と再定式化して、脳の物理的・生化学的研究とは異なるカテゴリーの問題と再認識されました。この哲学上の難問に関しては、ハラリが指摘しているように、諸説あるものも現時点で最終解決をもたらしたと認定された理論はまだ存在しません。

AGI実現のために必要とされる理論がいまだ存在していないため、「AGIは実現するのか」と問われた場合、「実現する」または「実現しない」と断言できるだけの根拠がないので、「わからない」と答えるのがもっとも誠実かつ妥当でしょう。AGI実現にまつわる困難さは、前述のように意識のハード・プロブレムが未解決なことに由来しています。それゆえ、AGI実現にまつわる問題はその困難さの由来になぞらえて「AIのハード・プロブレム」と呼ぶことができるでしょう。

AIのハード・プロブレムが定式化されたところで、改めて「2045年、シンギュラリティは到来するのか」と問われれば、次のように答えることができるでしょう。AIが動作する工学的駆動原理と意識のハード・プロブレムを解決する心の理論を架橋する「AIと心の統一理論」が存在しない現状が続く限り、2045年あるいは2145年になっても、シンギュラリティは到来しないでしょう。この答えを裏返して言えば、AIと心の統一理論が確立ささればシンギュラリティは実現するかも知れないし、その統一理論を確立する努力を続ければシンギュラリティに近づくだろう、となります。何だか奥歯に物が絡まったような答えになってしまうのは、シンギュラリティ成就のために解決する必要のあるAIのハード・プロブレムが困難な問題だからです。

AIのハード・プロブレムに対して、「解決しない」(つまりAGI実現を目指さない)という立場をとることも可能でしょう。しかし、もしこの問題が解決すれば、人類に大きなメリットがもたらされるはずです。

AGIが実現したあかつきには人類に大きなメリットがもたらされると期待できる限り、少なくともAI業界と現代哲学は、AIのハード・プロブレムに取り組むべきです。もっとも、この問題はその困難さが計測不能なゆえに難しいという側面があるので、「細く長く」取り組むのが望ましいでしょう。この問題に関しては、研究予算と人的リソースを2倍にしたからといって、2倍早く解決に近づくとは言い難いのです。また、研究進捗の予想が難しいので、この問題の解決を前提とした事業計画や政策の立案は厳に慎むべきでしょう。

ちなみに、前述のようにケリーとハラリはAGI実現について懐疑的な態度をとっていますが、AGIは決して実現しないとも考えておらず、むしろわからないことが多いからこそAGIの研究開発は続けるべき、というスタンスをとっています。

3つの重要なAI社会問題

AIのハード・プロブレム以外にも、AIに関する重要問題はあります。以下では今日重要と考えられるAIと労働、AI倫理、そしてAIと安全保障に関して、AI思想家のアイデアを手がかりにしてその解決の糸口をさぐります。

AIによる失業問題とベーシックインカム

AIが引き起こす労働環境の変化は、AI社会問題のなかでもっとも関心が寄せられているものと言えます。テクノロジーによる人類の救済を固く信じるカーツワイルは、シンギュラリティに至る過程で「肉体的、精神的ルーティンワークの全てが事実上、オートメーション化」されて、反発を受けながらもAIによる労働からの解放は社会的に受け入れられる、と考えています。

AIによる労働代替が穏やかに進んでいる現状を見ると、カーツワイルの主張は的外れなものでもないように思われます。しかし、同氏が説くテクノロジーによる労働からの解放が実現する過程では、試練が待っていることでしょう。というのも、AIによる労働代替は経済格差を広げると予想されるからです。AIをはじめとする情報テクノロジーは、「勝者総取り」の市場を強化する傾向があります。この傾向はGoogleによる検索技術の独占(Google検索にはBERTが使われている)、さらにはGAFAによる世界経済の支配というかたちですでに確認できるものです(※脚註2)。こうした圧倒的な勝者が台頭する一方で、大量の敗者が生まれます。この敗者のなかには、AIによる労働力にも太刀打ちできずに労働市場そのものから締め出される者もいるかも知れません。この締め出しこそが「AIによる失業」という現象です。この現象は、労働力として価値そのものを喪失する可能性をはらんでいるという点において、現在の失業とは異なるものです。ハラリは、労働力としての価値を喪失した人間を「無用者」と呼んでいます。

AIによる失業が深刻な社会問題になるという懸念に対して、AIによって創出される仕事もあるという指摘があります。AIエンジニアやデータサイエンティストなどが、AIによって創出された仕事の最たる事例でしょう。しかし、AIによる失業者がAIによって創出された仕事に就けるわけではない、とハラリは言います。例えば、警備ロボットの台頭によって失業した警備員が、すぐにAIエンジニアになれるわけではないのです。AIによって仕事が創出されたとしても、労働力の移動が円滑に進まなければ、無用者は常に存在することになります(※脚註3)。

来たるべきAIによる失業問題の対策として近年注目されているのが、最低所得を制度的に保証するベーシックインカムです。この対策に対しても、ハラリは限定的な効果しか上げないと考えています。なぜならば、ベーシックインカムによって何らかの生活の「最低ライン」が定められると、そのラインを基準線として持てる者と持たざる者との階級的対立が生まれるからです。ベーシックインカムは、最低を保証しても平等を保証しません。

階級的対立を生み出すことなくベーシックインカムを運用するために必要とされるものとしてハラリが提言しているのが、非労働的な活動に価値を見出すことです。この提言の実践例としてハラリが挙げているのが、同氏の母国イスラエルにおけるユダヤ教超正統派の男性の生活です。彼らの約半数は働かずに、ユダヤ教の聖典を読んだり宗教的儀式を執り行ったりして一生を過ごします。彼らの経済的基盤は、妻たちが働いた稼ぎとイスラエル政府による援助です。そんな彼らの生活は貧しいものですが、イスラエルにおける生活満足度調査によると、驚くべきことに生活にもっとも満足しているのは彼らなのです。彼らは貧しさを苦にしておらず、金持ちになりたいとも思っていないので、「最低ラインの生活」であっても心が満たされているのです。

AIによる失業問題を解決するには、社会制度改革とともに人生の価値に関する転換も求められるのかも知れません。

『雇用の未来レポート2020』のインフォグラフィック集より抜粋

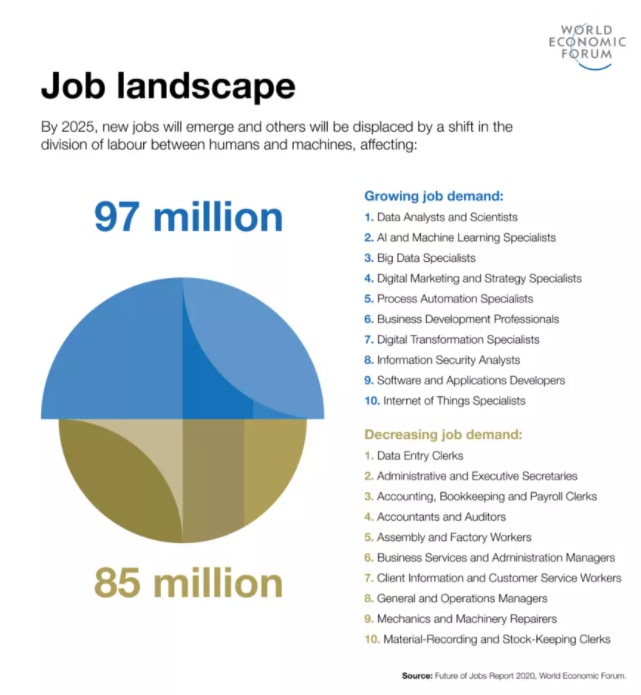

データサイエンスのような人間とアルゴリズムの協働が求められる新興の仕事は2025年までに9,700万人分創出される一方で、データ入力のような人力による単純労働の需要は8,500万人分失われる(下の画像参照)。

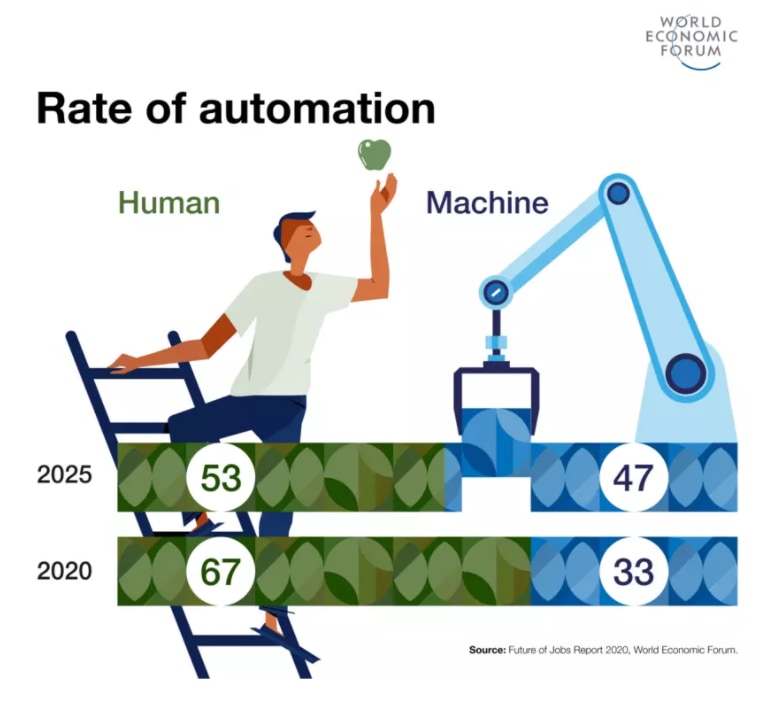

『雇用の未来レポート2020』のインフォグラフィック集より抜粋

さらに全世界の労働者のうち50%は、2025年までに機械およびアルゴリズムとの協働が強く求められる労働環境に適応するために、リスキリング(スキルの学び直し)が必要とされる。リスキリング等の労働環境の変化への対応を怠った場合、技術革新とコロナ禍という二重の影響によって、低賃金労働者、女性、および若年労働者は深刻な経済的影響を被り、世界の不平等は拡大する可能性がある。こうした経済的影響は、2008年の世界的金融危機(リーマン・ショック)におけるそれをはるかに凌ぐと見られる。

以上のように、ハラリの予見する無用者階級の誕生は現実化する懸念が高まっている。

知性の多様性にもとづいたAI開発の倫理的基準

AIによる失業問題とならんで注目されているのが、AI倫理をめぐる問題です。この問題は、AIによる差別、AIによる監視といったAIの悪用やAIの活用によって生じる悪影響に関する事例が報告されることによって明らかになってきました。

AI倫理を考えるにあたっては個々の事例とその対策を挙げていく方法がありますが、より原理的な方法として「良いAIとは何か、AIの良し悪しを決める基準とは何か」について論じる方法もあります。AIにおける善悪の基準を俎上に載せるにあたっては、ケリーの唱える「知性の多様性」が役立つように思われます。

前述したようにケリーによれば、人間とAIは認知活動において質的に異なっていて、優劣関係にあるわけではありません。そして、人間の知性とは異質であるという点こそがAIの本質であり、こうした「異体知能(Alien Intelligence:AI)」の種類を増やさば、増やしたぶんだけ人間だけでは解決できなかった問題に対してさまざまなソリューションを社会に提供できるようになります。

以上のような知性が多様となることを是とする倫理観を展開するにあたって、参考になりそうなのが環境問題で語られる「生物多様性」です。環境省が公開している生物多様性に関する啓発サイトによれば、生物多様性とは「生きものたちの豊かな個性とつながりのこと」と定義され、地球上の全生物は互いに直接・間接に支え合いながら生きているとされます。こうした生物多様性が(特定生物の乱獲といった)何らかの要因で損なわれた場合、特定の生物種の生存基盤が失われたり、ひいては全生物の生存が脅かされる事態が生じます。それゆえ、地球上の全生物の現在と未来における繁栄を保障するために、生物多様性は守られるべきなのです。

生物多様性を援用して知性の多様性に関する原則を設ける場合、注目すべきのは現在と未来における多様性を保障すべきという姿勢です。こうした姿勢にもとづいて、知性の多様性に関する原則を考えると、以下のようになるのではないでしょうか。

定義:「知性の多様性」とは、人間とAI、さらには動物を含めた知的エージェントの豊かな個性とつながりのこと

原則1:AIは、既存の社会と環境に存する知性の多様性を増やすようにして開発されるべきである。

原則2:知性の多様性を損なうようなAIは、開発すべきではない。

原則3:知性の多様性は、未来においても保障され多様化されるべきである。

原則1を満たすAI開発の事例として挙げられるのは、カスタマーサービスにおけるAIチャットボット、画像認識を活用した検品システムなど無数にあります。原則2によって禁じられているAI開発には、特定のグループが不利になる判断を下す貸し付け可否判定AI、フェイクニュースを自動生成する言語AIなどが挙げられます。差別的な貸し付け可否判定AIは銀行の貸し付け業務という知的活動の健全性を損なうものであり、フェイクニュース生成AIは、報道の健全性を脅かすものです。

原則3に関連して指摘できるのが、AIシステムの消費電力問題です。周知のように、AIシステムは多大な計算資源を消費する「燃費の悪い」技術です。テック系メディアWIRED日本版が2020年3月に公開した記事『大量の電力を消費するAIは、どこまで「地球に優しく」なれるのか』で特集されているように、大量の電力を消費するAIシステムは間接的に地球環境に負荷をかけていることになります。地球環境への悪影響は、結局のところ、あらゆる知的活動を脅かすことにつながります。

知性の多様性にもとづくAI開発の倫理的基準は、当然ながら、以上の3原則で説明し尽されているわけではありません。例えば、2020年8月にDARPAが発表したドッグファイトのシミュレーションにおいて人間の熟練パイロットに勝利したAIは、安全保障という目的から考えれば良いAIですが、その機能が破壊をもたらすことを考慮すれば無条件に良いとは見なすのは難しそうです。とは言え、AI開発の倫理的基準を論じる出発点として、知性の多様性というアイデアは有望なのではないでしょうか。

スーパーインテリジェンスと安全保障

AIを実装したAI兵器開発の是非および規制に関しては、今日活発に議論されています。こうしたAIと安全保障という問題で、AI兵器とともに注目すべきなのがスーパーインテリジェンスの人類に対する脅威です。確かにスーパーインテリジェンスはいまだ存在せず、その脅威を現実のものとして実感するのは難しいでしょう。しかし、ボストロムが言うには、スーパーインテリジェンスの実現が現実味を帯びた頃から、この超絶的存在をコントロールする方法に関して論じているようではもはや手遅れなのです。なぜならば、スーパーインテリジェンスが誕生した刹那、人類が壊滅的打撃を被ることも考えられるからです。それゆえ、スーパーインテリジェンスのコントロール問題に取り組むには、いまだ存在しない超絶的存在を想定しながら、その存在が原因となる脅威を未然に防止する方策を検討する、という困難なミッションの遂行が求められます。そして、この問題が未然に防止しようとしていることが人類の絶滅という究極的事態なため、現在から取り組み始めてスーパーインテリジェンス誕生に備えるべき、ともボストロムは主張します。

ボストロムによると、スーパーインテリジェンスのコントロール問題で論じるべき課題には、以下のようなものがあります。

- スーパーインテリジェンスに何を指示するか(最終目標の設定)

- 設定した最終目標をどのように遂行させるか(行動基準の策定)

- どのように安全に管理するか(管理体制の確立)

- スーパーインテリジェンス開発をどのように進めるか(開発体制の整備)

コントロール問題の全容を解説するのはこの記事に許されている範囲を超えてしまうので、以下ではこの問題の難しさと現在との関わりを考察するために、スーパーインテリジェンスの「最終目標の設定」と「開発体制の整備」に関する議論を紹介します。

最終目標の設定に際しては、一見すると何の問題もなさそうな目標を設定していも、スーパーインテリジェンスが目標設定者が意図しないような意味に目標を解釈した結果、人類絶滅の危機に瀕する可能性があります。ボストロムは、こうした可能性を「偏屈なインスタンシエイション」と呼んでいます(「インスタンシエイション(instantiation)」とは「具体化」を意味する英単語)。この用語で説明されている事態の具体例には、以下のようなものがあります。

最終目標:人類を笑顔にせよ。

偏屈なインスタンシエイション:顔面の筋肉を弛緩させ、ずっと笑いっぱなしの顔にする。

以上のような偏屈なインスタンシエイションが生じないように最終目標を設定するのは、至難の業のように思われます。スーパーインテリジェンスは人類を超越している存在なので、人類が考えもしなかったような最終目標達成の方法を考案し、偏屈なインスタンシエイションを犯すことを排除できないのです。

スーパーインテリジェンスが目指すべき最終目標の設定には偏屈なインスタンシエイションのほかにもさまざまな困難がありますが、ボストロムは最終目標設定に役立つアイデアとして「整合性のある外挿的意志」を挙げています。しかしながら、このアイデアにしても最終目標設定にまつわる問題をすべて解決できる類のものではなく、あくまで現在における有力な説に留まります。

スーパーインテリジェンスの開発体制に関しては、市場原理のもとで開発競争が行われた場合、悲劇的な結末を迎えるとボストロムは考察しています。同氏の説く悲劇は、スーパーインテリジェンスの開発に成功した組織あるいは国家は競争相手に対して圧倒的優位に立てることに起因します。勝利すれば圧倒的優位に立てるなかで、自由競争が行われると何が起こるでしょうか。開発競争での敗北は勝利者に対する全面的な服従を帰結するので、開発チームはいかなる手段を用いても勝利しようとするでしょう。そして、敗色が濃くなれば、最終手段として開発に先行しているチームを妨害しようとするでしょう。開発が国家的プロジェクトとして取り組まれている場合には、戦争をしかけて開発先行国家に損害を与えるという状況も想定されます。このようにスーパーインテリジェンス開発を自由競争で進めると、治安や世界平和に深刻な悪影響が及ぶことが考えられるのです。

スーパーインテリジェンスの開発体制としてボストロムが推奨しているのが、国際的な協力体制のもとでの研究開発です。国際協力体制が確立されていれば、開発成功者に対する全面的服従の可能性に怯える必要がなくなります。同氏が国際協力体制として具体的に考えているのは、CERNや国際宇宙ステーションのような組織やプロジェクトです。ただし、スーパーインテリジェンス開発に際しては、既存のどんな国際協力的プロジェクトよりも厳しいセキュリティ体制を構築すべき、とも説いています。

スーパーインテリジェンスの実現は今のところ現実味がありませんが、今後本格的に研究開発する状況になった時には、その研究成果が世界的に共有される体制を構築するのが望ましいでしょう。

以上のように執拗なまでにスーパーインテリジェンスの脅威を警戒しているボストロムに対して、本当のところはこの超絶的存在の開発に反対しているのではないか、としばしば批判されます。この批判に対して、スーパーインテリジェンス誕生によって人類が受益できるメリットが巨大だからこそ、この超絶的存在を安全に開発・運用するためにコントロール問題を徹底的に論じている、と同氏は自らのスタンスを説明しています。

まとめ

この記事では世界的に著名な4人のAI思想家の思想を概観したうえでAI思想マップを提示し、そのマップを参照しながら、AI社会問題を解決する糸口をさぐってきました。AI社会問題を考察するにあたっては、AIをめぐる特別な問題として「AIのハード・プロブレム」を定式化しました。

この記事で解説した問題については、当然ながら、十分に語り尽くせたわけではありません。以下にこの記事で為しえなかったことを4項目の制限事項として挙げることによって、今後の考察につなげたいと思います。

- 4人のAI思想家に関する解説は、この記事で十分に為しえたわけではありません。もっとも、この記事のねらいはAI思想家たちの思想を俯瞰するAI思想マップを提示することにあったので、このねらいを満たすだけの解説に留めました。また、AI思想マップはあくまで4人のAI思想家の相対的関係を図示したものであり、4人の思想をまとめた大統一理論を表しているわけではありません。

- 定式化するのみに留まっている「AIのハード・プロブレム」に関しては、今後はAGI開発の進捗状況、心の哲学における学説の整理、そして心の哲学とAI開発の接点を論じる必要があるでしょう。

- AI社会問題として論じた「AIによる失業」「知性の多様性にもとづいたAI開発の倫理的基準」「スーパーインテリジェンスのコントロール問題」のそれぞれに関して、さらなる考察が必要です。

- ハラリが提起している「デジタル独裁国家誕生の危険性」に関して、この記事ではその存在に言及するだけに留まりました。この問題はAIの悪用の究極形態と考えられるので、さらなる考察が急がれます。

結局のところ、この記事は何かを解説しているというよりは、何かを考えるきっかけや手がかりを提供しているのかも知れません。しかしながら、何かについて答える記事より、何かについて考えることをうながすものの方が、長期的には読者諸氏の役に立つのではないでしょうか。

記事執筆:吉本幸記(AINOW翻訳記事執筆担当)

編集:おざけん