Metaは2022年1月末、同社のAI開発を推進するスーパーコンピュータ「Research SuperCluster(略してRSC)」を発表しました。2022年半ばの完成を目指す同コンピュータはAIスーパーコンピュータとしては史上最速となり、スーパーコンピュータランキングにおいてもおそらくトップ5にランキングされる超高性能なものです。

Metaの発表によると、同社はRSCを使って大量の学習データにもとづいた画像認識AIをはじめとする各種大規模AIモデルを開発することを計画しています。こうした学習データには、FacebookやInstagramから収集されたユーザデータが活用されます。ユーザデータを活用することでより実用的なAIモデルを開発できる、と同社は説明しています。

Romero氏は、果たしてMetaはユーザデータを適切に活用できるだろうか、と疑問を呈しています。というのも、Instagramの悪影響やFacebookにおけるフェイクニュースの流布を同社が黙認していたというネガティブな事実があるからです。さらには、大規模な学習データで訓練するほど言語AIはバイアスを含むリスクが大きくなる、という最近の研究も引用して、RSCによる言語AI開発に対して注意を促しています。

RSCの善用に関しては、いずれMetaから何らかの発表があるかも知れません。

なお、以下の記事本文はAlberto Romero氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

画像出典:ShutterstockのGorodenkoffより

それは傷ついたパブリックイメージの改善につながるか?

数日前、MetaはAI Research SuperCluster(RSC)を発表した(※訳註1)。これは最新の言語モデルからメタバースに至るまでのAI技術を動かすことを目的とした、新しいハイパフォーマンスコンピュータ(HPC)である。同社によると、2022年半ばの完成時にはRSCは最速のAIスーパーコンピュータとなり、同社は次のAIブレークスルーを発表する有力な候補となる。同社はRSCを使って、1兆パラメータのNLPモデルの学習、画像認識や音声認識の製品のさらなる開発、さらにはエンボディドAI(※訳註2)やマルチモーダルAIなどの重要な分野での進歩を計画している。

RSCは、Metaのハードウェア機能を大幅に向上させる。現時点では、760個のNvidia DGX A100(6,080個のGPU)で構成されており、完成後は16,000個のA100 GPUにスケールアップする予定だ。ちなみに、Nvidia Seleneは(同社のAIデータソリューションである)DGX A100 SuperPODでもあり、2,240のGPU(63.4Pflop/s)を搭載して世界第6位の性能を誇る。また、OpenAIと共同で構築したMicrosoft Azureのスーパーコンピュータは、V100 GPUを10,000個搭載し、世界第10位(30.05Pflop/s)だ。また、Teslaの現在のスーパークラスター(今後数年でDojoに置き換わる予定)は、8個のA100 GPUから成る720ノード(5,760GPU)で構成されており、世界第5位となるだろう(ただし、浮動小数点フォーマットの精度が他のHPCに比べて低いため、比較は困難だ)(※訳註3)。

MetaのRSCのスペックは、AIスパコンとしては素晴らしいものだ。最速のHPCにはかなわないが、Nvidiaは「MetaのRSCは、完全に実装されれば、NVIDIA DGX A100システムの最大の顧客導入となることが予想される」と述べている。Metaの以前のGPUスーパークラスターは22,000台のNvidia V100を搭載しており、これまでのAI研究開発に求められるパワーには十分であった。現在のRSCでは、コンピュータビジョンの製造タスクで20倍、大規模なNLPワークフローで3倍の速度向上を実現する。RSCが完成すれば、これらの数値はさらに2.5倍に向上する。

RSCは、Metaが長年にわたって蓄積してきたすべてのユーザーデータを使ってAIシステムを動かすだろう。 (RSCを紹介するブログ記事を共同執筆した)Kevin LeeとShubho Senguptaは、ブログに次のように書いている。「オープンソースやその他の公開データセットのみを活用していた以前のAI研究インフラとは異なり、RSCはモデルの訓練にMetaの製品システムからの実例を含められるようにすることで、私たちの研究が効果的に実践に結びつくようにしてくれます」。この記述は同社が今後、プラットフォームを超えてユーザーから収集した何兆ものデータポイントを活用して、次世代のAI製品やツールを作っていくことを意味する。

Meta社のAI担当副社長であるJerome Pesentiは、(The Wall Street Journalの)インタビューのなかでRSCは 「皆さんの周りの世界をはるかによく理解するAIを解き放つでしょう…(RSCを建造した)目的は、膨大なデータを取り込み、音声や視覚などを認識したうえで複数の入力を用いて人間の脳のように考えることができ、状況を文脈的に理解できるAIモデルを構築することです 」と述べている(※訳註4)。この予測が現実のものとなれば、私たちはこれまで以上にAGIに近づくことになるだろう。しかし、Metaは出来上がったモデルを安全に実装できるだろうか。Pesenti氏は、GPT-3がプロンプトから(文章を)入力された後に有害な出力を生成する傾向があることを批判した。Meta社の新しいAIモデルは、毒性やバイアスの点でGPT-3よりも質的に優れているのだろうか。

RSCによって開発されるモデルは、そのモデルに与えられたデータにAIをめぐる問題が存在する場合、より多くのコンピューティングパワーがそうした問題を解決するのかという懸念をもたらす。LeeとSenguptaは、RSCがMetaのプラットフォーム上の有害なコンテンツを検出・識別するのに役立つと何度か言及している。しかし、どのようにそれを行う予定なのかについては言及していない。RSCは、Instagramが10代の女の子に与える害を解決するだろうか。あるいは、Facebookのフィードに流れているフェイクニュースの流布を除去するだろうか。同社は、より単純なアルゴリズムを管理できていないのに、「ただ世界を理解するのに……はるかに、はるかに優れた」AIを作ろうというのだろうか。

AIモデルが大きくなればなるほど(※訳註5)、問題のあるデータを利用する可能性が高くなるため、被害のリスクは高くなる。何が得られ、何が失われるかを考慮することは、AIシステムを設計し、管理し、訓練し、実装する人の手に委ねられている。MetaがRSCの力を採用して、最も強力なAIモデルを作るだけでなく、誰にとっても公平で有益なものにしてくれることを期待しよう。特にAIモデルによって繰り返し標的にされ、差別されているマイノリティの人々に恩恵があることを願おう。そのためには、同社が現在の立ち位置から180度転換する必要があるだろう。

Metaは2021年6月30日、エンボディドAIを開発するシミュレーション環境Habitat 2.0に関するブログ記事を公開した。同環境を使えば、例えばキッチンで稼働する家事用AIの研究ができる。同社は2021年12月6日に公開したブログ記事で、Habitat 2.0を活用した論文がNeurIPS 2021で採択されたことを報告している。

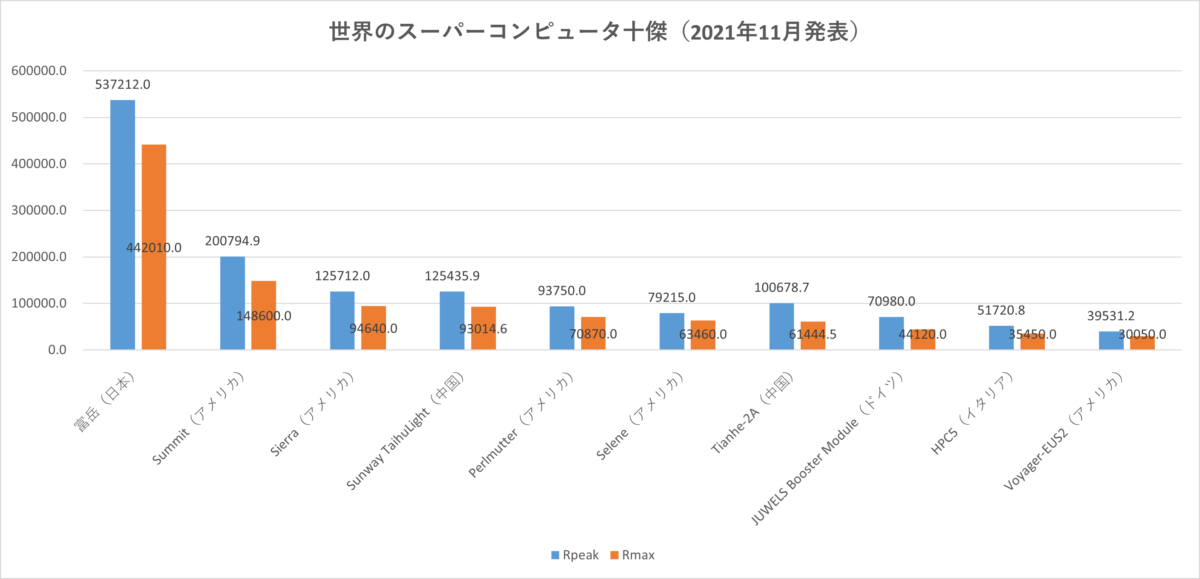

以下のグラフにおける青棒は理論上のピークパフォーマンスを意味するRpeak、赤棒はTOP500プロジェクトで採用されているベンチマークLINPACKにもとづいて測定された最高演算値Rmaxを意味する。単位は両方ともテラフロップス(TELOPS)。2022年3月時点で1位は日本のスパコン富岳。RSCはおそらくトップ5以内にランキングされると予想される。

「メタバースでは、100%3次元の多感覚体験が可能であり、その環境下で自分に関連する人工知能エージェントを作る必要があります」(Meta社AI担当副社長Jerome Pesenti)

・・・

この記事を気に入ってくださった方は、私の無料週刊ニュースレター「Minds of Tomorrow」の購読をご検討ください!毎週AIとテクノロジーに関するニュース、リサーチ、インサイトをお届けします。

また、私の紹介リンクを使ってMediumメンバーになると、私の活動を直接サポートし、無制限のアクセスを得られます!詳しくはこちらをご覧ください。:)

原文

『Meta Is Building a 16,000-GPU AI Supercomputer — The Fastest Ever』

著者

Alberto Romero

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん