ルチアーノスフィア氏は、ChatGPTの前身モデルGPT-3に関して化学的知識を問うテストを実施しました。その結果は、同モデルは化学的知識に関する知識問題では高い正答率を達成するものも、化学的知識の応用を問う問題解決的な問題はほとんど解けない、というものでした。ChatGPTに関しては同AIの化学に関する理解を検証する多数のテストが実施されており、その結果は知識問題では好成績を収める一方で、概念の理解や知識の応用が苦手というものであり、GPT-3とほぼ同様の弱点があることが露呈しています。

以上の検証結果をふまえて、ChatGPTを化学教育に活用するにあたっては、人間の指導を代替するものではなく、学生の理解を深める補助的なツールとして扱うべき、とルチアーノスフィア氏は結論づけています。そして、学生が同モデルを適切に使えるように指導できる教育者の育成が必要、とも指摘しています。

なお、以下の記事本文はルチアーノスフィア氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、日本語の文章として読み易くするために、意訳やコンテクストを明確にするための補足を行っています。

画像出典:UnsplashのJason Goodmanより

目次 [非表示]

科学教育におけるChatGPTの限界と可能性を議論する。現在、ChatGPTの教育への活用は非常に広範囲にテストされている

テクノロジーが進歩し続けるなか、私たちは教育と研究において新しい時代の入り口に立っていることに気づく。進化の途上にあるテクノロジーには仮想現実や拡張現実、ハイパーコネクティビティ、オンライン百科事典があるが、おそらく我々教育者が最も注意深く分析しなければならない諸刃の剣とは、ChatGPTのような人工知能チャットボットである。これは学生の学習に大いに役立つこともあれば、教育を台無しにすることもある。

ChatGPTとはOpenAIの世界的に有名な生成的事前訓練済みTransformer(generative pretrained transformer:頭文字を並べると「GPT」)で、公開からわずか2ヶ月で月間アクティブユーザ数が1億人という驚異的な数字を記録し、私を含む教育関係者のあいだで大きな注目を集めている。このAIが学習や科学的探究へのアプローチ方法に革命をもたらす可能性は否定できないが、最近の研究が示すように、この(潜在的に)非常に強力なツールを責任を持って効果的に使用するためには注意を払わなければならない。

ChatGPTの前身モデルで性能が似通ったGPT-3が登場した時、これはすでに人間を騙すくらいに十分に賢く、非常に才能豊かなアシスタントとして機能していた。そこで私は、GPT-3の基礎科学に関する知識をテストした。このテストの成果については、例えば私のブログ記事に掲載した「GPT3の長所と限界を探る」の記事リストを参照してほしい(※訳註1)。

ルチアーノスフィア氏が公開したGPT-3の教育活用に関して論じた記事一覧

私のGPT-3に関する研究から得られた主な考察は、このAIは事実に関する質問には非常に正確に答えるが、問題解決に関しては惨めに失敗する、ということであった。この考察はそれほど予想外ではなかったが、このモデルがたとえあからさまに間違っていたとしても、かなり自信に満ちた話し方で答えを出すのを見ると、非常に心配になった。

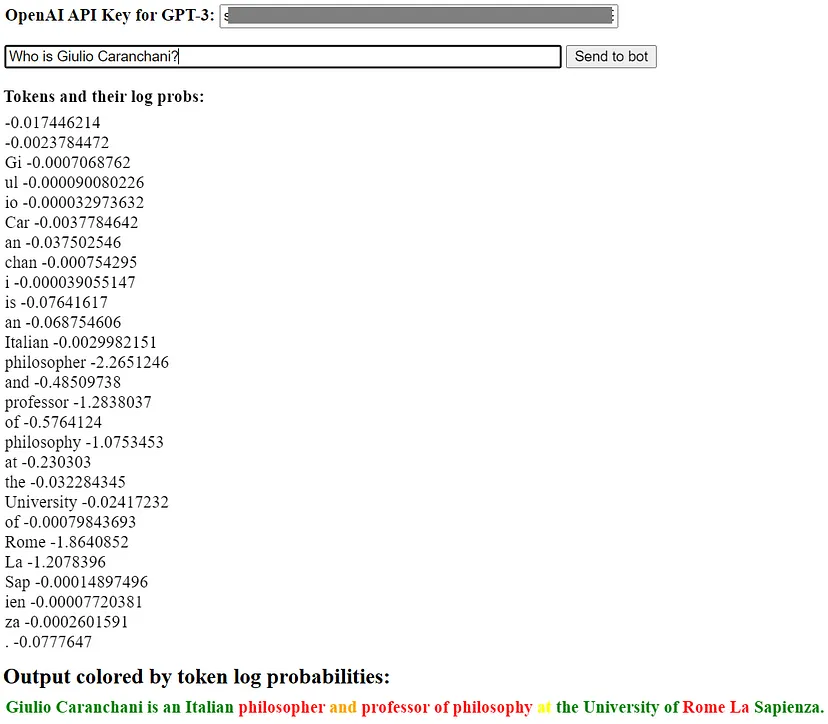

以上の研究において、私は言語モデル自身が提供するスコアを使って、GPT-3の答えがどれくらいの確率で正しいかを見分ける方法をテストした。

各トークンの出現確率と出現確率に応じて色分けされた出力テキスト

しかし、上記のテストを実施しても、質の高い回答を保証するには十分ではなかった。

その後、GPT-3.5をベースにしてファインチューニングしたChatGPTとGPT-4が登場した。これらのモデルは、より良い答えをもたらし、質問にどう答えるべきか確信が持てない時には、それを認めるようになった。しかし、このモデルでさえも不完全であることが判明し、指導されていない学生がこれらのAIを素朴に使うと、あまりにも高いリスクが生じる。

そうこうしているうちに、GoogleのBardのような他の言語モデルが出てきた。Bardはヨーロッパの大部分を含む世界の大部分ではまだ利用できないので(※訳註3)、私はこれをまだ使えていない。数学と科学に秀でているはずのメタのGalacticaにいたっては、完全な失敗作となった(※訳註4)。対話型AIは、単なる流行なのかも知れない。

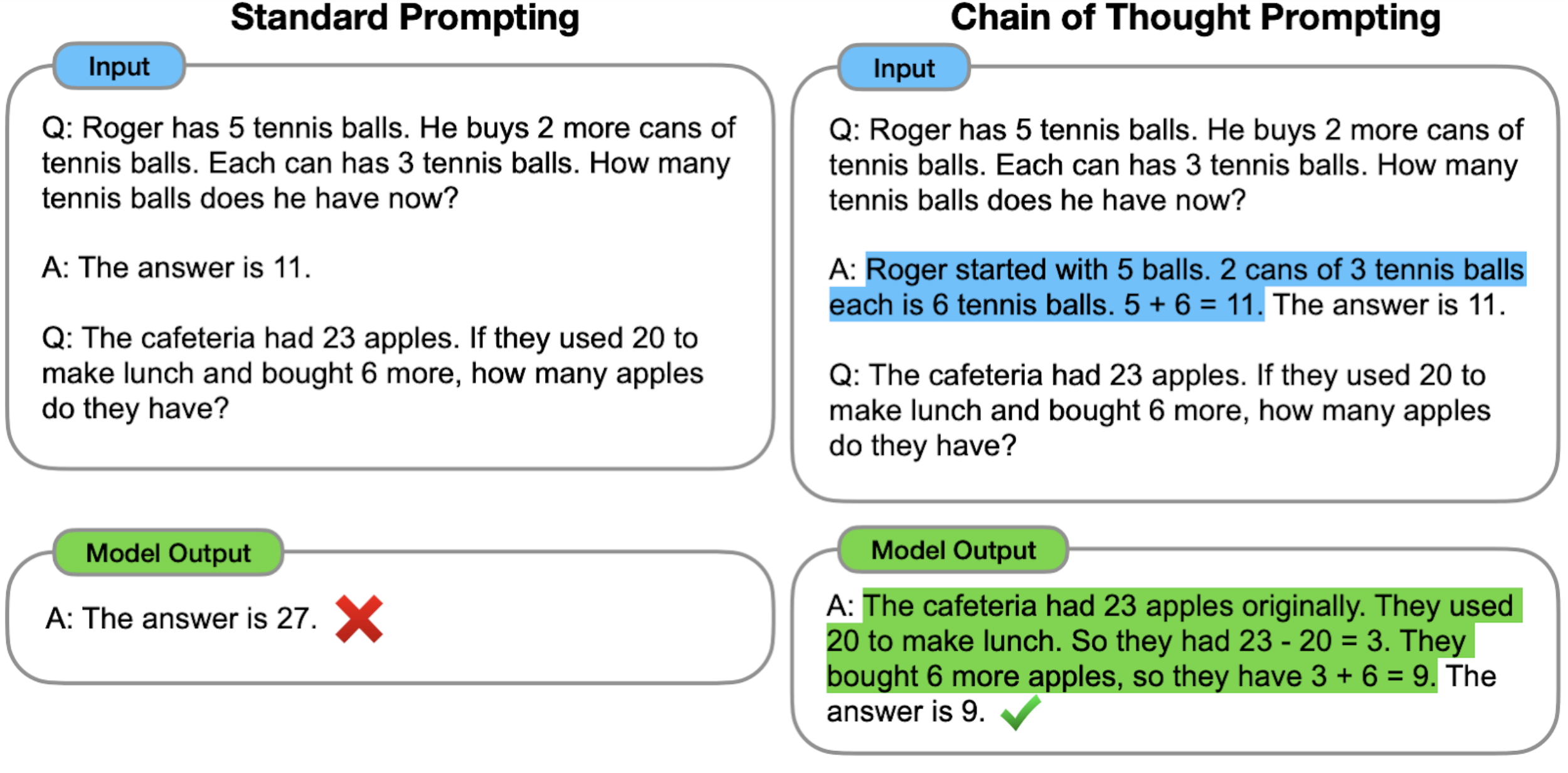

OpenAIのGPTファミリーを含むいくつかのモデルでは、「思考の連鎖」を持つプロンプトを作成することで、実際に回答を大幅に改善できることを示唆する研究やテストがあるようだ(※訳註5)。この技法は有望に見えるが、確実かつ一貫して適切な答えを導き出すことができる、徹底的にテストされた方法とクリーンな(プロンプトの)レシピを提供した人はいない。

「思考の連鎖」の模式図

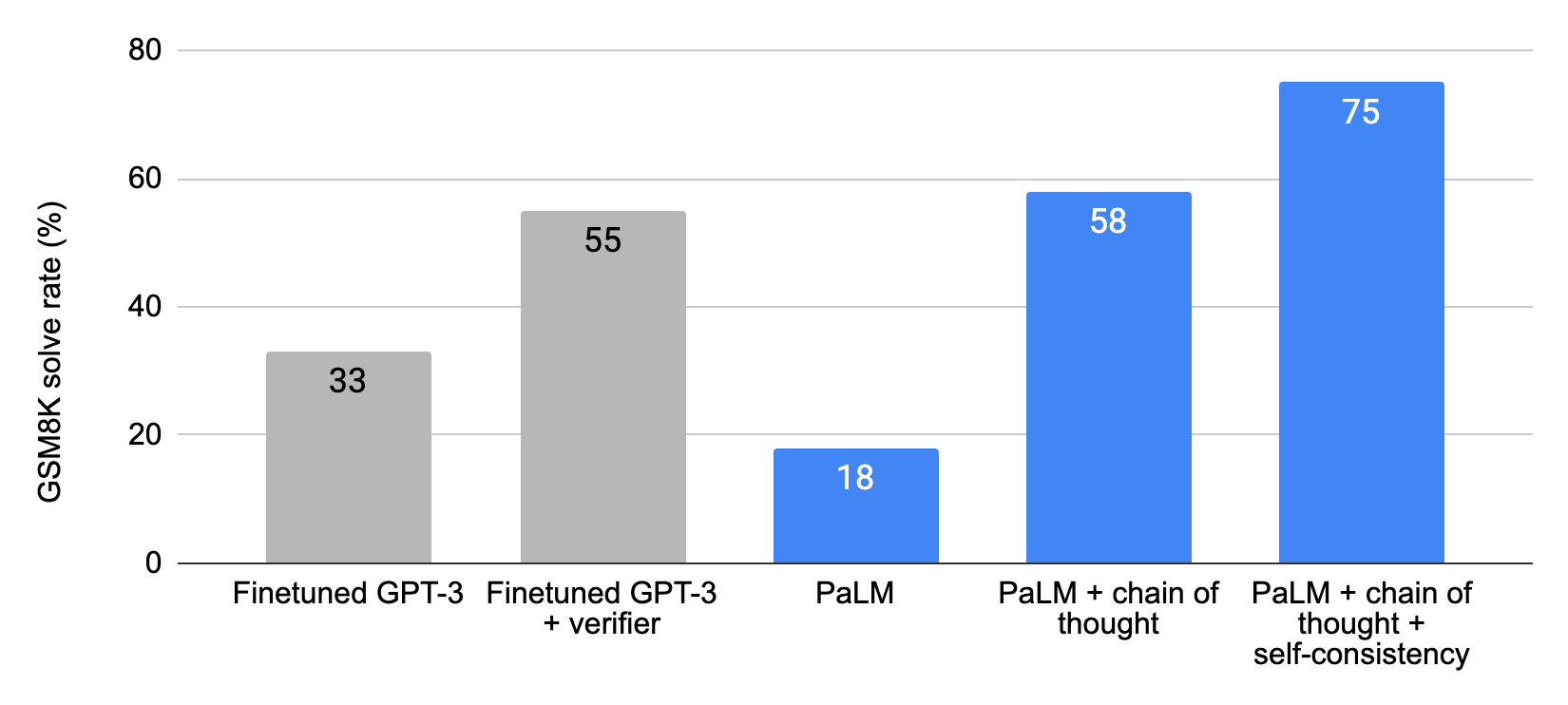

Google研究チームは、同社開発の言語モデルPaLMを使って、数学的問題を集めたデータセットGSM8Kに関するCoTの比較実験を実施した。その結果、CoTを使わない場合の正答率が18%なのに対して、CoTを使うと58%に向上した。さらに自己整合性(Self-Consistency)と呼ばれる技法を組み合わせて使うと、75%まで向上した。

PaLMを用いてChain of thoughtの効果を検証したグラフ

より深いテスト

OpenAIの言語モデルファミリーに関する私の初期のテストは定性的で示唆に富むものであったが、定量的な評価をするほど深いものではなかった。しかし、そうした初期テストはむしろ素早く実行され、本質的には、その後の深い研究が発見したのと同じ結果を明らかにした。そうしたテスト結果の主な内容とは、以上で記述した通りだ。

しかし、GPT-3のリリースからほぼ2年、ChatGPTの最初のバージョンのリリースからほぼ1年が経過し、現在にいたるまでにこれらの言語モデルについて、学生の勉強や(家庭)学習の支援を含むさまざまなタスクに対してどの程度信頼できるかに焦点を当てた、深い調査が大量に行われた。そのような論文のなかで科学教育専門誌に掲載されたいくつかの興味深いものは、すでに知られている限界に加えて、かなりの長所に光を当てている。以下では、これらの論文の一部を紹介する。

化学情報とモデリングに関するジャーナル(Journal of Chemical Information and Modeling)に掲載されたこの研究では、化学に特化した質問を投げかけた時のモデルの理解度と回答精度を調べた。研究者は、ChatGPTの性能は25%から100%の精度の範囲内で大きく異なることを発見した。ChatGPTは、一般的な物質の水溶性のようなありふれたトピックのクエリに答えるのは得意だったが、化合物名のような、それほど難しくはないのだが、より具体的なトピックに直面すると苦戦した。炭素原子が数個しかないアルカンのような単純な分子でさえも難問となった。この問題は平均的な化学専攻の3年生であれば、すぐに規則を理解できるだろう。こうした結果は、正確な化学情報の検索をChatGPTに頼る場合、注意が必要であることを強調している。

さらに、化学教育ジャーナル(Journal of Chemical Education)に掲載されたこの研究では、ChatGPTの化学の回答と解説に概念的な誤りがあることが明らかになった。この言語モデルは、モデルの学習データセットで比較的よくカバーされていると予想されるいくつかの概念(例えば、電磁放射、周期的性質、イオン化エネルギーなど)の「理解」において欠陥を示した。この論文は、ChatGPTは化学記号を学生が理解できるように伝え、解釈することには優れているが、信頼できる化学の学生自体になるには不十分であることを明らかにした。これは言語モデルに盲目的に依存しかねない学生にとっては非常に危険なことだが、学生がChatGPTと関わって間違いを特定し、修正するよう指示されれば、その限界はチャンスに変わり、ChatGPTによって学生自身の理解を強化できる。

ここで発表された別の査読付き研究は、薬学プログラムの文脈でChatGPTの長所と限界を強調した。このモデルは、知識と理解に焦点を当てた質問に対する回答を生成できたが、知識の応用と非テキスト情報の解釈に関しては苦戦した。これらの研究は、ChatGPTは試験合格には至らなかったが、学生が自身の理解力を明らかにして、自己評価を行うための貴重なツールとして活用できることを指摘している。

絶対的なものには程遠いが、有用なものである。未来を覗く

以上の論文やその他の知見から、ChatGPTは強力なリソースではあるが、無謬ではないことが判明した。推論や問題解決における限界は明らかである。さらに言えば、革命を起こしたオリジナルのGPT-3プログラムと比べるとかなり改良された現在でさえ、ChatGPTは情報をでっち上げることがある。

それゆえ、ChatGPTは人間の指導に取って代わるものではなく、補助的なツールとしてアプローチする必要がある。このAIを効果的に、そしておそらくは監視された形で活用すれば、研究のガイダンスを提供し、ライティングスキルをサポートし、概念理解を強化することで、学生の学習経験を真に高める可能性がある。

計算式や公式を演算したり、実験レポートの書き方に関する着眼点や例題を見つけたり、さらには文法のチェックや単語の意味の説明、あるいはその逆、つまり複雑な概念をたった一言、あるいは数言で伝える方法を説明したりするのに、学生がChatGPTを活用する化学教室を想像してみてほしい。

ChatGPTが学生を確実に助けられる特別なタスクの1つは、レポートの結論部分を書くことである。というのも、このAIは首尾一貫したテキストの生成に優れているからだ。もちろん、言語モデルからの他の出力と同様に、学生には結論に関するプログラムからの出力を批判的に分析し、テーマへの深い関与を促す必要がある。この研究では、そのような応用例をいくつか紹介している。

ChatGPTをツールとして実りあるものにするためには、効果的な質問の立て方とモデルの応答の分析について、教育者が学生にガイダンスを提供することが極めて重要である。ACS(American Chemical Society:「アメリカ化学会」)のブログが論じているように(※訳註6)、学生とAIモデルの共生関係を育むことで、人間の知恵と判断力の本質的な役割を保ちつつ、テクノロジーの利点を受け入れる教育環境を作れる。

以上の記事では、ChatGPTを効果的に使用するためには「学生は答えを知りたい化学原理を理解し、適切な質問を効果的に行い、AIの出力を分析する必要がある」と述べられ、学生に同AIが生成する回答を吟味する科学的知識とプロンプトエンジニアリングを含む質問力が不可欠であることを指摘している。さらに「AIを効果的に使用するためのヒントやベストプラクティス」の学生への提供の必要性にも言及している。

また、学生にAIを使わせたくない教育者に対しては、AI生成文検出器の使用の検討をすすめている。

もちろん、ChatGPTの力に伴う潜在的な危険性は常に認識すべきである。主な懸念事項のひとつは、モデルが間違った回答を生成しても、それを自信たっぷりに伝えてしまうことである。ChatGPTが普及し受け入れられるようになると、学生が批判的な評価をせずに、疑うことなくその回答に頼ってしまうリスクがある。教育者や研究者の責任として、自主的に考えることの重要性を強調し、情報を検証し、ChatGPTの回答を信頼できる情報源と照らし合わせることを学生に奨励しなければならない。さらにはChatGPTの誤りを特定し修正するスキルを学生に習得させることによって、懐疑主義と知的厳密さの文化を育成しなければならない。このように言語モデルを活用すれば、それはその出力を注意深く取り扱わなければならないツール以上のものとなる。

ほとんどの研究は、私がこの記事で説いてきたように、ChatGPTやそれに類似した言語モデルは、限界があるものも、学生の学習を助け、複雑な概念の理解を拡張できるので、教育支援における無限の可能性を秘めている、と結論づけている。このAIが持つコミュニケーションと解釈に関する強みを活用することで、教育者は学生の学習意欲を高め、自己評価の貴重な機会を提供できる。しかし、特に推論と問題解決においては、ChatGPTの限界を認識し、その扱いに関して慎重であり続けなければならない。

言語モデルが進化し続けるなか、その力を活用することと、研究・学習プロセスの完全性を維持することのバランスを取ることが極めて重要である。最後に、今日(2023年6月)時点の最先端技術をもってすれば、批判的思考を重視しつつ、ChatGPTを教室の新たなツールとして取り入れることで、教育者はより豊かな教育体験を創造するために、今日にでもそれをうまく活用できる、とアドバイスしておこう。もちろん、そうした教育体験を創造するカギは教育者の適切な訓練にある。

さらに読む

- アメリカ化学会のブログで、化学の授業におけるChatGPTの使用について論じている記事は、こちら。

- 言語モデルを化学の教育や研究に応用するというテーマに関する2つの非常に興味深いオピニオン記事は、こちらとこちら。

- いくつかの自然科学と工学の教育にChatGPTを応用することに関する深い研究は、こちら。

教育テクノロジーに関するその他の記事

・・・

www.lucianoabriata.comでは自然、科学、テクノロジー、プログラミングなど、私の幅広い関心領域に関するあらゆることについて、書いたり写真撮影したりしている。

Mediumの全ストーリーにアクセスするには、ここで私にチップを送るか、Mediumのメンバーになってください。新着記事の配信をメールで受け取りたい場合はこちら。小さな仕事について私のサービスページで相談する場合はこちら。わたしへの連絡はこちらからできます。

原文

『Unleashing the power of ChatGPT in the classroom -discussion after months of tests』

著者

ルチアーノスフィア(LucianoSphere)

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん