ChatGPTをはじめとする大規模言語モデルの訓練と運用には、巨大なデータセンターを使った計算が不可欠です。こうした計算に伴って熱が発生するため、その熱を冷却するために大量の水が使われます。大規模言語モデルをめぐる水消費問題に関して、トンプソン氏がさまざまなソースを参照しながら調査した結果、以下のような事実が判明しました。

大規模言語モデルの水消費について判明した事実

|

以上のような事実を明らかにしたうえで、大手テック企業に水消費の抑制をうながすためには、データセンターが建設される地域住民が水提供契約に関してこれらの企業に簡単に譲歩しないこと、とトンプソン氏は述べています。というのも、高額な水提供契約を締結すれば、大手テック企業はデータセンター運用費を抑制するために節水技術の開発を余儀なくされるからです。

なお、以下の記事本文には、読みやすさを考慮して原文記事にない見出しをつけています。

以下の記事本文はクライブ・トンプソン氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、日本語の文章として読み易くするために、意訳やコンテクストを明確にするための補足を行っています。

画像出典:UnsplashのJacek Dylagより

目次 [非表示]

大規模言語モデルとのチャットは、地面に水を捨てるようなもの

今日、私はChatGPTを使ってブラウザ・プラグインを作る手伝いをした。自分のクエリーを投稿し、コードとテキストがスクリーンにこぼれ落ちていくのを見た。これこそ、大規模言語モデルの醍醐味だと私は思う!趣味の開発者として、カスタマイズされたソフトウェアの提案を受けることは、強力な学習方法になり得る。

しかし、結局のところ、ChatGPTを使うと予想外のリソースを大量に消費する。

水だ。

コードは私が求めていたものとは全く違っていたので、ChatGPTと15分ほどチャットし、ゆっくりとなだめすかして修正させた。修正が終わるまでに、私とChatGPTは20回ほどやりとりをした。

そのやりとりのあいだに何が起こったか。Microsoftのサーバはおそらく、私が半リットルのペットボトルを買ってきて地面にこぼしたのと同じくらいの水を使っただろう。

AIは信じられないほど水に飢えている技術であり、毎日新鮮な水を大量に消費している。今後、大規模言語モデルのAIがますます多くのアプリや家電製品に組み込まれる可能性があることを考えると、AIの利用が急増している今、どれだけの水を消費するのか考える価値がある。

・・・

GPT-3の訓練に350万リットル、20~50の会話で500ミリリットル

なぜ大規模言語モデルAIは水を必要とするのだろうか。今年(2023年)の4月、ある研究者グループはAIの水消費量の見積もりを作成しながら、この疑問について考えた。彼らの論文(全文無料)(※訳註1)にあるように、水の主な使用は、テック企業がAIを訓練するときと、企業が推論を実行するとき(つまり、あなたや私、あるいは他の誰かがモデルと対話するとき)に生じる。

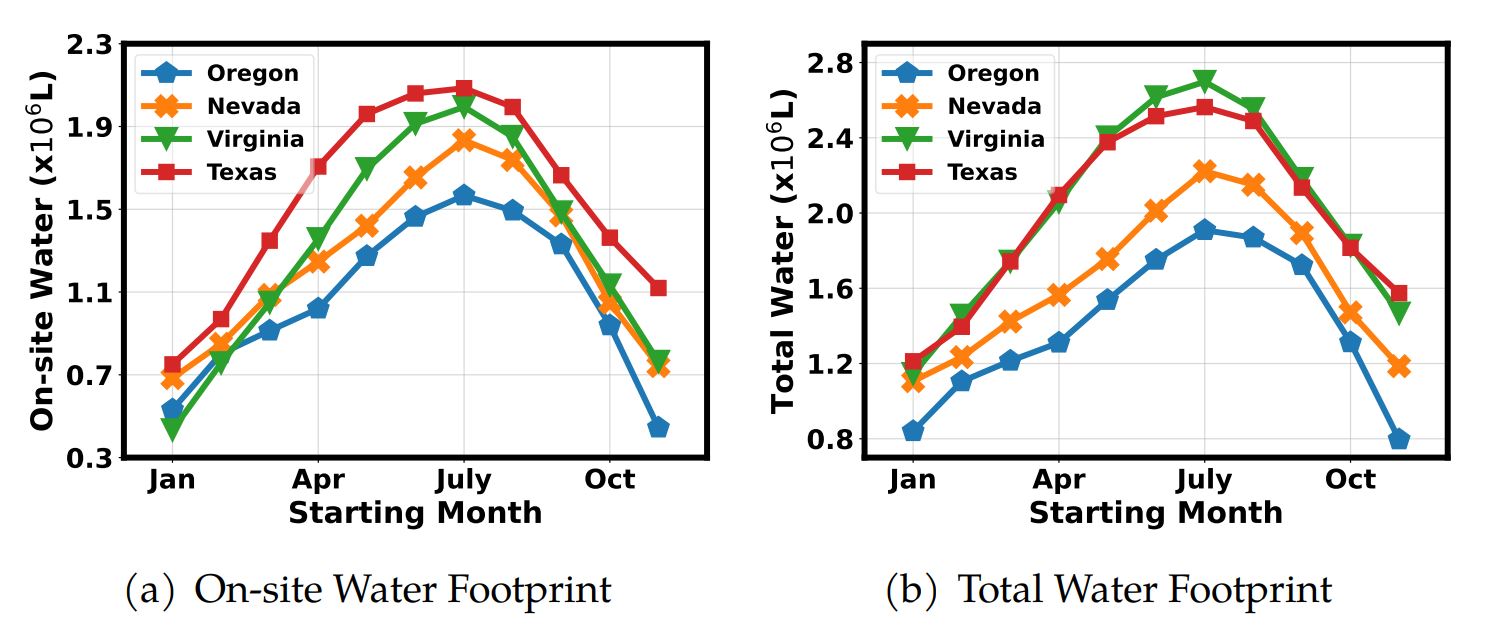

アメリカの4州にあるデータセンターのウォーターフットプリント比較

MicrosoftやGoogle、Metaのようなテック企業は、巨大な計算施設ですべての訓練(と推論)を行っている。その計算には大量のエネルギーが必要で、そうした計算により熱が発生する。その熱をサーバ施設から取り除くために、彼らはたいてい冷却塔を使用し、そこで水を蒸発させて熱を外界に放出する。この蒸発の段階でAIは水を消費するのだ。そのほとんどが淡水であることは注目に値する。

テック企業は、さまざまな形式の計算にどれだけの淡水を使用しているのか、具体的な統計を公表していない。そこで学者たちはいくつかの試算を行った。よく知られている大規模言語モデルのひとつを訓練する(そしてそれを使って推論を実行する)のに必要なエネルギーを計算した。(ここで、役に立つ公開情報がある: Googleがこの論文で説明しているように、同社が大規模言語モデルLaMDAを開発した際には、57.7日間の連続訓練が必要だった。)それから学者たちは、冷却メカニズムの効率指標を使って、どれだけの水が必要かを正確に割り出した。

その結果、彼らは以下のように割り出した…。

アメリカにあるMicrosoftの最新鋭データセンターでGPT-3を訓練する場合、70万リットルの清浄な淡水を直接消費する可能性があり、これはBMWの自動車370台またはテスラ電気自動車320台を生産するのに十分な量である…さらに、GPT-3の訓練には、電力使用による280万リットルの追加的なオフサイトのウォーターフットプリント(※訳註2)に関する責任も生じる(水使用効率をアメリカの全国平均レベル1.8L/kWh [32]、電力使用効率を1.2と仮定)。したがって、以上の数字を合わせると、アメリカで訓練を行った場合、GPT-3の訓練にかかる総ウォーターフットプリントは350万リットルとなる。

大規模言語モデルとチャットする時はどうだろうか。

ChatGPT(を稼働させる施設)がある場所とチャットする時間帯にもよるが、およそ20~50の質問と回答から構成された単純な会話のために、ChatGPTは500ミリリットルのボトルの水を「飲む」必要がある。

この計算は妥当だろうか。テック企業(および彼らに水を供給する管轄区域)は水の使用量に関する詳細なデータを公表していないため(これについては後述する)、この論文の著者は、データセンターの冷却に必要な水の量に関する第三者的な推定に頼っている。この推定値自体が間違っている可能性もある!この記事の続きでは、学者たちが出した数字を使うが、私は企業内部からのデータの方がずっといいと思っている。

・・・

画像出典:UnsplashのBrendan Church

ChatGPTが1ヵ月稼働すると、1億2,800万リットルの水を消費?

以上の分析が示すように、モデルを訓練するには大量の水が必要なのは明らかだ。

しかし、私が本当に驚いたのは、モデルを使用するのに必要な水の量の見積もりである。20~50回の会話のために、1/2リットルの水を消費するだろうのか。しかし、そのような会話の数は爆発的に増えている。

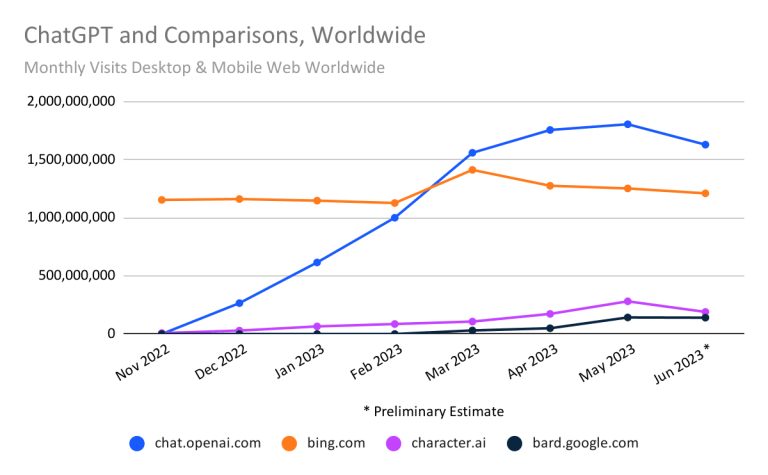

similarwebの推定によれば、2023年6月におけるChatGPTへのユーザ訪問数は約16億にのぼるという(※訳註3)。さらにsimilarwebの人々は、ChatGPTの平均セッション時間はおそらく8分弱だったと推定している。つまり、6月には128億分の会話があったことになる。

2023年6月までの世界におけるChatGPTと競合の訪問数(デスクトップPCとモバイル端末を合算)

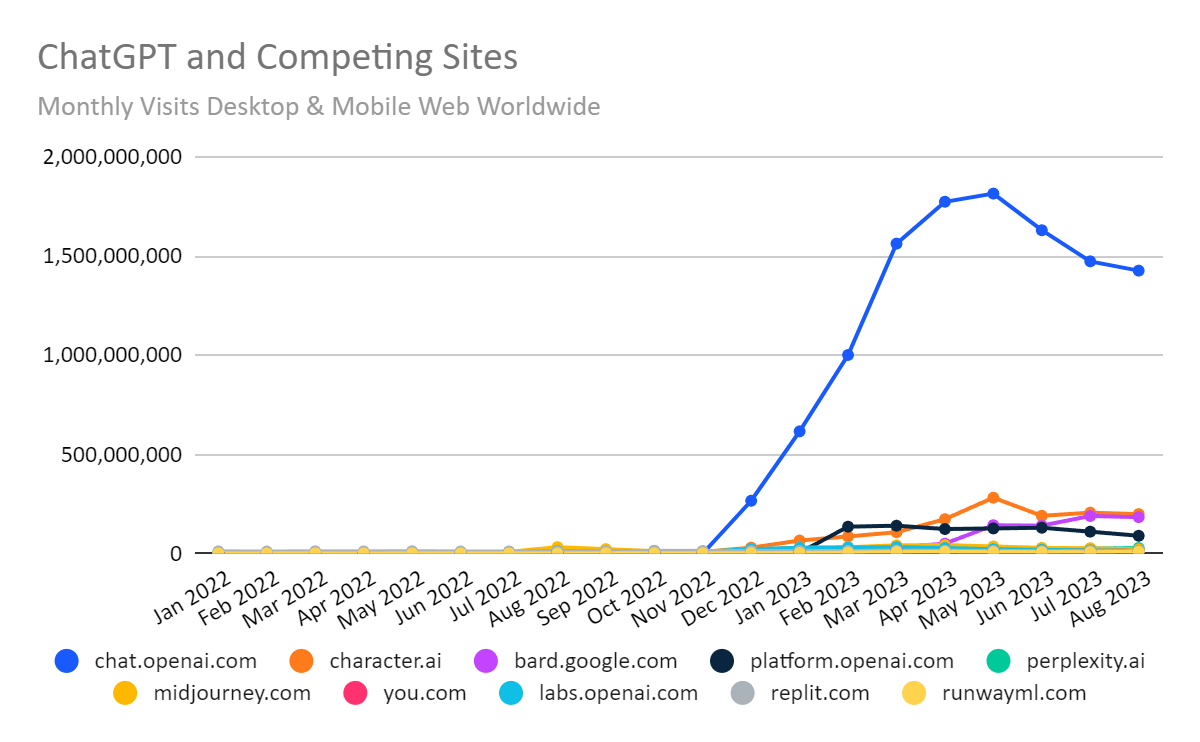

また同社は2023年9月7日、2023年8月までのChatGPTへの訪問数を発表した。訪問数が6月と7月に大きく減少したのは、学校が夏季休暇に入ったからと推測される。

2023年8月までの世界におけるChatGPTと競合の訪問数(デスクトップPCとモバイル端末を合算)

誰かがChatGPTと話しているとき、1分間にどれだけの質問と答えのやりとりが行われているかは分からない。(しかも、私は妥当な見積もりを見つけられていない)。しかし、ひとつの試算として平均的なAIチャット・セッションでは、1分間に1つの質問と1つの返答があると仮定してみよう。そうすると、1ヶ月で128億の質問と回答があることになる。このモデルで50回のやりとりに500ミリリットルの水が必要だとすると、ChatGPTの会話は1ヶ月で1億2,800万リットルの水を消費したことになる。

私の(明らかに非常に粗雑な)見積もりが1桁か2桁ずれていたとしても、モデルを使用することが、単に訓練するよりもはるかに多くの水を消費することがわかるだろう。

そして、これらのモデルの使用はまだ初期段階にある!おそらく、大規模言語モデルは今後ますますデジタルな相互作用に織り込まれていくだろう。銀行取引、ロボット工学、ウェブサイト・インターフェイス、eコマースなど、さまざまな場面でこのモデルが使われるようになるだろう。おそらく、大規模言語モデルAIを介して、電子レンジとチャットする日も近いだろう。この予想は、エネルギーと水の使用量も急増することを意味する。

・・・

相反する節水とCO2削減

淡水はますます不足していく資源である。それゆえ、大規模言語モデルが渇望する新鮮な淡水をどのように削減するのか、ということが問題なのは明白だ。

学者たちはそれについていくつかの考えを持っている。彼らは、AI企業が水の需要を減らすために訓練の時間を調整することを提案している。気温が最も低い夜間にモデルを訓練すれば、冷却塔の効率は暑い昼間よりも良くなるだろう。(上記論文の著者らは、最悪の学習時間では最善の学習時間の3倍の水を使用すると見積もっている)。

問題は、これがCO2削減のような他の環境目標と相反する可能性があることだ。AIができるだけCO2を排出しないようにしたいのであれば、太陽光発電が最も豊富な明るい日中に訓練を行うべきだろう。論文の著者が指摘するように、CO2を削減するには「太陽に従う」一方で、水の使用量を削減するには「太陽に従わない」ことになる。大規模言語モデルにまつわる環境問題のもう1つの側面として、モデルを使用する人々が世界中にいるため、太陽が昇っているときに推論を求める顧客が常に存在することがある。

これらの問題を解決するのは容易ではない。

現在テック企業自身が、2030年までに水の使用量を全体的に改善し、「ウォーター・ポジティブ」になることを約束している。Microsoftは2020年に「グローバルベースで消費量以上の水を補充する」と発表した(※訳註4)。同社の介入策リスト(敷地内での雨水収集や、水ではなく空気を使用する「断熱冷却」などが含まれる)を読むと、とても素晴らしいことのように聞こえる。しかし、彼らが予測する節水量は、年間数億リットルに過ぎない。学者たちの数字が少しでも正しければ、今日のモデル使用の増加によって、水の消費量はその節約分の数倍になってしまうだろう。

ウォーター・レジリエンス連合リーダーシップコミュニティメンバーの企業ロゴ

・・・

画像出典:UnsplashのTaylor Vick

(効果は期待できないが)解決策は確かにある

もちろん、テック企業の水使用に関しては、AIは氷山の一角に過ぎない。すべてのクラウド計算には冷却が必要だ。そのためテック企業は、大量の淡水を可能な限り低価格で販売してくれる州や町を常に探し回っている、とUS版Gizmodoの記事は指摘している。

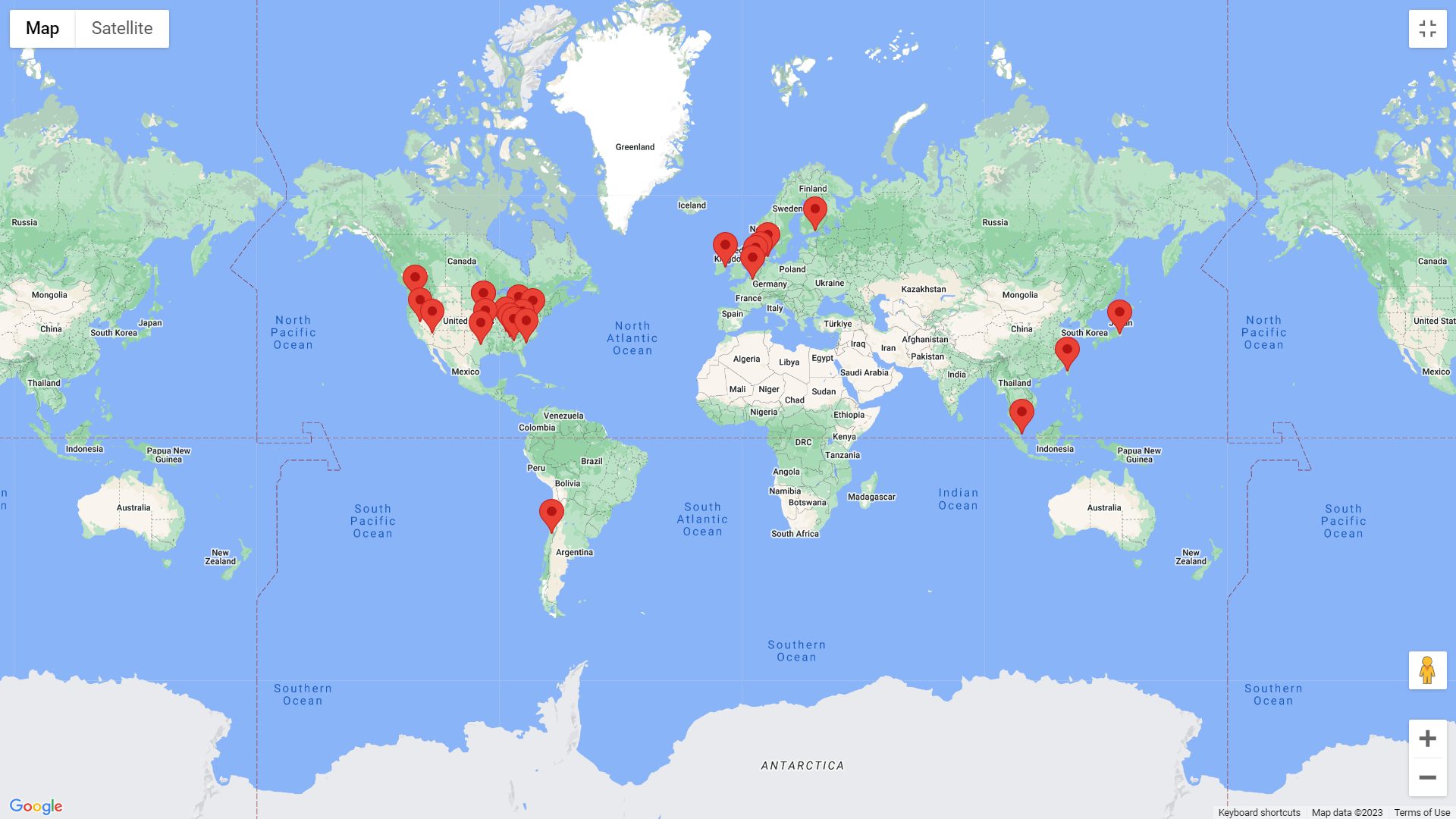

水の消費問題は、OpenAIやAIモデルに限ったことではない。2019年、Googleはたった3つの州のデータセンターに23億ガロン(約87億リットル)以上の水を要求した。同社は現在、北米に14のデータセンターを所有しており(※訳註5)、Google検索やWorkspace製品群、最近ではLaMDAやBardといった大規模言語モデルの開発に利用している。最近の研究論文によると、LaMDAだけで、訓練に数百万リットルの水を必要とする可能性があるという。同社のデータセンターはテキサス州のような暑い州にあるため、GPT-3の訓練より水を多く消費する。そして、研究者たちは以上の試算を「おおよその参考値」と呼んだうえで、水消費について警告を発している。

世界地図から見るGoogleのデータセンター所在地

さて!この試算は、テック企業にエネルギーや水を大量に消費するような計算をさせないようするために、私たち市民が使える手段を提供してくれる。もし市民が(地方自治体や州政府を通じて)地域が所有し管理する水を販売するのであれば、もっと厳しい交渉を行い、より多くの料金を請求できるだろう。企業の外部性(※訳註6)に対して厳しい価格をつけることは、基本的にそれら(外部性)を事業コストに組み入れるように仕向ける唯一確実な方法である。

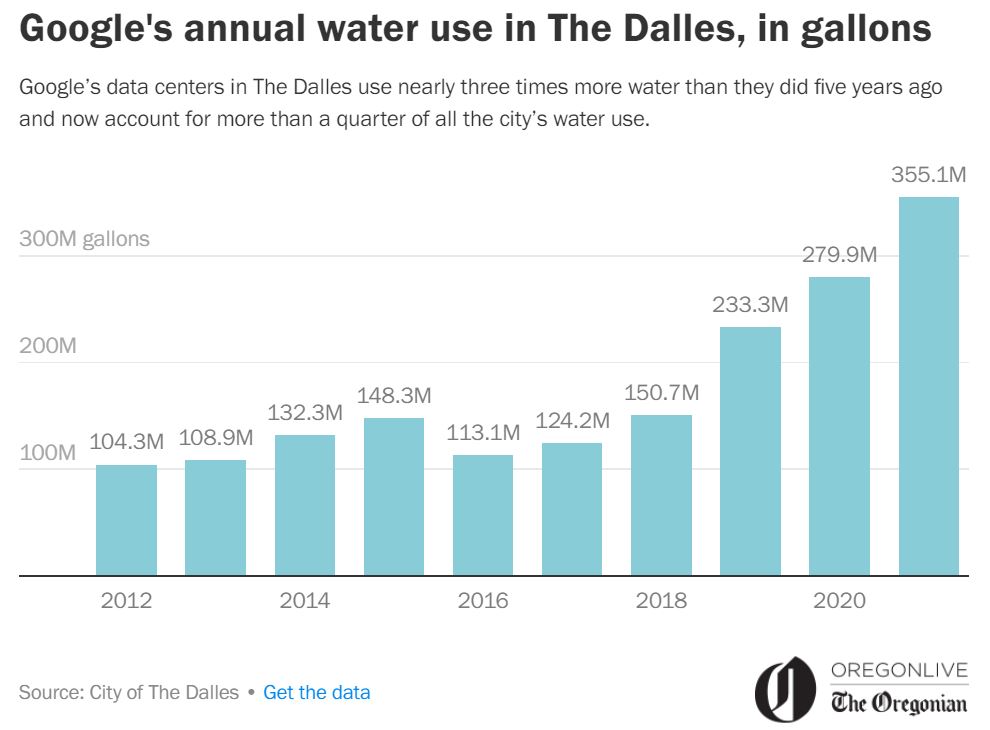

残念ながら、私はこの件に関しては期待していない。都市は20年来、テック大手にエネルギーや水に関する優遇策を提供することで、地方の繁栄をもたらすというよくある危なかったしい仮定にもとづいた結果、躓いてきた。市職員はテック企業に対してストックホルム症候群(※訳註7)に陥っているようだ。(次のような教訓となる話がある。オレゴン州ダレス市ではGoogleの水使用量が過去5年間で3倍近くになっていたのだが、同市はこの数字を公表していなかった。こうしたなかオレゴニアン/オレゴン・ライブ紙は同市を訴えることで、裁判官の判決によって市の官僚がデータを公開せざるを得なくなるまで追い詰めた。)(※訳註8)

Googleは2022年、ダレス市で3億5,500万ガロン(約13億4,000万リットル)の水を消費したが、この量は同市の年間総水消費量の29%に相当する。

2012年から2021年までのオレゴン州ダレス市におけるGoogleの年間水消費量推移

テック大手は、自分たちは全体から見れば、特に水を大量に消費しているわけではない、としばしば弁明する。Googleが指摘したように、同社の2021年の水の使用量は(アメリカ南西部にある)ゴルフ場におけるそれと同等だ。

全体として、Googleの2021年中の水の消費量は、全米で33億ガロン(124億リットル)、「追加的なグローバル拠点」(つまり世界のその他の地域)で9億7,100万ガロン(44億リットル)である。

これは非常に多く聞こえるかもしれないが(実際そうだ)、Googleのデータセンター事業の年間水消費量合計は、アメリカ南西部にある29のゴルフコースの水使用量に匹敵する、と同社は主張している。

公平を期すならば、以上の報告でGoogleが選んだ比較対象は、かなりひどいものである。ひどい理由は2つあり、a)ゴルフ場は、ますます不足する淡水の供給という課題と絶対的に衝突するコース上にあるため、持続可能な産業の例とは言えない。加えて、b)ゴルフコースの数は急増していないが、AIモデルの利用は増加しているのだ。

とはいえ、十分な圧力がかかれば(そしてまた、都市や州、あなた方住民の水に対する価格設定の動向に私は注目している)、テック企業が水の使用において根本的に効率的になるよう誘導することは十分に可能だ。

以上の主張はエネルギー問題で起こったことだ!(たとえ有利な契約で供給されたとしても)エネルギーにはコストがかかるため、テック企業は過去数十年にわたり、データセンターのエネルギー効率の改善に地道に取り組んできた。2010年には、データセンターは世界のエネルギーの約1%を使用していた。2020年までにデータセンターは6倍のデータを処理するようになったが、それでも世界のエネルギーの1%をかろうじて上回る程度であることがサイエンス誌の計算でわかった(※訳註9)。これはかなり印象的だ。

もちろん、水の供給はエネルギーの供給とは全く異なる。理論的には、われわれは大量のエネルギーをまだ利用できる。私たちは、太陽が毎日与えてくれるものを、やっと利用し始めたばかりなのだ。それとは対照的に地球上に新たな淡水を供給することは、現在のところ不可能である。

つまり、AIの水消費という課題、より一般的には計算における水消費という課題は、まだ私たちとともにあるのだ。

・・・

(この記事はいかがだっただろうか。もし面白いと思って頂けたら、冷たいグラスに美味しい水を注いで、「拍手」ボタンを探し出そう。そのボタンを1記事につき50回まで叩けます!)(※訳註10)

私は週に2回Mediumに記事を投稿しています。ここをフォローして、各記事をメールで受け取ってください。Mediumのメンバーでない方は、こちらから入会できます。月会費の約半分は、Mediumでの私の執筆支援に直接使われます。Mediumメンバーになれば、サイト上の他のすべての記事にアクセスできるようになります。

私はニューヨークタイムズ誌とWiredの寄稿ライターであり、『Coders』(邦訳『Coders(コーダーズ)凄腕ソフトウェア開発者が新しい世界をビルドする』)の著者でもあります。MastodonかInstagramでフォローしてください。

原文

『AI Is Thirsty』

著者

クライブ・トンプソン(Clive Thompson)

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん