画像出典:記事著者がMicrosoft Image Creatorで作成

目次

はじめに

2023年における生成AI市場の急拡大は、生成AIサービスの台頭と同時に新たな問題を産みました。その問題とは、GPUやAIチップ(※注釈1)を含むAIインフラ機器の世界的な不足です。この問題をめぐって、世界と日本のAI企業はAIインフラ機器の確保を争う(AIモデル開発競争とは別の)「もうひとつのAI開発競争」を繰り広げています。そこで本稿では以下のような内容を展開することを通して、この新たな競争の現状をまとめます。

|

AI市場を支えるAIインフラ層

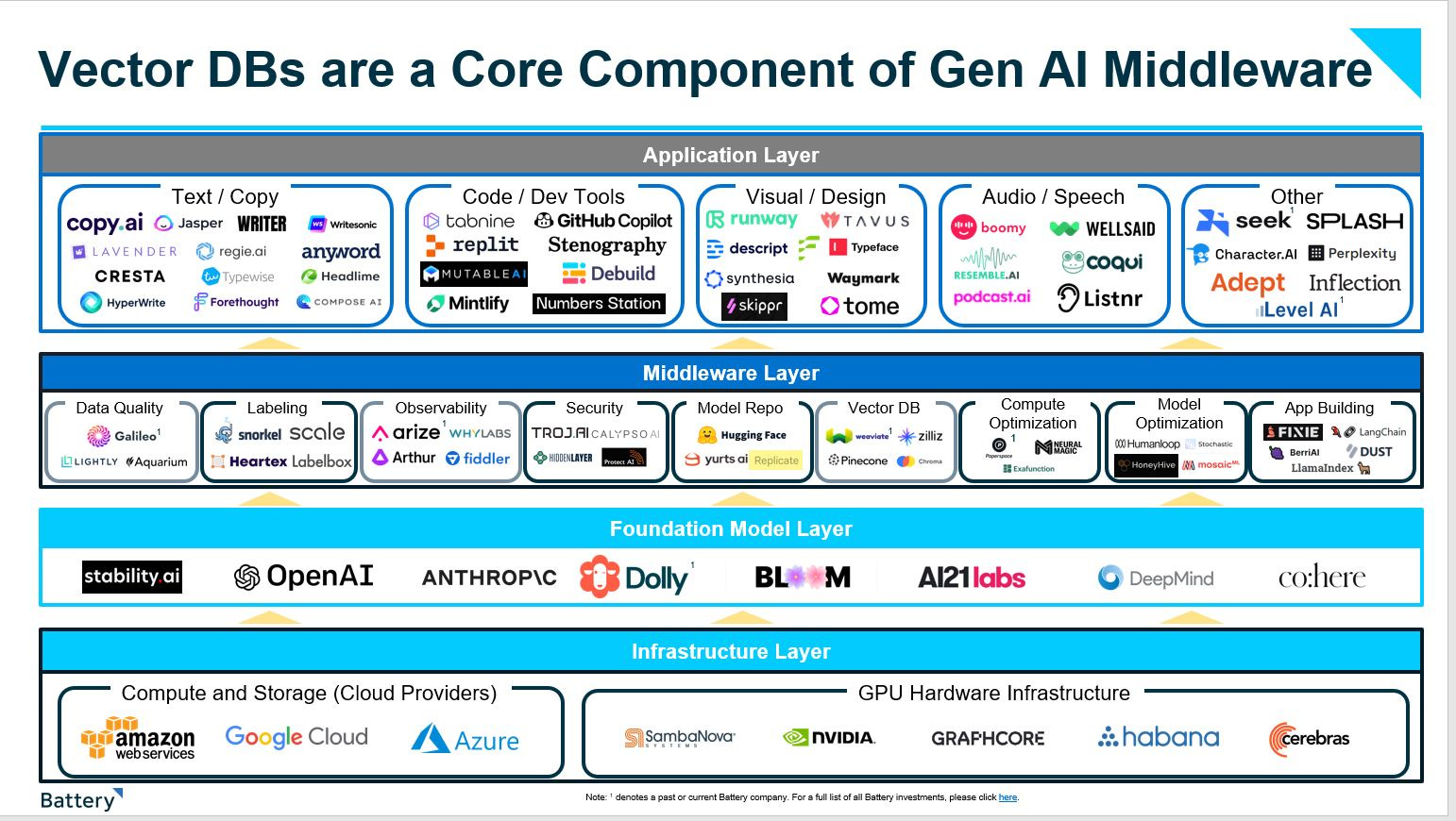

アメリカに拠点を置く投資会社Batteryは2023年4月22日、AI市場におけるインフラ機器の位置づけを明らかにするブログ記事を公開しました。その記事には、AI市場の階層構造を図示した画像が掲載されています。AI市場は、デジタルサービス市場が物理層からアプリケーション層までの階層構造を形成しているるのと同様に、以下のようなレイヤーから構成されています。

| インフラストラクチャ層 | AIアプリケーションの稼働を物理的に支える電子機器を提供する企業が属するレイヤー。この層の代表的企業はGPUを提供するNVIDIA、データセンターを運営するGoogleやAmazonなど。 |

| 基盤モデル層 | 多くのAIアプリが使用する基礎的なAI機能を提供する基盤モデルを開発・提供する企業が属するレイヤー。代表的な企業はChatGPTを開発するOpenAI、Stable Diffusionを開発するStability.aiなど。 |

| ミドルウェア層 | 基盤モデルほど汎用的ではないが、AIアプリ開発に活用されるAIモデルを開発・提供する企業が属するレイヤー。各種AIモデルを提供するHugging Faceが代表的企業。 |

| アプリケーション層 | さまざまなAIアプリを開発・提供する企業が属するレイヤー。動画生成AIアプリ「Gen-2」を開発するRunwayなどが代表的企業。 |

AI市場のレイヤー構造を図示した画像。画像出典:Battry Condensing the Cloud掲載記事

以上の各レイヤーで企業活動を継続するためには、レイヤーごとに異なるリソースと経営戦略が求められます。企業活動から見たレイヤーごとの特徴をインフラストラクチャ層と基盤モデル層を含む下方レイヤーと、ミドルウェア層とアプリケーション層を含む上方レイヤーに大別すると以下のようになります。

|

レイヤー |

求められる経営戦略 |

求められるリソース |

| 下方レイヤー | 事業の継続には大量のインフラ機器が不可欠なため、起業には多額の資金が必要。事業を黒字化するのに時間がかかるため、AI事業とは別の収益手段も必要となる。 | GPUをはじめとする大量のインフラ機器。 AI事業を黒字化するまでの収益源 |

| 上方レイヤー | ソフトウェア開発が基幹業務となるため、起業に多額の資金を必要としない。その一方でレッドオーシャンの市場なので、速いサイクルで研究開発する必要がある。 | ソフトウェア開発環境 速いサイクルでAIアプリを開発するための人材 |

2023年になって生成AI市場の急拡大に伴い、AI市場の全レイヤーで競争が激化しました。とくにインフラストラクチャ層と基盤モデル層の競争激化により、AIインフラ機器の需給バランスが需要過多に大きく傾きました。その結果、同機器の争奪戦が生じたのでした。

AIインフラ市場の現状

以下ではAIインフラ市場を各種発表データにもとづいて概観したうえで、同市場において大きなシェアを占めているNVIDIA製品をめぐる争奪戦の様相を確認します。

データから見るAIインフラ市場

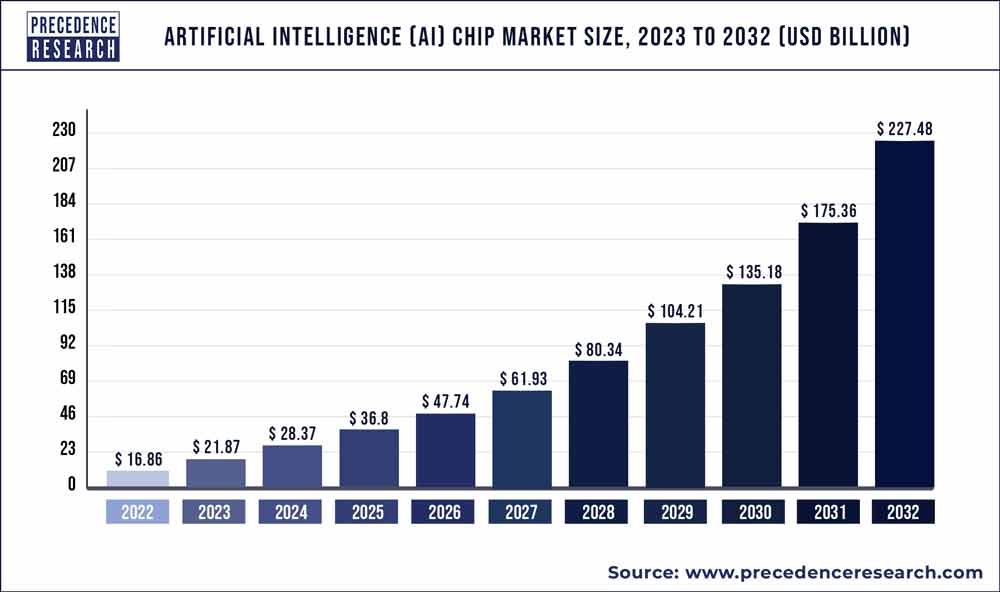

AIチップ市場は、生成AI市場の急拡大と軌を一にして成長が予想されています。こうしたなかカナダとインドに拠点を置く調査会社Precedence Researchは2023年1月、世界のAIチップ市場の成長予測を発表しました。2022年における同市場の規模は168億6,000万ドルと評価され、2023年から2032年までに年平均成長率29.72%で成長して、2032年には2,274億8,000万ドル規模となると予想されています。

世界のAIチップ市場の成長予測を図示したグラフ。画像出典:Precedence Research

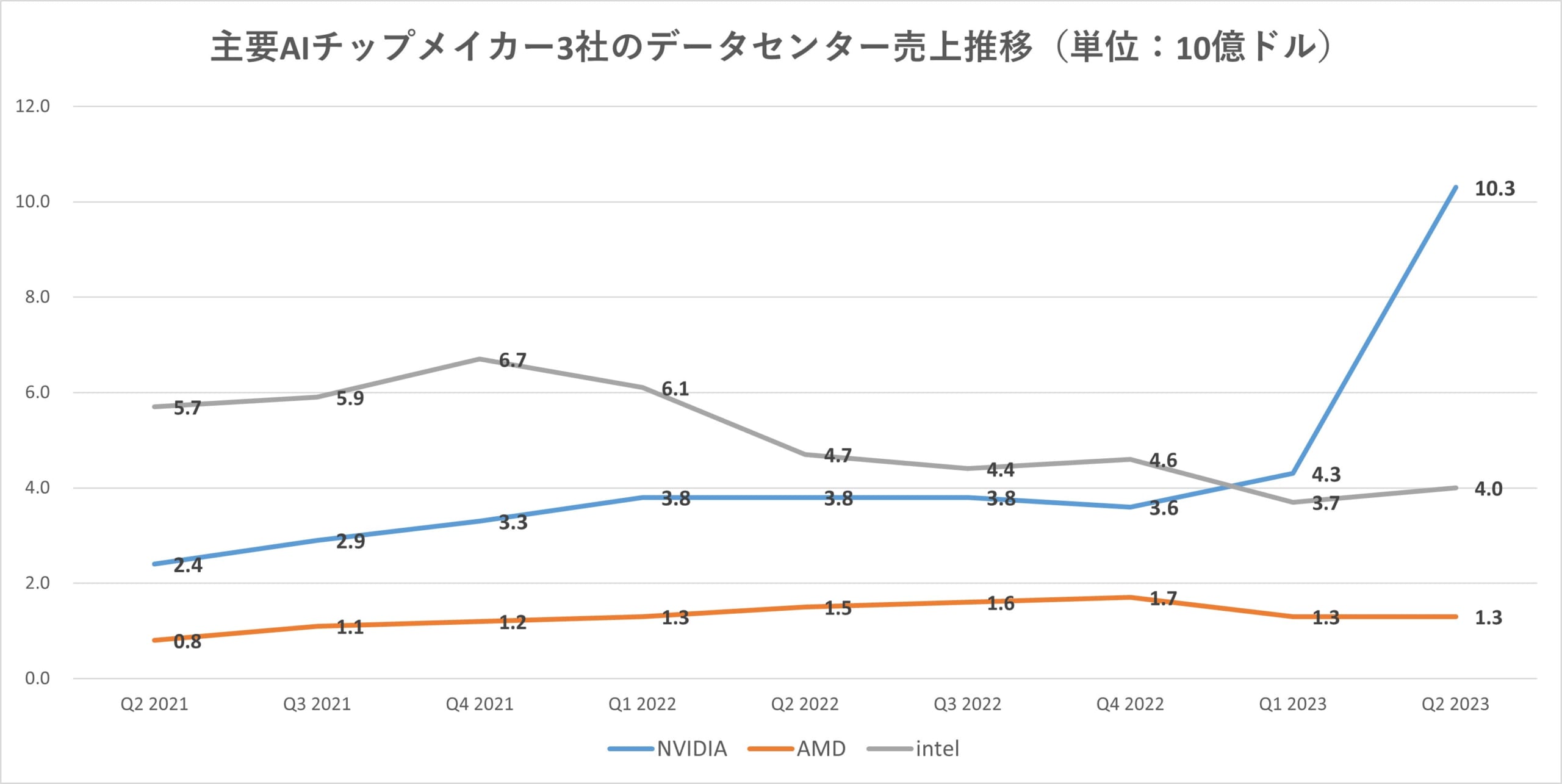

AIチップを製造する主なメーカーは、NVIDIA、AMD、そしてIntelです。これらのメーカーの動向について、経済メディアVisual Capitalistは2023年8月25日付けの記事で報じました。この記事ではAIチップの売上を公表していないメーカーがあることを鑑みて、3社を比較するためにAIインフラが活用されるデータセンターの各社売上推移が掲載されました。掲載されたデータにもとづいて、データセンター売上推移をグラフ化すると以下のようになります。生成AIブームが本格化した2023年第一四半期から同年第二四半期にかけて、NVIDIAが売上を急上昇させているのがわかります。

主要AIチップメーカー3社のデータセンター売上推移。画像出典:Visual Capitalis記事のデータにもとづいて記事著者が作成

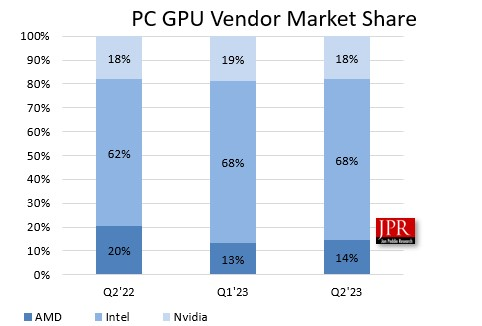

GPUについても、その主要メーカーはNVIDA、AMD、Intelです。アメリカ・カリフォルニア州に拠点を置くコンサルティング会社Jon Peddie Researchは2023年8月28日、2023年第二四半期までのGPU主要メーカーのGPUシェアを発表しました。そうしたシェアの推移は、以下のグラフのように図示できます。このグラフからわかるように、近年はNVIDIAがGPU市場の覇権を握っています。

2023年Q3までのGPU主要メーカーのGPUシェアを図示したグラフ。画像出典:Jon Peddie Research

以上のデータからNVIDIAがAIインフラ機器のトップメーカーであると言えます。同社は生成AI市場の急拡大によって大きく注目された結果、2023年10月31日時点の同社株価は2023年初めに比べて約185%(つまり約2.8倍)上昇しました。

2023年のNVIDIA株価推移。画像出典:Google Finance

NVIDIA製品の争奪戦

NVIDIA製品をどの程度所有できるかは、最近では下方レイヤーに属する企業の死活問題となっています。こうしたなかOpenAIのエンジニアであるアンドレイ・カルパシー(Andrej Karpathy)氏は2023年8月2日に、同社のデータセンター向けGPUの最上位モデルNVIDIA H100 Tensor コア GPU(通称「H100」:以下、通称で略記)を獲得できるかどうかが、シリコンバレーのトップゴシップになっている、とXにポストしています。

Who’s getting how many H100s and when is top gossip of the valley rn https://t.co/AxarseOmg9

— Andrej Karpathy (@karpathy) August 2, 2023

H100の需給に関しては、「NVIDIA H100 GPU:その供給と需要」という記事(2023年7月公開、2023年9月更新)が有名です。この記事では、前述のAI市場レイヤーに名を連ねている企業の推定H100希望購入台数(※注釈2)がまとめられています。そのデータは、以下のようにまとめられます。

|

企業名 |

所属レイヤー |

推定H100希望購入台数 |

| OpenAI(※注釈3) | 基盤モデル層 | 5万 |

| Meta | 基盤モデル層 | 2万5,000~10万 |

| AWS | インフラストラクチャ層 | 3万 |

| Google Cloud | インフラストラクチャ層 | 3万 |

| Azure | インフラストラクチャ層 | 3万 |

| Anthropic | 基盤モデル層 | 2万2,000 |

| Character.ai | アプリ層 | 1万 |

| Inflection | アプリ層 | 1万 |

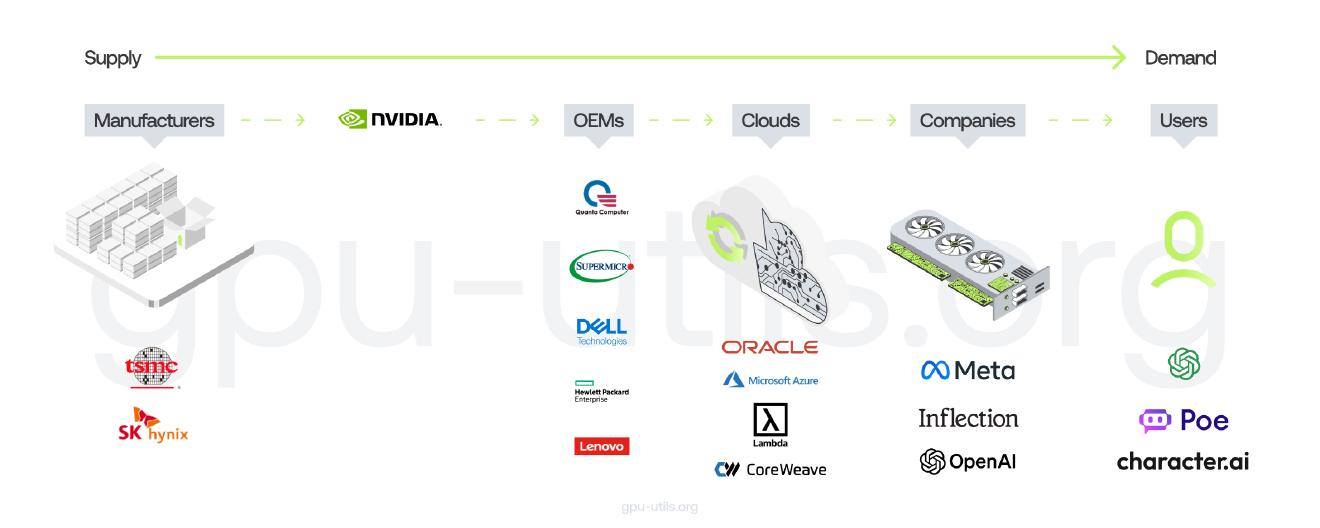

H100の供給を考察するにあたっては、同製品の販売経路を確認する必要があります。同製品は台湾のチップメーカーTSMCが製造後NVIDIAに納品され、その後、NVIDIAが各企業の注文に対して同製品を販売します(以下の画像も参照)。こうした経路を経て各企業が同製品を入手するまでには、(あくまで関係者からの伝聞がソースとなりますが)2023年9月時点で6ヵ月はかかるとされています。

H100の販売経路。画像出典:H100需給考察記事

企業がH100を入手するにあたっては、NVIDIAの同製品割当方針も大きく影響します。同社は同製品を販売するにあたって、以下のような方針があると考えられています。

|

以上の考察を含むさまざまな事情を考慮すると、少なくとも2023年末までは数百から数千単位でH100が不足し続け、こうした供給不足は2024年の一部まで続くと考えられます。

改善の予兆?

もっとも、最近になってH100供給が改善しつつあるという報道もあります。例えばアメリカ大手メディアCNBCは2023年9月27日、Microsoftのケビン・スコット(Kevin Scott)CTOがアメリカ・カリフォルニア州で開催されたカンファレンスでNVIDIAのAIチップの供給が改善しつつあると発言したことを報じました。

また、日本経済新聞は2023年10月17日、アメリカ政府がNVIDIA製品を念頭においてAI向け先端半導体の中国への輸出規制を強化することを報じました。この規制により同社製品の供給先が減るので、その結果として、日本をはじめとする中国以外の国への供給が改善されるかも知れません。

以上のようにNVIDIAのAIインフラ製品の供給は改善の兆しはあるものも、同製品を入手したい企業の希望が完全に満たされるにはまだ時間がかかるでしょう。

世界のAI企業のAIインフラ事情

以下では世界の有名AI企業のAIインフラ状況を確認します。

Googleは世界各地に合計14のデータセンターを所有しており、そのなかには千葉県印西市にあるものもあります。そうしたデータセンターから、AIの訓練や推論に活用される計算資源が提供されています。同社はGPUの所有数を公表していませんが、世界トップレベルの所有数であると推測されます。

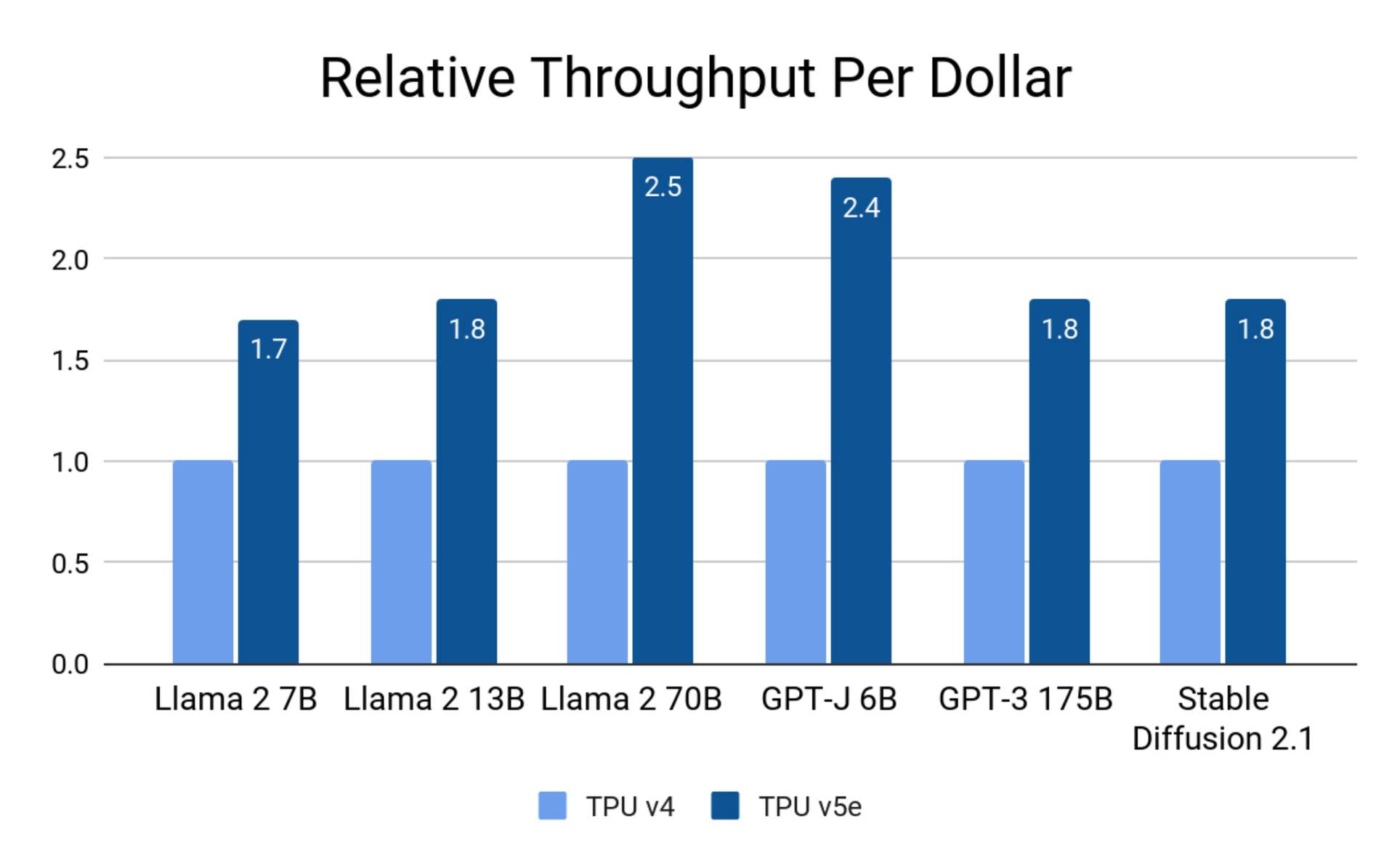

Googleの強みは、自社製AIチップを開発しているところです。Google Cloud公式日本ブログは2023年9日15日、同社製AIチップのTPU v5eを紹介する記事を公開しました。同チップは同社が製造するAIチップ「TPU(Tensor Processing Unit)」の最新モデルであり、その性能を前世代モデルTPU v4と比較すると、1ドル当たりの推論パフォーマンスが最大2.5倍向上しました(以下のグラフ参照)。

TPU v4とTPU v5eの1ドル当たりの推論パフォーマンスを比較したグラフ・画像出典:Google Cloud公式ブログ記事

2023年5月16日にはGoogleとNVIDIAが提携して開発したAI向けインフラストラクチャ「A3 VM」の限定公開プレビュー版の提供を発表しました。このインフラストラクチャには、NVIDIA H100が搭載されています。

また、Googleは有力AIスタートアップに計算資源を提供しています。例えば、2023年2月6日、同社はAnthropicと技術提携してGoogle Cloudの計算資源を提供することを発表しました。ちなみにAnthropicは2023年10月17日、同社開発の対話型AI「Claude.ai」を日本を含む95ヶ国でサービス展開することをXに投稿しています。

Microsoft

Microsoftのクラウドサービス「Azure」は、同社と技術提携しているOpenAIをはじめとしたAI企業の計算資源として活用されています。同社の公式発表によると、同サービスで運用されているデータセンターは「世界中に60 以上のリージョンを備え、140 の国/地域で利用」できる世界トップレベルの規模です。

ChatGPTの訓練にはAzureの計算資源が活用されたと推測されますが、NVIDIA日本法人でテクニカルマーケティングマネージャーを務める澤井理紀氏のプレス説明会の様子を伝えた2023年7月19日公開のImpress Watchの記事によると、同モデルの訓練には約10,000基のNVIDIA GPUが数週間稼働していた、ということです。

NVIDIA澤井理紀氏の発表資料。画像出典:Impress Watch

また、Microsoftは2023年3月13日、AIインフラストラクチャ「ND H100 v5 VM」を発表しています。このインフラストラクチャでは、8基から数千基までのNVIDIA H100が利用できます。

Meta

Metaは自社製スーパーコンピュータ「RSC(Research SuperCluster)」を開発運用しています。同コンピュータは大規模言語モデルをはじめとしたAIモデルの開発を想定して設計されており、2023年5月18日公開のAI at Meta(MetaのAI研究部門)公式ブログ記事によると、16,000基のNVIDIA A100 Tensor コア GPUと2,000基のNVIDIA DGX A100システムによって構成されています。同コンピュータは、LLaMAの訓練などに使われました。

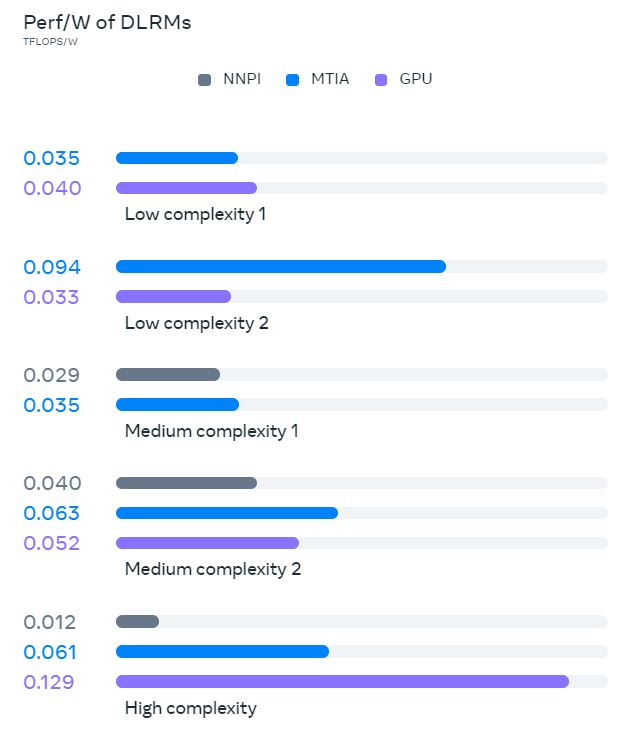

Metaは、同社製AIチップ「MTIA v1」も設計しています。2023年5月18日のAI at Meta公式ブログ記事によると、同チップの性能評価のために同社が開発したAIモデル「DLRM」を用いたテストを行いました。具体的には、MTIA v1とNNPI(Neural-Network Processor for Inference)、そしてGPUのぞれぞれで複雑度の異なるDLRMを稼働させてみて、計算効率を比較してみました。その結果、MTIA v1は複雑度が小あるいは中のDLRMの処理については高い計算効率を実現しましたが、複雑度が高い場合にはGPUに及ばないことがわかりました。それゆえ、MTIA v1はまだ改善の余地がありそうです。

複雑度の異なるDLRMを使ったMTIA、NNPI、GPUの比較実験結果。画像出典:AI at Meta記事

AWS

AWSは2023年7月26日、生成AI とHPC向けに最適化されたクラウドサービス「Amazon EC2 P5インスタンス」を発表しました。同サービスには、NVIDIA H100が搭載されています。このインスタンスを活用したインフラストラクチャ「Amazon EC2 UltraCluster」には、最大20,000基のH100を搭載できます。

日本のAIインフラ動向

日本のAIインフラに関する主な動向を、生成AI市場の急拡大が始まった2023年初めから時系列にまとめると、以下の表のようになります。

|

発表日 |

発表内容 |

| 2023/1/31 | 株式会社サイバーエージェント、80基のH100から構成されたNVIDIA DGX H100を導入。 |

| 2023/6/16 | さくらインターネット株式会社、H100を活用したクラウドサービスの提供計画を発表。H100を2,000基以上採用したサービスを2024年1月以降に提供開始予定。 |

| 2023/7/6 | NEC、同社製大規模言語モデルを開発。パラメータ数は130億、開発環境には同社のAIスーパーコンピュータを活用。同コンピュータは、NVIDIA A100 80GB Tensor コア GPUをノード当たり8基搭載するGPUサーバを96台搭載。 |

| 2023/7/4 | 国立研究開発法人情報通信研究機構(National Institute of Information and Communications Technology:略称「NICT」)、400億パラメータの大規模言語モデルを開発。開発環境には、NVIDIA A100(80GB)が128基が採用された。 |

| 2023/7/12 | 産業技術総合研究所、AI橋渡しクラウド(AI Bridging Cloud Infrastructure:略称「ABCI」)を活用する第1回 大規模言語モデル構築支援プログラムの公募開始。ABCIは960基のNVIDIA A100 GPUアクセラレーターを備えた120台の計算ノードと、4,352基のNVIDIA V100 GPUアクセラレーターを搭載している。 |

| 2023/9/28 | 株式会社Preferred Networks、130億パラメータの大規模言語モデル「PLaMo™-13B」を公開。同モデルは上記プログラムに採択されたことで完成した。 |

| 2023/10/20 | 国立情報学研究所(National Institute of Informatics:略称「NII」)、130億パラメータの大規模言語モデル「LLM-jp-13B」を構築。計算資源にはデータ活用社会創成プラットフォームmdxを活用。同プラットフォームは8基のNVIDIA Tesla A100 (GPUメモリ40GiB)から構成されたノードが40個搭載されている。 |

| 2023/10/31 | ソフトバンク株式会社、2024年内を目標に3,500億パラメータの国産大規模言語モデルを開発することを発表。計算基盤にはNVIDIA Tensor コア GPU(モデル名非公表)を2,000基以上搭載したスーパーコンピュータを活用。 |

以上のように日本国内の研究機関では、H100より廉価なNVIDIA A100シリーズが活用されています。また、国産大規模言語モデルの開発に使われたGPU数は、ChatGPTやLLaMAの開発に使われた数と比較すると一桁以上少ないこともわかります。

OpenAIの画策

AIインフラ機器が不足するなか、AI企業はNVIDIAからの製品供給を座して待つしかないのでしょうか。OpenAIは、こうした現状の打破を画策しているようです。

テック系メディア『The Verge』は2023年9月28日、OpenAIのサム・アルトマンCEOが元Apple最高デザイン責任者のジョニー・アイブ(Jony Ive)氏に接触したことを報じました(1次ソースはThe Information)。この記事によると、両氏はAIと対話するための「より自然で直感的なユーザーエクスペリエンス」を提供するデバイスを作ることを目指しており、ソフトバンクグループ株式会社代表取締役会長兼社長の孫正義氏に資金提供を働きかけているようです。この計画では、孫氏が株式の90%を保有するNVIDIAのライバル企業Armが中心的な役割を担うとも見られています。

アルトマンCEOとアイブ氏が目指す新たなAI製品は、スクリーンがインタラクションの中心にならない可能性がある、とのこと。つまり、新しい「OpenAI製スマホ」ではなく、iPhoneのように新しいユーザーエクスペリエンスを提供して新たなデジタル文化を創出する「生成AI時代のiPhone」を実現しようとしているのです。

2023年10月6日には、OpenAIが自社製AIチップの製造を模索している、とロイター通信によって報じられました。この報道は、同社製AIチップ製造のほかに、NVIDIAとのより緊密な提携、NVIDIA以外とのAIチップメーカーとの提携強化などの選択肢も検討している、とも伝えています。

OpenAI製AIチップ製造の可能性に関しては、同社は企業買収によって製造計画を加速化すするために、買収企業のデューデリジェンス(買収候補企業の調査)の着手を視野に入れています。

以上のような最近のOpenAIに関する報道にもとづけば、2020年代に誕生するかも知れない「OpenAI製携帯端末」には同社製のAIチップが搭載されるかも知れません。そして、こうした携帯端末はオンデバイスAI製品となり、端末内でAI処理が完結するとも予想されます。

ChatGPTのようなクライアントサーバシステム型AIに対する対義語となるオンデバイスAIは処理が高速なうえに、サーバにデータを転送しないのでセキュリティに優れている一方で、AIの出力品質が(クライアントサーバシステム型AIに比べて)落ちるという欠点が知られています。しかしながら、携帯端末に最適化されたAIチップを活用すれば、高い出力品質が実現できるかも知れません。

対策と今後の展開

現在のAIインフラ機器不足は改善の兆しがあるものも、この問題が解消するにはもうしばらくの時間を要します。こうした現状に対して、AI企業が講じられる対策は以下のように列挙できます。なお、以下の対策は後に挙げたものほど、講じる難易度が高くなります。

|

最後のほうに挙げた2つの対策は、実行するには多大な研究開発費と長期的な取り組みが不可欠なので、これらの対策を採用できるのは(OpenAIやGoogleのような)一部のAI企業に限られるでしょう。

日本国内のAIインフラ市場に関しては、2022年8月に設立された半導体メーカーのラピダスの動向に注目すべきでしょう。nippon.comが2023年8月8日に公開したインタビュー記事『新たなコンセプトで先端ロジック半導体製造へ:ラピダスの小池淳義社長に聞く』では、小池淳義ラピダス社長が以下のように発言しています。

” 今盛んに取り上げられているAIチップ。ここで重要なポイントは、汎用のGPUから専用のAIチップに変わっていくということだ。モバイルから自動車からあらゆるものにAIチップが必要になり、巨大なマーケットが出てくるのだが、一社がそれを独占して製造するのを顧客は求めなくなっている。ラピダスは、TSMCがアップル向けの半導体を生産するような、工場丸ごと一つの顧客のために使うというようなことはしない。中規模の量を求める顧客のニーズに対応する。”

以上の発言にしたがえば、今後日本では用途ごとのAIチップの供給が改善されるかも知れません。

いずれにしろ、AIインフラ機器不足は短期間では解決しそうにない問題です。それゆえ、この問題は多くのAI企業の経営方針に影響を与えると同時に、(OpenAIの自社製AIチップ製造の画策のような)この問題に対する対処によって、将来的にAI市場全体が再編成される可能性があるでしょう。

記事執筆:吉本 幸記(AINOW翻訳記事担当)

編集:おざけん