Turing Bletchleyは、今年1月にOpenAIが発表したDALL-Eのように何らかのオブジェクトを意味する任意のテキストを入力すると、そのテキストの意味に合致する画像を検索できる画像言語表現モデルの最新型です。同モデルで実行できるタスクをまとめると、以下のようになります。

Turing Bletchleyが実行可能な検索タスク

|

Turing Bletchleyは、以上の各タスクにおいて最高性能を達成しました。こうした同モデルは、ウェブから収集した数十億のキャプションと画像のペアを学習データとして訓練したのに加えて、キャプションを多数の言語で理解できるように訓練したことによって実現しました。

ちなみに、DALL-E以降に開発された画像言語表現モデルにはTuring Bletchleyのほかに以下の記事で言及されているGoogleが開発したALIGNなどがあり、1年足らずで大きく進歩したと言えます。

以下の翻訳記事の理解と解釈は、翻訳者およびAINOW編集部の責任において行われたものです。また、翻訳記事の内容は特定の国や地域を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

目次

序文

本日、Microsoft Turingチーム(※訳註1)は、94の言語で画像言語タスクを実行できる2億5,000万のパラメーターを持つユニバーサル画像言語表現モデル(T-UILR)Turing Bletchley(※訳註2)を紹介できることを嬉しく思います。同モデルは、意味的に類似した画像やテキストが互いに整列するように、入力された画像とテキストをそれぞれベクトル化する画像エンコーダーとユニバーサル言語エンコーダーを備えています。このモデルは、他に類を見ない強力な機能を備えており、画像言語理解において画期的な進歩を遂げています。

T-Bletchleyは、英語の画像言語データセット(ImageNet、CIFAR、COCO)に関しては、Googleが開発したALIGNのような最先端モデルよりも優れており、ユニバーサル画像言語データセット(Multi30k、COCO)についてはMULE、SMALR、M3Pを凌駕する性能を発揮します。T-Bletchleyが実際に動作している様子をご覧になりたい方は、デモをお試しください。

マルチモーダルとユニバーサルの意義

「浜辺の美しい夕日」を表す画像

言葉と視覚は本質的に結びついています。「浜辺の美しい夕日(a beautiful sunset on the beach)」という言葉を聞いたとき、私たちは上のような画像を想像します。言語のみに焦点を当てたモデルでは、このつながりを捉えられません。このようなモデルでは、文章は文法的に正しい単語の連なりでしかありません。

さらに、視覚はグローバルなモダリティでもあります。浜辺の夕日という同一の光景をどんな言語で語っても(「una hermosa puesta de sol en la playa」(スペイン語)、「un beau coucher de soleil sur la plage」(仏語)、「Matahari terbenam yang indah di pantai」(インドネシア語)など)、対応する視覚表現は変わりません。従来のマルチモーダルモデルでは、視覚を特定の言語(最も一般的には英語)に結びつけていたため、視覚の持つこの普遍的な特性を捉えられませんでした。

T-Bletchleyは、以上の2つの欠点を解決します。マルチモーダルなアプローチにより、同モデルはコンピュータが言語を理解する能力とピクセルだけで画像を(テキスト情報を介さずに)そのまま理解する能力を進化させています。さらにモデルを開発する際には、ユニバーサルファーストというアプローチを採用して言語のモダリティを考慮しています。その結果、94の異なる言語の画像とテキストを理解する、他に類を見ないユニバーサル・マルチモーダル・モデルが完成し、素晴らしい機能を発揮することになりました。例えば同モデルは、メタデータや(画像に含まれた)周囲のテキストなどの余分な情報を使用せずに共通の画像-言語ベクトル空間を利用して、あらゆる言語で提供されたテキスト記述にマッチする画像を検索できます。また、任意の言語で書かれたテキストベースの質問に答える画像や、別の画像と意味的に似ている画像も見つけられます。

T-Bletchleyの実行

T-Bletchleyの能力を検証するために、学習時にモデルが見ていないウェブ上の画像を3,000万枚ランダムにサンプリングした画像検索システムを構築しました。これらの画像はキャプションやalt-textなどのテキストメタデータが一切ない状態で、画像エンコーダーによってエンコードされ、インデックスに格納されました。

(T-Bletchleyの機能検証に際して)テキストから画像への検索と,画像から画像への検索の2種類の検索システムを構築しました。(テキストから画像への検索ではテキストエンコーダーを、画像から画像へのそれでは画像エンコーダーを使って)入力されたクエリをベクトル化するようにもしました。エンコードされたベクトルをキーとし、近似最近傍(ANN)アルゴリズムであるHNSW(※訳註3)を用いて、ベクトル空間内の最近傍を見つけるためにインデックスに問い合わせます。そして、そうして得られた最近傍の画像は検索結果として表示されます。

今日の画像検索システムは、画像のキャプション、alt-text、周囲のテキスト、画像のURLなど画像で利用可能なテキストメタデータに大きく依存しています。T-Bletchleyの特徴はエンコードされた画像ベクトルだけで画像検索を行えて、テキストメタデータを一切使用しないところです。この特徴は現在のシステムと比較して、真の画像理解のための大きな一歩となります。さらに、同モデルのデモは事前学習したモデルをそのまま使って構築されており、画像検索タスクのためにファインチューニングしていません。

また、現在の画像検索システムがオブジェクト・タギング(タグ付け)・アルゴリズムを使っており、このアルゴリズムが適用される画像にはテキストで書かれたメタデータが補強されます(つまり、画像から生成された自動車、家、波辺などのタグを追加されるのです)。オブジェクト・タギング・システムは人間がラベルを付けたデータで訓練されるため、クラス(タグ)の数が非常に限られています。T-Bletchleyは教師なしのデータで訓練されているため、非常に多くのオブジェクト、アクション、そして(ダンス、プログラミング、レースなどの)現実世界の多くの概念を理解しています。

以下に、画像検索システムにおけるT-Bletchleyの能力を示す例を示します。

ユニバーサルなテキストから画像への検索

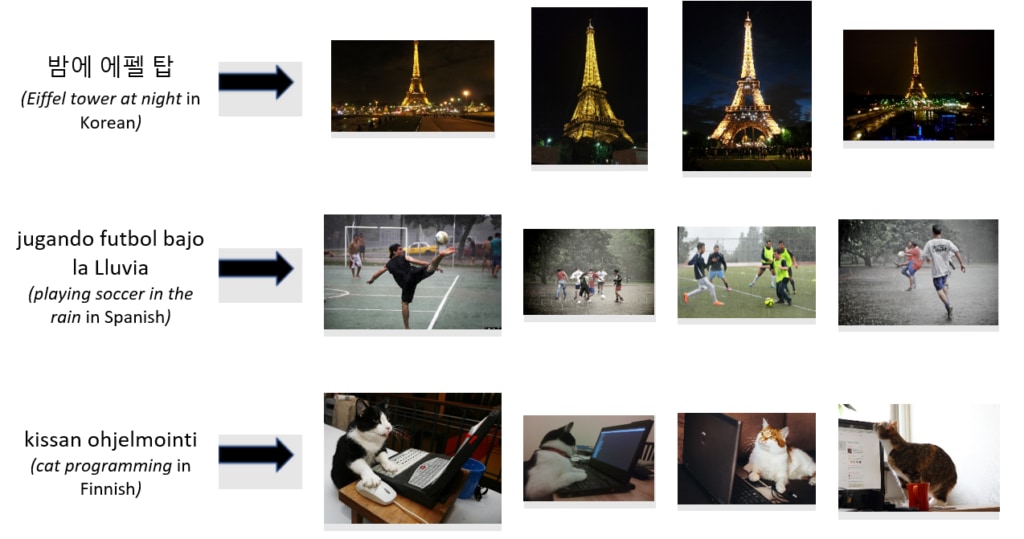

複数の言語で書かれたテキストベースのクエリで検索した画像の例を以下に紹介します。

3つ目の事例では、T-Bletchleyがプログラミングという行為を「理解」し、猫がプログラミングをしている画像専用のベクトル部分空間を生成しているのを示しています。本当の意味での画像理解とは、現在の検索システムをより画像自体を重視するように改善するために利用できるのです。

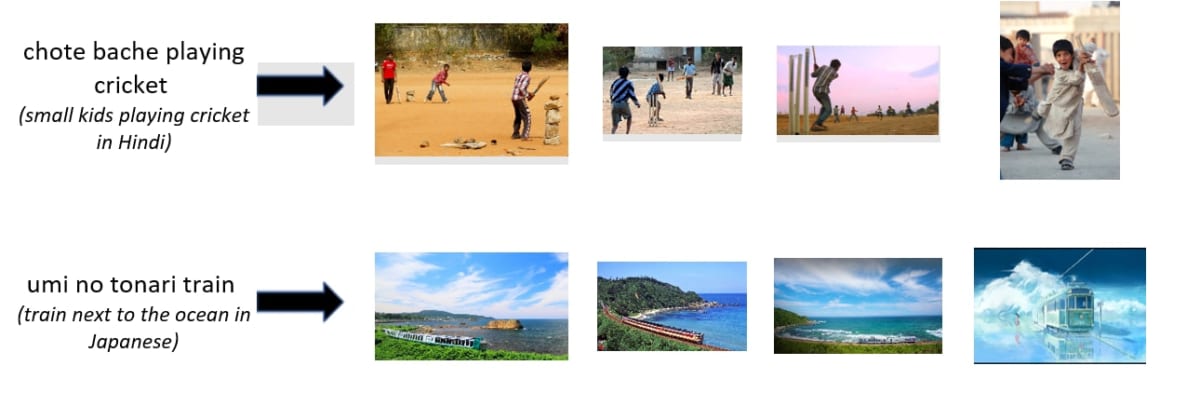

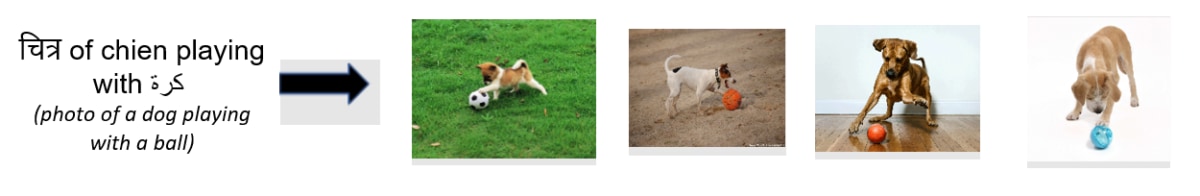

コードスイッチ検索

T-Bletchleyは、英語以外の言語を含む英語のスクリプトで書かれたクエリから画像を検索できます!

T-Bletchleyは、複数の言語やスクリプトを含む文章を理解できます。

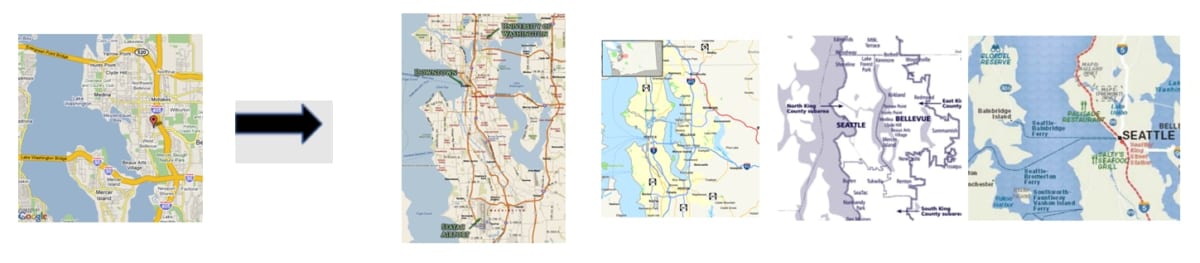

画像から画像への検索

画像検索を評価するために、与えられた画像を画像エンコーダーによって符号化し、最も近い画像ベクトルとそのベクトルに対応する画像をインデックスから検索しました。T-Bletchleyは画像に最適なキャプションを選ぶように訓練されているため、視覚的に似た画像ではなく、意味的に似た画像を好む傾向があります(※訳註4)。

T-Bletchleyによって検索された画像は、必ずしもクエリ画像と外観が似ているわけではありません。しかし、同じ地理的条件の画像は、「意味的に似ている」のです。同モデルは、入力画像と見た目が似ている以下のような検索群から検索結果を返しません。

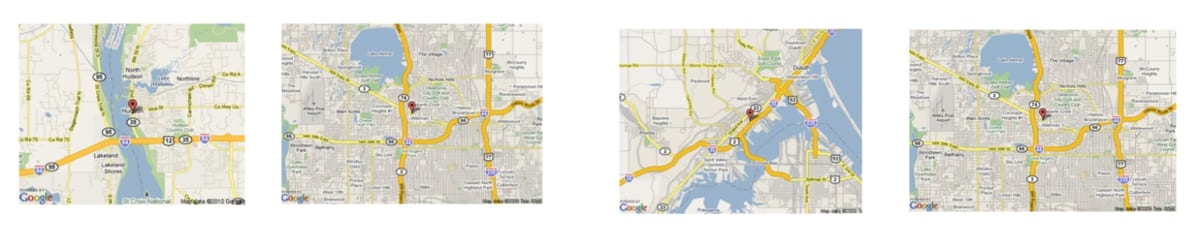

画像内のテキスト理解

T-BletchleyはOCR技術を使用せずに、画像内のテキストを理解できます。以下の例では、画像は直接画像エンコーダーに渡され、1024次元のベクトルとして格納され、これらのベクトル間のコサイン類似度のみを用いて類似画像を検索しています。

最初の例では、T-Bletchleyは画像内のテキストがミクロ経済学とマクロ経済学の違いについてのものであることを理解し、類似のスライドを検索します。2番目の例では学習データがCOVID-19以前のものであるにもかかわらず、同モデルはCOVID-19に関連する画像を検索しています。

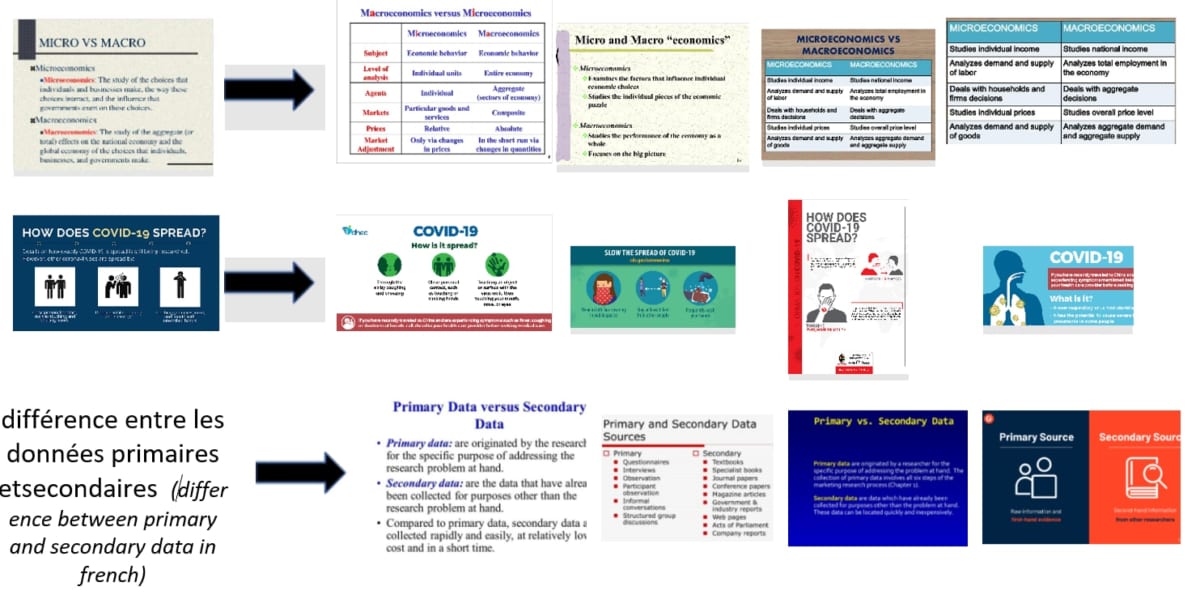

こうした画像内のテキスト認識機能はユニバーサルなもので、複数の言語で使用できます。以下の例では、フランス語とアラビア語で検索を行っています。

T-Bletchley:モデル開発

データセット

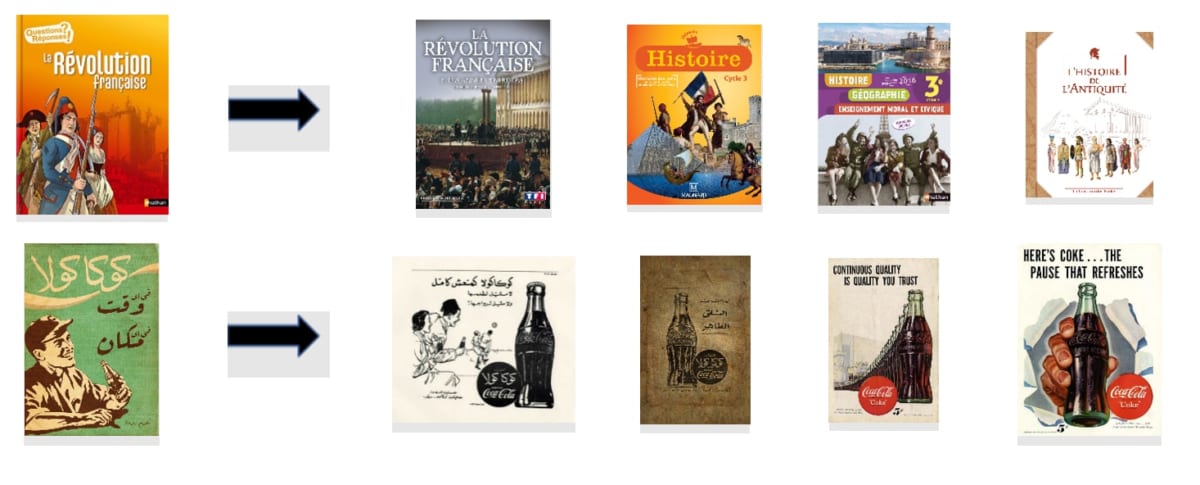

T-Bletchleyは、ウェブから抽出した数十億の画像とキャプションのペアを使って学習しました。

このデータセットの例を以下に示します。

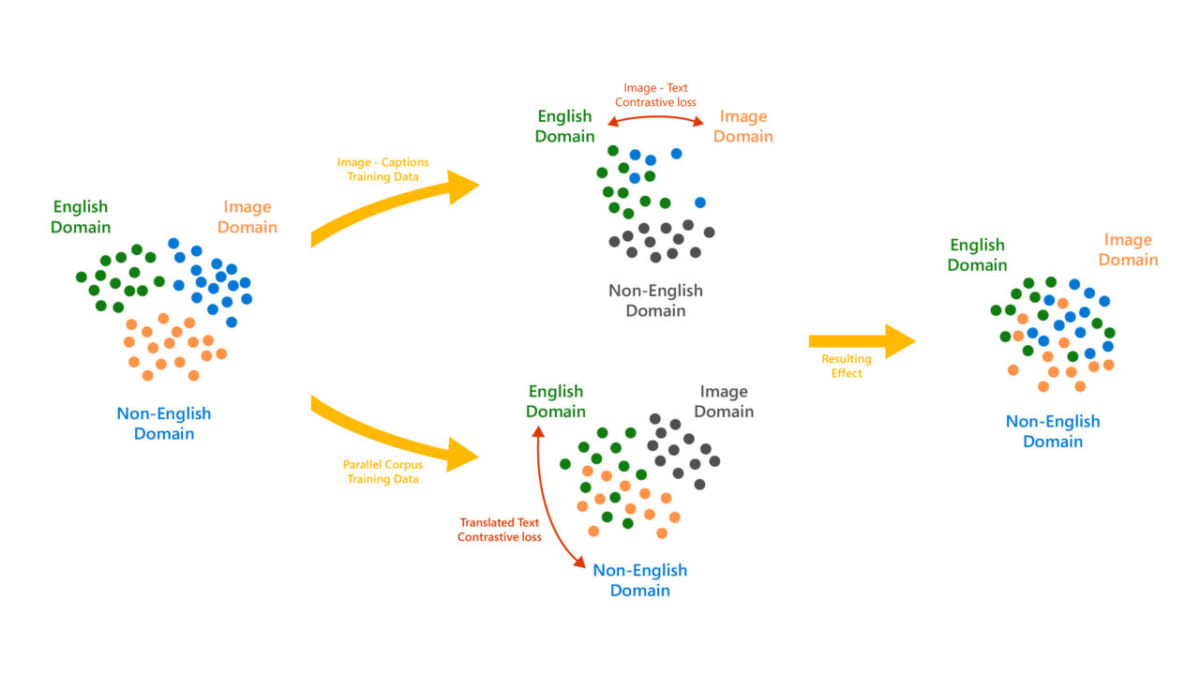

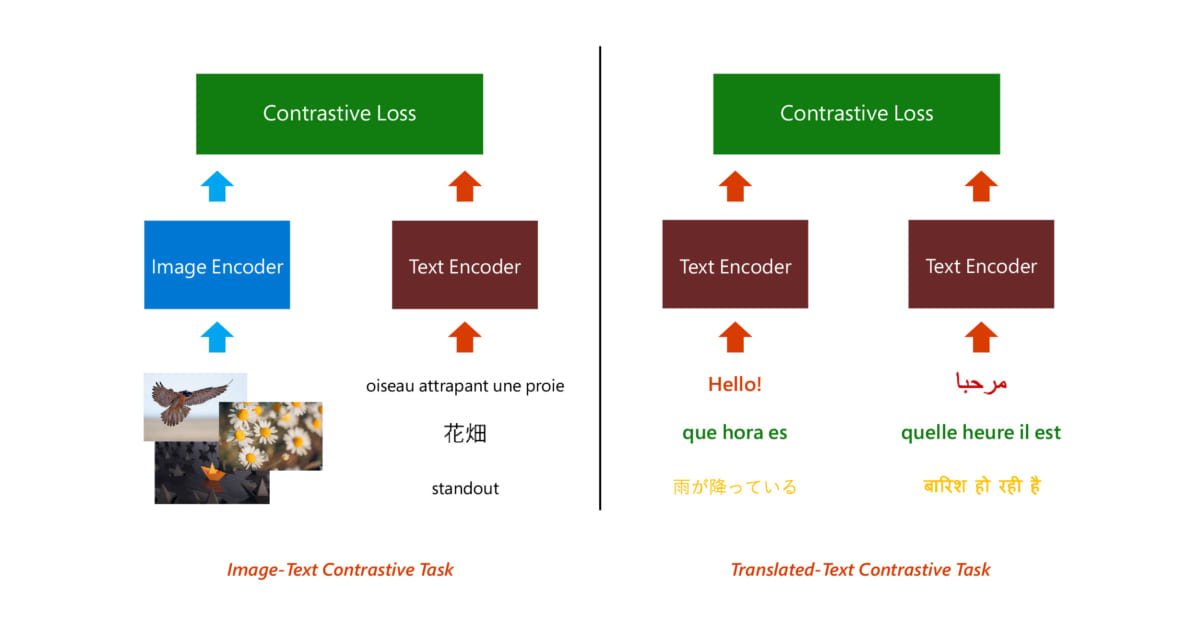

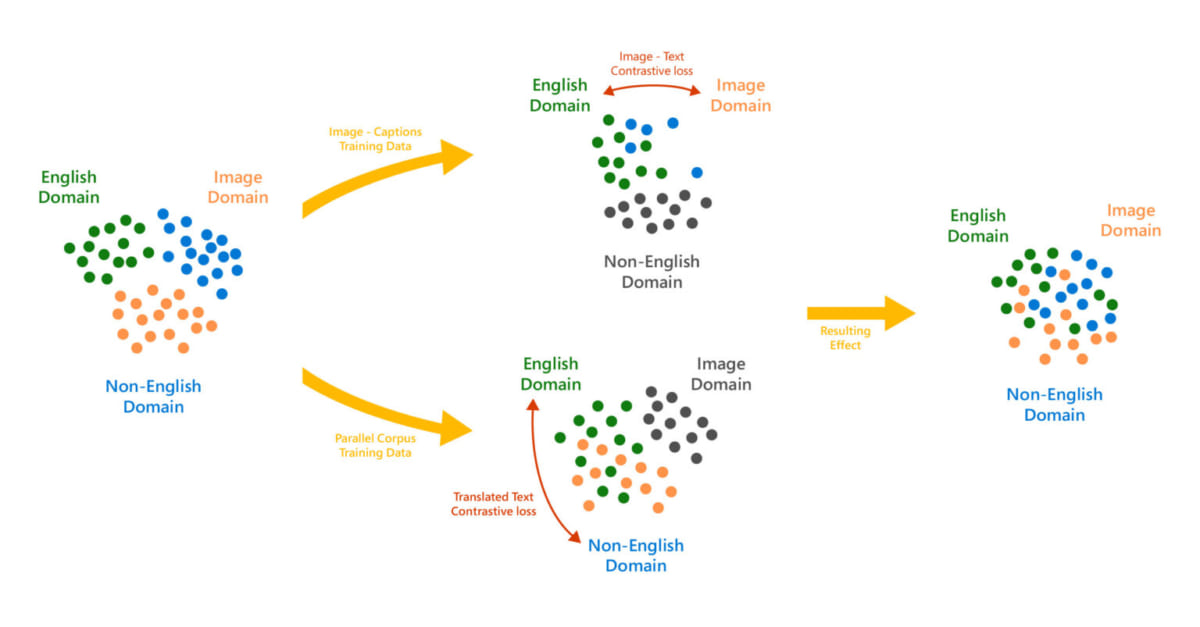

大規模で多様な学習データセットにより、さまざまな画像を扱える堅牢なモデルが得られました。ユニバーサル性を実現するために、5億の翻訳ペアからなるパラレルコーパスでモデルを学習しました。これらのペアは、一般的なクロールコーパスからドキュメントに沿ってウェブページの文を抽出して作成されました。また、「翻訳文対照タスク」を追加することで、言語にとらわれないキャプションのベクトル表現を作成でき、モデルのユニバーサル性を高められました。

モデルアーキテクチャと訓練

T-BletchleyはTransformerにもとづいた画像とテキストのエンコーダーから構成されており、こうしたアーキテクチャはどちらもBERT-largeのそれに似ています。

画像とキャプションはそれぞれ独立して符号化され、生成された画像とテキストのベクトルに対照損失(※訳註5)を適用してモデルを学習しました。同様に、言語にとらわれない表現を行うために、翻訳ペアにおける各国語の文を独立して符号化し、生成されたベクトルのバッチに対照損失を適用しました。

このようにして画像のキャプションのペアは主に英語であるにもかかわらず、画像に対応するさまざまな言語で書かれたキャプションを整列できたのでした。

Transformerの実装には(PyTorchとの互換性がある)DeepSpeedライブラリのカーネルを、モデルの学習にはZeROオプティマイザーを活用しました(※訳註6)。

詳細なモデル評価

T-Bletchleyは、複数のパブリックベンチマークにおいて最先端の記録を更新しました。

英語

英語に関する評価では、Googleが発表したALIGNの論文で行われたプロンプトエンジニアリングとアンサンブリングを踏襲しました(※訳註7)。T-Bletchleyは、英語の画像言語のベンチマークでGoogleのALIGNモデルを上回り、OpenAIのCLIPモデルが開拓したゼロショット画像の分類において、新たな技術水準を確立しました(※訳註8)。

|

モデル名

|

ImageNet

|

CIFAR-100

|

CIFAR-10

|

COCO R@1

画像からテキスト

|

COCO R@1

テキストから画像

|

| ALIGN | 76.4 | – | – | 58.6 | 45.6 |

| T-Bletchley | 79.0 | 83.5 | 97.7 | 59.1 | 43.3 |

検索用にファインチューニングした場合、T-Bletchleyは、COCOテストセットにおいて、従来の最先端モデルであったALIGNを2ポイント以上上回る結果となりました。

|

モデル名

|

Flickr 30k Recall @1

|

COCO Recall @1

|

||

|

画像からテキスト |

テキストから画像 |

画像からテキスト |

テキストから画像 |

|

| OSCAR | – | – | 73.5 | 57.5 |

| ALIGN | 95.3 | 84.9 | 77.0 | 59.5 |

| T-Bletchley | 97.1 | 87.4 | 80.2 | 62.3 |

T-Bletchleyは、英語に特化したタスクにおいて、英語のみのモデルと比較して最先端の結果を出しています。同モデルの英語性能は、ユニバーサル言語サポートを行っても劣化していないのです!

以上のモデルの性能評価には、OpenAIが開発した画像言語表現モデルCLIPの性能評価に用いられたプロンプトアンサンブル法が採用された。具体的には、任意の画像を入力として与えると、出力として「A photo of a {画像分類名}」というテキストプロンプトが返される。

ユニバーサル

T-Bletchleyのユニバーサル検索能力はMulti30k、COCO-CN、COCO-JPデータセットで評価して、多言語モデルと比較しました。ファインチューニング前でも、同モデルは以前のモデルを大幅に凌駕しています。

|

実験設定

|

モデル名

|

Multi30k

|

COCO

|

|||

|

仏語

|

独語

|

チェコ語

|

中国語

|

日本語

|

||

| ゼロショット | M3P | 27.1 | 36.8 | 20.4 | 32.3 | 33.3 |

| T-Bletchley | 85.0 | 83.2 | 81.2 | 81.5 | 64.8 | |

T-Bletchleyがファインチューニングされると、このモデルは下の表に示すように、複数の言語で新しい最先端の結果を打ち立てます。

|

実験設定

|

モデル名

|

Multi30k

|

COCO

|

|||

|

仏語

|

独語

|

チェコ語

|

中国語

|

日本語

|

||

| ゼロショット | MULE | 62.3 | 64.1 | 57.7 | 75.6 | 75.9 |

| SMALR | 65.9 | 69.8 | 64.8 | 76.7 | 77.5 | |

| M3P | 73.9 | 82.7 | 72.2 | 86.2 | 87.9 | |

| T-Bletchley | 94.6 | 94.3 | 93.6 | 89.0 | 86.3 | |

今後の展開

T-Bletchleyの目標は、人間と同じようにテキストや画像をシームレスに理解するモデルを作ることです。同モデルの最初のバージョンは、このミッションにおける重要なブレークスルーとなります。同モデルによって、Bing、Microsoft Office、Azureにおける画像に関する質問と回答、画像検索、画像から画像への検索体験が向上することが期待されます。

責任あるAIに関する注記:他の利用可能なパブリックモデルと同様に、Microsoft Turingモデルは何十億ページもの公開テキストや画像を使って学習されているため、これらの公開文書から性別や人種などのバイアスを拾っている可能性があります。このようなバイアスによる悪影響を軽減することは業界全体で取り組むべき難しい問題であり、Microsoftは人間を第一に考えて社会に貢献する原則にもとづいて、AIの進歩と使用に取り組んでいます。私たちTuringチームはMicrosoftが定める全社的なAI原則を実践しており(※訳註9)、自社製品のモデルを使用する際にこうした暗黙のバイアスが表出しないように、広範な予防的措置を講じています。開発者の皆様にはこれらのモデルを本番環境で使用する前に適切なガードレールと緩和策を講じることで、私たちが講じた予防的措置と同様なことを行うのを強くおすすめします。

Microsoft AI原則

|

以上の倫理原則のさらなる詳細については、Microsoftの「責任あるAI」公式ページを参照。

原文

『Turing Bletchley: A Universal Image Language Representation model by Microsoft』

著者

Saurabh Tiwary(Microsoftヴァイス・プレジデント兼ディスティングイッシュト・エンジニア)

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん