学んだ8つの教訓は、それぞれに付けられた見出しを見ると大意がわかります。それらは、以下のようなものです。

- 製品を作るのであって、AIを作るのではない

- 考えるべきは問題であり、手段ではない

- データと製品のシナジーを探す

- データがはじめ、AIは後

- 効果的なコミュニケーションへの投資

- 早いが鈍くさいのは実は鈍くさくない

- 迷ったら、データを見せろ

- 信頼を築く

なお、以上の教訓が解説されるにあたっては、本翻訳記事の元記事とは別のMedium記事で論じられた「製品とデータの適合」「モデル価値グラフ」「データ債務」といった概念が援用されています。こうした概念については、注釈を付けて解説します。

Mediumには、本翻訳記事が論じているようなAIスタートアップの体制作りやAI製品の開発プロセスに関する記事が多数公開されています。こうした「AIマネジメント論」とでも総称できる記事として、以下のAINOW翻訳記事を挙げることができます。

[blogcard url=”https://ainow.ai/2019/02/12/162876/”] [blogcard url=”https://ainow.ai/2019/03/13/164123/”] [blogcard url=”https://ainow.ai/2019/03/14/164178/”]日本においてAIビジネスがさらに発展するためには、AI技術の普及だけではなく本翻訳記事が論じるようなAIマネジメント論の体系化も必要となるのではないでしょうか。

なお、以下の記事本文はDaniel Shenfeld氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。

製品、データ、そしてヒトビトについての8の教訓

わたしは12のスタートアップと働いたことがある。それらはフィンテックやヘルスケアからエデュテックやバイオテックと業界を縦断するように広がっており、資金調達ラウンドもプレシードから資金獲得済みまで及んでいる。わたしの役割もスタートアップに応じて変化し、最初の従業員として深く関わったこともあれば、データサイエンスと戦略的アドバイザーのトップを務めることもあった。そうしたスタートアップにおいて、わたしは興味深い機械学習とデータサイエンスに関する問題に取り組んだのだった。どのスタートアップも素晴らしい製品を作ろうとしていた。そのうちの多くがそれに成功した。

以上のような経験から私が学んだことを以下に記す。

目次 [非表示]

製品を作るのであって、AIを作るのではない

スタートアップと働き始めた時、生粋の数学者としてのわたしは、科学としての機械学習や独創的で新しいアルゴリズムと方法論を発見しようと挑戦することからもっともモチベーションを得たものだった。

しかし、もっとも精度の高い機械学習モデルであっても、そのモデル固有のクリエイティブな価値など持っていないことにすぐに気づいた。機械学習とAIの価値とは、それらの技術を使った製品がちからを発揮するコンテクストにおいて評価される(※註1)。機械学習によって駆動する製品がいかにして効率よく動作するかについて思案することが、そうした製品を作るに際して知るべきすべてのことなのだ。

『不思議の国のアリス』の原作者であるルイス・キャロルは、数学者でもあった。彼は多くの魅力的な製品を発明したが、それらのうちのいくつかは期待通りには動作しなかった。本記事のすべてのイラストはJohn Tennielが描いたものである。

考えるべきは問題であり、手段ではない

もし製品を作ることが目標であるならば、機械学習とAIはその目標に対する手段である。機械学習とAIが製品の対処する問題をいかに解決するかが問題なのであり、どんな解決策を使うかは二の次なのだ。ほとんどの場合、早く解けるが鈍くさい解決策がかなりうまく行くことが多い。単純な線形回帰で十分うまく行く時に、ディープニューラルネットを訓練してはいけない。

問題に焦点を合わせると、時には機械学習が問題を解決するのに適切なツールではないと分かるかも知れない。多くの問題は、たいていプロセスに関わるものだと分かるものだ。問題なのはプロセスだと分かった場合でも、データサイエンティストは元来厳格であろうとする傾向にあるので、彼らはデータ駆動的なアプローチを採用して多くの価値を生み出すことに貢献することもできる。しかし、厳格なデータサイエンティストがやりそうなAIをはじめとした素晴らしいアイデアを適用しても、うまく行っていないプロセスが改善することはない。AIのようなクールなアイデアを使う代わりに、まずはプロセス自体を改善しよう。

データと製品のシナジーを探す

機械学習の真価は既存の製品を使うことで引き出されることはまれであり、機械学習モデルが実行する予測によってはじめてその真価がわかるものである。しかしながら、強力なAI製品や機械学習は単なるアドオンではない。そうしたものは価値を生み出すエンジンであり、価値あるAI製品はこの価値を生み出すエンジンによって作られるものなのだ。つまり、AI製品とデータは相乗効果的に動作しなければならない。

以上のような相乗効果が得られれば、その結果としてわたしが「製品とデータの適合」(※註2)と呼ぶ強力かつ高尚なサイクルが生み出されるだろう(※註3)。このサイクルにおいては、製品はデータの潜在的価値を効率的に実現しながら、製品自体をさらに改善するために不可欠なデータを生成し続けるのだ。

機械学習を製品に導入するための最適化以前の戦略

とりわけAIというものは、データサイエンスや技術チームに留まり続けることはできないものである。製品開発から企業経営レベルにまで至る企業におけるほかの組織は、AI製品によって価値が生み出される過程を加速するためにAIに関する会話に加わる必要がある。こうした事情により、スタートアップであってもエンジニアがソフトウェア開発のうえで典型的に慣習としている知識を有するだけではなく全社的に有用な教育とメンバー全員の参画が必要となるのだ。

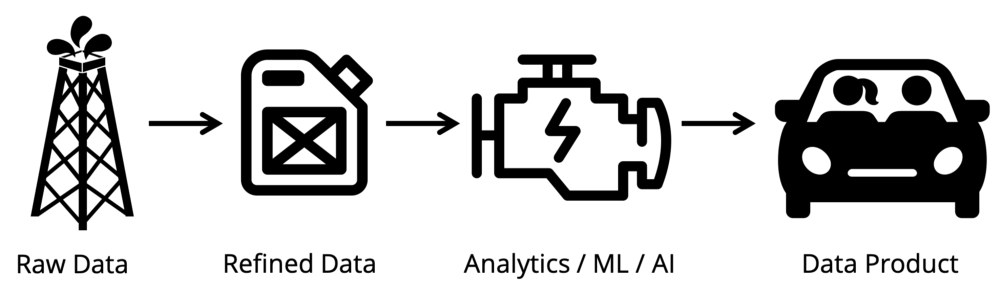

データが石油だとしたら、AI/機械学習はクルマのエンジンに該当する(下の画像参照)。そして、クルマのエンジンがクルマの走行というエンジンを含んだ製品が遂行するタスクに着目して評価されるように、AI/機械学習もそれが実装された製品が生み出す価値から評価されるべきなのだ。

データ製品の価値連鎖。アイコンはアイコンサービスNoun ProjectよりAle Estrada、 Ayub Irawan,、BomSymbols,、Hadi Davodpour作成のものを引用。

データ製品の価値連鎖。アイコンはアイコンサービスNoun ProjectよりAle Estrada、 Ayub Irawan,、BomSymbols,、Hadi Davodpour作成のものを引用。画像出典:Medium ’The Product/Data Fit Strategy’[/caption]

製品が生み出す価値にもとづいて評価する場合、学習データやAI/機械学習に過度に着目するのは間違いとなる。ちょうどクルマの性能を評価するのに、燃料となるガソリンやエンジンの品質だけに着目するのが間違いなのと同様である。それゆえ、期待する価値が得られるAI/機械学習製品を開発するためには、その価値に見合うように学習データとAI/機械学習に投資するのが望ましい。こうした学習データとAI/機械学習に対する投資の最適化が、製品/データ適合の戦略と呼ばれる。

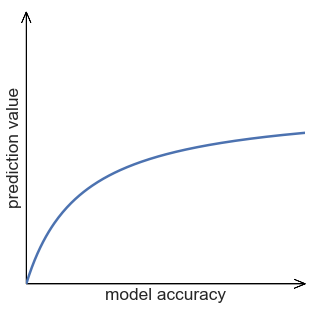

予測とそれがもたらす価値の関係を考察する事例として、配車サービスUberのアプリに使われているクルマの到着時刻を予測する機能「UberX」を採りあげてみよう。この機能の精度が高ければサービスに対する信頼度が上がるので、予測が生み出す価値も増える。しかし、予測精度が向上して100分の1秒単位で到着時刻がわかるようになっても、ユーザはそのような高い予測精度は求めていない。つまり、予測から得られる価値が頭打ちになるわけだ。こうした予測と価値の言わば収穫逓減の関係をグラフ化すると、以下のよう曲線が現れる(下のグラフ参照)。

画像出典:Medium ’How to Build an AI Moat’[/caption]

画像出典:Medium ’How to Build an AI Moat’[/caption]

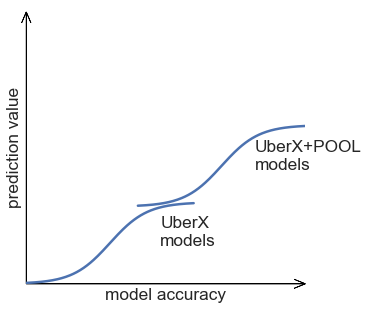

以上の収穫逓減的なグラフにおいて、再び価値を上昇させる方法がある。その方法とは、同一のデータを学習データとして活用して類似の価値を生み出すというものである。Uberの事例で言えば、同一の配車予約データを用いてUberPool(乗合サービス)を展開するのだ。新たなサービスを展開することによって、機械学習モデルの予測を向上させる余地とその予測がもたらす潜在的価値が誕生する(下のグラフ参照)。このような学習データを流用して新たな派生サービスを開発することが、予測とデータのあいだに築かれる「強力かつ高尚なサイクル」なのだ。

画像出典:Medium ’How to Build an AI Moat’[/caption]

画像出典:Medium ’How to Build an AI Moat’[/caption]

データがはじめ、AIは後

機械学習とAIには大量のデータが必要であり、さらに重要なのはそうしたデータが高品質である必要もある。もし白紙の状態からAI製品を作るのであれば、開発初日からデータ収集について考えるべきだ(※註4)。もし既存の製品にAIテクノロジーを導入するのであれば、AI部分を開発する前にデータエンジニアリングと製品アーキテクチャの再設計に多額の投資をする準備をしよう。

データに対して優先的に資金と時間を費やすことは、AI製品の価値を実現する前に開発業務を前倒して実行することを意味しているのではない。そうではなくてより良いデータの運用はより良い分析をもたらし、こうしたデータ重視の姿勢はAIの学習とその改善を組織化するうえでも重要なのだ。データに投資することはAI製品の価値を首尾よく証明し、データへの投資を組織的に回収することにもつながる。そしてデータ重視の姿勢が堅実である時に、はじめて機械学習について本腰を入れて考える準備ができるのだ。

データサイエンス・レディな企業になるためには、「データ債務」が蓄積されない体制作りが重要となる。データ債務とは企業やエンジニアがデータを収集しなかったり、保有するデータのメンテナンスを怠ることで生じる損失を意味する。こうしたデータ債務が蓄積された状態では、かりにデータサイエンティストを雇用しても、データの収集と整理から着手しなければならないため、データ分析が後回しにされてしまう。それゆえ、データ債務が蓄積しないように常日頃からデータの収集と整理を怠らないことが、データサイエンティストが本領を発揮できる企業になるための施策となるのだ。

効果的なコミュニケーションへの投資

素晴らしいAI製品を作るには素晴らしい製品マネージャーが必要であり、また経営陣からのサポートも必要である。多くのマネージャーや経営陣がAIとディープラーニングのちからに目がくらんでいる一方で、そうした技術を真に理解している非技術職はほんの少ししかいない。機械学習とAIについて効果的なディスカッションをするためには、統計学に関するかなりの理解が必要であり、そうした必要知識がないとしばしばAIに対する非現実的な期待を生み出すコミュニケーションギャップができてしまう(※註5)。

機械学習とAIについてのディスカッションは、明らかにビジネス的指標に全くもとづいていないこともある。

素晴らしいAI製品を作るために必要なカギのひとつは、AI製品についてビジネス的指標に照らして話し続け、そうしたビジネス的指標をAIのモデリングにおける指標にいかにして翻訳するか、ということにある。この成功へのカギを手に入れるには製品マネージャーに大きな責任が課せられると同時に、データサイエンティストにも責任がある。そして、データサイエンティストは自分の専門とする分野での知識を築き上げるとともに、そうした専門知識が真に効果的に働くためにもビジネス上の配慮について深く理解しなければならない。

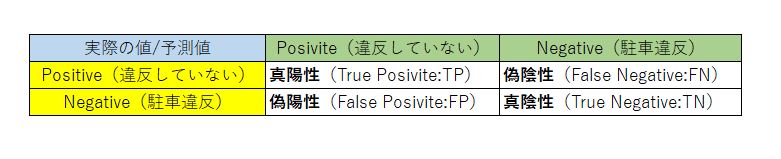

アメリカ・ニューヨーク市でクルマを路上駐車する場合、駐車券販売機から駐車券を購入して、その券をボンネット等において警察官に合法な駐車であるとわかるようにする。もし駐車違反チケットをきられた場合は、違反の無効を訴えることができる。訴えの際には違反チケットが必要となる。この違反チケットが不正なものでないかどうかを判定する機械学習製品を開発することを想定してみよう。この製品の仕様を決定するにあたっては、以下の質の異なるふたつの誤検知を考慮しなければならない。

(誤検知1):AI製品が誤って違反チケットの無効を承認した場合、言い換えると駐車違反しているのにその違反を見逃した場合、ニューヨーク市は罰金を徴収する機会を失うという不利益を被る。

(誤検知2):AI製品が無効な違反チケットを承認した場合、言い換えると駐車違反していないのに誤って違反だと誤認した場合、本来は必要のない駐車違反に対する対応が発生する。この対応にあたる担当者の人件費をニューヨーク市は支払わなければならない。

以上のふたつの誤検知は、AIの品質評価技法である混合行列を使って表現することができる(下の表を参照)。

ニューヨーク市における駐車違反チケットの誤検知を混合行列に翻訳した表[/caption]

ニューヨーク市における駐車違反チケットの誤検知を混合行列に翻訳した表[/caption]

- 誤検知1は偽陽性率と呼ばれ、FP/(FP+TN)という計算で求められる。

- 誤検知2は偽陰性率と呼ばれ、FN/(TP+FN)という計算で求められる。

以上のふたつの誤検知のうち、どちらの誤検知を減らすようにするかは、AI製品の開発を受注した企業の経営者が決めるべきである。例えば、罰金が高額であれば徴収機会を失った時の不利益が大きいので、偽陽性率を下げることに開発リソースを集中させる、と意思決定できる。こうした意思決定プロセスにおいては、経営者は混合行列について知っている必要があり、他方でデータサイエンティストはふたつの誤検知を混合行列に翻訳しなければならないことがわかるだろう。

早いが鈍くさいのは実は鈍くさくない

前述した通り、早く解けるが鈍くさい解決策がかなりうまく行くものだ。こうした事実が成り立つのは、今日の早くて鈍くさい解決策は昨日は遅くて精確であったことが部分的な理由となっている。Word2vecのようなツールは今や線形回帰のように簡単に使えるようになり、新しく強力なツールも継続的に導入されている。新旧の分析技術をレンガを積み上げ架橋するように結び付けて堅固に理解することは、どんなデータサイエンティストにも必要不可欠である。

オープンソースのツールの爆発的普及がもたらすひとつの帰結は、ほとんどの場合において独自の機械学習プラットフォームを構築するのは良いアイデアではない(※註6)、ということだ。もちろん、よく知られたレンガを積み上げて固有のアルゴリズムを作り、それらを取り組んでいる問題や分野に対して活用すべきである。しかし、ディープラーニングに関する研究はGoogleの連中に任せよう。そして、ビジネス的問題だけに焦点を合わせるべきと覚えておこう。

AI製品の開発においては、回帰分析の計算式のようなAI技術に関する専門知識と回帰分析をどのようなAI製品の開発に適用するかを判断するAI製品開発に関わるノウハウという2種類の知識の存在が指摘できる。そのうえでAIビジネスが失敗する原因として、後者の知識を有しているエンジニアが必要なのに、前者のそれに詳しいエンジニアを雇ってしまうことが挙げられる。

以上の議論を本記事のコンテクストに戻してとらえると、AIプラットフォームの機能を拡張するようなタスクはAI技術に関する専門知識が不可欠だが、AIスタートアップはこうしたタスクには手を出すべきではない、ということになろう。

なお、『なぜ機械学習ビジネスは失敗するのか』の要約は、AINOW海外トレンド記事『【要約つき】AINOWがおすすめの海外記事を紹介!(2018年10月)』において紹介されている。

迷ったら、データを見せろ

データをユーザに見せることは非常に強力であるが、その見せる方法のすべてが等しく魅力的というわけではない。

製品開発における早い段階でもっとも重要な活動は、市場からのフィードバックを得ることである。しかし、機械学習には多くのデータが必要であり、そのデータを得るには多くの時間を要する。こうした問題は次にように表現できる。どのようにして市場がくだすデータ製品についての洞察を多くのデータなしに得ることができるのか。

以上の問題に対する解決策は、しばしば製品のユーザにデータを見せるという単純なものとなる。ヒトというのは一度に少量のデータしか扱えないので、見せるデータを大量に持っていなくても問題ないのだ。ユーザは見せられたデータとどのような関係を持つか。彼らはデータのどんな箇所を見過ごして、反対にどんなところを深く見たがっているか。事前にアクセス不可能な情報をさらすことは非常に強力な解決となることがあり、さらには所有しているデータの潜在的なビジネス的価値に導いてくれる強力なガイダンスを与えてくれるのだ。

信頼を築く

信頼は、ほとんどのテクノロジーに関する成功の主要な要因である。究極的にはすべてのテクノロジーはヒトに使われ、ヒトに信頼されなければならない。このことを機械学習のコンテクストで述べると、このテクノロジーによって自分たちの仕事が自動化されて仕事を奪われるのではないか、という懸念しているヒトビトがいる。他方で、重要な意思決定を促す機械学習によって提供される情報を信頼しているヒトビトもいる。

AI製品というものは、以上のような懸念をない交ぜに含んでいるものなのだ。そうした懸念を引き起こす具体例として、AI製品をヒトビトの意思決定に助力するものではなくヒトビトに代わって意思決定を行うものとして作ろうとする、ということがある。こうした事例は早々に信頼の侵食を招くことになるだろう。

信頼は容易く失われ、取り戻すのは難しい。ヒトビトが信頼する製品を作ろう。

チェシャ猫のような論証はユーザの信頼を得る方法としては疑わしい。

Stephanie Wissigに感謝の意を表します。

原文

『What I’ve Learned Working with 12 Machine Learning Startups』

著者

Daniel Shenfeld

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん