「医師」のような特定の職業名が男性に関連付けられて翻訳されるような現象は、「AIのバイアス」として知られています。こうしたバイアスを緩和・除去するうえで重要となるのが、機械学習モデルがバイアスを伴った判断を下した理由を理解可能なように説明する「解釈可能性」です。

Kim氏によると、解釈可能性を実現する方法には大別して2種類あります。ひとつめは、機械学習モデルにあらかじめ説明の枠組みを組み込んで、判断を出力する度にその理由も提供するようにする方法です。もうひとつが、事前に説明の枠組みを組み込まずに機械学習モデルの判断過程を後から考察する方法です。後者の方法は、さらに判断の根拠としてピクセルのような人間にはわかりにくい特徴を提示する低次元的な説明と、人間でも理解可能な概念として根拠を提示する高次元なそれがあります。現在Kim氏が取り組んでいるのは、高次元な説明による解釈可能性の実現です(この方法の詳細は記事本文を参照)。

以上の解釈可能性の分類のほかにも、機械学習モデルが人間を凌駕しているところ、機械学習モデルの判断を解釈する際の注意点、そして機械学習モデルに関する難問といったトピックにkim氏は答えています。

最後に仕事のやりがいについて質問されたところ、Kim氏は解釈可能性の研究を通して機械学習の普及に貢献できること、と答えました。こうした同氏の回答からもわかるように、解釈可能性はAIの社会実装において不可欠なAI倫理を司る要となる概念です。日本のAI業界においても、解釈可能性に関して早急な整備が求められるでしょう。

なお、本記事の翻訳に関してはGoogleジャパン広報部に連絡済みです。また、以下の記事内容は特定の国や地域を代表する見解ではなく、AINOW編集部ならびに翻訳者の主義主張を表明したものでもありません。

目次 [非表示]

機械学習の解釈可能性について専門家に聞いてみた

US版Googleブログ編集部による注記:あなたは、今までに技術的なことが話題でなっているところで、場違いな気まずい思いをしたことはありませんか?試しに技術初心者になって、グーグルのようなところで働いているエンジニアに話を聞いてみてはいかがでしょうか。「Ask a Techspert」は、グーグルの専門家に複雑な技術に関するキーワードを説明してもらうシリーズです。このシリーズの記事は包括的なものではありませんが、ディナーパーティーであなたを賢く見せるには十分な内容です。

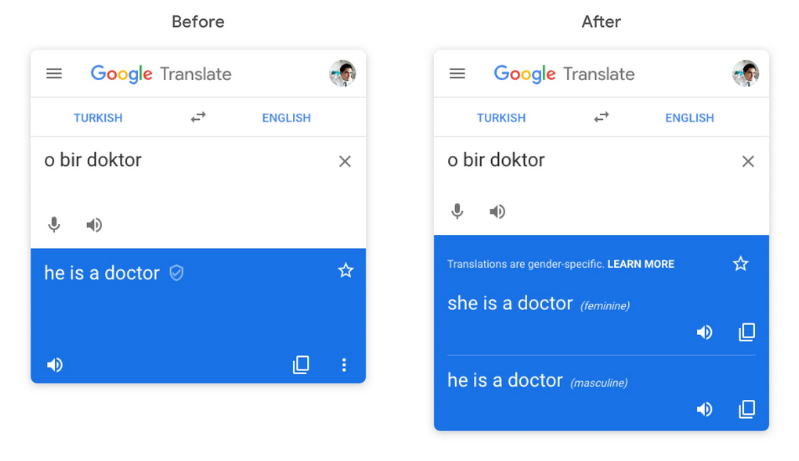

数年前、Google翻訳を使ってフィンランド語を英語に翻訳したところ、予想外の結果が出ることを知りました。フィンランド語では”hän”はジェンダーニュートラルな単語ですが、英語では”hän on lentäjä”という文章が”he is a pilot”(「彼はパイロットです」)になっていました。なぜ翻訳ではデフォルトで「彼」となったのでしょうか?

調べていくうちに、人間と同じように、機械も社会的バイアスの影響を受けていることに気づきました。翻訳に関する機械学習モデルは、ウェブ上の何億もの翻訳済みの事例から作った入力で構成された学習データに依存していました。いくつかの職業は「彼女」よりも「彼」に関連付けられ、その逆(つまり「彼」より「彼女」に関連付けられる職業)もありました(※訳註1)。

現在、Googleはいくつかの言語でジェンダーニュートラルな単語を適応させる際に、女性的な翻訳と男性的な翻訳の両方のオプションを提供しており、こうしたジェンダーニュートラルな翻訳をより広く展開するための努力が続けられています(※訳註2)。そうは言っても、機械学習が私たちの周りにある偏見をどのように反映させるかを示す良い例であることに変わりはありません。ありがたいことに、Googleには、すべての人にとってテクノロジーを包括的なものにするための人間中心のソリューションを見つけることに専念しているチームがあります。そこで、People + AI Research (PAIR)チームに所属するGoogleの研究員であるBeen Kim氏に話を聞きました。彼女はそのチームの中心で、人工知能とは機械ではなく人間を中心に据えたものであることを確認したうえで、機械知能と人間の相互作用の全領域が理解される手助けとなるように専心しています。以下では機械学習をどのようにして簡単に解釈できて理解もできるものにするのか、そしてなぜ機械学習がどのように機能するのかについての基本的な考え方を誰もが持つことが重要なのか、ということについて伺いました。

Google People + AI Research (PAIR) チームのBeen Kim氏

US版Google公式ブログ記事『Google翻訳におけるジェンダーバイアスの削減』

Google AIブログ記事『Google翻訳におけるジェンダー固有な翻訳の提供』

Google AIブログ記事『Google翻訳におけるジェンダーバイアスを削減するためのスケーラブルなアプローチ』

また、ジェンダーニュートラルな表現をジェンダーごとに訳し分ける事例は、以下の画像を参照。以下の画像ではジェンダーニュートラルなトルコ語で「彼/彼女は医師である」という表現から、「彼は医師である」と「彼女は医師である」というふたつの翻訳が生成されている。

US版Googleブログ記事『Reducing gender bias in Google Translate』より画像を引用

なぜ理解可能な機械学習という分野が重要なのですか?

機械学習は非常に強力なツールであり、だからこそ、責任を持って使用するようにしたいものなのです。電動ノコギリを例に考えてみましょう。これは超強力なツールですが、指を切らないためには使い方を学ぶ必要があります。その使い方を一度覚えてしまえば、とても便利で効率的なので、もう手のこぎりには戻りたくなくなるでしょう。機械学習についても同じことが言えます。私たちは、機械学習を正しく、公平に、そして安全に理解し、利用するためのお手伝いをしたいと考えています。

機械学習は私たちの日常生活の中で利用されているので、それがどのような影響を与えるのかを誰もが理解することも重要です。コーヒーショップのオーナーが機械学習を使って季節のトレンドに基づいて豆の購入を最適化している場合でも、あるいは医師がこの技術を使って病気の診断をしている場合でも、機械学習モデルがなぜそのような結果をもたらしたのかを理解することが重要であることはよくあります。また、開発者や意思決定者が機械学習モデルを人々に説明したりプレゼンしたりするためにも、機械学習モデルを説明できることが重要なのです。以上が「解釈可能性」と呼ばれるものです。

機械学習モデルをわかりやすく解釈しやすくするには、どのような方法があるのですか?

機械学習モデルを理解しやすくするためには,さまざまな方法があります。ひとつめの方法は,人間がどのように考えているかを最初からモデルに反映させ,予測と一緒に説明を提供するようにモデルを「訓練」することです。この方法では、機械学習モデルが何らかの出力をユーザに与えた時、その出力を得た方法についての説明も与えます。

もうひとつの方法は、データによる訓練が終わった後にモデルを説明しようとすることです。この説明は明確な「説明する方法」が含まれていなくても、予測のために最適化された入力を使用して独自の観点から出力を提供するようにモデルが構築されている場合に使えます。この説明では、機械学習モデルに何かを投入すると何が出てくるかを見ることができることを意味し、モデルが一般的にどのように意思決定を行うかについてある程度の洞察が得られます。しかしながら、特定の入力が特定の状況でモデルによってどのように解釈されるかを正確に知ることがいつもできるわけではない、ということも意味しています。

訓練を受けた後にモデルを説明しようとする方法のひとつとして、低レベルの特徴あるいは高レベルの概念を使用することがあります。これが何を意味するのか、例を挙げてみましょう。画像を分類するシステムを想像してみてください:画像を与えて、機械学習モデルが「これは猫です」と言うとします。低レベルの特徴を使った説明では、機械にどのピクセルが(猫の画像であるという)予測に重要であるかを尋ねると、機械はその特徴がある1ピクセルかあるいはほかの1ピクセルにあるのを教えてくれます。そして、答えとして与えられたピクセルが猫の顔ひげを示していると見えるかも知れません。しかし、そんなピクセルが人間の目には意味のないピクセルの散乱であるも知れないし、あるいは機械学習モデルが間違った解釈をしていることがわかるかもしれません。高レベルの概念は、どちらかというと人間同士のコミュニケーションの仕方に近いものがあります。ピクセルについて尋ねる代わりに、私は「予測にはひげが重要だったのか、それとも足が重要だったのか」と尋ねることができます。すると機械学習モデルは、猫という結論を導いた画像の部分を示すことができます。こうした結果に基づいて、モデルをよりよく理解することができるのです。(機械学習モデルの解釈可能性についてスタンフォード大学の研究者と一緒に論文を発表しました。興味のある方のために、こちらでさらに詳しく説明しています)。(※訳註3)

同論文で論じられているアルゴリズム「ACE」(”Automatic Concept-based Explanations“の頭文字をとった略称)を画像識別に使うと、識別の決め手となった箇所が重要度に応じて複数提示される。ACEを使った画像識別の事例が、以下の画像。例えば中央にある「警察のバン」の画像では、4ヶ所提示された概念のうち、もっとも識別に重要なのがいちばん上に示された概念の「タイヤ」である。つぎに重要なのが、タイヤの下に提示された概念「警察のロゴ」である。ACEによる警察のバンの識別では、タイヤと警察のロゴから「警察のバン」という判断を下したことがわかる。

人間が理解できないことを機械は理解できるのでしょうか?

機械は人間が理解できないことを理解できます!この領域こそ私自身が非常に興味を持っている分野です。私は現在、いかにテクノロジーが人間が新しいことを学ぶのに役立つかを紹介する方法に取り組んでいます。機械学習は、ある点においては私たち人間より優れているのです。例えば、機械学習技術は人間よりもはるかに大きなスケールでデータを分析したり解釈したりすることができます。この技術を活用することで、人間の科学者が今まで気づかなかった知識に光を当てることができると信じています。

機械学習モデルにもとづいて結論を出すときに気をつけるべきことは何ですか?

第一に、人間のバイアスが影響しないように注意しなければなりません。人間は自分ではどうしようもないバイアスを持っていて、そんなことに気づかないことが多いのです。それゆえ、機械学習モデルの判断に関する解釈が人間だけに頼っている場合、こうした状況はしばしばあるのですが、問題が生じます。というのも、人間は自分が読みたいものだけを読んでいるからです。人間だけに頼る場合の欠陥を指摘したからといって、人間を判断のループから外すべきだということを意味していません。人間は機械とコミュニケーションを取りますが、その逆もあります。機械は、曖昧で完全に解釈の余地があるようなものではなく、定量的なデータを使った明確な声明の形で出力を伝える必要があります。機械の解釈が曖昧な場合、機械はあまり良い仕事をしておらず、人間は機械に良いフィードバックを戻すことができません。反対に、機械学習の出力に人間だけが提供できる追加的なコンテクストが欠けている場合、あるいは人間による注意が出力を改善できる場合には、そうしたコンテクストや注意が機械学習モデルが出力する結果に関する判断を豊かなものとするのです。

機械学習モデルに関する主な課題を教えてください。

この分野のコンピュータ科学者にとっての課題のひとつは、数学的でない対象を扱うことです。そうしたものは最適化しようとしても、最適なものにはならないのです。人間にとって何が良いかを数学で定義するのは、いつもできるわけではありません。そのためには、手法を厳密にテストして評価し、その結果を議論するために大勢の人が集まるテーブルを用意する必要があります。もうひとつは、複雑さに関係しています。人間は非常に複雑なので、これを研究するために心理学という分野があります。私の仕事では、計算上の課題だけでなく、複雑な人間についても考慮しなければなりません。「公正さを定義するものは何か」のような価値観に基づく質問は、さらに難しいものです。こうした難問に取り組むには学際的な協力が必要であり、個々の問題について議論するために多様な人々のグループが必要となります。

あなたの仕事でいちばん興奮するものは何ですか?

解釈可能性の研究や手法は大きなインパクトを与えていると思います。機械学習技術は、周知のように社会を変革する強力なツールであり、それを安全に利用するための手助けをすることは、非常にやりがいのあることです。

個人的な話になりますが、私は韓国出身で、あまり多くの機会がないと感じる環境で育ちました。そんな私が、MITの奨学金を得てアメリカに来れたのは信じられないほどラッキーでした。今まで科学や機械学習の教育を受ける機会がなかった人たちのことを考えると、この機械学習技術は安全に使えば日常生活に役立つことを知っているからこそ、この技術を民主化するための活動をしたいという気持ちが強くなりました。機械学習を民主化するための方法は色々あると思いますが、解釈可能性は私が貢献できることのひとつだと思います。

原文

『Ask a Techspert: How do machine learning models explain themselves?』

著者

Andrea Lewis Åkerman

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん