近年、AI研究の発展によって私たちの生活や働き方、社会のあり方までも大きく変わってきています。そんな中、AIによる自動化や予測によって便利で豊かな世の中になっている反面、AIによるフェイクニュースや監視社会、差別などの社会的問題が指摘されるようになっています。

こうした現状を背景に日本をはじめ各国でAIに関する倫理的、 法的、 社会的な側面からの議論が活発になり、 AIの開発、 利用に関する指針づくりも相次いでいます。企業にもAIのガバナンスが求められており、独自にAI利用のポリシーやAI指針を策定する企業もでてきています。

今回は、2021年5月に『絵と図でわかる AIと社会 ――未来をひらく技術とのかかわり方』(技術評論社)を上梓した、東京大学未来ビジョン研究センター准教授・日本ディープラーニング協会理事の江間 有沙さんを取材しました。

江間さんはこれまでAIにおける社会問題に関して社会科学的な視点から研究しており、AIガバナンスやガイドラインについて世界中で議論を交わし、発信している人物です。

5月に上梓した書籍の中では、AIの技術の基本から社会問題に対する影響や、それらが私たちの生活にどう関わるのかをイラストを交えて解説しています。

インタビューでは、今回の出版に込めた思いやAIガバナンスの現状、AIを取り巻く社会的な課題、海外と日本の議論の違いなどをお話しいただきました。

東京大学未来ビジョン研究センター准教授。2017年1月より国立研究開発法人理化学研究所革新知能統合研究センター客員研究員。専門は科学技術社会論(STS)。人工知能学会倫理委員会委員。日本ディープラーニング協会理事。2012年東京大学大学院総合文化研究科博士課程修了。博士(学術)。

目次 [非表示]

課題は「データの整備」と「AI技術自体への過剰評価・過小評価」

江間さんは科学技術社会論を専門にしながら国内でさまざまな議論や研究を行い、海外でも国際的な会議で委員を務めるなど、AIガバナンスに関して幅広い知見を持って活動されています。

「海外と日本の議論の橋渡しをできるような活動をしていきたい」と語る江間さんに、現代社会におけるAI活用の実態を聞きました。

ーー江間さんご自身がこのAIの分野に携わるようになったきっかけは何だったのでしょうか。

江間さん:学部の頃から科学技術社会論というサイエンステクノロジースタディーズもしくはサイエンステクノロジーアンドソサイエティ(STS)と呼ばれている分野を専攻し、特に情報と社会の課題に焦点を当てて研究をしていました。STSは科学技術と社会に関するアカデミックな研究をするだけではなく、科学コミュニケーションや科学技術政策のような社会的な活動もする領域です。

博士号取得後、2012年4月に京都大学白眉センターに行きました。2014年1月には人工知能学会で表紙問題(※)が起きまして、大学の人工知能学会の関係者の方と問題に関して立ち話をしたりするなかで、こうしたことが起きる原因は情報技術だけに閉じた問題ではなく、哲学や倫理学、社会科学などの研究者との接点が薄くなっていることが問題なのではないかという話になり、何人かでAIR(Acceptable Intelligence with Responsibility)という研究グループを作って分野を超えて議論を始めたというのが経緯です。

人工知能学会(JSAI)が刊行している学会誌『人工知能』において、2014年1月号の表紙イラストが女性差別ではないのか、とJSAIが批判を受けた。

ーー倫理や社会の問題を考える上で、現在のAI活用の状況をどのように見ていらっしゃいますか。

江間さん:日本では最近、DX(デジタルトランスフォーメーション)が叫ばれるようになりAI活用の関心は高まっていると思いますが、AI以前にデータの問題が解決してない印象です。

データやアルゴリズムの偏りの問題や、そもそもデータが揃っていない、情報を共有する制度が整っていない、共有する際のプライバシーとセキュリティ保護の仕組みが整備されていないなど、問題が多くあるように感じています。

また、AIにどのような役割を期待しているのか、持たせるのかというイメージがうまく伝わっておらず、過剰評価や過小評価されているところがあると思っています。

具体的には、AIはとりあえず導入すれば万能だと思っている人がいたりしますが、そうはいっても適切なデータがなかったら何もできないこともあります。その逆に、人間のように何でもできると思い過剰に怖がって活用できていない面もいまだに問題としてあるのかなと思っています。

さらに技術だけではなく、人とコミュニケーションをとることができるインターフェイスを適切にデザインしなければ、どんなに高精度な技術を作ったとしても受け入れられない・使えないこともあります。その意味では、AIという技術自体に「何ができて何ができないのか」という区分けや意識、考え方自体がまだばらけている状況です。なので社会実装が進まないもったいない領域もけっこうあるのではないかなと思います。

自分が住みたい社会の”ビジョン”を考える|多様性が担保された話し合いを

社会課題の解決にも応用されるAIは、ESGやSDGsの実現に貢献することが期待されています。環境問題や高齢社会、そして未来世代のことを考えたAI技術の活用が求められています。

ーーESGやSDGsとAIガバナンスの関係性について、どう結びつけて考えていらっしゃいますか。

江間さん:今回出版した本のメッセージの1つでもあるんですが、AIを考えるということは「私たちがどういう社会に住みたいのか」を改めて考えることだと思っていて、ビジョンが重要になってきます。本の最初の方のページでは、国や地域によってそれぞれが重視する自由や権利、安定性などの価値を地図上で紹介しています。

AIを議論するということは社会や社会が求める価値について議論することでもあるので、SDGs等が掲げる目標とも親和性が高いです。Responsible AI(責任あるAI)やSustainable AI(持続可能なAI)という考え方も提唱されています。そうしたビジョンを選び掲げること、あるいは目指すことは大事ですが、どうやって理念を実践に落とし込んでいくかが課題です。責任や持続可能性あるいは公平性といった価値は、誰がどの立場、文脈で議論するかによっても、答えは一通りではないからです。もう一点付け加えると、SDGsが掲げる項目自体がトレードオフを孕むビジョンでもあります。

また時代によっても、重視される価値は変化していきます。人種やジェンダーの問題は先人たちが声を上げ続けて来て、社会問題化されたものでもあります。どうやってどの時代に合った最適解を導けるか、あるいは自分自身のビジョンを説明できたり納得できたりするのかが重要です。

さらに、自分が寄って立つそのビジョン自体も、自分が置かれている状況や文脈に依存した偏ったものではないかなど疑ってかかることができるか、ビジョンを作ってるのが誰かという眼差しを持つことも非常に大事だと思います。

ーー先進国を中心に世界中でAI活用の原則が作られてきています。ビジョンを作る上でどのような話し合いがされているのでしょうか。また、話し合いが進んでいく中で問題点はありますか。

江間さん:日本の内閣府が公開した「人間中心のAI社会原則」は、各国・地域や国際機関の原則とも共有できる価値が提唱されています。ですが、欧米など他の国や地域の原則に比べて、原則を作った人たちのジェンダー的な観点や多様性が欠けている問題があります。原則の基本理念として「多様性や包摂性」を掲げているにもかかわらず、です。つまり、理念が実践と合っていないのです。これは、環境問題を謳っているイベントで紙の資料やペットボトルがたくさん並び、懇親会会場でフードロスが起きているとか、インクルーシブな社会について議論する会場の建物が車椅子で入れなかったりするのと同じ構図です。そうした言動不一致や“矛盾”に言われるまで気づかないという無意識のバイアスがあります。

何を議論するかも大事ですが、誰がどの立場で言っているのかというビジョンを疑うことが必要です。例えば、先進国寄りのビジョンになっていないかどうか。AIの倫理も先進国のみで作られるのではなくアフリカ、中東、南アメリカなどいわゆるグローバルサウスの人たちの議論も含まれているかを考慮する必要があります。

現在、国際的な会議で各国地域のAIの取り組みを評価する時に、「多様性を謳っている」など書かれている中身を評価するだけではなく、議論し原則を作る人たち自体の多様性が担保されているかどうかも確認をする、ということが行われています。結果ではなくプロセスにも重点が置かれています。

AIガバナンス エコシステム|サプライチェーンが連携をとれるプラットフォームが必要になる

ーー日本は守りに徹していて攻めのガバナンスができていないと言われることもありますが、江間さんは日本企業のAIガバナンスに関してどう考えていらっしゃいますか。

江間さん:ガバナンスとは企業などの一組織の枠組み、つまりコーポレートガバナンスを意味するのが一般的だと思います。

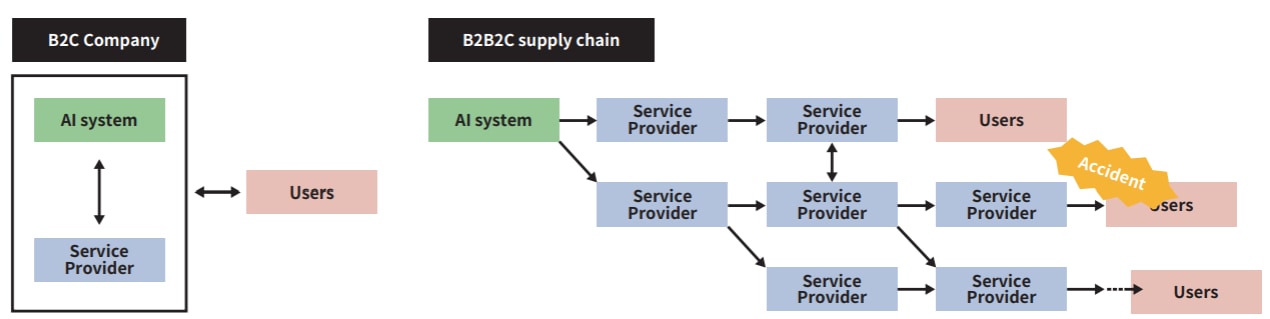

現在、AIのガバナンスや倫理問題に関して積極的に取り組んでいるGAFAをはじめとしたビッグカンパニーは、プラットフォーマーでありますが、同時に巨大なB2C(Business-to-Consumer)企業だともいえます。なので、消費者(コンシューマー)とのやり取りがある程度迅速にできて問題や変更が発生したときに、比較的すぐに対応できます。消費者から見ても、サービスやシステムを提供している企業が見えやすく、責任の所在が明確になりやすいです。

一方で、日本の産業構造を考えるとB2B(Business-to-Business)の企業が多いです(下記画像参照)。中小企業やスタートアップだけではなく、昨今では大企業であっても主要な利益はB2CではなくB2Bから得ているという企業も多いです。そのため、AIのシステムを作っている会社やサービス提供会社、ベンダー、そしてエンドユーザなど非常に長いサプライチェーンになります。例えばユーザーがサービス提供企業に、何か問題が起きた時にコンタクトをとっても、「このシステムの仕組みよくわからないので大元に戻します」という話になり責任の所在が非常に不明確になってしまうことがあります。また、AI自体がブラックボックスであり、なぜその結果が出るのかの判断理由が分かりにくく、品質の保証が非常に難しいという問題もあります。

https://www.jdla.org/document/ai-governance-eco-system/より引用

この2つの問題が重なって、もはや1社だけではAIシステムやサービスに何かあった時の問題の特定や責任が取れない状況になっている場合があり、これは日本企業が特に考えなければならない問題です。

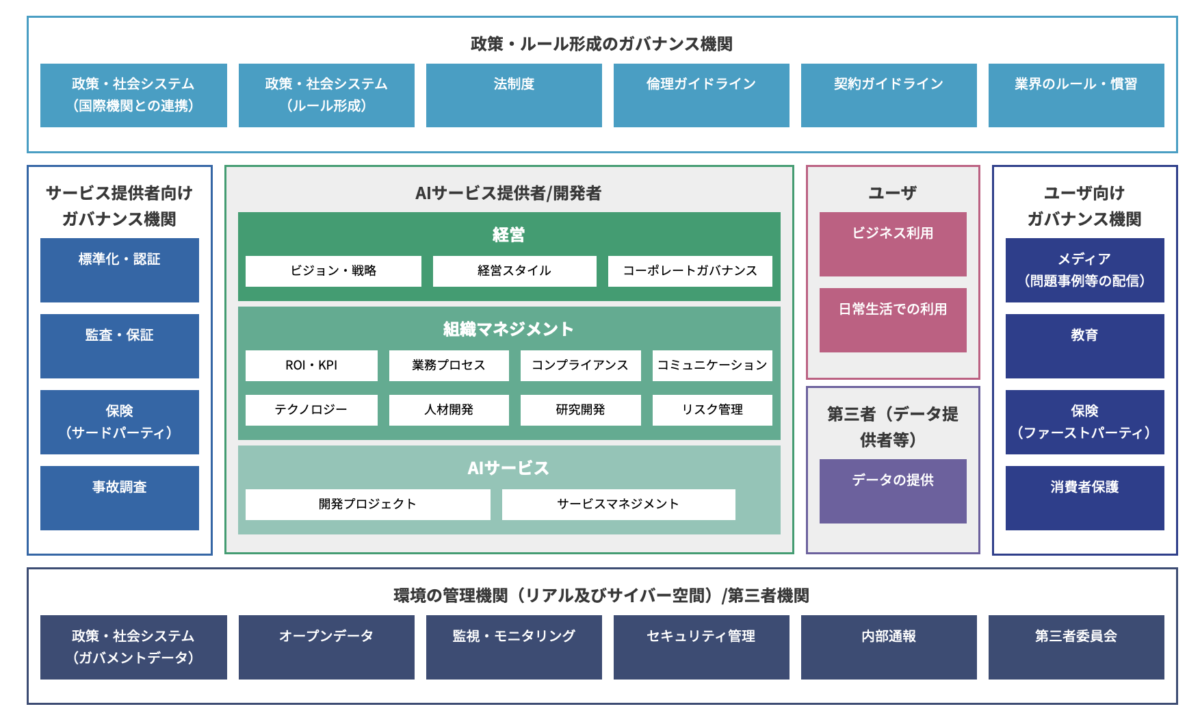

こちらの図は(下記画像)、日本ディープラーニング協会の「AIガバナンスとその評価」研究会で副座長を務めていただいたデロイトの松本さんが作成した「AIガバナンスエコシステム」の俯瞰図です。「AIガバナンスエコシステム」というのは、ガバナンスを形成する外部機関、モニタリング機関、保険、監査など、さまざまなところと連携して、AIのガバナンスをエコシステムとして考えていかなければならないという提案です。研究会のウェブサイトでは、図の各項目に関する話題提供をしていただき、その内容も日本語と英語両方でまとめているので、ご覧いただければと思います。

AIガバナンスの標準化の議論も始まってます。ITガバナンスというのはコーポレートガバナンスが基本にありますが、将来的には組織をまたいだ上でのガバナンスを考えることが大事になってくるのではないかという議論もされています。これは国際的な流れとしてもおもしろいと感じています。

https://www.jdla.org/document/ai-governance-eco-system/より引用。 各研究会の開催記録やレポートはこちら

ーー江間さんのこれまでの取り組みも踏まえてリスクチェーンモデルに関して簡単にご説明お願いします。

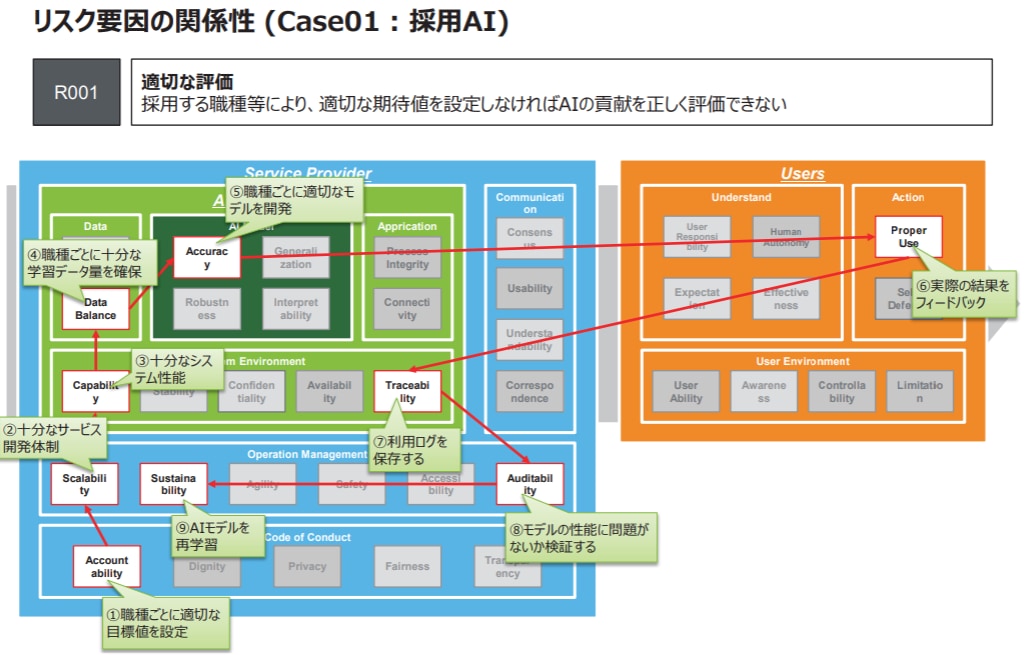

江間さん:リスクチェーンモデルは2020年6月に東京大学未来ビジョン研究センターから政策提言を出し、その後、より発展させるため2021年7月から「AIサービスとリスクコーディネーション研究会」として展開しています。現在ウェブサイトには、使い方のガイドといくつかの事例を掲載しています。この研究会は東京大学とデロイトトーマツリスクサービス株式会社の共同研究プロジェクトで運営していますが、他にも様々企業・組織の方とも連携をしています。

もともとの問題意識として、AIに関する原則にある透明性、公平性、信頼などの項目をどうやって実践に落とし込んでいくのかがあります。議論の結果だけではなくプロセスを他の人と一緒に共有して可視化し、蓄積していくことが透明性を担保する1つだと思います。最終的には様々な事例をデータベース化して誰もが参照できるようにしていこうという目的があります。議論ができるようなフレームワークを作ることが異分野を渡り歩いてきた私のやりたいこと、ミッションのひとつかなと思っています。

例えば、ベンダーとAIシステムをつくっている側が、一緒に議論や会話するとなったとき、変更点だけではなく、どんなところを注視してこのシステムをつくっているのかの説明が求められます。そのための共通のプラットフォームが必要になってきます。

すでにベストプラクティス集をさまざまな団体が出していて、AIをいかにうまく実践的に使っているか、あるいは失敗した事例が公開されています。ただし、チャットボットで起きた問題と、医療AIで起きた問題を同じカテゴリーで議論することは難しいので、似た項目で比較検討することができるフレームワークやプラットフォームがあったらいいのではないかということで議論が始まりました。

サンプルケース「採用AI」(画像引用:https://ifi.u-tokyo.ac.jp/wp/wp-content/uploads/2021/07/RCM_210705.pdf)

ーー今後リスクチェーンモデルの議論をどう発展させていきたいですか。

江間さん:リスクチェーンモデルのガイドを作り、こちらでリスクチェーンモデルの使い方やどうやってそれをマネジメントに落とし込んで議論していけるかを説明しています。

このガイドを作って終わりではなくて、活用してフィードバックを得ながらどんどんケースを蓄積していく予定です。そうすることで事前にリスクを参照できたり、現時点で開発者と一緒に議論していかなくてはいけないことの参考にできたりするのではないかと考えています。2021年7月には「採用AI」を事例にして、リスクチェーンモデルを使ったオンラインイベントを開催しました。その報告書やまとめ動画もウェブサイトに秋以降掲載していく予定で、現在準備中です。

ーーこれからさらに認知を拡大して実践のフェーズで使われるフレームワークが生まれていくのですね。

江間さん:そうですね。ただ、注意していただきたいのは、フレームワークがあることによってAIの公平性や安全性に保証を与えるものではないということです。あくまで1つの考え方であってAIをめぐるリスクというのは刻一刻と変わっていきますし、受け手の価値観によっても判断基準が異なってきます。

コンサルティングではなく大学でやっている研究ですので、みんなが使えるようなツールとして広めていきたいですし、国際的にも発信することでガバナンスのフレームワークとして展開をしていきたいと思っています。

出版に込めた思い|企業からだけでなく個人からも声をあげることができるように

江間さんは2021年5月に『絵と図でわかる AIと社会 ――未来をひらく技術とのかかわり方』(技術評論社)を出版しました。

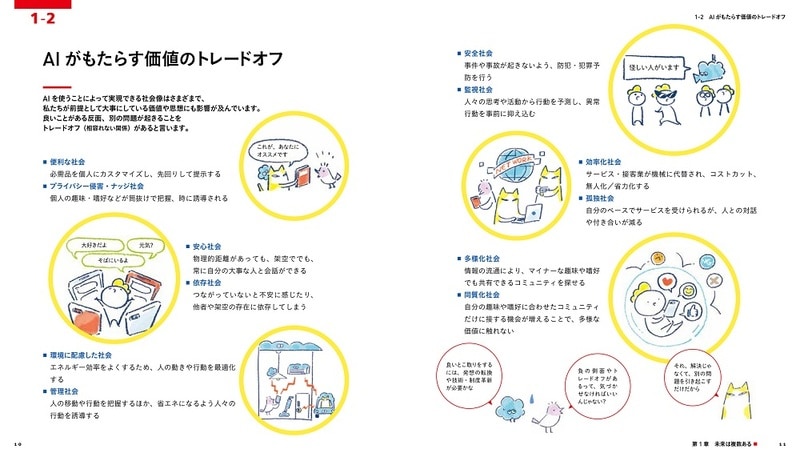

本書10-11ページ「AIがもたらす価値のトレードオフ」

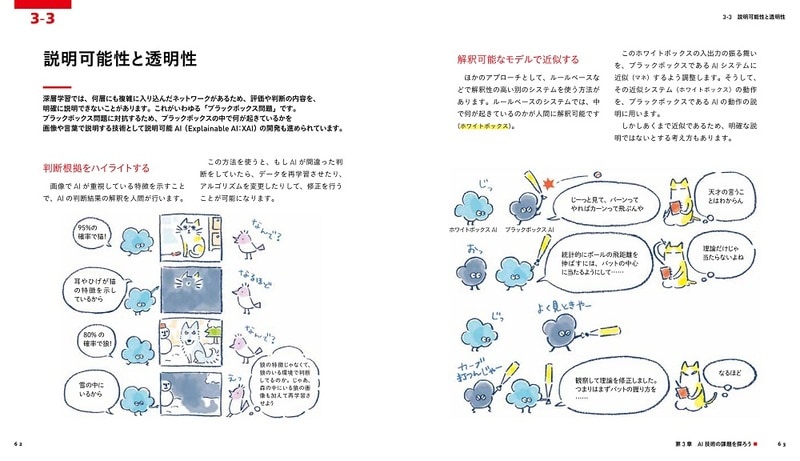

本書62-63ページ「説明可能性と透明性」

イラストが多く使われおり、AI技術の基本からAIを取り巻く社会問題まで初学者がわかりやすいように説明されています。

ーー今回ご出版された書籍に込めた思いをお聞かせください。またどんな方に読んでもらいたいですか。

江間さん:学習指導要領の改訂で、2025年より大学入学共通テストの中に新しく「情報」という教科が追加される予定です。その教育に関わる方たちや生徒がAIに触れる機会が増えてくると思うので、副教材的として使っていただけたらと考えています。ただ、今までお話してきたAIガバナンスエコシステムやリスクチェーンモデルについても本書では紹介していますので、中高生だけでなく企業でAIシステムの営業、法務や広報に関わる方などさまざまな年代の方にも入門書として読んでいただきたいとも思います。

書籍の第6章に書いていますが、環境に配慮したシステムや公平性に配慮したシステムというのは顧客や消費者からのニーズがないと企業がコストをかけてくれないという現状があります。だからこそ、消費者や生活者が声をあげムーブメントを起こしていくことが重要です。AIにはできることとできないことがあるのでその問題点に気づいたり、無意識のバイアスをなくしたりすることで企業からも個人からも疑問を投げかけられるようになってほしいと思います。

おわりに

AIガバナンスは今後AIの社会実装が進むことでより一層活発に議論が展開されていくでしょう。いかに多くの人を巻き込み、誰もAIによる差別を受けない世の中を作れるかはIT化が急速に進む日本や世界全体の課題です。

私たちのようなAIを伝えていくメディアも例外ではないと今回の江間さんのインタビューから感じました。今後もAIを巡る問題にも正面から向き合い、公平性をもって伝えていくことでAIの発展に寄与していきます。