ブルームバーグやロイター通信が報じたところによると、OpenAIは極秘裏に「プロジェクト・ストロベリー」と名づけられた次世代AI開発プロジェクトを推進していると見られます。同プロジェクトでは既存AIより強力な推論能力を備えたAIが開発されており、その能力は「高度な数学や科学の問題」を解けると言われています。

プロジェクト・ストロベリーでは、スタンフォード大学らの研究チームが2022年に発表したAI技法「Self-Taught Reasoner (STaR:自己教育推論器)」が活用されていると言われています。この技法を簡単に説明すると、間違った推論から正しい推論を自己学習することで、AIの推論能力を向上させるというものです(同技法の詳細は以下の翻訳記事本文を参照)。

GPT-4oに続くGPTモデルについては、OpenAIのミラ・ムラティCTOが2024年6月に「博士号レベルの人間のような知性を持つだろう」と発言しており、次世代GPTモデルが水面下で開発されていることを示唆しています。

以上のようなプロジェクト・ストロベリーが、アルトマンOpenAI CEOが突然解任された「OpenAI騒動」の際に噂された先進的AI「Q*」を後継するものなのかは不明ですが、OpenAIは着々と次世代GPTを開発していると推測されます。そうした推測の根拠として、2024年8月29日、OpenAIとAnthoropicがアメリカ政府機関であるAI安全性研究所と公開前AIモデルに対して安全性評価を実施することに合意したり、2024年9月3日に開催されたKDDI主催のビジネスイベント「KDDI SUMMIT 2024」において、OpenAI Japanの長﨑 忠雄代表が「いずれ出てくる『GPT Next』というAIモデルは、過去の実績から見て100倍近く進化していく」と発言したりしたこと(出典はITmedia AI+記事)が挙げられます。

なお、以下の記事本文はジム・クライブ・モンジュ氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、日本語の文章として読み易くするために、意訳やコンテクストを明確にするための補足を行っています。

画像制作:ジム・クライブ・モンジュによる

はじめに

OpenAIは、未発表の新しいAIモデル「プロジェクト・ストロベリー(Project Strawberry)」で、再びAIの限界に挑んでいる。この取り組みは、以前はQ*として知られており、AIモデルの推論能力を飛躍的に向上させることを目指している。

ブルームバーグやロイターが最近リークした情報によると、OpenAIは、AIモデルが計画を立て、自律的にインターネットを探索し、OpenAIが「ディープ・リサーチ(deep research:深層検索)」と呼ぶものを実行できるように、研究を進化させている(※訳注1)。

さらにアルトマンは、現在のGPT-4は1万回質問すれば1回くらいはかなり良い回答を出力するに過ぎない一方で、ユーザは毎回最高の回答を求めているだろう、とも回答した。

また、前出のロイターの記事は、翻訳記事で言及されているSTaRを執筆したスタンフォード大学のノア・グッドマン(Noah Goodman)教授の発言も引用している。同教授はSTaRを活用すれば、AIは人間をはるかに凌駕するスーパーインテリジェンスに到達する可能性があると述べたうえで、しかし、この可能性は「エキサイティングであると同時に恐ろしいことだと思います。このままこの方向に進むのであれば、人間として(AIとの関係を)深刻に考えなければならないことがあります」と発言した。

ブルームバーグによると、火曜日に開催された社内全体会議で、OpenAIは人間のような新しい推論能力を備えたと主張される研究プロジェクトのデモを行った、とのこと。(※訳注2)

基本的に、OpenAIはAIがより人間らしく考えるように努めている。

一部の情報筋によると、OpenAIは内部でモデルをテストし、AIの数学能力テストで90%のスコアを達成したという。しかし、これがプロジェクト・ストロベリーに関連しているかどうかは確認できなかった。

一方、さらに異なる2つの情報源は、Q*プロジェクトのデモを目撃したと報告しており、そこでは、今日の主要な商業用AIの能力を超える高度な数学や科学の問題を解くモデルが紹介されていた。

OpenAIがこれらの能力を強化するために使用した正確な方法は、依然として不明である。ロイターの報道によると、プロジェクト・ストロベリーでは、広範なデータセットで既にトレーニング済みのOpenAIの既存大規模言語モデルのファインチューニングが行われているという。

以上のアプローチは、スタンフォード大学の研究者による2022年の論文「Self-Taught Reasoner (STaR:自己教育推論器)」で概説されているものと同様であると報告されている(※訳注3)。

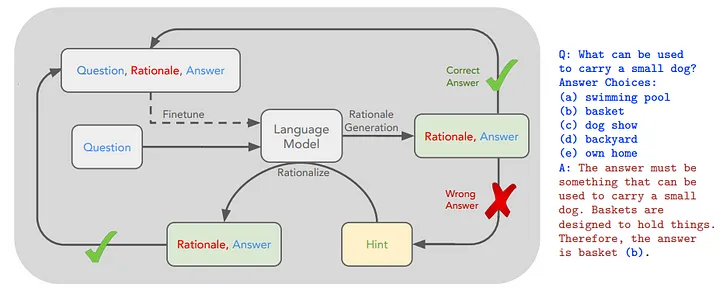

コモンセンスQAにおけるSTaRの概要とSTaRが生成した根拠

上の図では、ファインチューニングの外側のループが破線で示されている。質問と正解はデータセットに存在することが期待され、根拠はSTaRを使用して生成される。

STaRの処理プロセス

|

上記のプロセスを繰り返せば、不正解における根拠からも学習できるので、STaRによって推論能力が向上する結果となる。

・・・

では、ストロベリーとは何なのか?

数週間前、YouTubeチャンネルのダートマス・エンジニアリング(Dartmouth Engineering)におけるインタビューで、OpenAIのCTO(最高技術責任者)であるミラ・ムラティ氏は次世代AIについて語り、そのAIは博士号を持つ人間のような知性を持つと説明した(※訳注4)。

さらに3年後のAIの在り方について尋ねられると、AIは自律的なエージェントとなり、自由にインターネットにアクセスし、他のエージェントや人間と協働しているだろう、とムラティ氏は答えた。

ミラ・ムラティの画像

ストロベリーとは、彼女が言及しているモデルのことだろうか。

「最も重要な進歩の領域は、推論能力の周辺になるだろう」 — OpenAI CEO、サム・アルトマン

現在のAIモデルは、テキストの生成や特定のタスクの実行には優れているが、複雑な推論、長期的な計画、自律的な意思決定には苦戦している。

しかし、より幅広い文脈を考慮することは重要である。

イリヤ・サツケバーがOpenAIを去り、アライメントチームの主要メンバーも退社したため、OpenAIの研究の方向性や、一般公開される製品について安全性への懸念が高まっている。

私はOpenAIが描いている現在の軌道について深く懐疑的だが、AIの専門家ではない。私の懸念は、開発のペースが速いことと、これらの高度なテクノロジーがもたらす潜在的な影響から生じている。

以前はQ*(Q-Star)と呼ばれていた

プロジェクトQ*は、サム・アルトマンとイリヤ・スツケバーのドラマ(※訳注5)により、2023年に広く注目されるようになったが、実際の開発業務は2022年初頭から進められていた。

OpenAI騒動はアルトマンがCEOに復帰することで急速に収束したが、2024年3月8日、OpenAIは新ガバナンス体制と騒動に関する調査結果をまとめたブログ記事を公開した。その調査は、アルトマンがCEOを解任されたのは「前理事会とアルトマン氏とのあいだの信頼関係の崩壊」が原因であり、「製品の安全性やセキュリティ、開発のペース、OpenAIの財務、投資家、顧客、ビジネスパートナーに対する声明に関する懸念から生じたものではなかった」と報告している。つまり、Q*のような先進的人工知能の開発をめぐる対立はなかった、という公式見解を示している。

サム・アルトマンとイリヤ・サツケバー

主な開発スケジュールは以下の通りである。

- 2022年初頭:OpenAIがAIシステムの推論能力向上に向けた取り組みを開始

- 2022年半ば:OpenAIに所属していた著名な研究者であるイリヤ・サツケバーが、後にプロジェクトQ*となる取り組みを開始

- 2022年後半:Q*チームが簡単な数学問題を解くモデルを開発

- 2023年初頭:プロジェクトを巡り、Q*の研究者たちとCEOのサム・アルトマンとのあいだで対立が生じる

Project Q*のアーキテクチャは、大規模言語モデル、強化学習、検索アルゴリズムを組み合わせたものとなる。それは、ChatGPTに見られるディープラーニング技術と人間がプログラムしたルールを統合したものでもある。このAIモデルは、Q学習とA*探索(※訳注6)を組み合わせたものとなる可能性がある。

なぜQ*と呼ばれるのか?

OpenAIからの公式な声明はないが、「Q*」という用語は、強化学習におけるDeepMindの歴史に由来する可能性がある。当初、DeepMindはQ学習を用いてニューラルネットワークを訓練することを通して、AtariのビデオゲームをプレイするAIを開発していた。具体的には、試行錯誤しながら学習し、さまざまな行動から報酬を推定するQ関数と呼ばれる関数を最適化していた。

以上の技術的基盤にもとづけば、Q*はおそらく大規模言語モデルとAlphaGoスタイルの検索技術を統合し、強化学習を用いてモデルを強化しようとする試みであると見られる。その目標は、言語モデルが複雑な推論タスクにおいて「自分自身と対戦」することで能力を磨き、言語モデルが達成できることの限界を押し広げるようなシステムを開発することであろう。

・・・

最終的な考察

まだすべての詳細が明らかになっているわけではないが、OpenAIが大きな目標を掲げていることは明らかである。Q*、またはプロジェクト・ストロベリーがAGIにつながる画期的な進歩であるかどうかは疑わしい。私は、AGIが人類にとって脅威となるとは思わない。しかしながら、プロジェクト・ストロベリーが一般的な推論能力を持つAIの開発に向けた大きな一歩となる可能性はある。

重要なのは、知能は人間であれ人工であれ、連続体として存在することを認識することだ。

人間の推論能力がIQなどの要因によって異なるように、AIシステムも設計や訓練によって能力のレベルが異なる。多くの産業や専門的な用途では、現在のAIシステムはすでにAGIのような能力を発揮しており、データ分析、パターン認識、論理的推論を伴う特定のタスクでは、ほとんどの人間を凌駕している。

しかしながら、一般的な推論、常識、創造性、感情的知性といった分野では、依然として人間が優位を保っている。AIがもっているかもしれない真の変革的潜在能力を解き放つ鍵は、AIと人間の知性を競わせることではなく、それらを組み合わせることにある。

![]()

この記事は Generative AIに掲載されたものです。LinkedInとZeniteqもフォローして、AIに関する最新情報を入手しよう。

ニュースレターとYouTubeチャンネルに登録して、生成AIに関する最新ニュースとアップデートを入手しよう。AIの未来を一緒に形作っていこう!

原文

『OpenAI Introduces “Project Strawberry”』

著者

ジム・クライブ・モンジュ(Jim Clyde Monge)

翻訳

吉本 幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1、生成AIパスポート、JDLA Generative AI Test 2023 #2取得)

編集

おざけん