技術は軍事と常に切っても切れない関係にあります。重工業などの分野は、軍需によって大きく発達してきた側面もあるのは事実です。

今話題になっているAI(人工知能)の技術も例外ではなく、ビジネスや生活を超えて軍事の領域でも利用されるようになっています。

もし軍事にAIが活発に利用されるようになれば、戦争の形も従来とは全く違う形になるかもしれません。また、私たちの生活への影響も大きいと考えられます。

AIの軍事利用は賛否が分かれることは良く知られていますが、議論する前提の知識として、今回は軍事におけるAI利用の最新動向に関してご紹介していきます。

目次

軍事へのAI利用が盛んに

人が操作するロボットはすでに導入されている

ロボットの戦場への利用はすでに開始されています。これはロボットが自律的に動くというよりも人間が遠隔操作でロボットを操作し、戦場で活動させる形です。

例えば2020年1月、アメリカ軍によって実行されたイラン革命防衛隊のカセム・ソレイマニ司令官の殺害はドローンによる空爆で行われました。

兵士を戦場に行かせることなく人間が入れないエリアでの活動が可能になったことで、軍事行動の幅が広がっているのです。

AIによって人の判断を介さずに攻撃が可能に

軍事のAI利用には2種類があります。半自律的兵器と自律的兵器です。

半自律的兵器とは、AIなどの技術によって人間の兵器コントロールに関する判断を高度・高速化する兵器のことを言います。攻撃対象の判定、攻撃の実施判断などは人間が行うことが前提になっています。例えば映画のガンダム、操縦するラジコンのようなドローン、良く知られる巡航ミサイル トマホークなどはこれにあたります。

自律的兵器とは、AIなどの技術によって兵器コントロールに関する判断をすべてシステムが行う兵器のことを言います。攻撃対象の判定、攻撃の実施判断などはすべてアルゴリズムが行い、人間がコントロールに関与しません。例えば映画のターミネーター、人が操縦しないドローン、スイッチがオンになったあとのCIWS(イージス艦などの近接防御火器システム)がこれにあたります。

倫理の問題で議論を呼んでいるのは人間の判断が加わらない自律的兵器です。AIやシステムにより、人の判断を介さず攻撃が可能になります。AIを搭載した無人ロボット兵器なら人よりも強い防弾性能を備えられるだけでなく、仮に敵に倒されても人の命が奪われるわけでないので安心という見方もできます。しかし、自律的な判断が可能な兵器が人間に危害を加えることが可能になれば、かつてない規模の殺害が行われることになります。

どのようにAIが軍事に利用されるか

防衛機密もあるので全てはわからない

AIの軍事利用に関しては防衛機密の関係で、全てが詳細までわかるわけではありません。

しかし、どの国もAIを軍事に利用する動きに出ていることは確かです。

事実、2018年にアメリカの国防総省はAI部門に20億ドルの投資計画を発表しました。また、中国は100機以上のドローンが編隊を作る様子が世界で話題となりました。

無人兵器としてAIを搭載(完全自律型兵器「LAWS」)

AIを搭載し完全自立化した兵器は「LAWS」( Lethal Autonomous Weapons Systems)と呼ばれています。LAWSにはさまざまな種類がありますが、ドローンなど場所の制限を考慮しない形態で利用されることが多いです。

ドローン

ドローンにAIを搭載し、自律的に飛行して任務に遂行させます。

敵地への偵察や爆撃など今ままで有人飛行機で行なっていた危険な任務をAIで自動化することができます。AIで地上の画像を撮影して、人間よりも高い精度で分析したり対象を攻撃するという利用法は映画などでおなじみです。

映画などでよく見かけるドローンのコントローラー(人)がミサイルの発射を判断するものは人が関与しているため自律的兵器にはあたりません。

自律的兵器は、判断に人が関与せず、兵器そのものの中で閉じているものをいい、最も議論のあるAIの軍事利用領域です。自律的兵器の名前の通り、その行動はアルゴリズムが判断し、人が関与することはありません。

なぜ議論があるのかといえば、例えば攻撃対象に民間人が含まれているとして、それを自律的兵器が付随的被害(コラテラルダメージ)、いわゆる「政治的にやむを得ない犠牲」と判断して攻撃するのか、しないのか。その場合の判断は正しいのか、倫理的責任は誰が取るのか。

正解がないともいえる難しい議論になるでしょう。

▼関連記事

ロボット

ロボットの軍事利用では地上を行動するロボットにAIを搭載し、人間の兵士に代わる新たな兵力として従事させます。

戦車や装甲車などの車両を自動運転化する他、人型や動物型などあらゆる形のAI搭載ロボットが開発されつつあります。

例えば、ボストンダイナミクスが開発したAI搭載人型ロボット「アトラス」はまるで人間のように走ったり、ジャンプしたりできます。

▼ボストンダイナミクスが開発した「アトラス 」

引用:https://robotstart.info/2019/09/25/atlas-more-parkour.html

軍事行動の支援ツールとして利用

AIを兵器として使用する以外に、軍事行動の支援ツールとして利用する事例も出ています。

例えば、イスラエルのミサイル防衛システム「アイアンドーム」では、敵からミサイル攻撃を受けた際に、いつどのように迎撃すれば良いかを味方の被害が最小になるように教えてくれます。

このように、AIによって戦場で人的被害を減少させる判断の質を向上させるという使い方も可能になります。

軍事にAIを利用するメリット

自国兵士の命を守れる

人間の代わりにAIを戦力として使えば人間が戦う必要はありません。

戦争が人間対人間ではなく、AI対AIという形になれば人間は戦争であったとしても命を落としません。これは人道的で倫理的な使い方だという見方もできます。

判断と行動の精度が向上

AIであれば人間に高精度・高速で分析したり実行に移したりできます。

戦争では敵地を正確に攻撃したり、不測の事態に瞬時に行動することが求められます。

そのため、人間以上の戦力としてAIが軍事的期待を寄せられているのです。

24時間365日稼働できる

AIは人間のように疲れたり睡眠の必要がないため、24時間365日稼働することができます。

そのため人間の兵士を雇うよりも非常にコストが低くなります。AIは恐怖や逡巡といった感情に影響されないという軍事的メリットもあります。

しかし逡巡や恐怖を感じないということは、容赦なく人を殺すこともできるということでもあります。いかにAIの判断の流れに人間の判断を加えていくかが議論されることになりそうです。

AIの軍事利用に倫理面から批判の声も

AIの軍事利用に関して、倫理的な面から批判の声も上がっています。

もしAI兵器が人間の手を離れて暴走すれば大変な被害になるのではという恐怖があるからです。

GoogleはAIの軍事利用に反対

Googleはアメリカ国防総省と共同し、ドローン兵器利用に向けた「Project Maven」を進めていました。

しかし、Google社員はAIの軍事利用に反対。

結果として、このプロジェクトは打ち切りとなりました。

政府による倫理規範も

アメリカの防総省は『軍事におけるAIの倫理的な利用ガイドライン』を発表

アメリカの防総省はAIの軍事利用に関して、倫理的に利用するようガイドラインを発表しました。

その内容としては、軍事にAIを利用する際にはそのAIの「Responsible(責任感のある)」「Equitable(公平な)」「Traceable(追跡可能な)」「Reliable(信頼できる)」「Governable(統治可能な)」のからなる5つの観点から検討することを明記しています。

ただし、これはガイドラインのため法的な強制力があるわけではありません。

スイスでAI兵器の規制が議論されるも難航

2019年3月にスイスでAI兵器の規制に関する国際会議が実施されました。

しかし、この会議ではAIの軍事利用に関する各国の思惑が一致せず議論が難航しました。

アメリカやロシアなどの先進国はAIの積極的な軍事利用を主張する一方で、発展途上国はAIの軍事利用への規制を主張したためです。

また、仮に国際法でAI兵器の規制を定めたとしても、国際法には強制力がないため完全に規制することは困難です。

軍事へのAI利用への各国の姿勢は?

日本

日本はLAWSを開発しない立場をとっています。

国際的にも、人間の制御は不可欠だと主張しています。

殺傷するAI兵器は開発しないものの、省力化のために軍事へのAI利用は進めるようです。

アメリカ

アメリカはAIの軍事利用に向けた研究に投資を拡大しています。

米国防総省は2018年に今後5年間で約50億ドルをAI研究に充てることを発表しました。

また、AI業界を代表するような企業との提携も計画しています。ただし、そのうちいくつかはアメリカのIT企業からの反対によって取り消されました。

中国やロシアなどAIを積極的に進める国に対抗していくようです。

イギリス

イギリスでは、国防・セキュリティ促進機構(DASA、Defense and Security Accelerator)が2020年1月14日に海軍に対して効果的なAIの導入を提案したスタートアップに、総額400万ポンドもの投資を実施することを発表しました。特に注目しているのが、AIを生かした軍艦の意思決定の質向上です。コンペ「Intelligent Ship–The Next Generation」では9つのプロジェクトに対して、総額100万ポンドを支給し、今後も攻撃防御システムなど幅広い先進的な取り組みを目指しています。

中国

中国の人民解放軍は軍事にAIを軍事のあらゆる分野にAIを利用し確信を目指す「AI軍事革命」を目指しています。

中国はAIを最重要技術として国が主導して、2030年までに中国をAIの分野で世界をリードする存在にする目標を立てています。そして、軍民融合によってその技術を軍事に応用し、AIによる軍事革命を目指しています。

特徴的なのが、AIとロボットやドローン、船といった無人機システムの融合です。戦場を完全に無人化することで、戦争を今までの形から一変させるのではないでしょうか。

ロシア

ロシアはAI国家戦略プランにおいて、ロシアがAI技術では世界でリーダー的存在となり、AIでは他国に依存しない独立性とロシアのAI分野の競争力を強化していく重要性が強調されています。

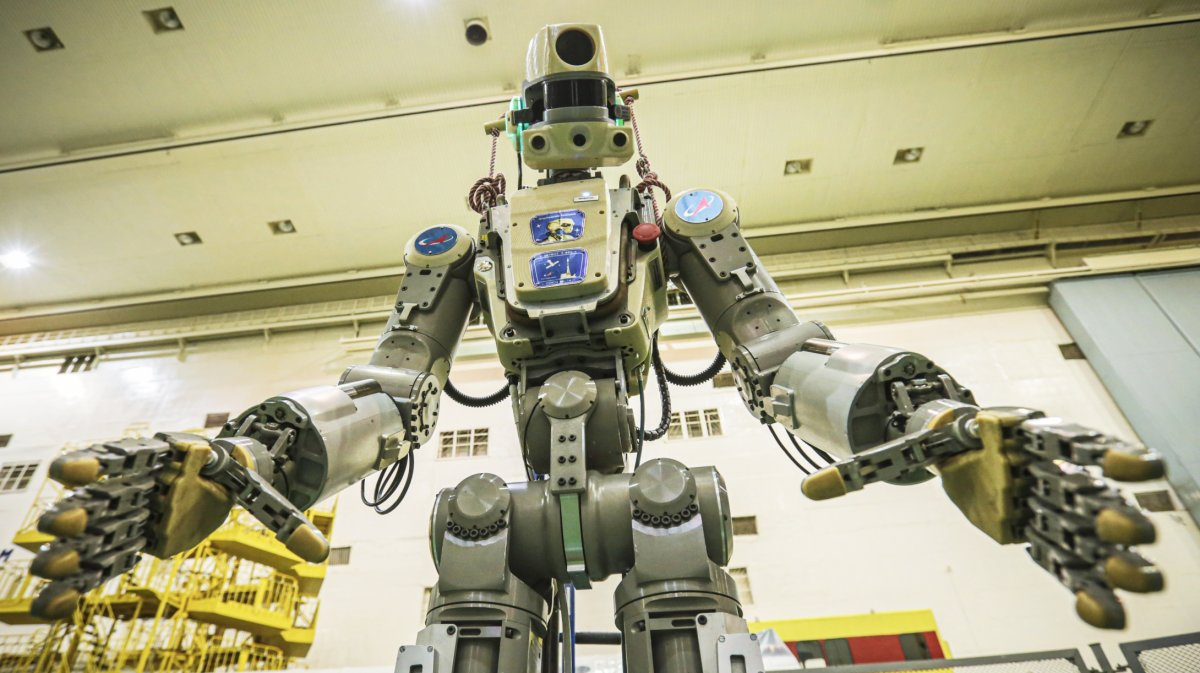

ロシアは現在軍事AIロボット「フョードル」を開発しています。

フョードルは自律的に動けるAI搭載人型ロボットであるだけでなく、2本の拳銃で射撃したり、自動車を運転することができます。その精度は非常に高いため、実戦でも期待されています。

▼軍事AIロボット「フョードル」

引用:https://japanese.engadget.com/2019/07/30/skybot-f-859/

軍事にAIは利用するべきか

他国の侵攻から防衛できるか

AIを軍事利用に関しては、各国で立場や取り組みがさまざまで、積極的に軍事利用している国もあれば倫理的な観点から軍事利用をしない国もあります。

しかし、国である以上、他の脅威からの防衛は常に重要な問題であり続けます。

もしAIを利用して強大になった敵国の軍が自国に進攻を始めた場合、アナログな戦力で対抗できるのでしょうか。

特に日本のような少子高齢化の進んでいる国は兵力の少なさを技術で補う必要があります。

自国を他の脅威から守るためにも、抑止力として技術を積極的に利用する必要性を完全に否定することはできません。

戦争のハードルが下がる可能性も

戦場に人ではなくAIを代わりに行かせられるようになると、戦争のハードルが下がってしまうのではという考えもあります。

確かに人が死ななくて良いとなれば、戦争が今よりもやりやすくなるのかもしれません。

そのため、国際法によってAI兵器の開発を規制すべきだという意見もあります。

大量虐殺のおそれ

AI兵器が暴走すると大量虐殺が始まるのではと考える人もいます。

もし、人を殺害するように設計されたAI搭載ロボットが市街地に解き放たれると、軍人や民

間人を問わず次々と殺されていきます。

そのような、AI兵器の暴走のリスクも考える必要があります。

AI兵器にどう立ち向かう?

もし将来的にAI兵器に立ち向かうことになった場合、どのような対抗手段があるのでしょうか。

電磁パルス攻撃

電磁パルス攻撃とは高度30~400kmの上空で核爆発を起こし、ガンマ線と空気の分子を衝突させることで強力な電磁パルスを地上に降らせる攻撃です。

これによって、人を殺したり害を与えることはありませんが、攻撃を受けた地域の全ての電子機器は機能を停止します。

アメリカが1962年に北太平洋上空で実施した高高度核実験「スターフィッシュ・プライム」では、高度400kmの上空で核爆発が引き起こされました。結果として、爆心から1400kmも離れたハワイでも大規模な停電が発生したことで、その威力が実証されたのです。現在では全てのインフラを破壊し、1年後には人口の9割が餓死するとも言われています。

つまり、電磁パルス攻撃を使えば、敵国のAI兵器の機能を停止させることができるということです。

しかし、電磁パルス攻撃はAI兵器を含む全ての電子機器の機能を停止させるため、使い方には注意が必要です。

ドローン捕獲用ドローン

引用:https://www.sankei.com/photo/photojournal/news/160117/jnl1601170002-n1.html

敵国のドローンを捕獲するためにAI搭載ドローンを利用する流れもあります。

AIを使って敵国のドローンを検知し、備えられた網を使って捕獲します。装備された網で直接捕獲する以外に投網を使ったものもあります。

非常にシンプルな方法であるだけでなく、AIを使うことで人がレーダーなどで常に監視する必要もなくなり、コストを抑えられるのもメリットです。

ただし、こちらのドローン捕獲用ドローンに対して、相手がドローン捕獲用ドローンを捕獲するドローンを繰り出してきて、こちらもそれを捕獲するドローンを繰り出すなど収拾がつかない事態に発展する可能性もあるので注意が必要です。

また、ドローンではなく鷲や鷹など猛禽類を使う取り組みもあるそうです。

▼フランス空軍では鷲でドローンを捕獲するプロジェクトが始動

引用:https://www.maxisciences.com/drone/quand-un-aigle-neutralise-un-drone-en-plein-vol-aux-pays-bas_art38754.html

まとめ

軍事と技術はいつの時代も常に切っても切れない関係にあります。

すでにAIは軍事で利用され今後の成長も予想されています。AIの軍事利用は賛否が様々あることは良く知られていますが、軍事への技術利用はAIにはじまったことではありません。

議論する前に現在のAI利用の最新動向に関して知っておく必要があるのではないでしょうか。

軍事AIをどう倫理的にコントロールするかはこれからの議論になりそうですね。

現在主流となっているのは、自律的兵器に対する人的判断の介入です。これは核兵器の発射コードを複数の人間で管理し、発射ボタンを押す仕組になっているように、複数の人間の判断をシステムの判断に組み込む方法です。

AIといえど、最終的には使う人間の判断が役割を果たすようにしたいですね。

慶應義塾大学商学部に在籍中

AINOWのWEBライターをやってます。

人工知能(AI)に関するまとめ記事やコラムを掲載します。

趣味はクラシック音楽鑑賞、旅行、お酒です。