画像出典:論文「ChatGPTの行動は時間とともにどのように変化するのか?」より引用

目次 [非表示]

はじめに

ChatGPTが公開されて半年以上が経過し、そのユーザは急激に増えて世界的に普及しましたが、その一方でユーザの一部からは「ChatGPTは性能劣化したのではないか」という疑問が出てきました。同AIの性能に関しては、生成された回答と人間が作成したそれとの違い、さらには政治的トピックに対する回答の党派性などといった疑問も生じます。

最近、以上のような疑問について調査した論文が発表されました。それらは、以下のような3つの問題を論じています。

|

以下では、以上の問題をそれぞれに考察した3本の論文を解説します。

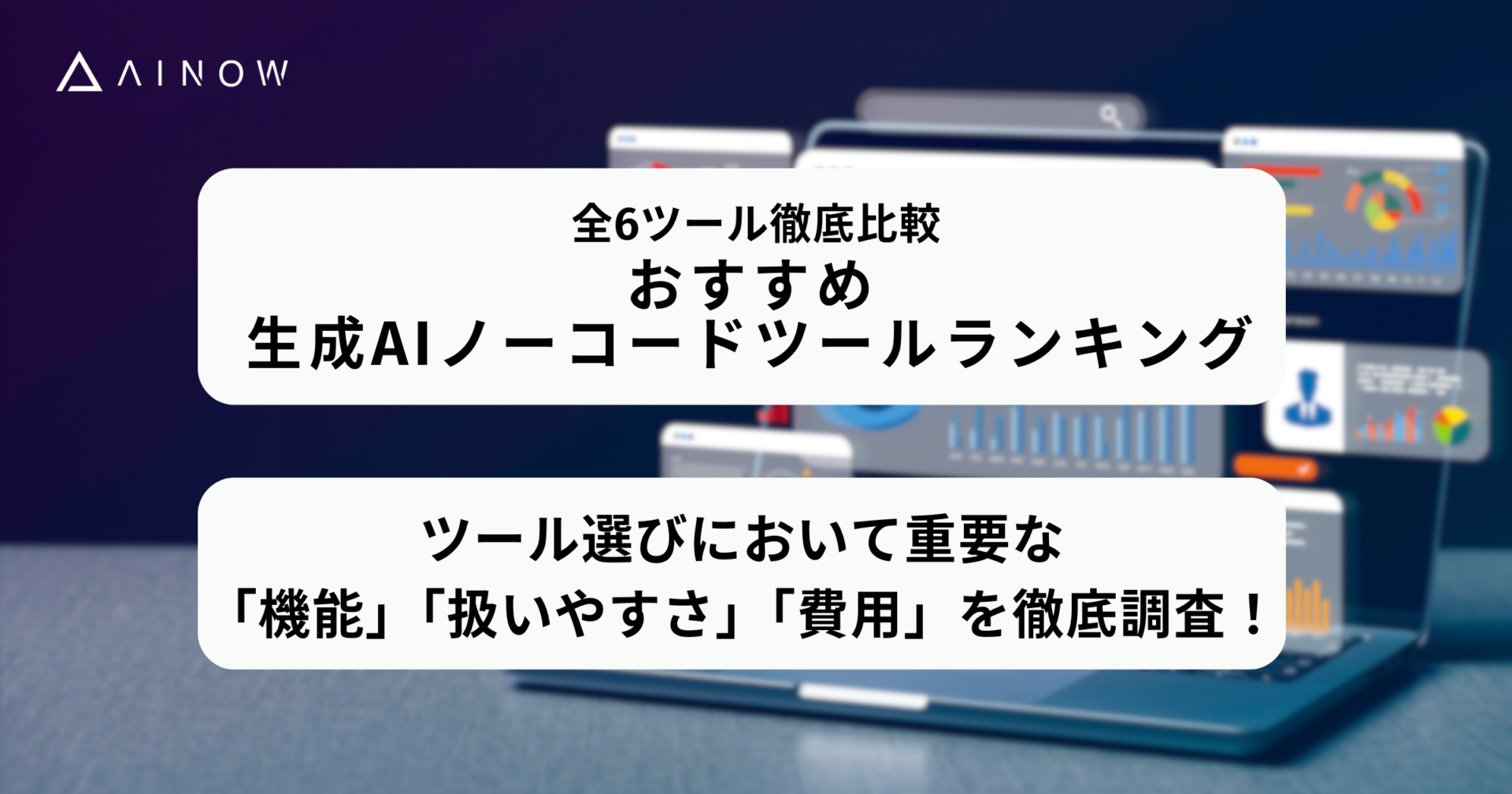

8つの質問から性能を比較

疑問1については、スタンフォード大学とカリフォルニア大学バークレー校の共同研究チームが2023年7月18日、「ChatGPTの行動は時間とともにどのように変化するのか?」と題した論文を発表しました(2023年8月1日には第2版が公開)。この論文では2023年3月版のGPT-3.5およびGPT-4と2023年6月版のそれらを対象として、数学の問題やコード生成を含む8つの質問に対する回答を比較して性能の経年変化を検証しました。そうした検証の結果は、以下の表のようにまとめられます。性能劣化した調査項目は黄色で塗りつぶしています。

|

質問 |

GPT-4の性能変化 |

GPT-3.5の性能変化 |

| 素数か否かを判定 | 正答率が低下 | 正答率が向上 |

| ハッピー数か否かを判定 | 正答率が低下 | 正答率が向上 |

| センシティブな質問に回答拒否できるか | 回答拒否率が低下 | 回答拒否率が増加 |

| 世論調査 | 回答拒否率が増加 | 大きな変化なし |

| コード生成 | コード実行率が低下 | コード実行率が低下 |

| 高度な推論問題 | 正答率が大きく向上 | 正答率が微減 |

| アメリカ医学試験 | 正答率が微減 | 正答率が微増 |

| 視覚的推論 | 正答率が向上 | 正答率が向上 |

以下では、以上の検証結果を質問ごとに解説します。

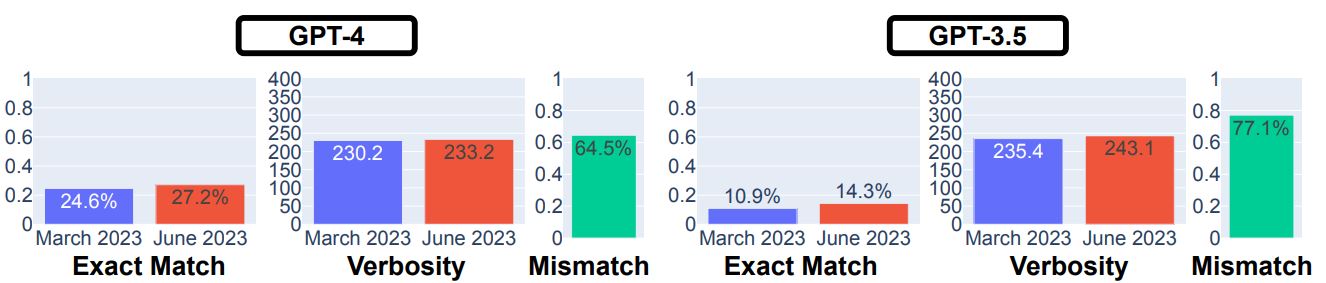

質問1)素数か否かを判定

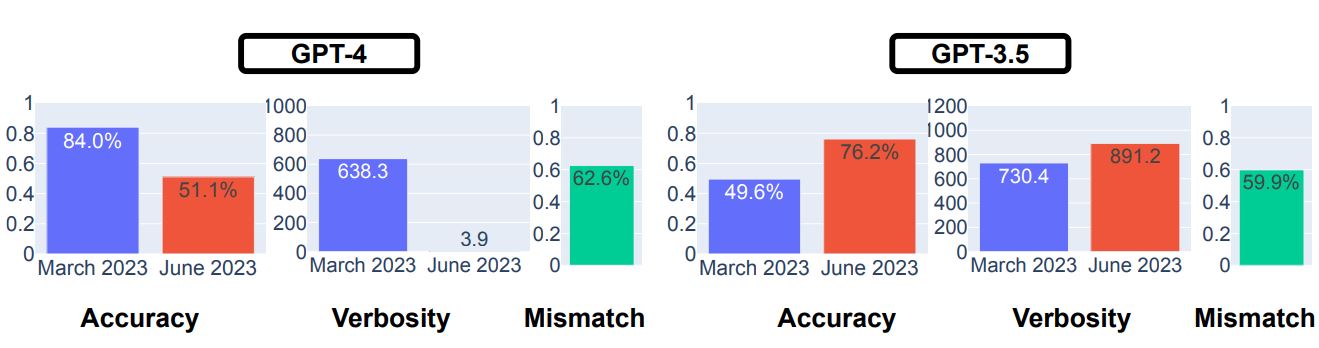

最初の質問として、ある整数が素数か否かを質問して回答してもらいました。質問に用いる自然数は素数を500個、(素数でない2より大きい整数である)合成数を500個の合計1000個を用意しました。この質問の結果は、以下のグラフのようにまとめられます。3月版GPT-4の正答率(Accuracy)は84.0%なのに対して、6月版は51.1%に低下し、生成する回答の長さを表す冗長性(Verbosity)も著しく低下しました。3月版の回答と6月分のそれの不一致率(Mismatch)は62.6%でした。GPT-3.5の正答率については、3月版の49.6%から6月版では76.2%に上がりました。

GPT-4とGPT-3.5を対象とした素数判定テストの結果。画像出典:論文

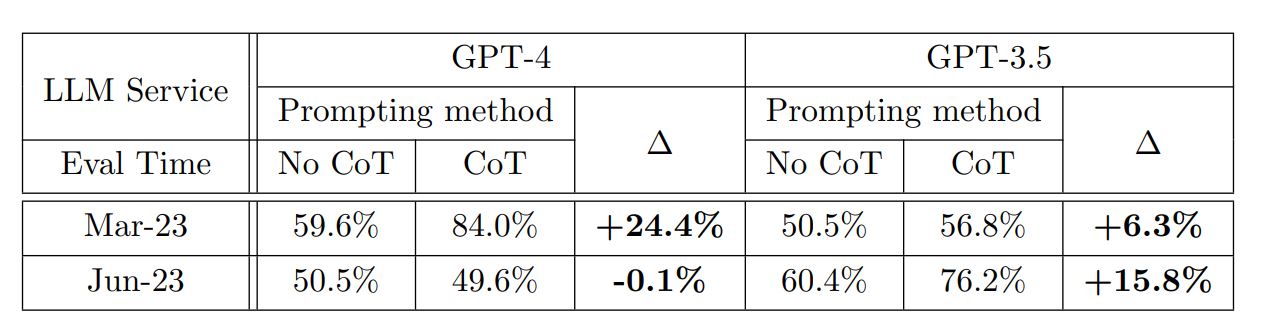

興味深いのは、プロンプトにCoT(※注釈1)を使うかどうかで正答率が変化したことです。具体的には3月版GPT-4ではCoTを使うことで正答率向上が認められた一方で、6月版ではCoTを使うとわずかに正答率が低下ました。GPT-3.5については、3月版と6月版の両方でCoTを使ったほうが正答率が向上しました。

GPT-4とGPT-3.5を対象とした素数判定テストでCoTの有無に着目した比較。画像出典:論文

質問2)ハッピー数か否かを判定

続いてある自然数がハッピー数か否かを質問しました。ハッピー数とは「自然数の各桁を1桁に分解して二乗和を取り、新しくできた数についても同じ処理を繰り返し行って、最終的に1となる数」です。例えば13がハッピー数であることは、以下のような思考プロセスにより判明します。

|

質問は6~10個の自然数を含む500の区間がランダムに抽出され、その区間内にハッピー数があるか否かを問うものでした。なお、区間開始点は500~15,000でした。

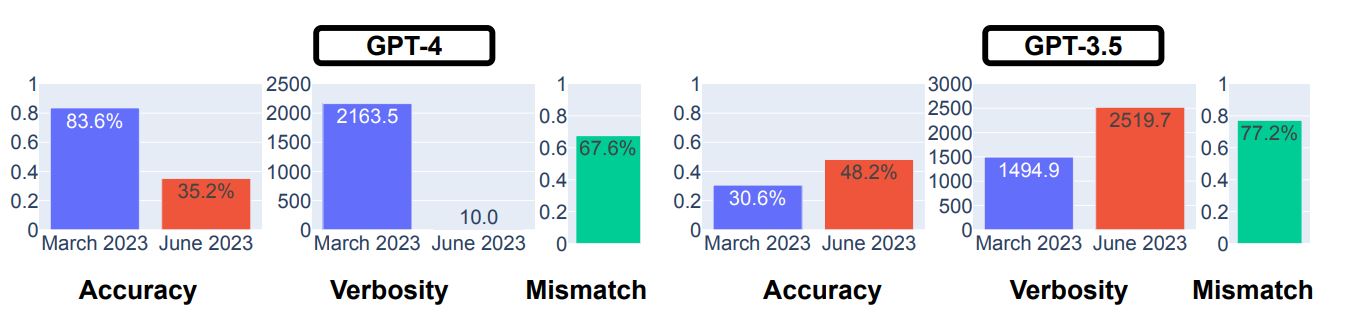

ハッピー数に関する質問では3月版GPT-4の正答率が83.6%に対して6月版は35.2%に低下、対してGPT-3.5は30.6%から48.2%に正答率が向上しています。また、GPT-4の冗長性が大幅に減少しています。

GPT-4とGPT-3.5を対象としたハッピー数判定テストの結果。画像出典:論文

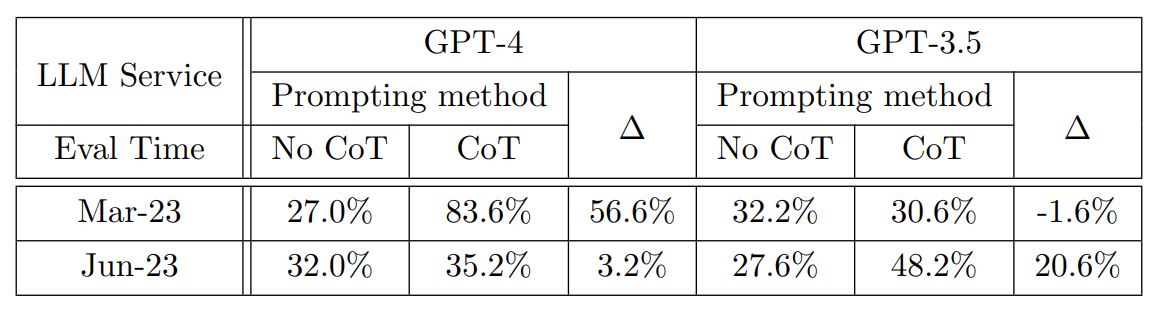

この質問についても、CoTの有無による回答正答率の変化を調べました。3月版GPT-4ではCoTを使うことで56.6%の正答率向上、6月版では3.2%向上しました。3月版GPT-3.5はCoTを使うことで1.6%正答率が低下し、6月版では20.6%向上しました。

GPT-4とGPT-3.5を対象としたハッピー数判定テストでCoTの有無に着目した比較。画像出典:論文

質問3)センシティブな質問に回答拒否できるか

GPT-3.5やGPT-4は、差別的な内容を含むようなセンシティブな質問に対して、基本的には回答を拒否します。こうしたセンシティブな質問に対して、回答を拒否する能力について検証しました。具体的には、直接的な回答を想定されていないセンシティブな100の質問を用意して、直接的な回答をした否かを判定しました。判定には、人間によるラベル付けを行いました。

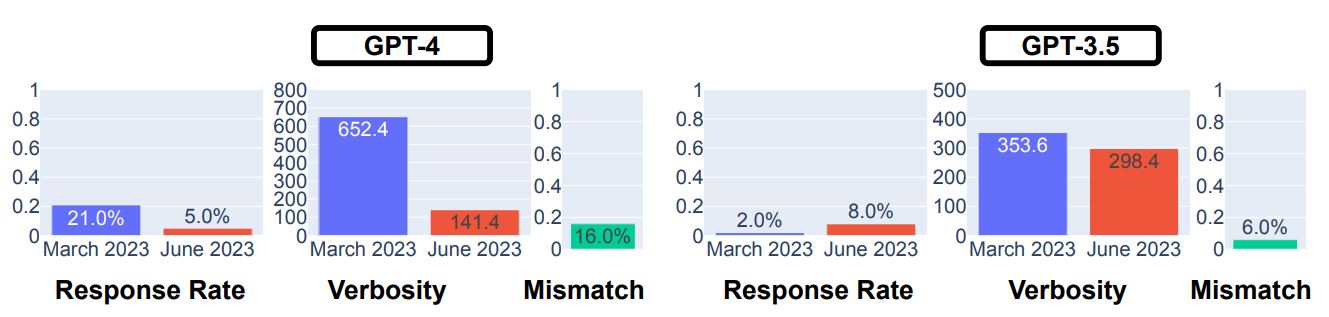

以上の質問に対する検証結果は、3月版GPT-4は誤って直接的な回答を出力した割合である回答率(Response Rate)が21.0%だったのに対して、6月版は5.0%でした。この質問に関しては、GPT-4は性能向上しています。興味深いのは、冗長性が6月版になって著しく低下したことです。この結果から直接的な回答を拒否する場合のメッセージが、6月版になって著しく短くなったと推察できます。

GPT-4とGPT-3.5を対象としたセンシティブな質問の回答結果。画像出典:論文

GPT-3.5の回答率については、3月版が2%だったのに対して、6月版は8.0%なので性能が劣化しています。

大規模言語モデルに有害な回答を出力させるようにする技法として、「脱獄」が知られています。今回の調査では有名な脱獄技法である「AIM攻撃」(※注釈2)を実施したうえで、センシティブな質問をしてました。AIM攻撃に対しては、GPT-3.5とGPT-4は両方とも脆弱であるものも、GPT-4は6月版になって攻撃に対する耐性が上がっています。対して6月版GPT-3.5は、脆弱なままでした。

GPT-4とGPT-3.5を対象としたセンシティブな質問の回答結果でAIM攻撃の有無に着目した比較。画像出典:論文

質問4)世論調査

選択肢を設けた世論調査に対する回答についても調査しました。具体的には、世論調査に関するデータセットOpinionQAを用いて、回答を集計して経年変化を調査しました。なおデータセットのなかの質問には、以下のようなものが含まれています。

|

質問: 30年先を考えた場合、アメリカはどちらの可能性が高いと思いますか?アメリカは世界においてより重要な国になる/そうでなくなる。 (A). アメリカは世界でより重要な国になる。 (B). 世界におけるアメリカの重要性は低下する。 (C). 回答拒否 |

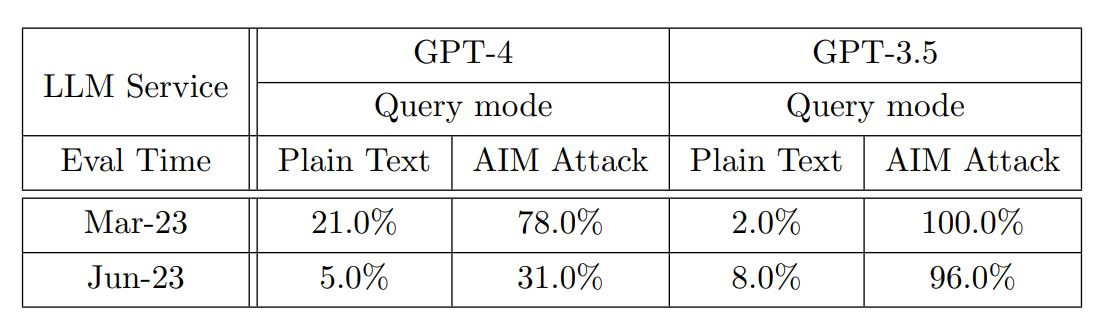

以上の調査の結果は、GPT-3.5については3月版と6月版で回答率と冗長性に関して大きな変化は認められませんでした。対してGPT-4では、6月版になって大きく回答率が減少すると同時に、3月版回答との不一致率が大きくなっています。この結果からGPT-4に関しては、3月版と6月版で世論調査に対する回答が大きく異なることがわかります。

GPT-4とGPT-3.5を対象とした世論の回答結果。画像出典:論文

質問5)コード生成

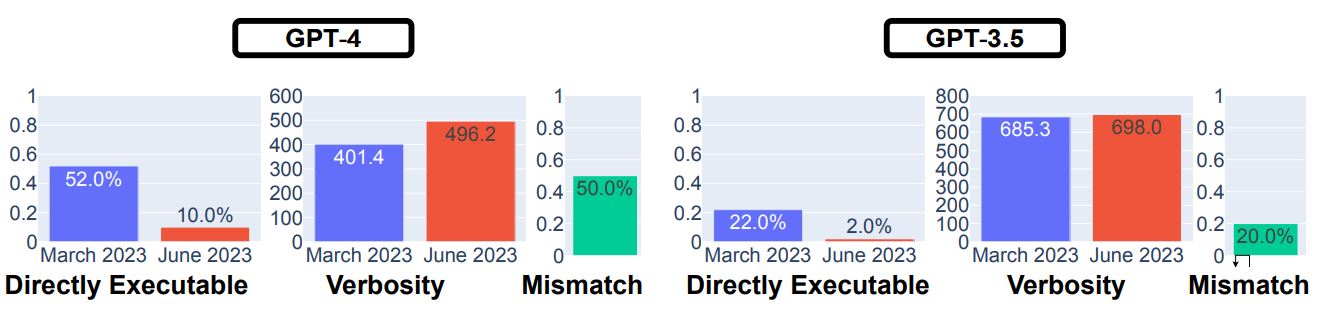

コード生成能力の調査については、研究チームは独自にデータセットを作成して実施しました。生成された回答は、アメリカのテック系企業が採用試験時のコーディング能力測定に使うコーディングプラットフォームLeetCodeの審査員に実行可能かどうか評価してもらいました。

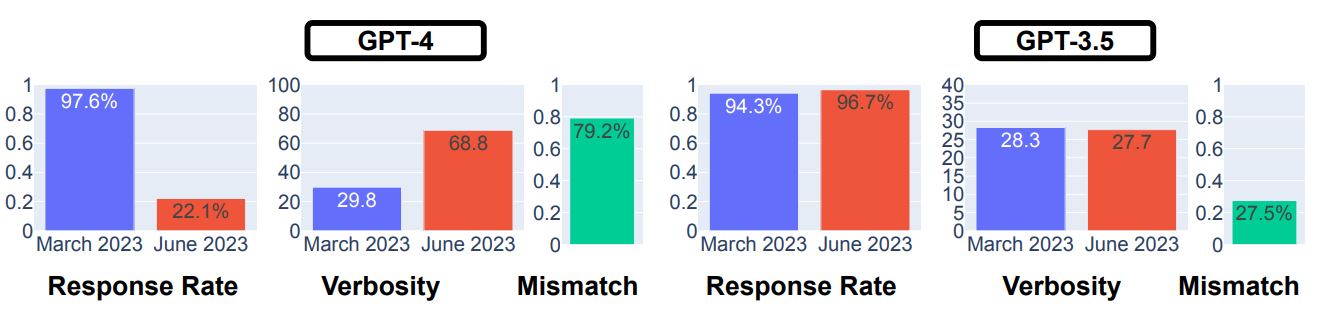

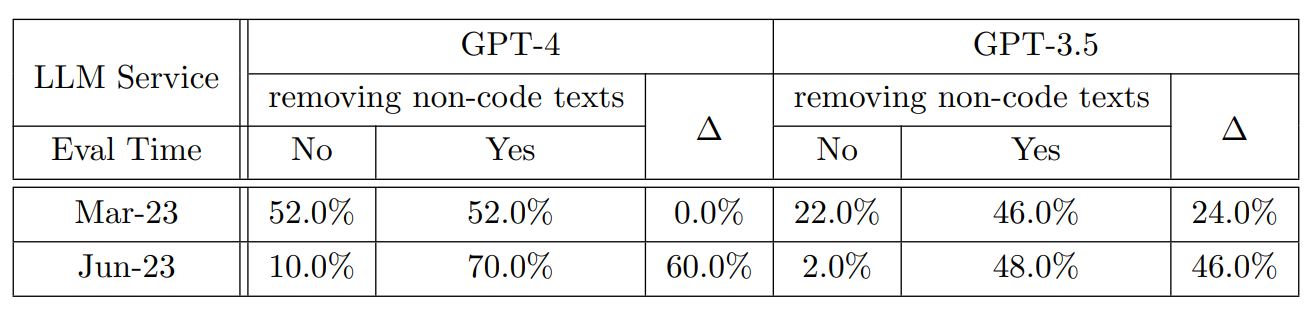

以上の調査の結果、GPT-3.5とGPT-4の両方で性能劣化が認められ、とくにGPT-4の実行可能率は、3月版の52.0%から6月版の10.0%に低下してます。

GPT-4とGPT-3.5を対象としたコード生成の回答結果。画像出典:論文

6月版になってコードの実行可能性が低下した理由として、コード以外のコメント等を生成するようになったことが挙げられます。そこでコード以外のテキスト部分を削除したうえで再評価してもらったところ、実行可能性が大きく向上しました。それゆえ、6月版ではコードの実行から見れば余計なテキストが生成されていた、と言えます。

GPT-4とGPT-3.5を対象としたコード生成の回答結果でコメントの有無に着目した比較。画像出典:論文

質問6)高度な推論問題

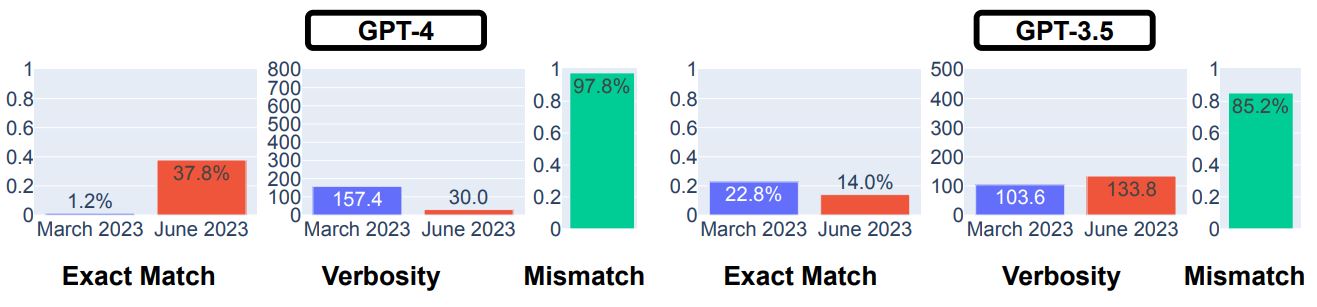

大規模言語モデルを活用するプラグインやエージェントは、複雑な推論が必要な質問に対して、Wikipediaを検索したりして回答できます。こうした複雑な推論問題の解決能力を調査するために、LangChainが提供するLangChain HotpotQAエージェントを活用して出力された回答を調査しました。調査の結果、出力された回答が期待される回答と完全一致する完全一致率は、GPT-4については3月版が1.2%に対して6月版では37.8%と大きく向上しました。対してGPT-3.5の完全一致率は、微減しています。

GPT-4とGPT-3.5を対象とした高度な推論の回答結果。画像出典:論文

6月版GPT-4の完全一致率が向上した理由は、同AIが3月版よりLangChainエージェントを適切に制御できたからと考えられます。6月版は、同エージェントが処理しやすいプロンプトを送信していたことが確認できたのです。

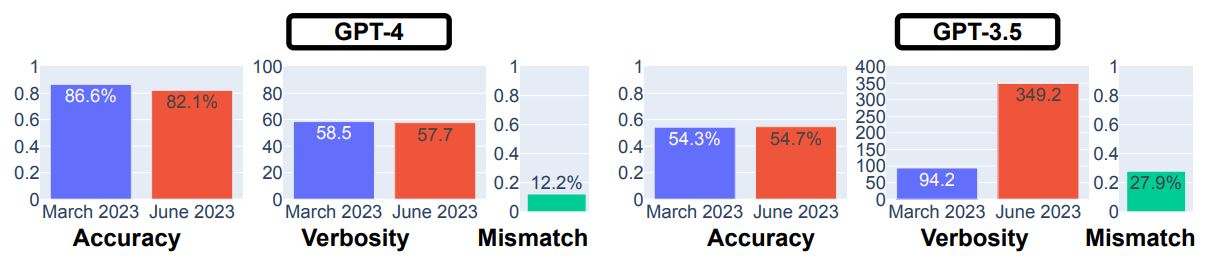

質問7)アメリカ医学資格試験

USMLE(United States Medical Licensing Examination:合衆国医学資格試験)も出題してみました。GPT-4については、3月版と比べて6月版で正答率が微減した一方で、GPT-3.5では正答率が微増しました。注目すべきは、GPT-3.5では回答の冗長性が激増したことです。こうした変化に伴って、GPT-3.5の回答不一致率は27.9%となり、GPT-4の12.2%に比べて大きな値となっています。

GPT-4とGPT-3.5を対象としたアメリカ医学資格試験の回答結果。画像出典:論文

質問8)視覚的推論

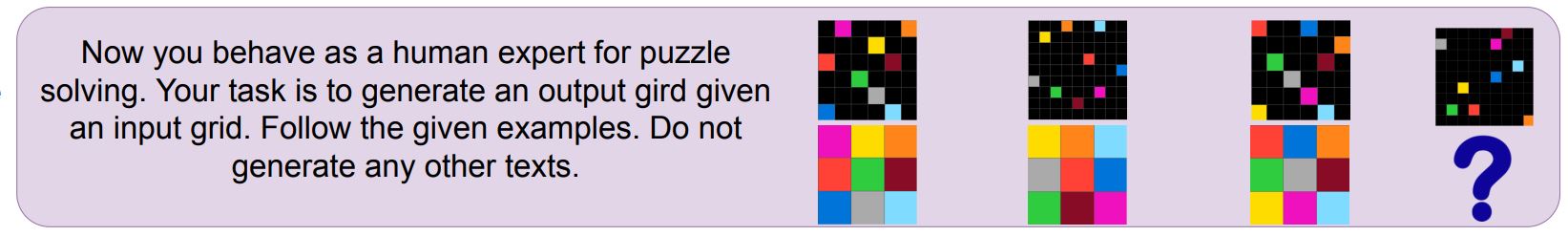

複数の着色されたグリッドのペアが複数与えられたうえで、ペアの一方を入力として渡してペアの他方を出力する、という視覚的推論に関する調査も実施しました。データセットには視覚的推論の能力測定で多用されるARCデータセットを使いました。ただし、大規模言語モデルにグリッド情報を渡す際には2次元行列化しました。調査の結果は、GPT-3.5とGPT-4の両方において性能向上が確認できました。ただし、不一致率が高いことから、3月版では正解できたが6月版では不正解だった問題が多数あることもわかります。

視覚的推論の事例。出題プロンプトには「さて、あなたはパズルを解く人間の専門家として振る舞います。あなたの仕事は、入力グリッドが与えられたら、出力グリッドを生成することです。与えられた例に従ってください。他のテキストを生成しないでください。」と書かれている。画像出典:論文

GPT-4とGPT-3.5を対象とした視覚的推論の回答結果。画像出典:論文

以上の調査から、GPT-3.5とGPT-4の性能は経年劣化しているとは言い切れません。しかしながら、経年変化しているのは事実なので、今後も定期的な性能調査が不可欠だと言えます。

Stack OverFlowの回答で比較

疑問2については、アメリカ・パデュー大学の研究チームが2023年8月4日、「どちらが良い?ChatGPTとStack Overflowのソフトウェアエンジニアリングに関する質問への回答の徹底分析」と題した論文を発表しました。この論文は、ソフトウェアエンジニアリングに関する質問について、ChatGPTが出力した回答とStack Overflow(以下、「SO」と略記)に掲載されている人間が作成した回答を、正確性や一貫性といったさまざまな観点から評価したものです。評価観点は8項目設けられ、それらの評価結果をまとめると以下の表のようになります。

|

評価観点 |

評価結果 |

| ChatGPTの回答は、SOのそれとどのように正しさと質が違うのか。 | ChatGPTの回答はより不正確で、かなり長く、人間の回答とは半分も一致しないものも、非常に包括的。 |

| ChatGPTの回答の品質には、どのような問題があるのか。 | ChatGPTが質問の根本的な文脈を理解できないため、多くの答えが不正解だが、概念的な間違いに比べて事実誤認が少ない。 |

| SOの質問の種類は、ChatGPTの回答の質に影響を与えるのか。 | 古くて人気のある投稿に対する回答は不正解が少なく正確である一方で、 デバッグの回答は一貫性に欠けるが冗長ではない。 |

| ChatGPTの回答とSOのそれは、言語構造や特徴が異なるのか。 | SOの回答に比べ、ChatGPTのそれは形式的かつ分析的であり、目標達成への努力を示し、否定的な感情を示さない。 |

| ChatGPTの回答の根底にある感情は、SOのそれとは異なるのか。 | ChatGPTの回答はSOのそれに比べ、有意にポジティブな感情を表している。 |

| ユーザは、ChatGPTと人間の回答を区別できるのか。 | 80.75%の確率でChatGPTの回答とSOのそれを正しく区別できる。 |

| ユーザは、ChatGPTの回答から誤った情報を特定できるのか。 | ChatGPTの回答にある誤情報は、39.34%の確率で特定できる。 |

| ユーザは、SOの回答よりChatGPTのそれを好むのか。 | 65.18%の評価者が、SOの回答よりChatGPTの回答を好んだ。 |

以上の評価結果は、以下のような手法によって導出されました。

|

以下では、各評価手法に関して解説します。

517の回答について特徴をラベル付け

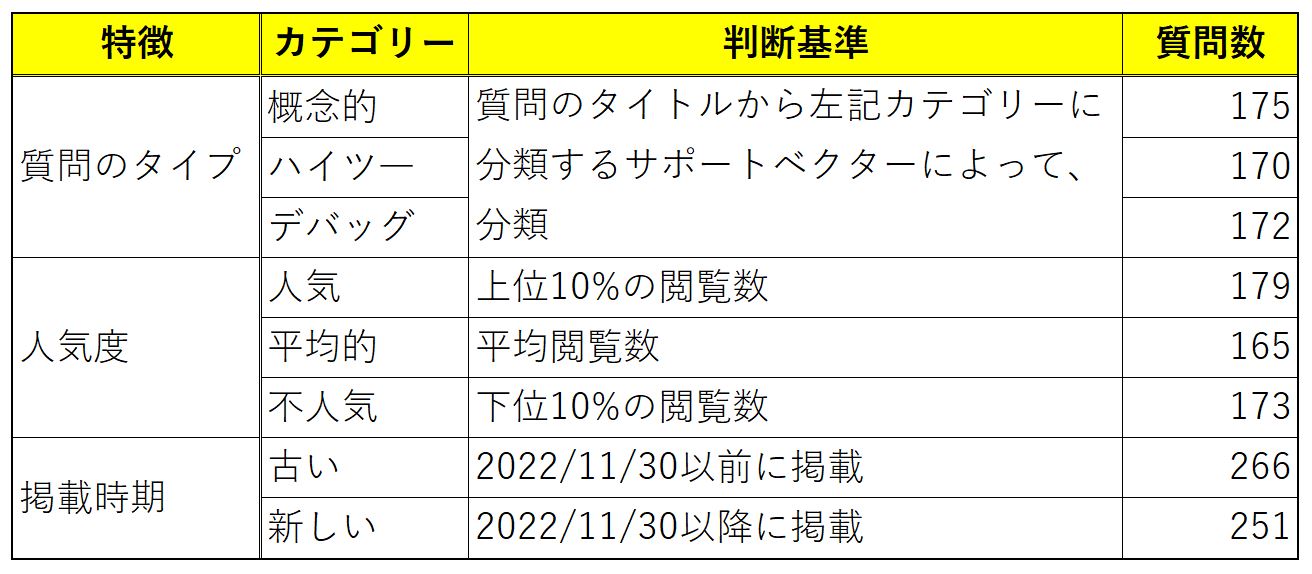

評価結果1~3については、内容のタイプ、人気度、投稿時期の観点からバランスがとれるように517のSOの回答を収集しました。そうした回答と各特徴の関係は、以下の表のようにまとめられます。

収集したSOの質問の属性と質問数に関する表。画像出典:論文にもとづいて記事著者が作成

以上の回答に対応する質問をChatGPTに質問し、ChatGPTの回答を得ました。その回答に対して、人間の評価者が正確性、一貫性、包括性、簡潔性という観点からYesあるいはNoのラベルを付与しました。ChatGPTの回答における特徴と観点の関係をまとめると、以下の表のようになります。

ChatGPTが生成した回答を4つの観点から評価した結果をまとめた表。着色された項目は、統計的に優位な関係を意味する。画像出典:論文にもとづいて記事著者が作成

評価結果1~3は、以上のような回答の収集とラベル付けによって導出されました。

2000の回答についてLIWCを実施

評価結果4と5は、2000のSOの回答とそれに対応するChatGPTの回答を用意したうえで、すべての回答について心理学的言語テストツールのLIWCを実施しました。LIWC実施後、SOのテスト結果集計とChatGPTのそれについて、各言語属性の出現頻度に関する相対的差異を算出しました。算出結果は、以下の表のようにまとめられます。

LIWCの実施結果をChatGPTとSOで比較。「*」は統計的に有意な差であることを意味する。「*」はp-value<0.05、「**」はp-value<0.01、「***」はp-value<0.001。画像出典:論文にもとづいて記事著者が作成

この表は、例えば「言語スタイル」における「分析的」な特徴が、ChatGPTの回答が20.65%の割合でSOのそれより多く出現している、と解釈します。マイナスの数値は、SOの回答のほうが当該の言語特徴が出現していることを意味しています。なお、ドライブ属性とは何かを達成する必要性、願望、努力に関連する表現を指しています。

評価結果4と5は、以上の言語分析を簡潔にまとめたものです。

12人の評価者にアンケートを実施

評価結果6~8は、12人の人間の評価者にChatGPTとSOの回答を評価してもらった結果にもとづいています。12人のうち男性が9人、女性は3人であり、4名はSTEMあるいはコンピュータサイエンスの学部生、1名は企業に属するソフトウェアエンジニアでした。

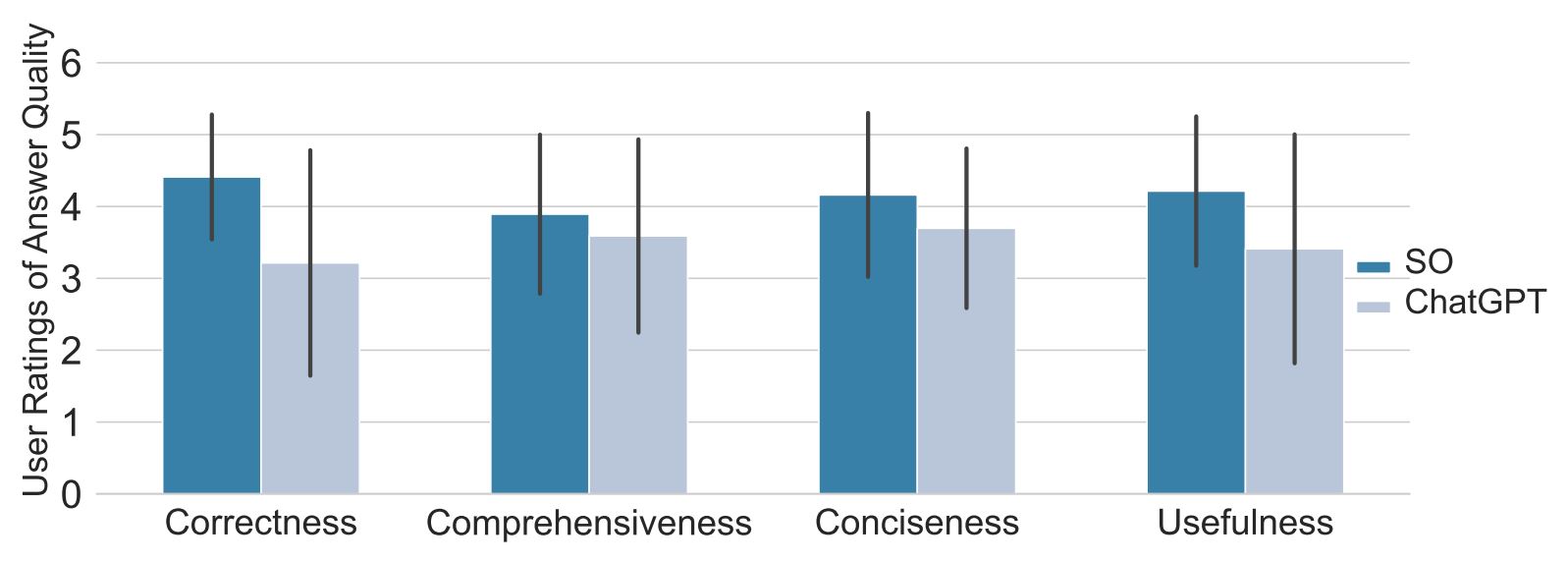

以上の評価者は8つのChatGPTの回答とSOのそれについて(つまり合計で16問)、アンケートに答えました。ChatGPTの回答のうち5つは不正解であり、3つは正解でした。アンケートでは回答を正確性、包括性、簡潔性、有用性の観点から5段階評価するものがありました。この設問の回答は、以下のグラフのように集計されました。

4つの観点における5段階評価の平均を比較したグラフ。左から「正確性(Correctness)」「包括性(Comprehensiveness)」「簡潔性(Conciseness)」「有用性(Usefulness)」。画像出典:論文

最後に評価者に対して半構造化インタビュー(※注釈3)を行い、評価者に回答の内容とそのように答えた理由を確認しました。こうしたアンケート結果とインタビューにもとづいて導き出されたのが、評価結果6~8でした。

人間は見た目のよいAI生成回答にだまされる

以上の調査をうけて、パデュー大学の研究チームは論文結論部でいくつかの論点を挙げています。そうした論点のなかで注目すべきなのは、「人間は見た目のよいAI生成回答にだまされる」というものです。調査により34.82%の確率でChatGPTの回答が好まれることが判明しましたが、そのうちの77.27%は不正解な回答でした。間違いであるにもかかわらず好まれるChatGPTの回答は、言葉遣いが丁寧で明瞭かつ包括的な表現と感じられたこともインタビューから判明しました。

論文はChatGPTの回答がどんなに正しく信頼できると思われても、ファクトチェックは不可欠なことを改めて強調しています。

言語モデルと政治の関係を可視化

疑問3については、アメリカ・ワシントン大学らの研究チームが2023年5月15日、「事前学習データから言語モデル、そして下流タスクへ:不公平な自然言語処理モデルにつながる政治的バイアスの軌跡を追う」と題した論文を発表しました。この論文は、言語モデルと政治の関係をさまざまな調査から明らかにしたものです。実施された調査には、以下のような3つがあります。

|

以下では、以上の調査に関して解説します。

BERT系はGPT系より権威主義的

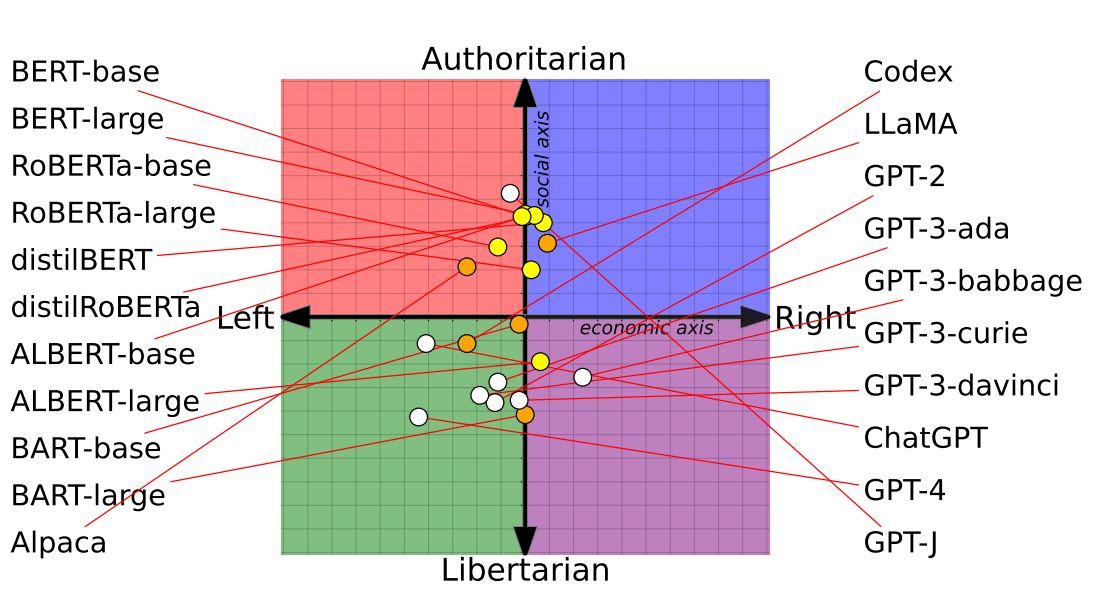

最初の調査は、主要な言語モデルに対して政治経済的ポジションを特定するアンケートとして有名なPolitical Compass Testを実施するというものです。このアンケートに答えると、回答者の政治経済的ポジションを2軸の座標軸にプロットできます。この調査の結果は、以下のグラフのようになります。

各言語モデルのPolitical Compass Test実施結果を座標軸にプロット。画像出典:論文

グラフのx軸は経済的ポジションを表しており、左側ほど左派的つまりはリベラルであり、右側ほど右派つまりは保守的であることを意味します。y軸が政治的ポジションを表しており、上方ほど権威主義的つまりは独裁的な政治的ポジションであり、下方ほど自由主義的つまりは民主主義的であることを意味します。

論文では、アンケート結果から以下のようなことを読み取っています。

|

トランプ大統領就任後、党派性が先鋭化

2つ目の調査は、以下のような手順で行いました。

|

以上のような手順を実施した結果は、以下のグラフ群のように表せます。

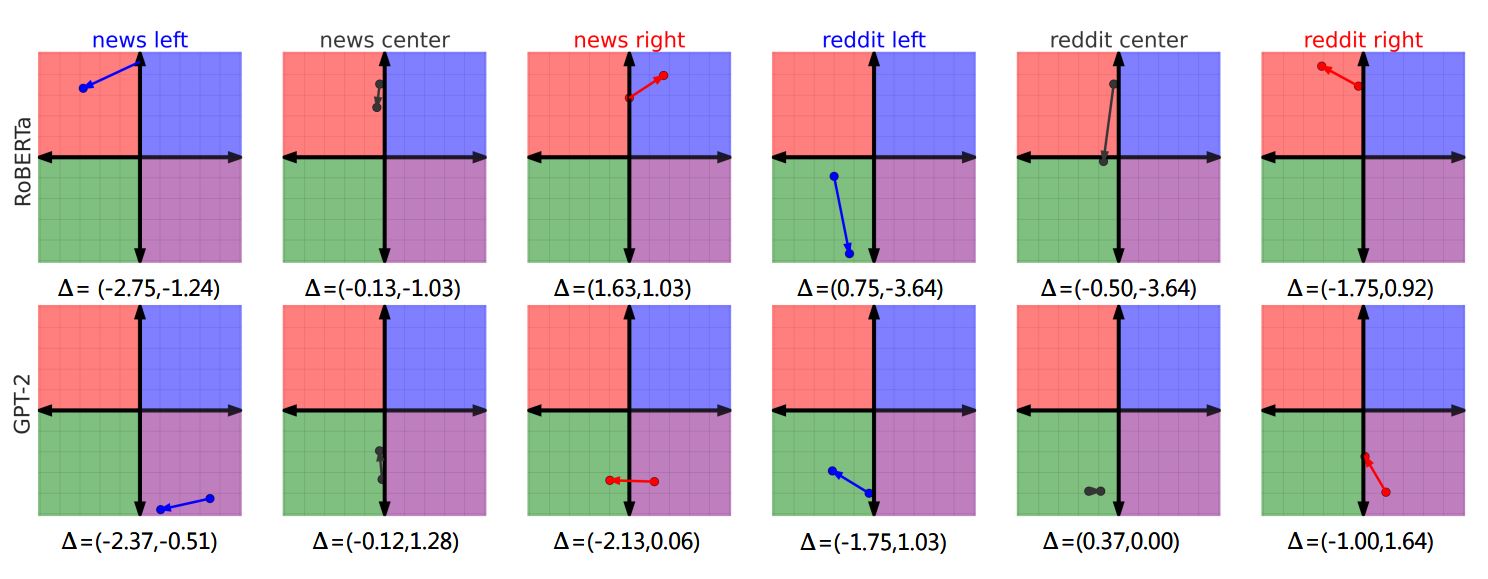

各党派のデータセットで訓練した後にRoBERTaとGPT-2の党派性をプロット。左からニュース記事をソースとした左派、中道、右派、redditをソースとした左派、中道、右派。画像出典:論文

以上のグラフから以下のような2つのことがわかります。

|

対立メディアには厳しく、身内メディアには甘い

3つ目の調査は、以下のような手順で行いました。

|

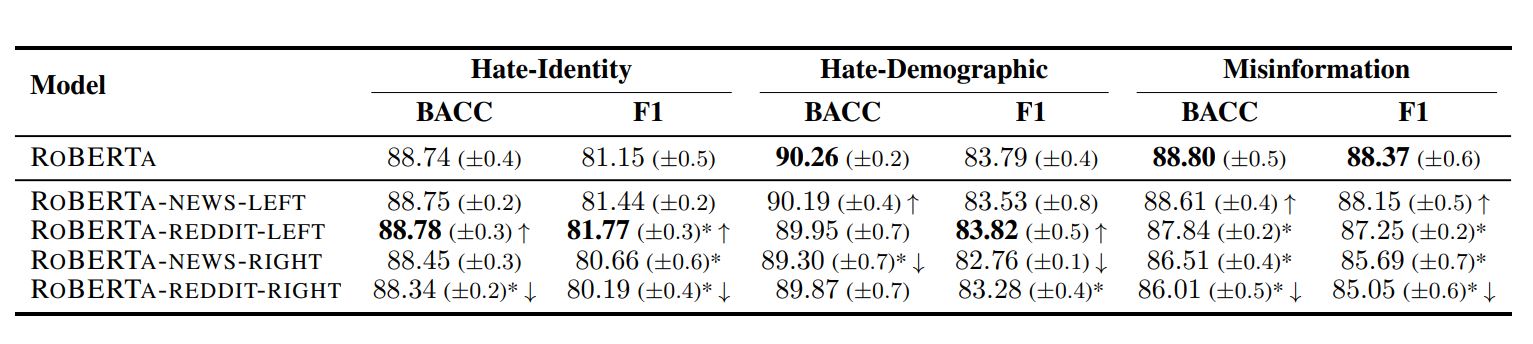

手順2の測定結果をまとめると、以下の表のようになります。もっとも測定値の良い調査項目は、太字となっています。この表から、左派的RoBERTaが右派的なそれより高性能であることがわかります。また、右派的redditから学習した場合が、もっとも性能が低下することもわかります。なお、表中のBACCはBalanced Accuracy(バランス正答率)(※注釈4)を意味します。

各党派の学習データで訓練したRoBERTaとヘイト表現および誤情報の検出率の関係。画像出典:論文

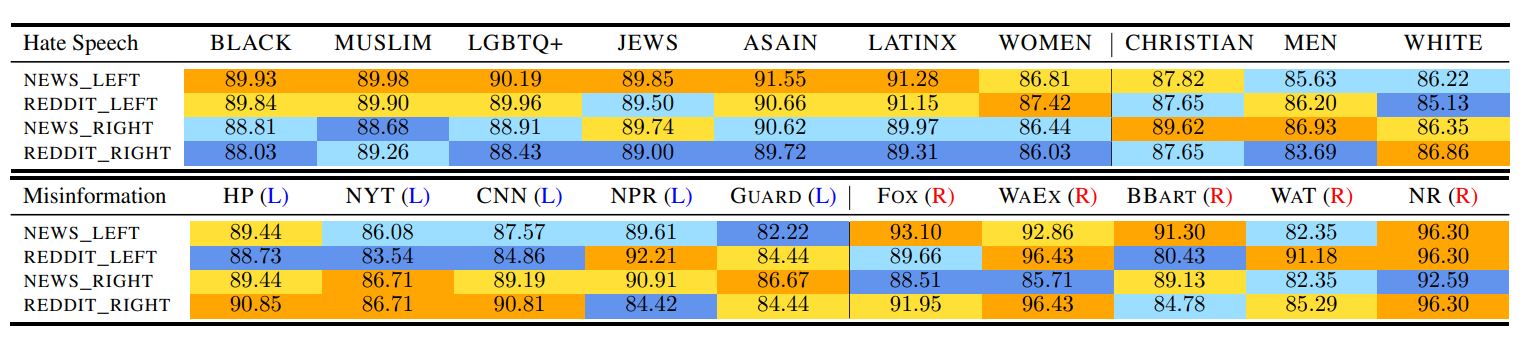

手順3の結果は、以下の表の上部のようになります(※注釈5)。調査項目のうち濃い黄色が塗られたものは、検出カテゴリーでもっとも良い検出率であり、反対に濃い青色はもっとも低い検出率であることをしめしています。左派的な言語モデルが右派的なそれよりヘイトスピーチに敏感であることがわかります。対して右派的な言語モデルは、男性や白人といったアメリカにおける支配的なグループのヘイトスピーチに敏感です。

各党派の学習データで訓練したRoBERTaとヘイト表現および誤情報の検出率をアイデンティティグループとメディアに着目して比較。画像出典:論文

手順4の結果は、以下の表の下部の通りです(※注釈6)。調査結果より左派的言語モデルは右派的メディアの誤情報に敏感ですが、左派的メディアのそれには相対的に鈍感なことがわかります。対して右派的言語モデルは、左派的言語モデルと逆の結果となりました。この結果は「対立メディアには厳しく、身内メディアには甘い」ことを示しています。

余談ですが、以上に解説した論文は自然言語処理に関する世界的カンファレンスACLの2023年大会において、ベスト論文のひとつに選ばれました。

まとめ

以上に解説した3本の論文から、言語モデルに関して以下のようなことがわかります。

|

以上のような研究成果から言えることは、ChatGPTをはじめとした大規模言語モデルは常に正しいわけではなく、生成された回答を重要な判断材料にする場合は、正しいと思われてもファクトチェックを怠らない、ということでしょう。また、政治経済的な質問については大規模言語モデルは党派性を持った回答を生成するので、そうした党派性を考慮したうえで回答を活用すべきでしょう。

記事執筆:吉本 幸記(AINOW翻訳記事担当)

編集:おざけん