Googleは2024年2月8日、同社の最上位AIモデルUltra1.0で駆動するGemini Advancedを発表しました。同AIをリリース前に評価したAIの専門家によれば、同AIはGPT-4と同等の性能だが得意分野に違いがある、と述べています。対して一部の一般ユーザは、同AIはGPT-4に明らかに劣っていると評価しています。

一部の一般ユーザがGemini Advancedを低評価する理由として、ロメロ氏は以下のような4つを挙げています。

一部の一般ユーザがGemini Advancedを低評価する4つの理由

|

以上のような理由を挙げたうえで、Gemini Advancedの信頼できる評価が揃ったら、同AIについて改めて論じる、とロメロ氏は述べています。

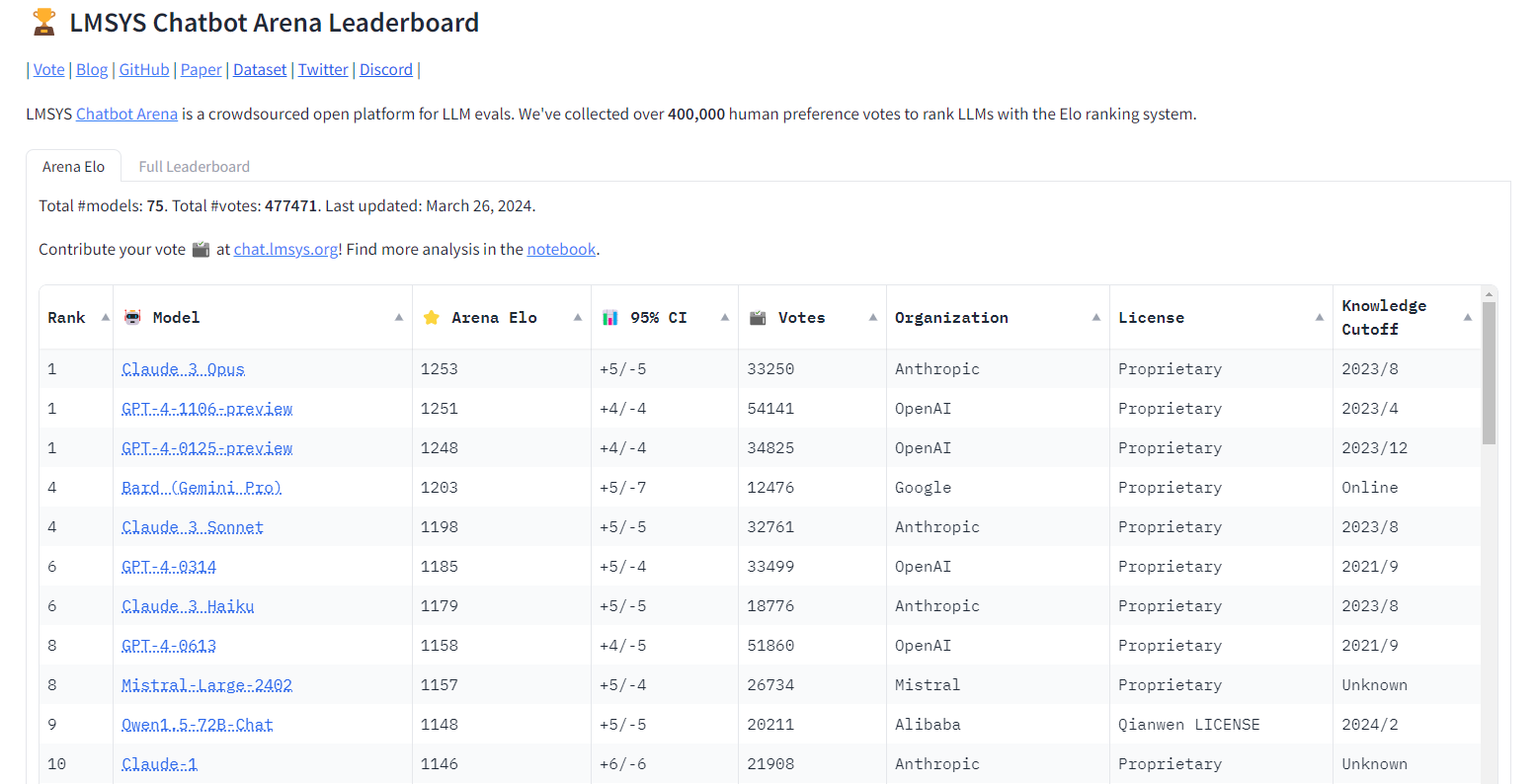

ちなみに以下の記事本文で言及されている著名なLLMベンチマークのひとつであるチャットボットアリーナ(Chatbot Arena)では、2024年3月26日更新時点において、Claude 3 Opus(最上位モデル)とGPT-4の最新モデル2種がほぼ同成績で1位、4位にGemini Proがランクインしており、Gemini Advancedのスコアはまだ算出されていません。

2024年3月26日更新時点のチャットボットアリーナ・ランキング

なお、以下の記事本文はアルベルト・ロメロ氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、日本語の文章として読み易くするために、意訳やコンテクストを明確にするための補足を行っています。

Gemini Advancedの2つの顔

GPT-4レベルだという人がいる。深く失望している人もいる。誰が正しいのだろうか?

この記事は、AIと人間の橋渡しをする教育プロジェクトThe Algorithmic Bridgeからの抜粋です。

・・・

GoogleはGemini Ultraを発表した。また、BardをGeminiにブランド変更した。Gemini UltraはUltra 1.0(言語モデル)になった。Bard AdvancedはGemini Advanced(チャットボット)となった。

以下は、リリースを見逃した読者のために、公式情報を簡単にまとめたものである。

Gemini Advancedの料金は月額19.99ドル(GPT-4やChatGPTとほぼ同様)で、最初の2ヶ月間は無料である。2ヶ月という期間は、徹底的にテストして気に入るかどうかを決めるには十分すぎる時間だ(ここから試してみてほしい)。無料のGemini Proにこだわることもできる。

GeminiはGoogle Oneからも利用できる。このサブスクリプションには、ストレージやGmail、Docs、SheetsなどのGoogleのサービス(以前はDuet AIとして知られていた)とのシームレスな統合(近日公開予定)といった他の特典も含まれている。同社の目標は、自社の最高のAIを広く使われているサービスと統合し、OpenAIに対抗することだ。

Gemini AdvancedにはAndroid版(Googleアシスタントを通じてオプトインすれば、その方法でチャットボットにアクセスできる)があり、iOS用のアプリとしても提供されている。150カ国で英語版がリリースされている(※訳注1)。

Googleのブログ投稿によると、Gemini Advancedは「第三者評価者によるブラインド評価において」優先的に選択された、とのこと。この評価方法はLMSysが運営するチャットボットアリーナに似ているが(※訳注2)、評価において重要な部分である透明性がない。GPT-4と同様にGemini Advancedはマルチモーダルであり、データ分析機能を持ち、Gemini Proと比較して推論が改善されている。

Geminiユーザのあいだの奇妙なコントラスト

以上は、Googleの発表から直接引用した客観的な部分である。Geminiの動作の主観的な概要については、イーサン・モリック(Ethan Mollick)氏のノートから見られる(※訳注3)。

モリック氏はGemini Advancedの早期アクセス権を与えられ、6週間にわたってテストし、プロンプトの設定やタスクのカテゴリーについてGPT-4と比較した(これまでのところ、彼はマルチモダリティやコードではなく、Geminiの言語能力と推論能力について書いている)。

彼の最初の結論は、彼のノートとジェミニ自体からも、何を期待すべきかのヒントを与えてくれるにちがいない。そのノートには「Gemini Advancedは明らかにGPT-4クラスのモデルだ」とある。同時に「Gemini Advancedは、ベンチマークでGPT-4を明らかに圧倒しているわけではない」とも言われている。

モリック氏は、この冷静な発言を裏付ける多くの例を紹介している。いくつかの事例では、Geminiの方が優れている場合もある。その一方で、GPT-4が優れている場合もある。彼は両者を比較することで、GPT-4クラスのモデルが一般的にどのような能力を持つかについての洞察を得られ、またそれぞれのモデルの性能は際立っており、タスクによってはモデルごとに異なる強みを発揮する、と主張している。

GPT-4はコードを使うことに関してより洗練されており、また多くの難しい言語的なタスクをよりよくこなす。それはより良いセスティーナ(※訳注4)を書き、リンゴを数えるテストに合格する。対してGeminiは説明が得意で、画像と検索をうまく統合している。

彼は、両方のモデルに改善の余地があることを強調している。どちらのシステムも私たちが許せる以上に失敗し、まだ幻覚を見ている。興味深いことに、両者には明確な個性がありながら、プロンプトレベルでは互換性が保たれているという。こうした結果を彼は次のように喩えている。GPT-4とGeminiは似ているようで別物である。その違いは、ちょうど性格は異なるが同じように賢明な2人の人間のようだ。

彼の結論は、Geminiに限ったものではない。

GeminiはGoogleが本当にAI競争に参加していること、そしてOpenAI以外の企業もGPT-4クラスのモデルを構築できることを示している。そして、今ではAIについて以前は知らなかったことがわかった。先進的なLLMは、プロンプトや回答について基本的な共通点を示す可能性があり、そうした共通点があることで人々はいつでも簡単に古いモデルから最先端のAIに切り替えられる。加えてGPT-4の「閃き」はOpenAIに限ったことではなく、モデルの規模が大きくなればよく起こることかもしれない。

私はモリック氏のレビューを信頼している。彼は他の多くの人よりも厳格に評価したうえに、6週間かけて以上のような考察を導き出している。彼は(Googleが何度か主張しているように)Gemini AdvancedがGPT-4より明らかに優れているとは言っていないが、同じようなレベルにあると述べている。

しかし、Gemini Advancedが(課金すれば)誰でも使えるようになった今、奇妙に対照的な姿が浮かび上がってきた。Googleの最も強力なチャットボットを手で触れた(そしてプロンプトを入力した)ユーザは、モリック氏と同じ結論には達していないようだ。

Gemini Advancedに対する一般的な認識を解明するための逸話的証拠を探して、いくつかのソーシャルメディアプラットフォームをスクロールしてみたが、そうして得られた私の結論はモリック氏と同じくらい単純だが、正反対の感情だった。

一般ユーザは、Gemini Advancedに非常に失望しているのだ。

次のコメントは(redditスレッドの)r/Singularityのユーザのものである 。「GPT-4と比較しながら遊んでみたが、全般的にGPT-4の方がはるかに正確で、知識ベースもはるかに大きく、幻覚もあまり見ないようだ」。 Xアカウント名dotCSVのスペイン人AI系インフルエンサーのカルロス・サンタナ(Carlos Santana)氏は、Gemini AdvancedはChatGPTが正しく回答する羽毛に関する重量テストにいかに失敗しているかを示している(こちらは重量テストの異なるバージョン)(※訳注5)。別のRedditorはGeminiがリンゴを数えるテストに失敗し、ChatGPTが正解する様子を示している(※訳注6)。GPT-3.5は鏡文字に関する推論テストに正解するが、Geminiは正解しない(※訳注7)。もしかしたら他の比較事例も見たいだろうか(※訳注8)。例えばじゃんけんをするとか(※訳注9)。

まだまだある。探し始めてからほんの数時間しか経っていないのに、RedditやXはGemini AdvancedとGPT-4の比較で埋め尽くされているのがわかった。この結果から、2つの解釈が可能である。 ひとつは「まだ数時間しか経っていない、もっと時間をかけろ」、もうひとつは「まだ数時間しか経っていない、どうしてもうこんなにGemini Advancedが悪く言われるのだ」。

Gemini Advancedを手放しで称賛しているのはモリック氏だけではない。フランソワ・ショレ(François Chollet)氏(Googlerであることからバイアスがあることは認めるが)は次のように語っている。「しばらくの間、コーディングのヘルプにGemini Advancedを使っているのだが、本当にいい」。公の場でこのようなことを言っても、試したものが本物のGemini Advancedでなければ意味がないので、彼のバイアスのある意見は無視してもいいだろう。今なら、このツールを自分で試すことができるのだから。

では、何が起こっているのか。モリックやチョレ、あるいはGoogleが語るストーリーとカジュアルユーザとのあいだにこれほど顕著な食い違いがあるのは、なぜだろうか。

| ユーザ:今日、トミーはリンゴを2個持っています。昨日トミーはリンゴを1個食べました。トミーはリンゴをいくつ持っていますか。 |

Gemini:トミーは1個のリンゴを持っています。その理由は以下の通りです。

|

同様の質問をChatGPTに入力すると、以下のような回答が出力される。

| ChatGPT:もしトミーが今日リンゴを2個持っていて、昨日リンゴを1個食べたという情報があったとしても、それは今日のリンゴの数には影響しません。ですから、トミーは今日もリンゴを2個持っています。 |

同様の質問をPerplexity AI proに尋ねたところ、該当のシーン画像を添付したうえで第6シーズン第8話の「43の特殊性」と回答した。

海外ドラマ『ビッグバン★セオリー ギークなボクらの恋愛法則』に関するGemini AdovancedとPerplexity AI proの回答比較

Gemini AI advanced Vs Perplexity AI pro.

Hi @madebygoogle step up pic.twitter.com/kLyiUaJB74

— Raven (@MINTENCODES) February 8, 2024

以上の質問について、Gemini Advancedはもっともらしいが誤っている理由を回答するのに対して、ChatGPTはAIの手がわかっているのだから同教授が勝つのは当たり前、と正しく回答した。

謎を解くかもしれないいくつかの仮説

言語モデルとチャットボットの評価は難しい。従来のベンチマークはブラインドリーダーボードアリーナとは違うし、6週間の非公式テストとも違うし、数時間にわたって試す意図的にトリッキーなプロンプトとも違う。

ベンチマーク的には、Ultra版Geminiは32タスク中30タスクでGPT-4を上回ったとされている(※訳注10)。この数字は、Googleのヴァイス・プレジデントでGeminiエクスペリエンス担当ジェネラル・マネージャーであるシシー・シャオ(Sissie Hsiao)氏が、本日(すなわち記事公開日の2024年2月9日)LinkedIn News Tech Stackのインタビューで繰り返したものだ。モリック氏によると、GPT-4とGemini Advancedは性能的には似ているが、性格的には異なるという。自分の認識を公にしているユーザのほとんどは、Geminiの回答の質の低さに非常に失望している。(LMSysのチャットボットアリーナにはGemini UltraのELOスコアはまだ出ていない。このスコアは結論を出すための重要なデータポイントになるだろう。)

さまざまな評価が混在する山からは、ひとつの結論を導きようがない!

この対立を説明するのに役立ちそうな仮説をいくつか挙げてみよう。もっともこの記事ではあまり詳しくは述べない。より多くの証拠を得たら、またこの話題に戻るつもりだ。以下の仮説は証拠とは整合するが、決定的なものにはほど遠いものとして扱ってほしい。

- GPT-4はトリッキーなテストにも対応できる。私が今日読んだほとんどのユーザは、モデルの能力を比較するための「頼りになる」質問を持っていると主張している。GPT-4は1.5年前のものなので、OpenAIが数カ月にわたる絶え間ないファインチューニングのあいだに、そのような問題を解決したとしても驚くことではない。ソーシャルメディア上で苦情があれば、同社は特定の問題にパッチを当ててきたことは以前からよく知られている。こうしたやり口は批判されるようなものではない。このやり口に関して、彼らはその場しのぎであることに自覚的だ。それでも改修は良いことである。そうは言っても、この対処は誤解を招く可能性がある。というのも、彼らは特定の事例を解決しているが、(そうした事例を引き起こす)より深い原因を解決していないからだ。おそらくGoogleはOpenAIと同じ改修をしておらず、それがGeminiの悪いパフォーマンスに反映されている。

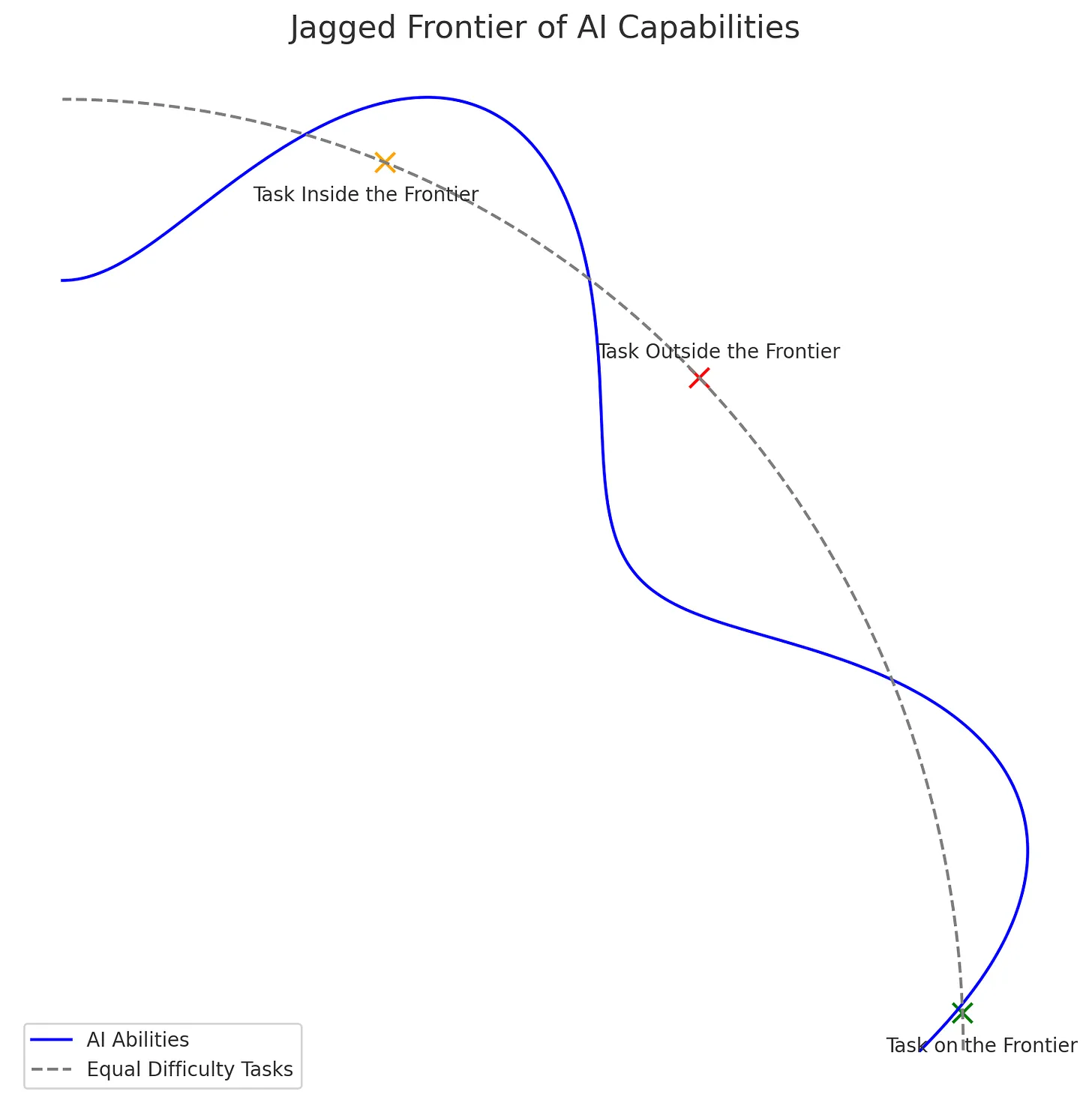

- Geminiは推論が苦手で、それがユーザの目にとまっている。ユーザははじめに推論タスクでチャットボットを評価する傾向がある。推論は、人間にとって他の知的タスクより難しいと感じるからだ。モリック氏が述べたように、Geminiは特定の分野ではGPT-4よりも劣っているが、典型的にテストされる他の分野では劣っていない。これは、同氏が数ヶ月前に概念化した、ギザギザの境界線の一部かもしれない(※訳注11)。そのギザギザは、彼が意図したように人間とAIのあいだだけでなく、GPT-4とGeminiのような同じカテゴリーのAIのあいだにも現れるかもしれない。

- ユーザは、反Googleバイアスから最悪の結果だけを公表している。現在、同社について決まりが悪いと感じてしまう不信感がある。実のところ、この不信感は決まりが悪いというよりは、不当だと感じられるものである。同社は私たちにGeminiのデモを披露したが、それはかなり編集されていた(※訳注12)。OpenAIがGoogleより決定的に優れているわけではないのにそんな編集をしたので、Googleを決まりが悪いと感じてしまう。サム・アルトマンはGPTシリーズの優位性について意図的に混乱させるようなメッセージを発しているのだが(※訳注13)、ユーザはGPT-4が時間の経過とともに遅延が生じていると常に不満を漏らしている。GoogleとOpenAIに対する人々の感情の違いは、単純にOpenAIの方がユーザからのフィードバックに対して反応がいいということだと思う。対してGoogleはより不透明かつ不浸透とユーザに感じられる。その結果、Geminiが何か間違いを犯すたびに、隠していた反感が再浮上する。

- Geminiがうまくいっていると思っているユーザは、ネットでわめいたりしない。これはおそらく、最も単純な説明だろう。ソーシャルメディアは現実世界を反映していない。オンラインの感情をチェックして得られるイメージは、オフラインの現実とは大きく異なることがある。おそらくGeminiはほとんどのユーザにとって問題なく機能しているが、そんなユーザはこのAIについてXに投稿しようとはしない。それゆえ、ネットに残るのは、Geminiの不満足な行動だけを反映した非常に偏ったイメージである。

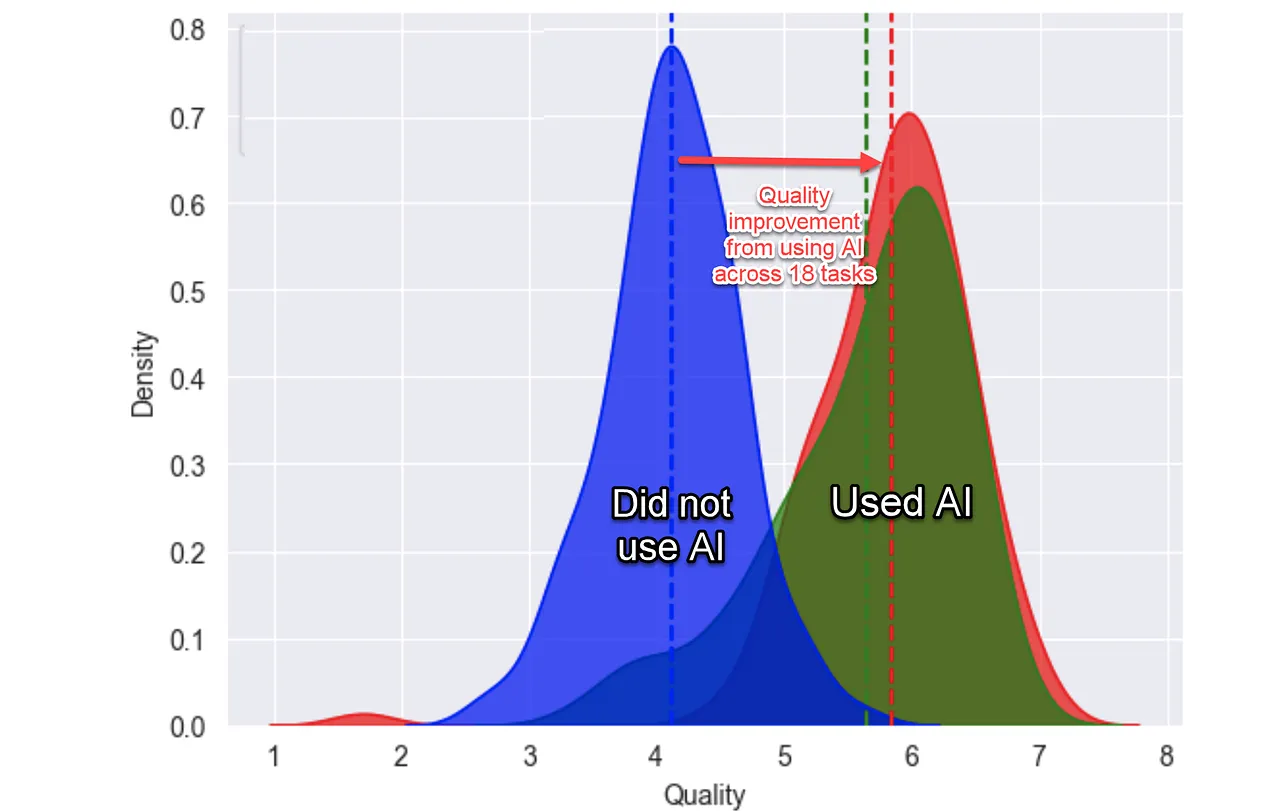

BCG社員を対象としたGPT-4使用比較実験結果

調査でわかったことのなかには、コンサルティング業務におけるAIの得手不得手は、直感的には理解できないことがある。人間が直感的に同じくらいの難易度と感じるタスクを円上に並べた場合、AIの得手不得手はその円の内側(得意タスク)と外側(不得意タスク)をギザギザにプロットできる。こうした事態をモリック氏は「ギザギザの境界線」と呼ぶ。

AIの得手不得手を図示した「ギザギザの境界線」

ギザギザの境界線は、GPT-4とGeminiでは異なるかもしれない。両者の得手不得手は同じ円の内側と外側にプロットされるが、その形状は異なっていると予想される。

今日はここまでだ。

本日リリースされたのでGemini Advancedに焦点を当てて書いたが、その評価が賛否両論なのはどのLLMやチャットボットにも当てはまる。賛否両論となるのは、それらを正しく評価するのは難しいからだ。以前にも述べたように、ベンチマークは信頼性に欠ける。また、逸話的証拠はあくまでも逸話的なものにとどまる。

LMSysのリーダーボードアリーナのような徹底的に厳密なテストは、ユーザのいちばんの味方である。Gemini Advancdがこのアリーナに登場しELOスコアが出れば、今までの不評が不当であったかどうかについて判断できるだろう。

原文

『How Good Is Google Gemini Advanced?』

著者

アルベルト・ロメロ(Alberto Romero)

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1、生成AIパスポート、JDLA Generative AI Test 2023 #2取得)

編集

おざけん