最終更新日:

CVPR(Computer Vision and Pattern Recognition:コンピュータビジョンとパターン認識)とは、物体検知や画像認識に関する世界的な学会のひとつです。2019年に開催された同学会のカンファレンスでは5,165本の論文が提出され、そのうち1,300本が採択されました。同氏は採択された論文のなかから現在の研究トレンドを代表していると思われる5本の論文を選び、その内容を解説しています。そうした論文は、以下のようなものです。

- カメラと被写体の両方が動く動画における深度評価の研究。学習データにマネキンチャレンジ動画を活用した。

- 動画内のオブジェクトを分割する方法を改善する研究。オブジェクトを分割する精度がもっとも高いコマを基準にするようにした。

- 手のかたちと姿勢を認識するモデルの研究。弱教師あり学習を使って学習データを生成した。

- 100種類以上のカテゴリーを認識するモデルの研究。アーキテクチャにナレッジグラフを導入した。

- 顔誤認攻撃対策に関する研究。13種類の顔誤認攻撃を認識・分類できるようにした。

以上の諸論文より、画像認識の研究トレンドはより複雑なタスクに応用される技術を探求する方向に向かっている、と言えるのではないでしょうか。

以下の前編にあたる記事本文では、CVPRの採択論文全体の傾向分析と上記論文のうち1本目と2本目を紹介します。

なお、以下の記事本文はPriya Dwivedi氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。

データを使ってクールなことを実行する!

IEEEの2019年カンファレンスにおけるコンピュータビジョンとパターン認識に関する分科会(CVPR)は今年の6月16日から20日まで開催された。CVPRはコンピュータビジョンの分野における世界トップレベルの3つの学術的カンファレンスのひとつである(残りふたつはICCVとECCV(※訳註1))。今年は最高記録となる5,165の論文の提出があり、そのうち1,300本が採択された(採択率は25.2%)。

ECCV(European Conference on Computer Vision:コンピュータビジョンに関するヨーロッパ・カンファレンス)とは、ICCVが開催されない年に開催されるコンピュータビジョンに関する国際的カンファレンス。2020年8月23日から28日にスコットランド・グラスゴーでECCV2020が開催される予定。

CVPRはコンピュータビジョンの分野に最高のアイデアをもたらし、毎年非常に印象深い多数の論文がある。

わたしはCVPRで採択された論文を集め、論文が論じている主な研究分野と論文タイトルで共通して使われているキーワードを理解するために分析を実行した。こうした分析は、研究分野がどこに移り変わっているのかを示していた。

分析に使ったデータとソースコードは、わたしのGitHubから利用できる。これらの情報は自由に引用することができ、それらに各々のひねりを加えることもできる。

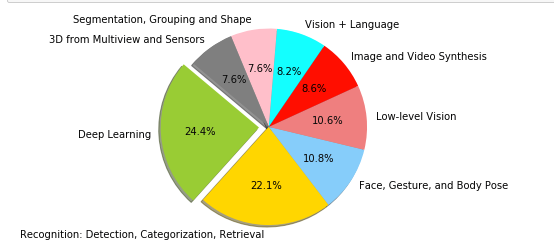

CVPRは、それぞれの論文に主要主題を割り当てている。採択された論文を主題が表す研究分野ごとに分類すると、以下のグラフのようになる。

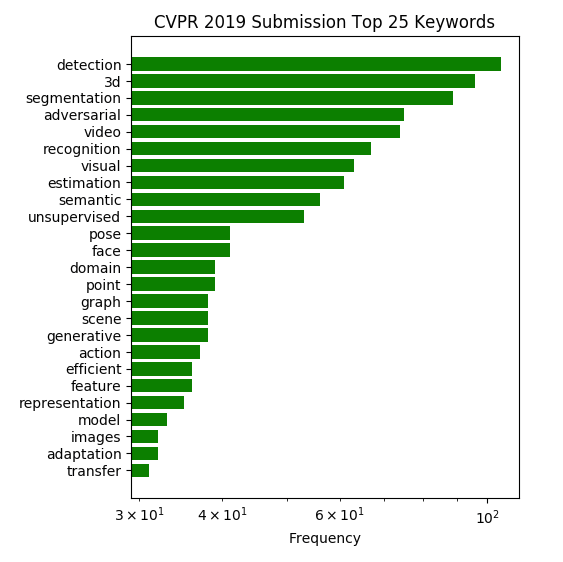

ほとんどの研究がディープラーニングに焦点を合わせていること(今でもすべての研究がディープラーニングというわけではない!)はまったく驚くに値せず、検知と分類が次に多く、そして顔認識/ジェスチャー/姿勢の研究が続く。こうした分類はきわめて概略的であり、有意義な考察を与えてくれるようなものではない。そこで続いて採択論文からすべての単語を抽出して、その出現頻度を数えてみた。共通して使われているキーワードのトップ25は、以下のグラフのようになる。

以上の分析は、最初の分析よりは興味深い。単語の出現頻度の分析からもっとも人気のある研究分野が検知、分割、3D、そして敵対的訓練であることがわかった。教師なし学習の方法論に関する研究も人気を伸ばしていることがわかった。

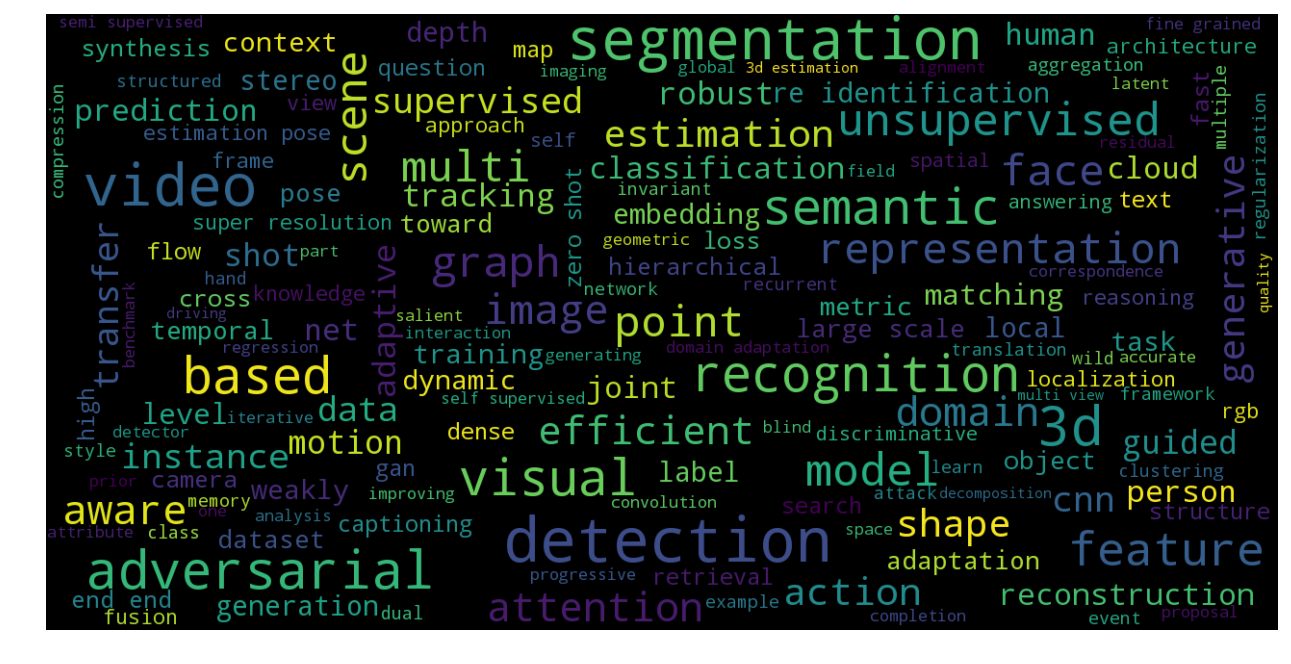

最終的に単語分析の結果をワードクラウド(※訳註2)にプロットしてみた。それが以下の画像だ。

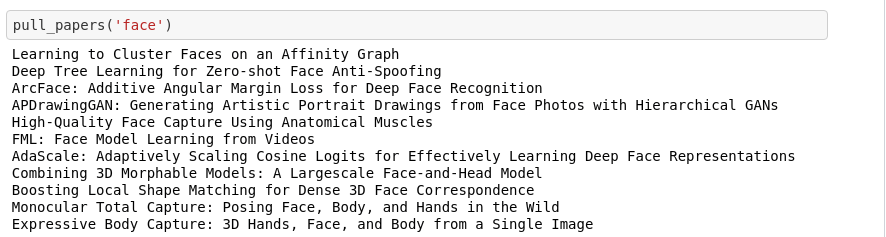

以下の示した画像のように採択された論文をトピックごとに抽出するために、わたしのGitHubのコードを使うことができる。

「顔」という単語で論文を検索するソースコード

わたしは機械学習に関するコンサルティングに従事している。わたしが務めている企業を調べるには、こちらのウェブサイトを見るとよい。わたしはコンピュータビジョンに関するプロジェクトで働くことが大好きだ。もし読者諸氏がわたしたちとコラボレーションするアイデアを持っているならば、どうぞご自由に企業のウェブサイトからコンタクトするか、info@deeplearninganalytics.orgにメールしてください。

ブログの以下の部分では、CVPRの主要な研究分野からわたしが選んだ興味深い5本の論文を紹介したい。選んだ論文はわたしにもっとも訴えるものがあった、ということに留意して頂きたい。

目次

1.静止したヒトを見ることによって動くヒトの深度を学習する

ヒトの視覚システムには、2次元的な投射から意味ある3次元的な世界を形成するという驚くべき能力が備わっている。複数の動くオブジェクトがあるような複雑な環境であっても、ヒトは幾何学と深度にもとづいた順序でオブジェクトを整合的に解釈し続けることができる。ここ数年、カメラ画像を使って深度を評価する研究が数多くなされたが、その多くの研究において堅牢な深度の再構成は困難なものに留まっている。カメラと被写体の両方が自由に動いているような時には、深度の再構成はとりわけ挑戦的なものとなる。こうした状況は、三角測量(※訳註3)にもとづいている3次元的に深度を再構成する伝統的なアルゴリズムを混乱させるのだ。

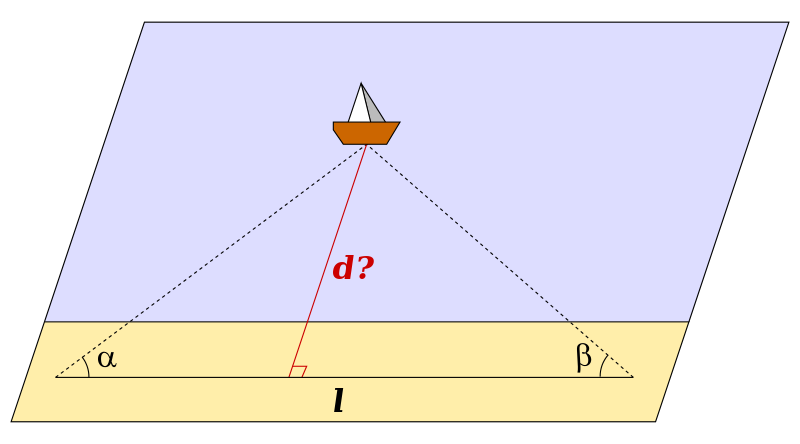

画像出典:wikipedia「三角測量」より引用[/caption]

画像出典:wikipedia「三角測量」より引用[/caption]

画像の深度とシーンごとの深度評価についてさらに知りたい場合は、このブログをチェックして欲しい。

わたしが選んだ論文は、深度の再構成問題をカメラと被写体の両方が自由に動くシーンにもとづいたディープラーニングモデルを構築することによって解決している。以下のGIFアニメを見ると解決する様子がわかる。

動くヒトの深度評価

以上のようなモデルを作成するには、画像のコマごとに正確な深度マップを付加する動くカメラによって撮影された、自然な光景に関するビデオシーケンスが必要とされる。こうしたデータセットを生成することは、ひとつの挑戦である。こうした挑戦に打ち勝つために、論文では既存のデータセットを革命的な方法で活用した。マネキンチャレンジに関するYouTube動画を活用したのだ。マネキンチャレンジとは、様々な自然なポーズをとって静止しているヒトビトがいるなかを動く手持ちカメラで撮影した動画である(※訳註4)。マネキンチャレンジ動画においてはシーン内の被写体は静止しておりカメラだけが動いているので、三角測量技術を使って正確な深度マップを構築できるのだ。この論文は非常に興味深く読める。複雑な問題を解決しており、なおかつ解決するために必要なデータセットを非常にクリエイティブに生成している。

#MannequinChallenge in a packed Rupp Arena? You bet. pic.twitter.com/dwWufwI8xm

— Kentucky Sports Video (@UKSportsVideo) November 7, 2016

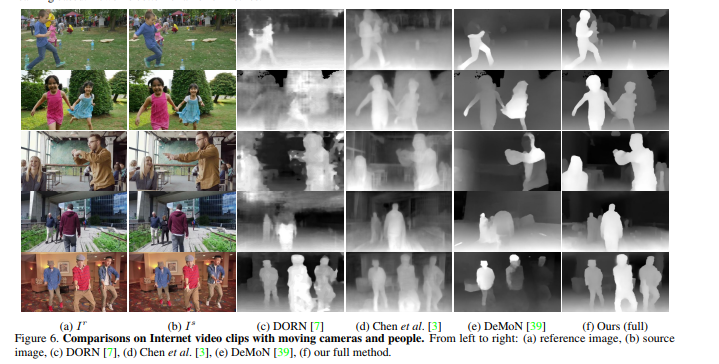

以上のようにして訓練したモデルをカメラとヒトがともに動いているインターネット上の動画に対して活用した時のパフォーマンスは、先行するどの研究よりも優れたものであった。そうした結果が以下の画像だ。

論文に掲載された深度評価モデルの比較。いちばん左が評価対象の動画の1コマ。いちばん右が上記論文で開発したモデル。オブジェクトの輪郭がもっとも明瞭なことから、もっとも精確に深度を予測していることがわかる。

こちらから論文の全文を読むことができる。

2.BubbleNets:ディープソーティングフレームによるビデオ・オブジェクト・セグメンテーションにおけるガイドとなるフレームを選択するための学習

いくつかの論文は、ビデオ・オブジェクト・セグメンテーション(VOS:Video object segmentation)を論じていた。VOSとは、最初のフレームに単一の注釈(アノテーション)が付けられた動画のなかにあるオブジェクトを分割するというタスクである。こうしたタスクは動画を解析するアプリのなかに見られ、昨年からさかんに研究されるようになった。

動画内のオブジェクトの位置と外観はフレームからフレームへと顕著に変化するのだが、以下のGIFアニメに見られるように、論文では(最初のフレームとは)異なったフレームの注釈を使うとパフォーマンスが劇的に変わることが伝えられている。

BubbleNetsの動画デモ

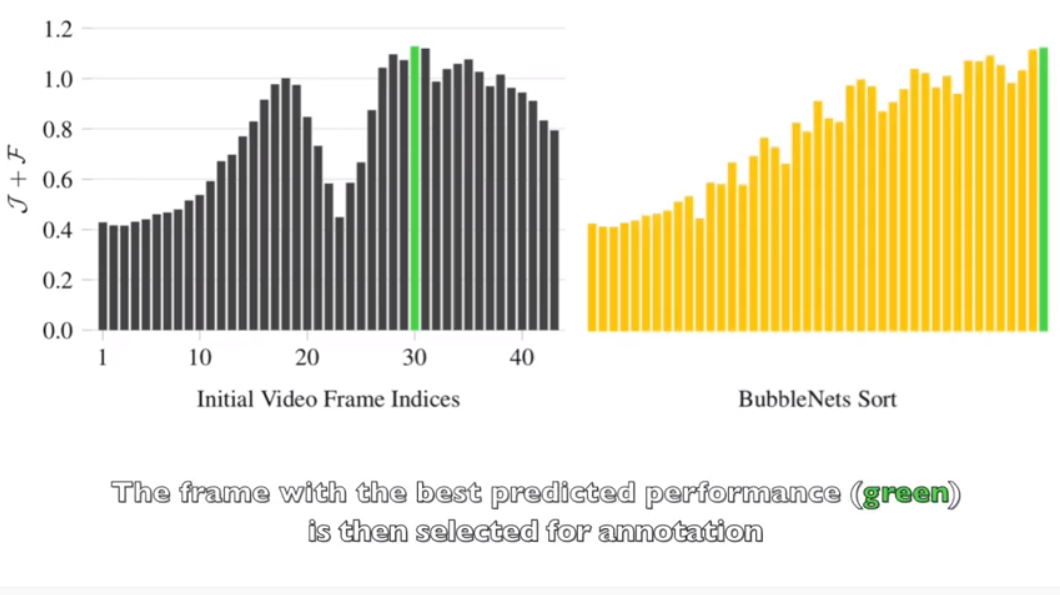

BubbleNetsは、注釈にもとづいてオブジェクトを指示する予測精度が最高ランクになるまで動画の隣接したコマを比較して入れ替える。予測精度が最高に達した時のフレームは、ユーザが注釈したりVOSを実行するために使われる。

BubbleNetsにおけるガイドとなるフレームの選択

このモデルを解説する動画はYouTubeでシェアされており、ソースコードはGitHubでオープンソースとなっている。

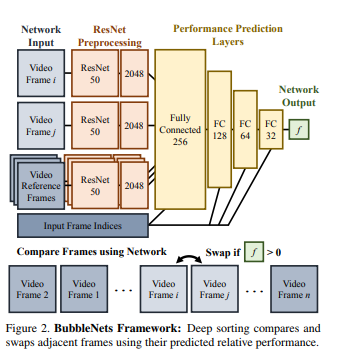

BubbleNetsは異なったふたつのフレームに関するそれぞれの相対的なパフォーマンスを予測するのに使われる。相対的なパフォーマンスは、オブジェクトを指定する領域の類似性とオブジェクトをかたどる輪郭の正確性を複合して測定される。

BubbleNetsにおいては入力データとして予測精度が比較される2つのフレームと3つの参照フレームが与えられる(※訳註5)。入力したフレームはResNet50と完全結合層を通り、2つのフレームの比較結果を表示した単一のf値が出力される。バブルソートを実行する際には最初の2つのフレームから始め、この2つを比較する。もしBubbleNetsが1番目のフレームを2番目のフレームよりパフォーマンスのよいものと予測したら、それらのフレームを入れ替える。そして入れ替わった次(つまり比較してパフォーマンスが良かった方)のフレームは、最高のパフォーマンスを示したベストなフレームと比較される。動画のシーケンス全体にわたって以上のような比較プロセスを最後のコマまで実行すると、最高のフレームが残る。下に示した図はBubbleNetsのアーキテクチャとバブルソートのプロセスを表している。

フレームは正規化すると予測精度が向上するが、その一方で計算が複雑になる。参照フレームの枚数を3つに設定すると、もっとも予測精度の向上と計算の複雑性が両立できる。

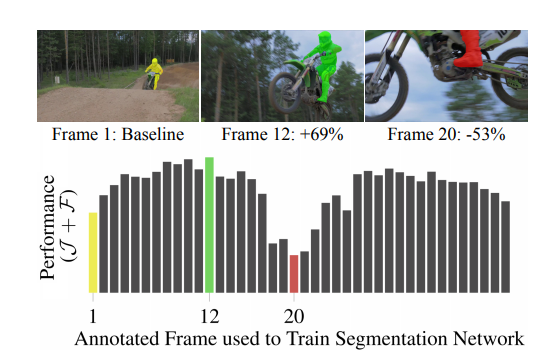

例えばオートバイを撮影した動画からオートバイを分割する場合、従来は動画の1コマ目を基準として各コマごとにオートバイを分割していた。しかし、1コマ目における予測精度がもっとも高いとは限らないので、予測精度が低いこともある(下の画像参照)。

画像出典:YouTube「BubbleNets: Learning to Select the Guidance Frame in Video Object Segmentation」より画像を抜粋[/caption]

画像出典:YouTube「BubbleNets: Learning to Select the Guidance Frame in Video Object Segmentation」より画像を抜粋[/caption]

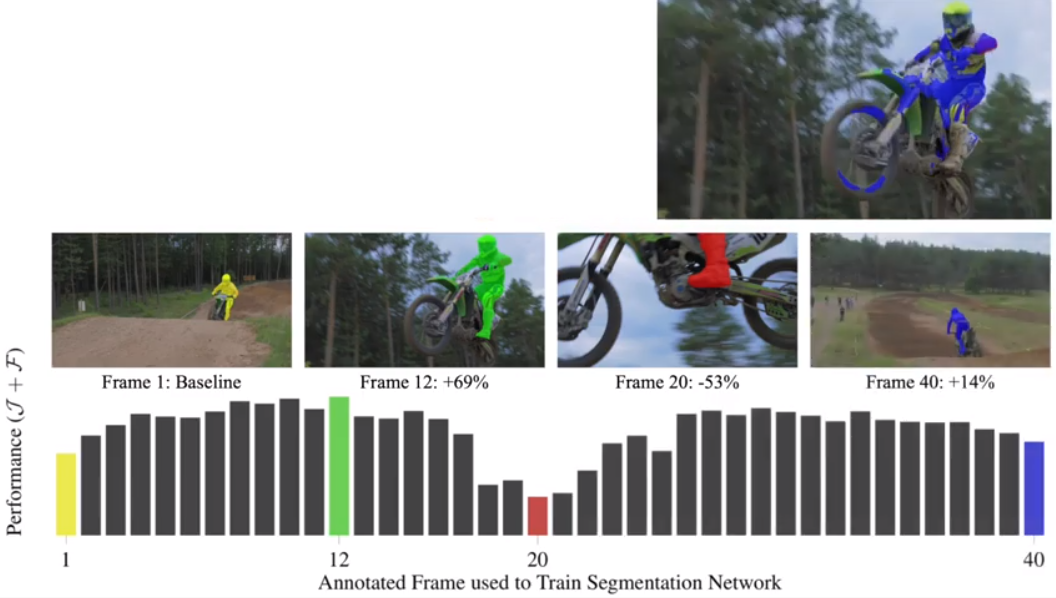

BubbleNetsでは、まずすべてのコマに関してオートバイのようなオブジェクトを分割する予測精度を算出する。オブジェクトを分割する予測精度がもっとも高くなるのは、もっとも高い予測精度のコマを基準のコマとした時である。こうした予測精度が最高なコマを検出するために、予測精度にしたがってコマを整列するのだ(下の画像の右側のグラフ参照)。整列する時に使われるアルゴリズムが、バブルソートである。

画像出典:YouTube「BubbleNets: Learning to Select the Guidance Frame in Video Object Segmentation」より画像を抜粋[/caption]

画像出典:YouTube「BubbleNets: Learning to Select the Guidance Frame in Video Object Segmentation」より画像を抜粋[/caption]

著者は、(オブジェクトを分割する)元々のセグメンテーション・アルゴリズムを変えずに注釈の基準となるフレームを選ぶ方法を変えた場合、DAVISベンチマーク・データセット(※訳註7)で測定したパフォーマンスが11%良くなったことを論文で示している。

BubbleNetsのアーキテクチャ

(後編に続く…)

原文

『Latest Computer Vision Trends from CVPR 2019』

著者

Priya Dwivedi

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん