最終更新日:

画像生成:記事著者による

はじめに

画像生成AIの普及は、絵を描くスキルに乏しい人が画像を作れるようにする「画像制作の民主化」をもたらしただけではなく、既存アーティストに対する著作権侵害の疑いという問題も引き起こしました。こうしたネガティブな側面のうち最たるものが、有害なフェイク画像の生成です。そこで本稿ではフェイク画像をめぐる現状を確認したうえで、大手テック企業の技術的対策、そして選挙における欺瞞的AI利用に対する政治的取り組みを紹介します。

なお、本稿の内容は見出し「サマリー」に要約しています。

サマリー

以下では、本稿における見出しごとの要点を箇条書きで列挙します。

テイラー・スウィフトのフェイク画像事件の顛末

|

暗躍するフェイク画像闇市場

|

大手テック企業のフェイク画像対策

|

フェイク画像に対する政治的取り組み

|

まとめ

|

テイラー・スウィフトのフェイク画像事件の顛末

瞬く間に数百万のユーザに拡散

2024年1月26日、世界的なアメリカ人シンガーソングライターのテイラー・スウィフトの性的に露骨なフェイク画像がSNSで拡散している、とアメリカ大手メディアCBSなどが報じました。同メディアの記事によると、ディープフェイクを監視する団体Reality Defenderの責任者であるメイソン・アレン(Mason Allen)氏は「残念なことに、SNSのいくつかが問題に対処するまでに何百万、何千万というユーザにフェイク画像が広まってしまいました」と事態の深刻さを語りました。

以上の事態をうけて、アメリカ映画俳優組合は「本人の同意なしで偽の画像(特に淫らな性質のもの)を開発し、広めることは違法とされなければならない」という声明を発表しました。

Xは26日、この問題に関する声明をポストしました。その内容は、同意のないヌード画像のポストは厳しく禁止されており、そのようなポストを発見次第、直ちに削除するというものでした。また、不適切なポストを行うアカウントには「適切な措置」を講じる、とも書かれていました。

アメリカ政府も反応する事態に

テック系メディアThe Vergeは2024年1月28日、テイラー・スウィフト画像問題に関する各SNSの対応をまとめた記事を公開しました。Xでは以上の声明発表と前後して、テイラー・スウィフトに関連したキーワードを検索すると、「問題が発生しました。リロードを試してください」というメッセージを表示するようになりました。Threadsやinstagramで問題のキーワードを検索した場合には、「危険な組織や個人の活動と関連しています」というメッセージが表示されることがありました。

テイラー・スウィフト関連のキーワードを検索した際のX画面。画像出典:The Verge

テイラー・スウィフト関連のキーワードを検索した際のThreads画面。画像出典:The Verge

この問題は、ついにアメリカ政府をも動かすことになりました。2024年1月26日にホワイトハウスで開催された報道関係者向け会見では、テイラー・スウィフト画像問題に関連して、AIが生成した有害画像に対して政府は何らかの取り組みを行っているのか、という記者からの質問がありました。この質問に対して、カリーヌ・ジャン-ピエール(Karine Jean-Pierre)報道官は、2023年の秋に24時間365日対応のオンライン・ハラスメントのためのヘルプラインを開設したと述べました。さらに、今後フェイクコンテンツに関する立法措置を講じるとも発言しました。

事態が沈静化しつつあった2024年2月5日、CBSはテイラー・スウィフトのフェイク画像の由来について報じました。この問題を調査した調査会社Graphikaによると、問題の画像は英語圏の掲示板サイト4chanから拡散した、とのこと。そして、同掲示板のスレッドのひとつでは、DALL-Eをはじめとする画像生成AIのガードレールを回避して有害な画像を生成できるかどうか、一部のユーザがゲーム感覚で試行錯誤していた、とも報告しています。

今後フェイクコンテンツに対する対策や法整備が進んだとしても、そうした取り組みを無効化する手口が速やかに考案されると予想できます。

暗躍するフェイク画像闇市場

被害者はテイラー・スウィフトだけではない

実のところ、テイラー・スウィフトのフェイクコンテンツが拡散したのは、以上の一件が最初ではありません。2024年1月16日にCBSが報じたところによると、彼女が調理器具メーカーのル・クルーゼの製品を宣伝するのを装ったディープフェイク動画が拡散しました。この動画では彼女が同製品を3,000個無料でプレゼントすると発言していますが、この内容は全くの虚偽でした。

ル・クルーゼ製品を宣伝するテイラー・スウィフトのディープフェイク動画。画像出典:CBS

オンラインELLE日本版が2024年2月4日に公開した記事では、ハリウッドのセレブリティを標的としたディープフェイク動画をまとめています。例えばトム・ハンクスは、2023年秋にデンタルプラン(歯科医療に限定されたローンサービス)を宣伝するディープフェイク動画に無断利用されました。その後、彼は公式Instagramに問題の動画が偽物であることを知らせる投稿を行いました。

同じく2023年秋、「Lisa AI: 90s Yearbook & Avatar」という画像生成アプリを宣伝するXのポストに、スカーレット・ヨハンソンのAIアバターが無断で使われていました。この事態に対して、彼女は同アプリを開発するトルコ企業を提訴しました。問題のポストは削除されましたが、類似の事件は今後も起こるでしょう。

不正生成手段を提供する闇市場

前出のGraphikaは2023年12月8日、同意を得ずに生成された脱衣画像を意味する合成非同意親密画像(synthetic non-consensual intimate imagery:以下、頭文字をとって「合成NCII」と略記)の実態を調査したレポートを公開しました。

合成NCIIを入手するには、ユーザ自身がセーフガードのない画像生成モデルを構築するか、合成NCII生成のためにカスタマイズされたモデルにアクセスする必要があります。後者のような画像生成モデルを提供するのが、合成NCIIプロバイダーです。これらのプロバイダーが提供するサービスを活用すれば、セレブリティのみならず一般人の合成NCIIを容易に生成でき、また生成された違法画像を取引できます。こうしたサービスは現在では市場を形成しており、Webトラフィック分析会社Similarwebが提供したデータによると、Graphikaが特定した34の合成NCIIプロバイダーのグループに対して、2023年9月には2,400万ものユニークユーザがアクセスしていました。

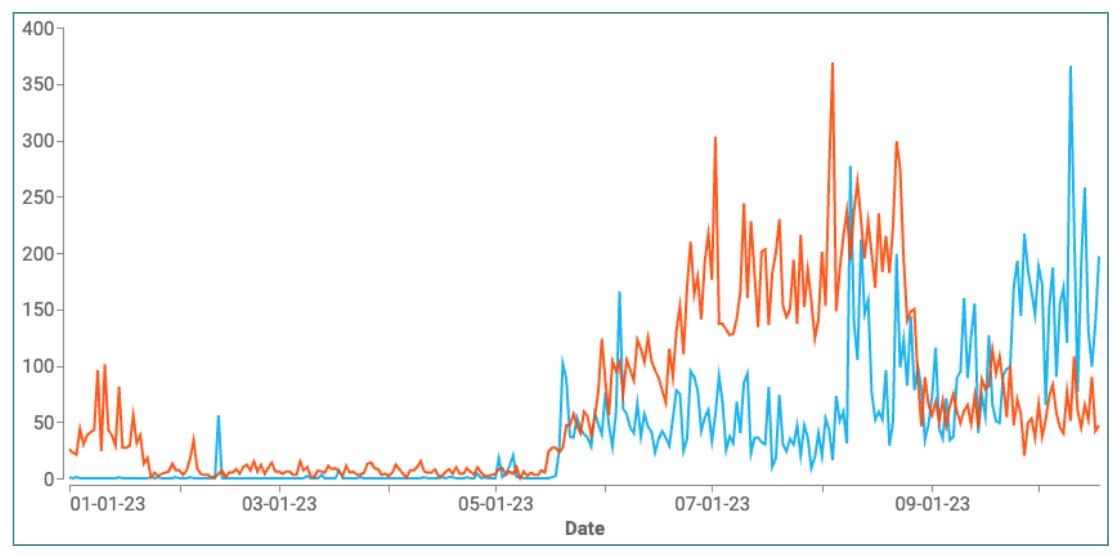

合成NCIIプロバイダーがユーザを獲得する主な手段は、自社サービスサイトに引き込むためのリンクを紹介するスパムの拡散です。Graphikaはマーケティング会社Meltwater提供のデータにもとづいて、合成NCIIを扱う34のWebサイトと52のTelegramチャンネルに対する参照リンクを含むReddit(英語圏最大級の掲示板サイト)とXのコメントと投稿の数を調査しました。その結果を時系列で可視化したのが、以下のグラフです。オレンジがReddit、青がXにおける問題のコメントと投稿の合計を表していますが、2022年には1,280件だったのに対して、2023年には32,100件と前年比2,408%と爆増しています。

合成NCIIプロバイダーサイトへのリンクを含むRedditとXのコメントと投稿の推移。画像出典:Graphika

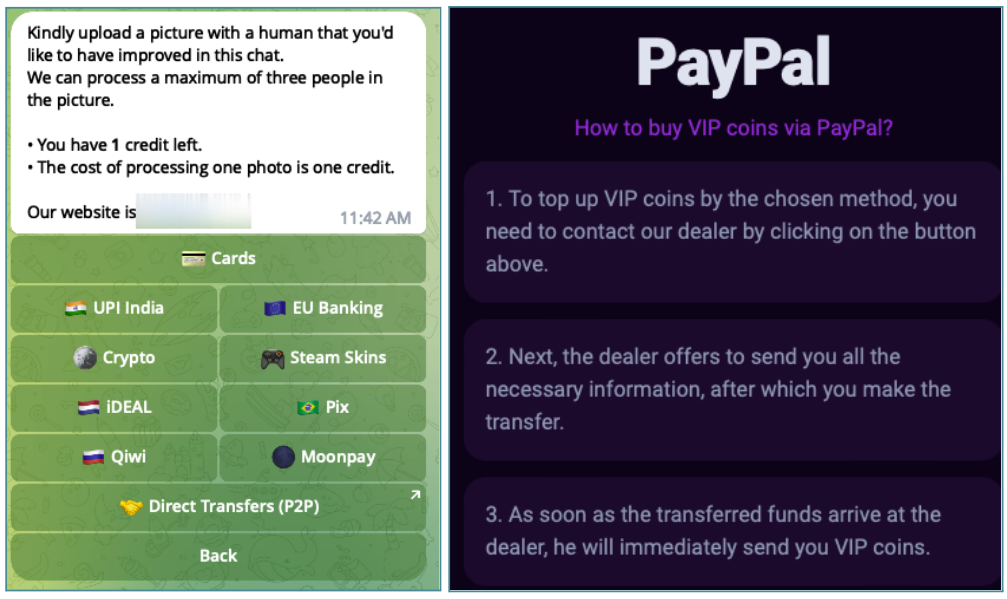

紹介リンクなどを介してアクセスした初めてのユーザに対して、多くの合成NCIIプロバイダーは少数の合成NCII生成を無料で提供するフリーミアムモデルを採用しています。そして、有料サービスとして高画質の合成NCIIのエクスポート、「年齢」や「身体特性」といった属性をカスタマイズした生成、画像の一部を置き換える機能などを提供しています。こうしたサービスには1クレジット当たり1.99ドル、あるいは追加機能のアンロックに299ドルが求められます。

有料サービスの支払いには、PayPalや各種クレジットカード、あるいは暗号通貨が利用されます。クレジットカード会社による不正決済の検出を回避するために、Patreonのようなクラウドファンディングプラットフォームなどの購読を隠れ蓑にする手口があります。また、ユーザどうしが合成NCIIを直接売買できるマーケットプレイスを提供するプロバイダーも存在します。

合成NCIIサービスの支払い画面。画像出典:Graphika

多くの合成NCIIプロバイダーは、ユーザが容易にアクセスできるシングルサインオンを採用しています。こうしたユーザフレンドリーなUXを提供することで、違法な画像生成への心理的敷居を下げているのです。

大手テック企業のフェイク画像対策

生成AIへの信頼を損なうフェイク画像に対して、大手テック企業はそれぞれ独自の対策を行っています。以下にそうした対策をまとめます。

OpenAIによるC2PAの付与

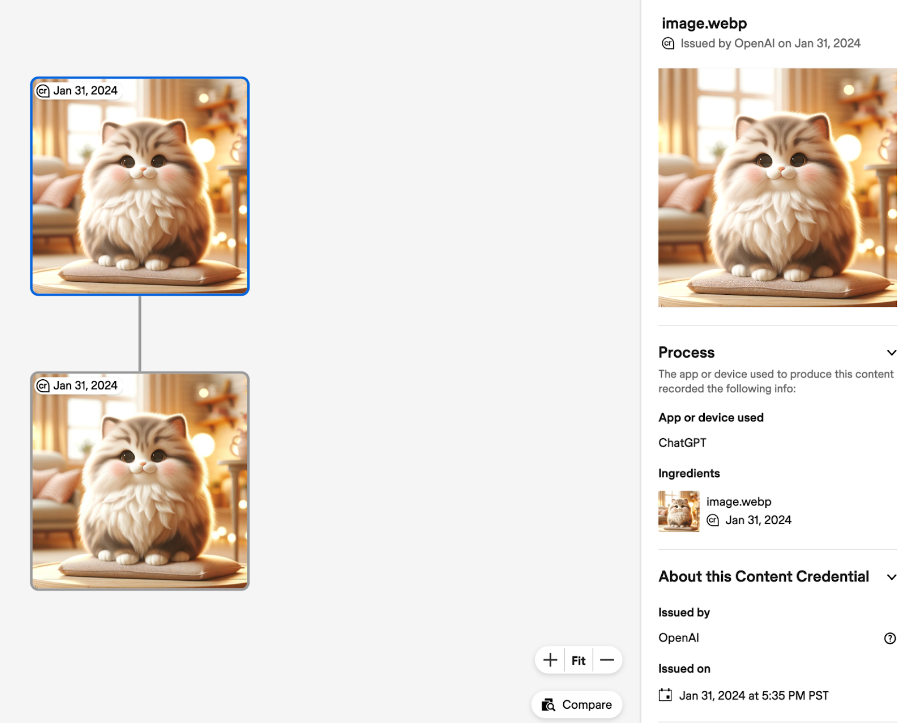

OpenAIは2024年2月7日、ChatGPTあるいはOpenAI APIによって生成された画像に、C2PAを付与することをXにポストしました。C2PA(Coalition for Content Provenance and Authenticity:コンテンツの証明性と真正性のための連合)とは、デジタルメディアの出処と履歴を証明するシステムで、デジタルメディアに付与するメタデータとそれを参照するツールなどから構成されています。

Images generated in ChatGPT and our API now include metadata using C2PA specifications.

This allows anyone (including social platforms and content distributors) to see that an image was generated by our products. https://t.co/kRv3mFnQFI pic.twitter.com/ftHqECS8SB

— OpenAI (@OpenAI) February 6, 2024

OpenAIが作成したC2PAに関するヘルプページによると、ChatGPTあるいはOpenAI APIで生成した画像をContent Credentials Verifyのようなウェブサイトで読み込むと、付与されたメタデータが参照できます。上に引用したXポストの画像はOpenAI APIで生成した画像を読み込んだ結果表示画面であり、右側に生成手段や生成日などが表示されます。以下の画像は、ChatGPTで生成した画像を読み込んだ場合の画面です。なお、メタデータ付与に伴い画像サイズがわずかに増えますが、画像品質とレイテンシーに及ぼす影響はごくわずかです。

ChatGPTによる生成画像のメタデータ確認画面。出典:OpenAI

C2PAは、実のところ、意図的に削除できるデータです。それゆえ、このデータが付与されていない画像については、ChatGPTあるいはOpenAI APIによって生成されたと証明できません。不正な加工が疑われる画像のメタデータを調べてみて、出処が不明の場合、悪意のあるユーザがメタデータを削除したと推測できるかもしれません。

DeepMind開発の電子透かしを付与するSynthID

Googleが2024年2月1日に発表した実験的画像生成モデルImageFXには、DeepMindが開発した識別システムSynthIDが実装されています。このシステムは電子透かしを生成して画像に付与するディープラーニングモデルと、その透かしを識別するモデルから構成されています。同システムが付与する電子透かしは人間には視認できず、また画像の品質にも影響を与えません。

オリジナル画像とSynthID生成電子透かし入り画像の比較。画像出典:DeepMind

SynthIDによる電子透かしは、フィルタの追加や色の変更といった画像加工、さらにはJPEG画像に使われる非可逆圧縮によっても損なわれない堅牢性をもっています。こうした堅牢性により、意図的な電子透かしの削除が困難となっています。もっとも、極端な画像操作によって電子透かしが毀損されることがあります。

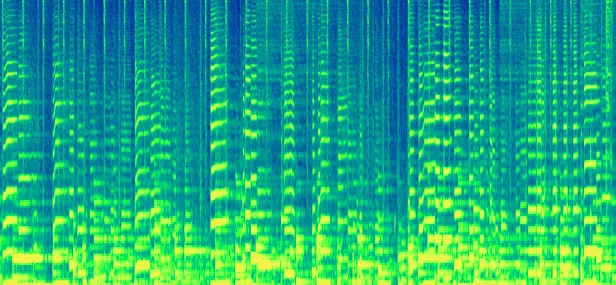

SynthIDは、2023年11月にDeepMindが発表した音楽生成モデルLyriaにも対応しています。具体的には、音声データに対して人間には認識できない波形を付与し、その波形を読み取ることでLyriaによって生成されたデータであることを特定します。

以上の音声的電子透かしは、付与対象の音声データのスペクトラム(音声波形を視覚化したデータ)を取得後、そのスペクトラムに挿入され再び音声データに変換されます。こうした処理によって、ノイズの追加、MP3圧縮、トラックのスピードアップやスローダウンなどの音声的操作によっても損なわれない堅牢性が確保されるのです。

スペクトラムに電子透かしを付与するイメージ画像。画像出典:DeepMind

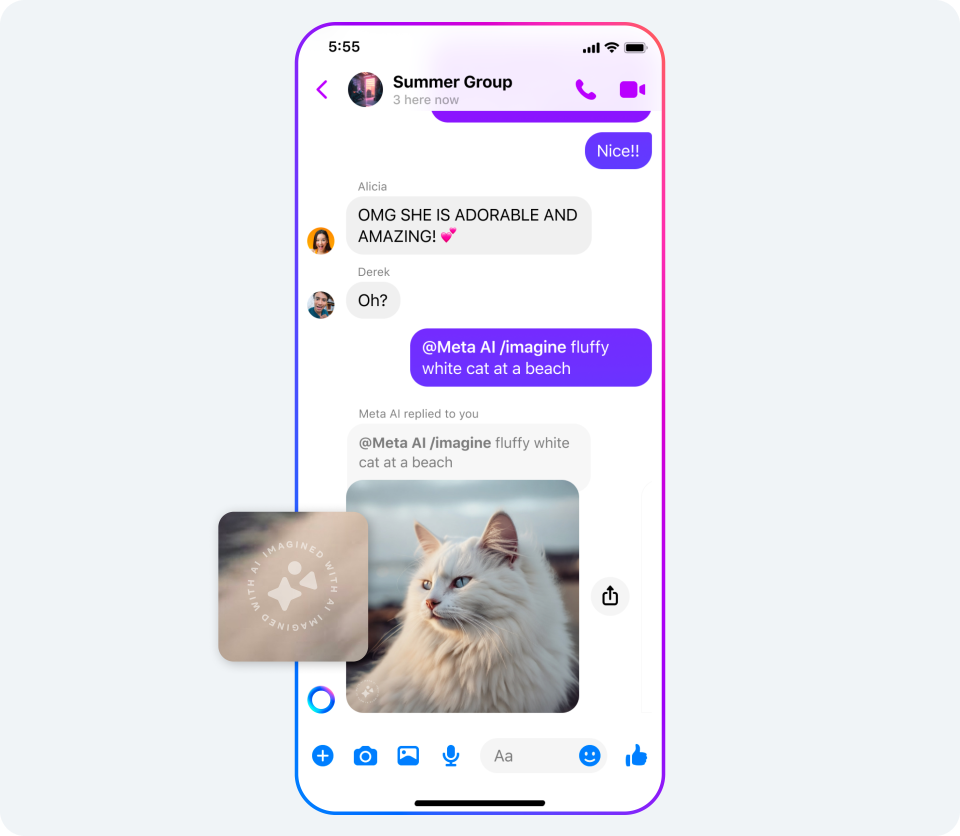

自社サービスの透明性を高めるMeta

Metaは2024年2月6日、Facebook、Instagram、そしてThreadsに投稿されたAI生成画像にその出処を示すラベルを付与することを発表しました。この発表では後述する同社製ツールによって生成された画像にラベルを付与するだけではなく、他社製ツールによるAI識別符号に対してもラベルを付与する、と述べています。こうしたラベル付与はPAI(Partnership on AI)を介して提携し、提携企業にはGoogle、OpenAI、Microsoft、Adobe、Midjourney、Shutterstockなどがあります。

2023年9月27日には、Metaが提供するAI編集ツールのrestyleとbackdropで生成した画像に対して、視認可能なマーカーを付与することを発表していました。

Metaが発表した視認可能なAI生成を示すマーカー。画像出典:Meta

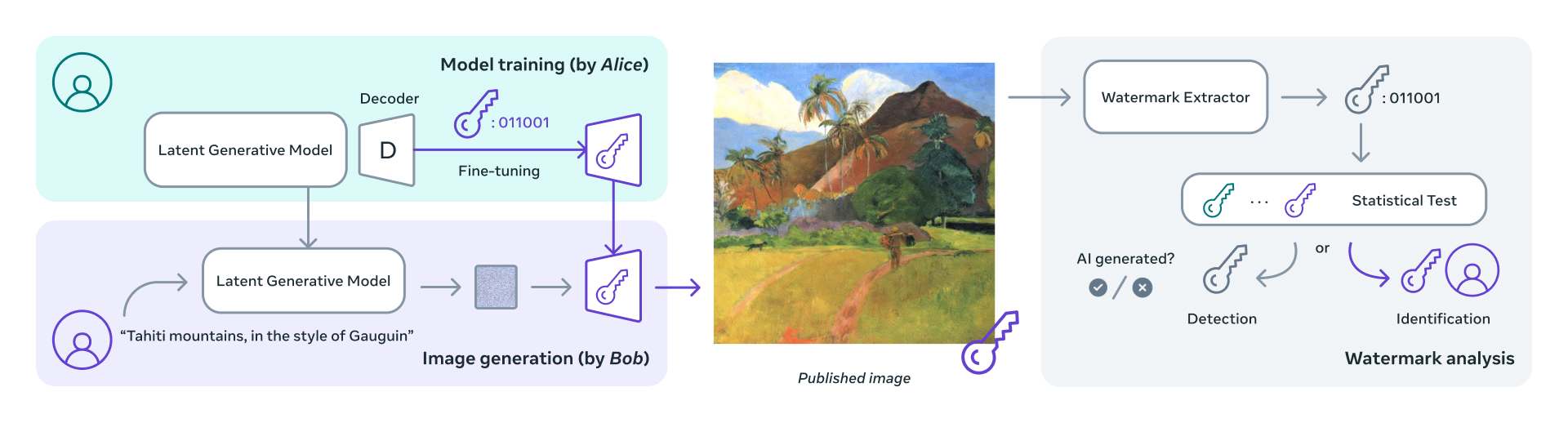

さらに2023年12月6日、電子透かしシステムStable Signatureを発表しています。このシステムは前述のSynthIDに類似したもので、電子透かしを生成するモデルとその透かしを抽出するモデル、そして、画像を生成したユーザが電子透かしを付与するモデルという3つのモデルから構成されています。ユーザが電子透かしを付与するモデルは電子透かしを生成するモデルをファインチューニングしたもので、このモデルを使うことでユーザに紐づいた電子透かしを付与できます。こうした機能により、画像を生成したユーザの特定をも可能とするのです。

Stable Signatureの仕組みに関する模式図。画像出典:Meta

ラベル付与ツールを導入するYouTube

YouTubeは2024年3月19日、AIによって生成または改変されたメディアで作成されたコンテンツであることを視聴者に開示するラベルを付与するツールの提供を発表しました。動画クリエイターは以下のようなコンテンツを制作する場合、ラベルの付与が必要になります。

|

ファンタジー世界のような明らかに非現実なコンテンツや、背景ぼかしや美肌加工フィルターを使用したコンテンツにはAI生成開示ラベルは不要です。

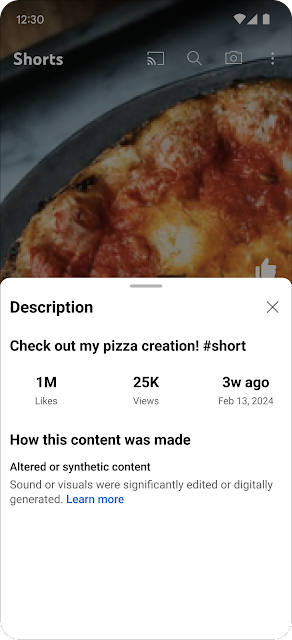

AI生成開示ラベルは基本的に動画の説明欄に「Altered or synthetic content(改変あるいは合成されたコンテンツ)」というメッセージが表示されますが、医療や選挙のようなデリケートな内容の動画については動画プレーヤーにも表示されます。

動画概要欄にAI生成開示ラベルを表示する事例。画像出典:YouTube

動画クリエイターがラベルを付与していなくても、YouTube運営元がラベル付与が必要と判断した場合には、ラベルが付与されることがあります。また、ラベル付与が必要にもかかわらず一貫してラベルを付与しないクリエイターに対して、何らかの措置を講じることを検討しています。

フェイク画像に対する政治的取り組み

フェイク画像は、選挙活動において悪用されると民主主義を脅かします。そのため、フェイク画像に対する政治的取り組みも進んでいます。以下では、そうした取り組みを紹介します。

「デジタル空間における情報流通の健全性確保の在り方に関する検討会」の取り組み

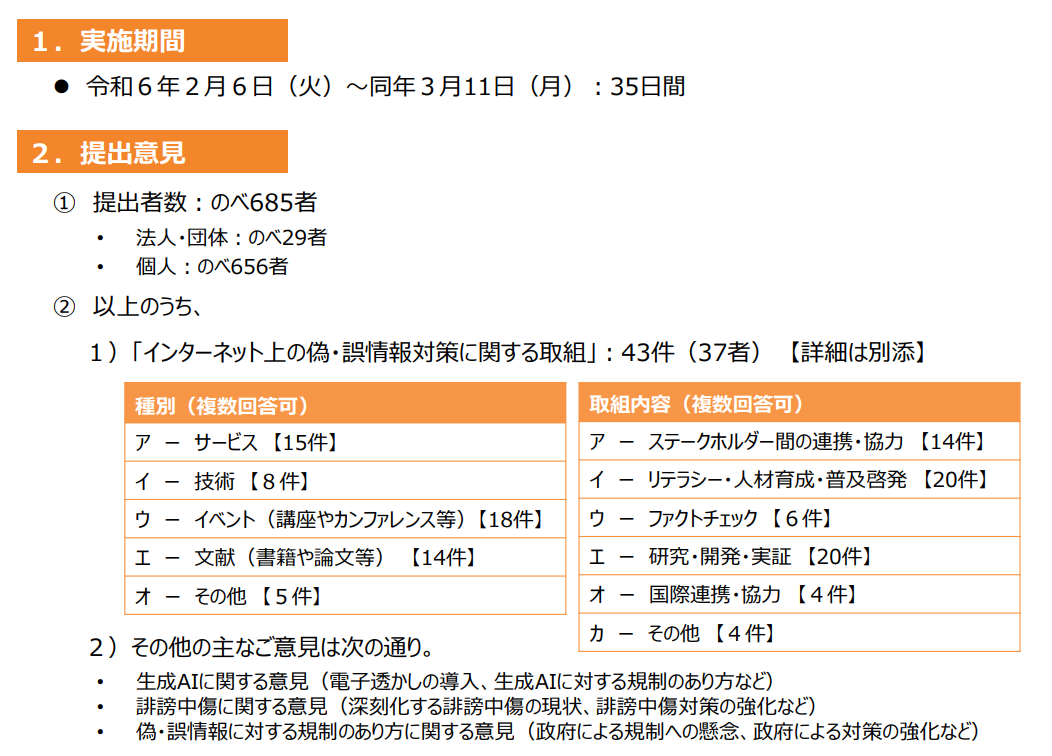

生成AIやメタバースの台頭によりデジタル空間が拡大・深化する現状をうけて、総務省は2023年10月31日、「デジタル空間における情報流通の健全性確保の在り方に関する検討会」を立ち上げました(※注釈1)。2024年2月5日には、プラットフォーム事業者等のステークホルダーによる偽・誤情報対策に係る取組を集約して共有することを目的として、2月5日から3月11日までインターネット上の偽・誤情報対策に関する取組についての意見募集を行いました。

2024年3月19日に開催された第13回検討会では、以上の意見募集をとりまとめた「「インターネット上の偽・誤情報対策に関する取組についての意見募集」に対する意見募集の結果について」を配布しました。配布資料の概要は以下のスライドのようにまとめられ、意見提出者は685者、そのうち「インターネット上の偽・誤情報対策に関する取組」は43件でした。

インターネット上の偽・誤情報対策に関する取組についての意見概要。画像出典:総務省

提出された意見のなかにはNABLAS株式会社が開発したフェイクコンテンツ検出技術があり、同社は前出のC2PAを自社製品に導入したことも報告しています。

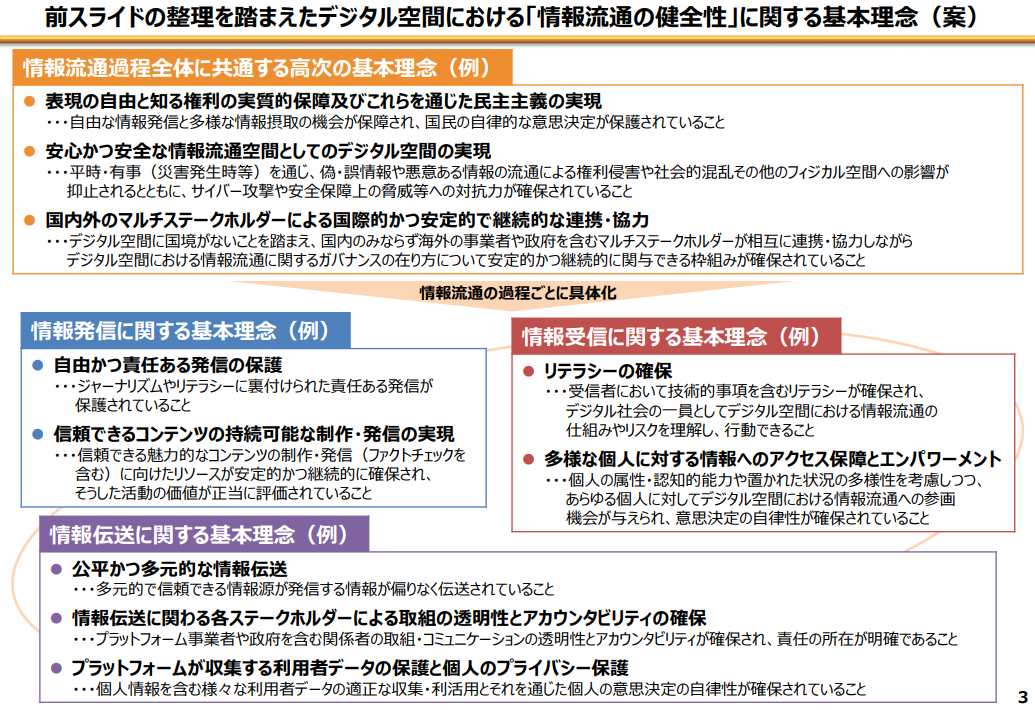

第9回検討会では、デジタル空間における情報流通の健全性に関する基本理念(案)も配布されました。この案では基本理念のひとつとして情報流通過程全体に共通する高次の基本理念がかかげられ、その細目には「安心かつ安全な情報流通空間としてのデジタル空間の実現」として偽・誤情報の抑止が明記されています。

デジタル空間における「情報流通の健全性」に関する基本理念(案)の一部。画像出典:総務省

OpenAIの取り組み

OpenAIは2024年1月15日、2024年に行われるアメリカ大統領選挙において同社製品が悪用されないための施策を発表しました。そうした施策は、以下の通りです。

|

ChatGPTにおける違反報告機能。出典:OpenAI

フェイク画像については前出のC2PAの導入に加えて、DALL-Eによって生成された画像を検出する由来検出器(provenance classifier)の実験を進めています。この検出器はC2PAのようなメタデータがなくても、さらには生成画像に典型的な加工が施されていたとしても、DALL-Eが生成した画像を検出するというものです。C2PAが付与されたDALL-E生成画像が多数を占めていない現状では、同検出器はフェイク画像に対する強力な対抗手段となります。

そのほかの施策として、ChatGPTの情報源として権威あるメディアとの提携も進めており、その成果として2024年3月13日に発表されたフランス有力メディアLe MondeとPrisa Mediaとの提携があります。さらに(たとえば投票場所などのような)選挙の手続きに関する特定の質問に対して、選挙に関する権威あるウェブサイトにユーザを誘導したりしています。

2024年選挙におけるAIの欺瞞的利用に対抗する技術協定

国際的な安全保障政策について話し合う第60回ミュンヘン安全保障会議がドイツ・ミュンヘンで2024年2月16日から18日に開催され、同会議において「2024年選挙におけるAIの欺瞞的利用に対抗する技術協定」が締結されました。この協定は2024年に行われる世界各地の選挙において、大手テック企業20社が有害なAI生成コンテンツに対して対抗技術を協調的に展開することを約束したものです。

以上の協定を締結した企業はアルファベット順に列挙すると次の通りです。Adobe、Amazon、Anthropic、ARM、ElevenLabs、Google、IBM、Inflection AI、LinkedIn、McAfee、Meta、Microsoft、Nota、OpenAI、Snap、Stability AI、TikTok、TrendMicro、TruePic、X。

2024年選挙におけるAIの欺瞞的利用に対抗する技術協定締結時の様子。画像出典:MSC

同協定締結企業は、以下の8項目に合意しました。

|

まとめ

本稿ではフェイク画像の現状を確認したうえで、大手テック企業が講じる技術的対策、さらには政治的取り組みをまとめました。この問題をめぐる戦いはまだ始まったばかりであり、直ちに劇的な効果が表れることはないでしょう。

前述のように、大手テック企業は生成AIによって生成されたことを示す技術によってフェイク画像に対抗しようとしています。この技術が効果を発揮するにはラベルや電子透かしを付与された画像が多数を占める状況になる必要があります。というのも、ラベルや電子透かしがないからと言って、フェイク画像だと断言できないからです。

その出処が明らかな画像が多数を占めるような状況になった場合になってはじめて、出処不明な画像が疑わしいものと判断できるようになります。このような不正コンテンツに対して頑健な状況になるには、しばしの時間がかかるでしょう。

今後懸念される問題として、フェイク動画の氾濫が挙げられます。OpenAIが今年中に公開すると報道されている動画生成AIのSoraには、高品質なフェイク動画を簡単に生成できる潜在的リスクがあります。同モデルが一般公開される頃には、フェイク動画に関する何らかの対策が行われているでしょうが、そうした対策は決して完璧なものではないと予想されます。

フェイク画像とフェイク動画に対するもっとも効果的な対策は、視聴者ひとりひとりが疑わしいコンテンツに接した時にそのリスクを感じ取れるAIリテラシーを育むことではないでしょうか。AIリテラシー向上のために、AINOWは今後も情報発信を続けていきます。

記事執筆:吉本 幸記(AINOW翻訳記事担当、JDLA Deep Learning for GENERAL 2019 #1、生成AIパスポート、JDLA Generative AI Test 2023 #2取得)

編集:おざけん