最終更新日:

同氏は2020年7月に発表された論文『大規模データセット:コンピュータビジョンのためのピュロスの勝利?』を要約することを通して、今日の大規模画像データセットが抱える3つの倫理的問題とその解決策を提起します。まず、問題は以下のようにまとめられます。

- 収集された画像のなかには、収集に関する同意が得られていないものがある。

- 画像検索を実行すれば、収集された画像の個人情報を特定できる。

- 不適切なラベルが付けられた画像がある。

以上のような問題の解決策として、下記の3つが考えられます。

- 同意の得られていない画像を適切な動画に入れ換える。

- データセットに関する情報は公開するが、個人情報は非公開とする差別化されたプライバシーを適用する。

- データセットの目的と制限事項等が記載された監査カードを作成する。

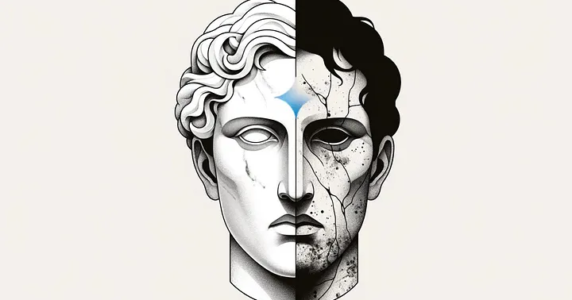

以下の記事本文で要約される論文の論題に含まれている「ピュロスの勝利」とは、勝利によって得たものより払った犠牲の方が大きい割に合わない勝利のことを意味します。この表現は、古代ギリシアの武将ピュロスがローマ軍と戦って勝利した時に、「もう一度ローマ軍に勝利したら、我々は壊滅するだろう」と発言した故事に由来しています。こうした表現を使っている論題が言おうとしているのは、大規模画像データセットによって生じた倫理的問題は、このデータセットによって可能となったコンピュータビジョンの進歩に見合う犠牲であったのだろうか、という問いかけなのです。

なお、以下の記事本文はCatherine Yeo氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならび組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

目次

ImageNetなど、多くの標準的なコンピュータビジョンデータセットに欠陥がある理由

画像出典:ImageNet

2009年に作成されたにもかかわらず、ImageNetは今日でもコンピュータビジョンとAIにおいて最もインパクトのあるデータセットである。1,400万枚以上の人間の注釈付き画像で構成されるImageNetは、AIにおけるすべての大規模データセットの標準となっている。毎年、ImageNetは、この分野の進歩をベンチマークするためのコンテスト(ILSVRC)を開催している。

コンピュータビジョンにおけるImageNetの影響力と重要性は否定できない。しかし、AIモデルやデータセットに潜むバイアスの証拠(※訳註1)が増えている今、未来のデータセットの進歩のためにも、倫理や社会的な文脈を意識した画像収集のプロセスを熟慮しなければならない。

Vinay PrabhuとAbeba Birhaneによる最近の論文によると、(主にImageNetだけでなく、8,000万枚のTiny Images(※訳註2)やCelebAなどの他のデータセットも含む)このような大規模なデータセットでは、考慮しなければならない懸念事項があることがわかった。また、彼らはこれらの懸念事項を軽減するための解決策を概説し、大規模データセットの画像収集プロセスのための制度的な審査委員会の義務化を呼びかけている。

この記事では、彼らの発見を以下にまとめる。arXiVで公開されている彼らのプレプリントはこちらから読むことができる。

論文では、まず顔認識AIの学習データとして多用されるIJB-AとAdienceにおけるデータ分布を調査した。その結果、どちらのデータセットも明るい肌の顔が多数を占めていることが判明した。公平な評価をするために、肌の色や性別の分布を是正した新しい顔認識データセットを作成した。

この新しい顔認識データセットを使って、Microsoft、IBM、そしてLenovo傘下のFace++社の性別分類APIを評価したところ、どのAPIに関しても明るい色の男性の正答率が高い一方で、暗い色の女性の正答率が低かった。

Tiny Imagesの画像数が8,000万枚と巨大なこと、および画像サイズが小さく人の目で確認することが困難であることから、不快な言葉でラベル付けされた画像をすべて除去するのが不可能、という理由で同データセットを利用不可とした。

一行要約

大規模画像データセットには、今後の画像収集のプロセスにおいて軽減し、対処しなければならない課題がある。

弊害と脅威

1) 同意の欠如

これらの大規模データセットの多くは、実在する人物が写っている写真を同意を考慮せずに自由に収集している。PrabhuとBirhaneは、Open Images V4-5-6データセットにおいて写真共有コミュニティFlickrから撮影された子供たちの「検証可能な非同意画像」を発見した。

写真家は、あなたの写真を全世界に向けて、あなたの同意なしにアップロードなどしてない。それなのに、なぜ画像データセットでは同意を考慮すべきでないと言えようか。

画像出典:Facebook

- (顔が検出されたという報告が)迷惑あるいは興味がない。

- その写真には私が写っていて、気に入っている。

- その写真はFacebookにあるべきではない。

- その写真はスパム。

2) プライバシーの喪失

ImageNetが公開されたときには、逆画像検索は存在しなかった。現在では、画像スクレイピングツールが普及し、強力な逆画像検索エンジン(例:Google画像検索、PimEyes)により、誰でも大規模な画像データセットの中から人物や顔の正体を明らかにすることができるようになった。

単純な逆引き調査を実行しただけで,フルネームやソーシャルメディアのアカウント,職業、家の住所など,私たちが提供することに決して同意しなかった多くのデータが潜在的に見つけられる可能性があるのだ(そもそもデータセットに顔を教えることに同意していなかったかもしれない)。

3) 有害な固定観念の恒久化

データセットをどのようにラベル付けし、画像収集するかによって、何が「望ましい」のか、誰が「普通」なのか、何が「許容できる」のかといったことが永続化されてしまう可能性がある。ラベル付けによる概念の永続化によって、カテゴリーの境界線上にいる個人やグループが「外れ値」として認識されてしまうだろう。

例えば、MITの8,000万枚から成るTiny Images datasetには有害な中傷が含まれており(※訳註4)、女性を「売春婦」や「ビッチ」、そしてマイノリティの人種グループを不快な言葉でレッテルを貼る可能性がある。

一度偏ったデータで訓練を受ければ、機械学習アルゴリズムはステレオタイプを標準化するだけでなく、増幅するのだ。

画像に不快なラベルが付けられてしまったのは、画像を収集するプロセスに問題があったからである。Tiny Imagesの画像を収集するにあたっては、英語の概念辞書であるWordNetに記載されている単語で画像検索を行った。このWordNetのなかには不快な言葉も含まれていたため、一部の画像に不快な言葉がラベル付けされたのだった。

解決策

1) 削除と入れ換え

ImageNet は、「潜在的に不快なラベル」を持っていると認識された場合に、「person」サブツリー内の写真を削除したという前例がある。不快なラベルを持つデータセットや、同意を得ない設定で撮影された写真についても、同様の処理を行うことができる – それらを削除し、(可能であれば)同意の上で撮影された金銭的な補償のある画像に置き換えるべきだろう。

2) 差別化されたプライバシー

もう一つの解決策は、差別化されたプライバシー(Differential Privacy)を利用して個人の身元を曖昧にしたり、難読化したりすることである。差別化されたプライバシーとは、データセットに関する情報は公開されていても、個人に関する情報は公開されないという、定量化可能なプライバシー保証を持つシステムのことである。

3) データセット監査カード

もしデータセットの公開に監査カードが添付されていれば、データセットを利用する際に、誰もがそのデータセットの目的、画像収集プロセス、限界などを知ることができるだろう。この解決策は、機械学習モデルに付随するモデルカード(※訳註5)の概念と酷似している。

公式サイトによると、モデルカードはAI開発者と非開発者の両方を対象としたもの、と述べられている。AI開発者がモデルカードを使えば、性能や制限事項を容易に把握できる。ジャーナリストのような非開発者がモデルカードを使えば、一般の人々にAIをわかりやすく伝えるための参考資料となる。

モデルカードには、AIモデルの標準的な動作、制限事項、使用した学習データの構造等がまとめられている。公式サイトには具体的事例として、顔検出のモデルカードが掲載されている。このモデルカードには期待できる顔検出の具体的事例、顔の角度によって検出率が低下するというような制限事項、そして使用している学習データにおける(性別、年齢層といった)データ分布が参照できるようになっている。

最後の感想

以上に解説した論文は魅力的であり、まさに今読むべきものである。データを収集して作業する際の自分自身の意思決定プロセスについて、より深く疑問を抱かせてもくれた。以上の論文(および他の類似の著作物)が、大規模画像データセットから生じ得る弊害や脅威を最小限に抑えて回避するために、研究者たちが画像収集プロセスを再考するきっかけとなることを、私は心から願っている。

論文の詳細については、arXivの原著論文をここでチェックしてください。

Vinay Uday PrabhuとAbeba Birhane.”大規模画像データセット:コンピュータビジョンのためのピュロスの勝利?”

・・・

お読み頂き、ありがとうございます。公正で倫理的なAIに関する研究、リソース、問題点についての詳細を読むために、以下のような記事を公開している私のMediumページを購読してください。

『Fair Bytes:AIにおける公平性に向けたより深いレンズ』

『GPT-3のバイアスはどのようなものなのか?』

『高校3年生の教室でAI倫理を教えるためのベストなリソース』

Catherine Yeoはハーバード大学のコンピュータサイエンス学部の学部生で、AI/機械学習/自然言語処理、公平性と倫理、そしてこれらに関連するすべてのものに興味を持っています。アイデアを提案したり、Twitterで彼女にコンタクトしたりみてください。

原文

『We Need to Change How Image Datasets are Curated』

著者

Catherine Yeo

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん