NVIDIA GTC 2021の基調講演では、仮想コラボレーションと物理的に正確なリアルタイム シミュレーションを可能とするNVIDIA Omniverseを使って制作されたデモ動画が多数披露されました。そうした動画のなかには、同社のジェンスン・フアンCEOにそっくりな小さいアバターが実在するエンジニアと質疑応答するものがありました。こうした動画が制作できた技術的背景として、Omniverseによって統合されている以下のような複数のAI技術があります。

NVIDIA Omniverseによって統合されているAI技術

|

以上のようなAI技術を統合するOmniverseは、デジタルツインやメタバースコンテンツを開発するプラットフォームとして活用されることで、さまざまな市場に多大な影響に与えると予想されています。

なお、以下の記事本文はNVIDIAのコンテンツの二次利用のガイドラインに基づき、AINOWで翻訳したものです。また、翻訳記事の内容は特定の国や地域を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

Toy Jensenの登場

そのプレゼンは、NVIDIA Omniverse(NVIDIAの3Dワークフローのための仮想世界シミュレーションおよびコラボレーションプラットフォーム)でしか起こり得ないことでした。

そしてそれは、NVIDIAのCEOであるジェンスン・フアン(Jensen Huang)のバーチャルなトイモデルToy Jensenとのインタビューにおいて起こりました。

Toy Jensenのクリエイターの1人が「もっとも素晴らしいものは…」と質問したところ、台本通りの質問を終える前に、言葉に詰まり、言い淀んでしまいました。

小さなToy Jensenは動じることなく、しばらくの間、答えを慎重に考えていました。

「最も素晴らしいのは、他人に親切な人です」と、Toy Jensenは答えました。

最先端のコンピュータグラフィックス、物理シミュレーション、ライブのCEO、そしてAIを搭載したアバターのサポートキャストが一体となって、Omniverseを使ったNVIDIA GTCの基調講演が実現しました。

以上の基調講演が実現する過程では、人間の魂もほんの少し混ざりました。

このAIによるコメント(Toy Jensenを使った質疑応答)はOmniverseの技術の奥深さを期せずして垣間見させるものなので、基調講演の見せ場として付け加えられました。

「Omniverseは、さまざまな研究領域が収束し、連携し、一体となって機能するためのハブです」、とNVIDIAのクリエイティブチームで今回のプレゼンテーションを担当したケビン・マーゴは語っています。「Omniverseは、それらすべての収束を促進するのです」とも述べています。

Toy Jensenのアドリブは現実のCEOと仮想環境および現実環境をシームレスに組み合わせたプレゼンテーションを締めくくるものであり、そのプレゼンでフアンはNVIDIAのテクノロジーがAI、グラフィックス、ロボティクスを現実および仮想世界の人間とどのように融合するのかを視聴者に説明しました。

本物のCEOとデジタルキッチン

視聴者が見ているCEOは全くもって実在しているのですが、周りの環境は同CEOが語るストーリーに合わせて変化していきます。

視聴者が見たフアンの基調講演は、COVIDの世界的流行のさなか多くの人々がいる場所でもあるようなキッチンで始まったように見えました。

そして、収納棚を固定しているネジまでモデル化されたフアンのキッチンがスライドして見えなくなった後、彼はバーチャルに再現されたエンデバー社屋のきらびやかなロビーに向かって歩いていったのでした(※訳註1)。

「私たちの目標の1つは、基調講演をいかに盛り上げるかということです」とマーゴは言っています。「私たちは、斬新かつ幻想的なことができて、なおかつNVIDIAの最新の技術革新を紹介できるような特別な瞬間を常に探しているのです。」

このイベントは、フアンをロビーからエンデバー内の集合場所であるシャノンの部屋に導き、ホロデッキ、データセンターを経て、本物のロボット研究室とエンデバーの外観に立ち寄るという視覚的な旅の始まりでした。

フアンのキッチンなどのバーチャル環境は、Autodesk Mayaや3ds Max、Adobe Substance PainterなどOmniverseでサポートされている使い慣れたツールを使ってチームが作成しました。

Omniverseは、これらのツールをリアルタイムにつなぐ役割を果たしました。これにより各チームのメンバーは、異なるツールを使用している同僚が行った変更を同時に見ることができたので作業が加速しました。

「(Omniverseによる)作業の加速は、非常に重要なことでした」とマーゴは言っています。

ライブ撮影が始まると、バーチャルとリアルの融合が一気に進みました。

現場にたずさわった少人数の動画制作チームは10月30日からわずか4日間で,NVIDIAのシリコンバレー本社にある予備の会議室を使って,フアンのスピーチを収録しました。

Omniverseは、NVIDIAのチームが同僚の作成したダイナミックな仮想環境をフアンの背後にあるスクリーンに映し出すことを可能にしました。

その結果,フアンの周りのシーンが変化すると彼に当たる光も変化し,彼が仮想環境にうまく溶け込むようになりました。

また、同氏がシーンの中を移動したりカメラが移動したりすると、周りの環境も変化しました。

「カメラが動くと、ビデオウォール上の世界の遠近感や視差がカメラと連動して変化します」とマーゴは言っています。

またフアンは周りに映し出された(バーチャルな)環境を見れたので、各シーンのナビゲーションをより上手くできました。

Omniverseのスピードで

以上のようなOmniverseで可能なことのすべてが、NVIDIAの制作チームの作業を加速させました。制作チームは、ポストプロダクションで手の込んだデジタルセットを追加するのではなく、必要なもののほとんどを各ショットの後にカメラで撮影しました。

その結果、動画制作チームは、本物のCEOとバーチャルおよび現実世界の設定をシームレスに融合させたプレゼンテーションを迅速に制作しました。

しかし、Omniverseは、締め切りに追われているリアルとデジタルの要素を持つクリエイターのコラボレーションを加速させるだけではありませんでした。Omniverseは、基調講演で紹介された一連のデモを結びつけるプラットフォームとしても機能しました。

開発者がOmniverseを使って、見たり、話したり、幅広いテーマについて会話したり、話された意図を自然に理解したりすることができるインテリジェントでインタラクティブなエージェントを作るために、フアンはOmniverse Avatarを発表しました。

Omniverseにはレイトレーシングからレコメンダーシステムまでさまざまな技術が結集しており、基調講演ではこれらの技術を組み合わせて、見事なデモを次々と披露しました。

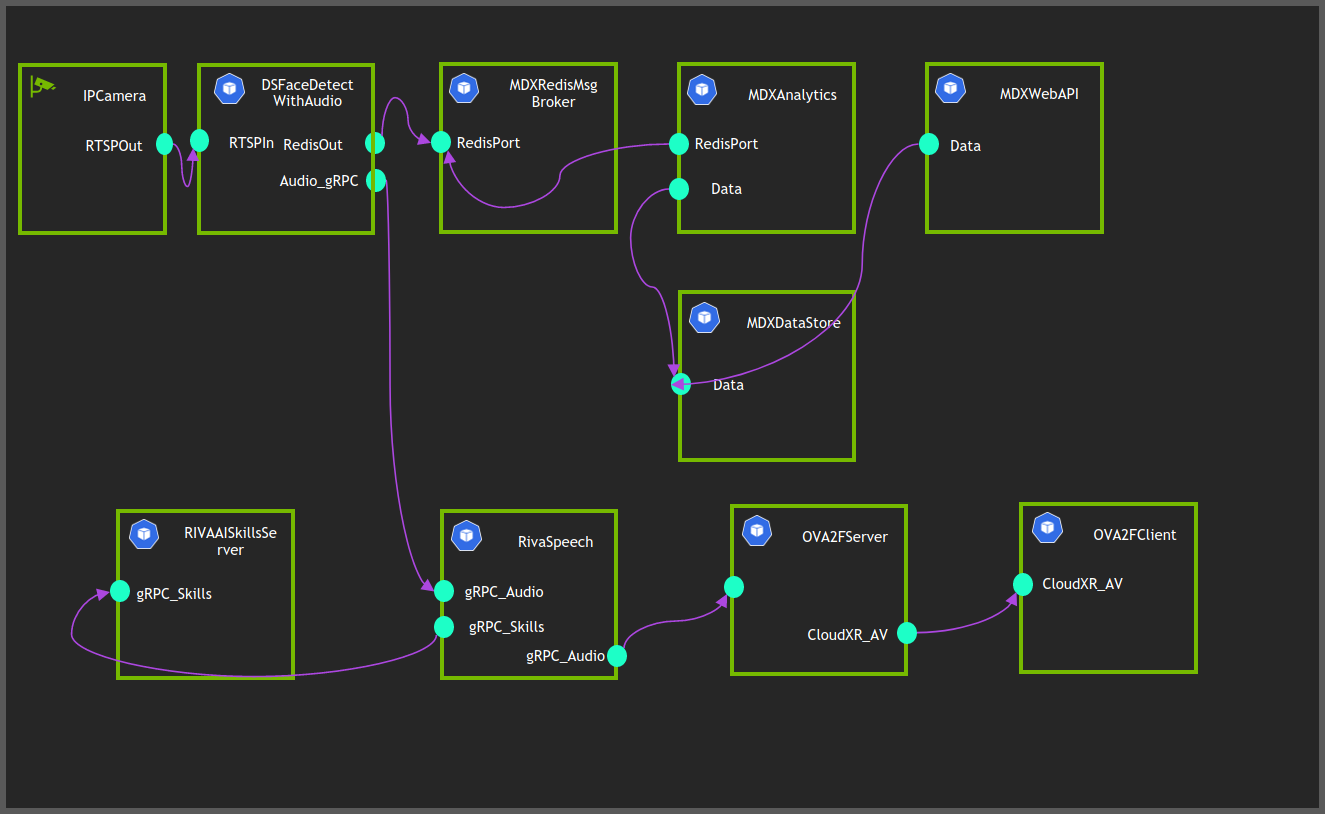

Omniverse AvatarのためのProject TokkioがMetropolisコンピュータビジョン、RivaスピーチAI、アバターアニメーション、グラフィックスを接続して、リアルタイムの会話型AIロボットであるToy Jensen Omniverse Avatarに仕上げる様子をフアンが紹介したところ、この紹介デモは瞬く間に話題となりました。

NVIDIAのエンジニア3人と小さなToy Jensenモデルとの会話は、単なる技術的な力技ではなく、専門的で自然な質疑応答を披露していました。

Toy Jensenとエンジニアの質疑応答は、Toy Jensenとその環境のフォトリアリスティックなモデリング(頭を動かしたときにToy Jensenのメガネが光るところまで)と,Megatron 530B大型言語モデルを搭載したNVIDIAのRiva音声合成技術が,いかに自然で滑らかな会話をサポートできるかを示しました。

このデモを制作するために,NVIDIAのクリエイティブチームがMaya Substanceでデジタルモデルを作成し,Omniverseがそれ以外の作業を行いました。

「どれも手動ではなく、アニメーションアセットをロードして(アバターに対して)話すだけです」とフアンは言いました。

また、フアンは「Project Tokkio」の2つ目のデモを披露しました。それはレストランのキオスクに設置された接客用アバターで、2人のお客様を見て、会話をしてその内容を理解できるものです。

もっともこのモデルはMegatronではなくレストランのメニューを統合したモデルに頼っており、それゆえアバターは顧客の選択肢をスムーズに案内できるのです。

同じ技術の積み重ねが、人間同士の会話にも役立ちます。フアンは、Project Maxine(※訳註2)がバーチャルコラボレーションやビデオコンテンツ作成のアプリケーションに最先端のビデオ・オーディオ機能を追加できることを紹介しました。

デモでは騒がしいカフェで女性がビデオ通話で英語を話している様子が映し出さましたが、背景の雑音がなくなり彼女の声ははっきりと聞こえます。また彼女が話すと、その言葉はリアルタイムでフランス語、ドイツ語、スペイン語に書き起こされ翻訳されます。

Omniverseのおかげで、彼女と同じ声、同じイントネーションで会話ができるアバターが話すのです。

これらのデモが可能になったのは、「Omniverse」が「Omniverse Avatar」を通じて、高度なスピードAI、コンピュータビジョン、自然言語理解、レコメンデーションエンジン、フェイシャルアニメーション、グラフィック技術を統合しているからです。

Omniverse Avatarの音声認識は、複数の言語の音声を認識するソフトウェア開発キットであるNVIDIA Riva(※訳註3)をベースにしています。Rivaは、音声合成機能を使って人間らしい音声応答を生成するためにも使用されます。

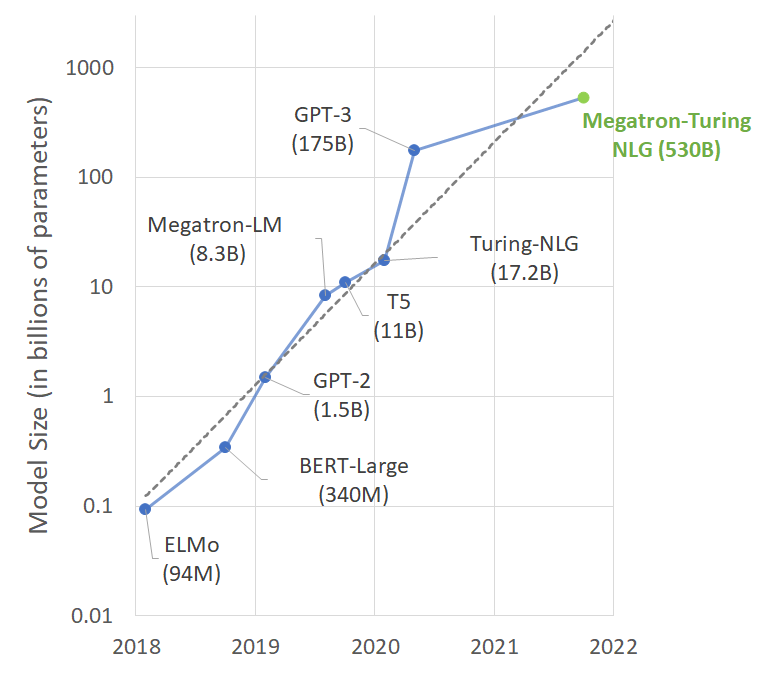

Omniverse Avatarの自然言語理解は、人間の言語を認識し、理解し、生成できるMegatron 530B大型言語モデル(※訳註4)をベースにしています。

Megatron 530Bは事前学習されたモデルで、ほとんど、あるいは追加の学習を全くすることなく文章を完成させ、広範囲のテーマを含む質問に答えられます。また、長くて複雑なストーリーを要約したり、他の言語に翻訳したり、特別な訓練を受けていない多くのドメインを扱うことができます。

Omniverse Avatarのレコメンデーションエンジンは、NVIDIA Merlin(※訳註5)によって提供されています。これは、企業が大量のデータを処理してより賢い提案を行えるディープラーニングレコメンデーションシステムを構築するためのフレームワークです。

知覚機能は、ビデオ分析のためのコンピュータビジョンフレームワークであるNVIDIA Metropolis(※訳註6)によって実現されています。

また、アバターアニメーションはAI駆動の2Dおよび3Dフェイシャルアニメーションとレンダリング技術であるNVIDIA Video2FaceとAudio2Face(※訳註7)によって実現されています。

これらの技術はすべてアプリケーションとして構成されており、NVIDIA Unified Compute Framework(※訳註8)を使ってリアルタイムで処理されます。

スケーラブルでカスタマイズ可能なマイクロサービスとしてパッケージ化されたこれらの技術は、NVIDIA Fleet Command(※訳註9)によって複数の場所に安全に実装、管理、オーケストレーションできます。

フアンはこれらの技術を使って、NVIDIA Omniverse が数兆ドル規模の産業をどのように変えていくかについて大規模なストーリーを語れたのです。

今回のデモはすべてOmniverse上で構築されました。本物のCEO、現実と仮想の環境、そしてOmniverse内で作られた一連のデモなど、Omniverseのおかげですべてがまとまりました。

昨年末の発売以来、Omniverseは500社のデザイナーによって7万回以上ダウンロードされています。Omniverse Enterpriseは、現在、年額9,000ドルから利用できます。

近年の言語AIのパラメータ数

Unified Compute Frameworkでノーコード設計する様子

原文

『How Omniverse Wove a Real CEO — and His Toy Counterpart — Together With Stunning Demos at GTC 』

著者

BRIAN CAULFIELD(NVIDIAチーフブロガー)

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん