最終更新日:

Romero氏は昨年9月にGPT-4の特徴を予想する記事を公開しましたが、自然言語処理研究の最新トレンドを考慮して予想記事を書き改めました。同氏によるとGPT-4は2022年の7月から8月頃にリリースされ、その特徴は以下のような5項目にまとめられます。

自然言語処理の最新研究にもとづいて予想されるGPT-4の特徴

|

以上のように予想したうえで、GPT-4はTransformerの登場以降続いてきた「ユニモーダルな高密度言語モデル」という自然言語処理の研究ドメインにおける最終バージョンとも呼べるものとなり、同モデル以降はマルチモーダルやスパース性を採り入れた新たな研究ドメインが主流となるだろう、とRomero氏は考えています。

なお、以下の記事本文はAlberto Romero氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、日本語の文章として読み易くするために、意訳やコンテクストを明確にするための補足を行っています。

画像出典:ShutterstockのPinkeyesより

目次

公式情報、現在の動向、そして予測

GPT-4発表の日が近づいてきた。

GPT-3が発表されたのは2020年5月、およそ2年前のことだ。GPT-2の1年後、つまりGPTの原論文が発表された1年後に発表されたことになる。この傾向がバージョン間で続くのであれば、GPT-4はすでに登場しているはずである。そうではなかったが、OpenAIのCEOであるサム・アルトマンは、数カ月前にGPT-4が登場すると発言している。現在の予想では、リリース時期は2022年のいつか、おそらく7月〜8月頃になると見られている(※訳註1)。

最も待ち望まれているAIニュースの1つであるにもかかわらず、GPT-4についてどんなものになるのか、どんな特徴があるのか、どんな能力があるのかといった公開情報はほとんどない。アルトマンは昨年Q&Aを行い、GPT-4に対するOpenAIのアイデアについて、いくつかのヒントを与えてくれた(※訳註2)(彼は参加者に情報については口外しないように求めたので、私は黙っていたが、沈黙を破るまでに待った期間が7ヶ月というのは妥当だろう)。1つだけ確かなことは、GPT-4は、私が以前の記事(※訳註3)で仮定したように、100兆のパラメータを持たないということだ(そんな大きなモデルは後回しだ)。

OpenAIがGPT-4の情報を明かしてからしばらく経つ。しかし、AIの分野、特に自然言語処理の分野で大きな注目を集めているいくつかの新しいトレンドが、GPT-4に関するヒントを与えてくれるかも知れない。自然言語処理における最近のアプローチの成功とその成功に対するOpenAIの関与、そしてアルトマンの発言からいくつかの納得のいく予測を立てられる。そしてきっとそれらは、モデルをどんどん大きくしていくというよく知られた(そして飽き飽きした)やり方を超えるものだろう。

OpenAIとサム・アルトマンから得た情報、そして言語AIの現在のトレンドと最先端を考慮して、GPT-4について私が予想することは以下のとおりだ。(どの予想が推測的、あるいは確定的かをコンテクストで明らかにする)。

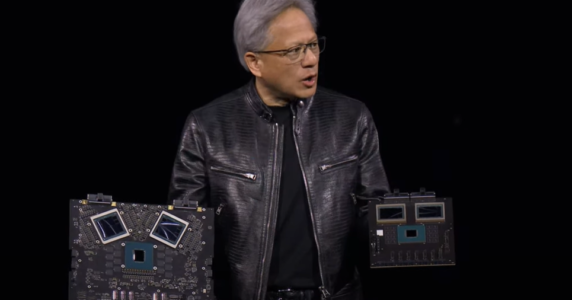

2021年9月開催のQ&Aセッションでサム・アルトマンが答えたこと

|

モデルサイズ:GPT-4は超大型にはならないだろう

GPT-4は最大の言語モデルにはならないだろう。アルトマンは、それはGPT-3よりそんなに大きくはならないだろう、と言った。確かに前世代のニューラルネットワークと比べれば大きいが、大きさが際立った特徴になるわけではない。おそらく、GPT-3とGopher(※訳註4)の中間(1,750億~2,800億パラメータ)くらいの大きさになると思われる。

(モデルサイズの巨大化を第一目標にしないという)この決断には、もっともな理由がある。

NvidiaとMicrosoftが昨年構築したMegatron-Turing NLGは、ごく最近まで5,300億のパラメータを持つ最大の高密度ニューラルネットワークというタイトルを保持しており、すでにGPT-3の3倍であった(現在はGoogleのPaLMが5,400億でタイトルを保持している)。しかし驚くべきことに、MT-NLGの後に登場したいくつかの小さなモデルは、より高い性能レベルに達している。

よい大きい≠よい良い。

より優れた小型モデルの存在には、2つの意味がある。

1つ目は、性能向上のための指標としてモデルの大きさを採用することが唯一の方法ではなく、また最良の方法でもないことに各社が気づいたことだ。2020年、OpenAIの(当時リサーチ・コンサルタントだった)ジャレッド・カプランと彼の同僚たちは、計算予算の増加を主にパラメータ数のスケーリングに割り当てた場合に、性能が最も向上し、べき乗の関係に従うと結論付けていた。Google、Nvidia、Microsoft、OpenAI、DeepMindなど言語モデルを開発している企業は、このガイドラインを額面通りに受け止めていた。

しかし、MT-NLGは、その大きさの割には性能の面では最高ではない。実際、どのカテゴリーの単一ベンチマークでもベストではない。Gopher(2,800億)やChinchilla(700億)のような小さなモデルはMT-NLGの何分の1かのサイズだが、すべてのタスクでMT-NLGよりずっと優れている(※訳註5)。

言語理解を深めるにはモデルの大きさだけが要因ではないことが明らかになり、それが2つ目の真意へとつながっている。

企業は「大きいことは良いことだ」というドグマを否定し始めている。より多くのパラメータを持つことは、パフォーマンスを向上させる多くの要因のうちの1つに過ぎないのだ。そして、(パラメータ増大に伴う)付随的な損害(例えば、二酸化炭素排出量、計算コスト、参入障壁など)を考慮すると、(巨大言語モデルの)実装は非常に簡単な一方で、最悪の要因の1つになってしまうのだ。企業は、より小さなモデルで同様の、あるいはより良い結果が得られるのであれば、巨大なモデルを構築することを考え直すだろう。

アルトマンが言うには、OpenAIの研究者たちはモデルを極端に大きくすることではなく、より小さなモデルから最良の結果を得ることに重点を置くようになった。彼らはスケーリング仮説(※訳註6)の初期の代弁者だったが、今では他の未踏の道がモデルの改良につながることに気づいているのかも知れない。

以上がGPT-4はGPT-3よりそれほど大きくならないだろうと言える理由である。OpenAIは、データ、アルゴリズム、パラメータ最適化、アライメントなど、より明確に大きな改善をもたらす可能性のある他の側面に焦点を移していくだろう。100兆のパラメータモデルが発揮する能力を見るには、待つしかないだろう。

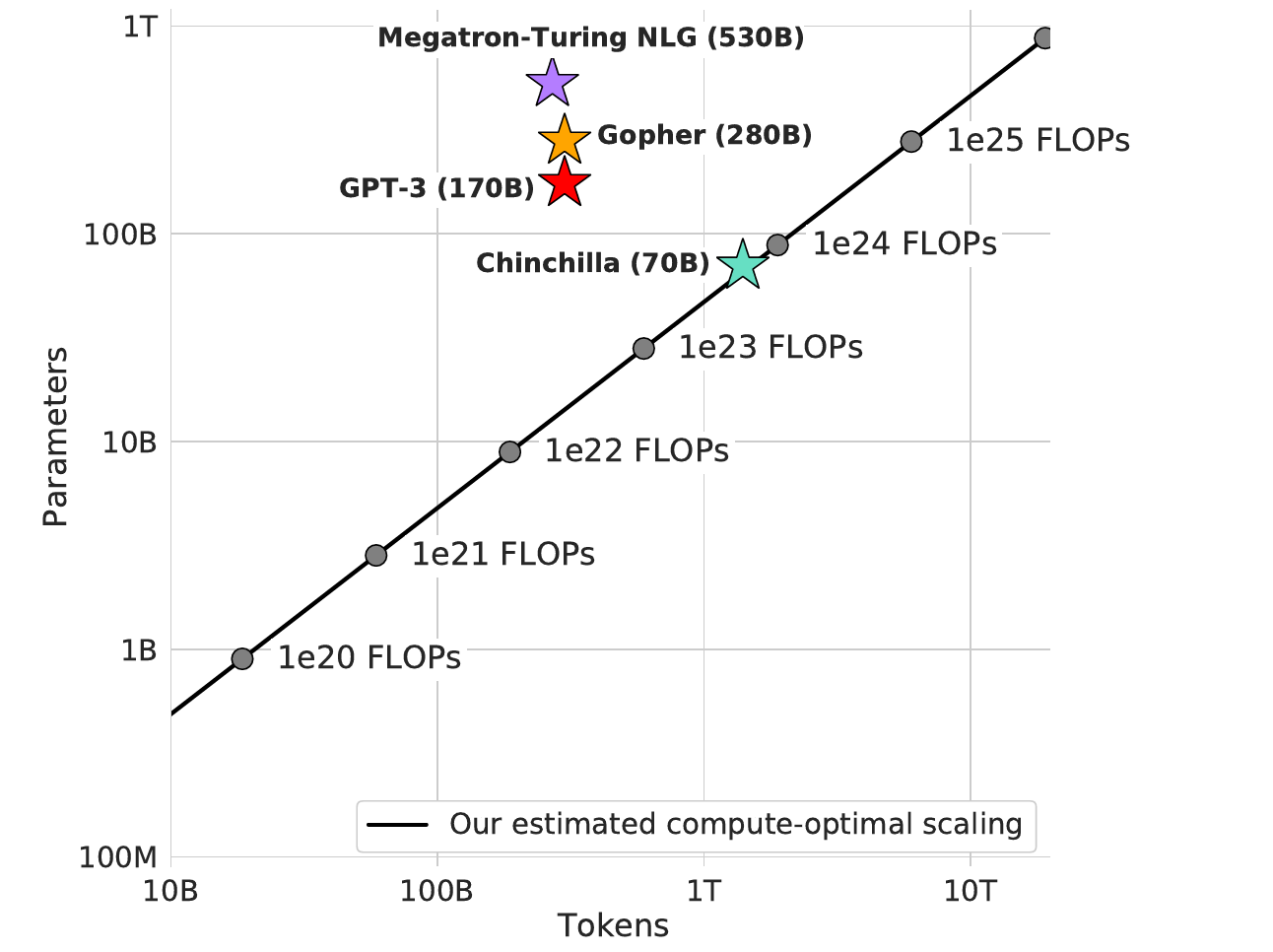

Chinchillaの解説記事には、同モデルと最大級サイズの言語モデルをモデルサイズと学習データを2軸とした座標系にプロットした以下のような画像が掲載されている。

以上の座標系における直線は、最適と推定されるモデルサイズと学習トークン量を表している。この直線より上にプロットされると、モデルサイズに比して学習不足であることを意味し、下にプロットされると学習が過剰であることを意味する。そして、最適直線にある言語モデルはもっとも効率的に計算予算を活用していることになる。当然ながら、Chinchillaはこの最適直線上にプロットされる。

最適化:GPT-4を最大限に活用する

言語モデルは、最適化という点で1つの重大な制限に悩まされている。学習が非常に高価であるため、企業は精度とコストのあいだでトレードオフを行わなければならない。その結果、モデルの最適化が不十分であることがよくある。

GPT-3は、利用事例によっては再訓練が必要となるようなエラーもあったが、1度しか訓練されなかった。OpenAI は、コストが手頃でないために再訓練を行わなかった。再訓練しなかったので、研究者がモデルに最適なハイパーパラメータのセット(学習率、バッチサイズ、シーケンス長など)を見つけられなかった。

学習コストが高いことのもうひとつの帰結は、モデル動作の分析が制限されることである。カプランのチームがモデルサイズが性能向上に最も関連する変数であると結論づけたとき、彼らは訓練トークンの数、つまりモデルに供給されるデータの量を考慮していなかった。訓練トークン数を考慮すると、膨大な量のコンピューティングリソースが必要になってしまうからだ。

テック企業は、カプランの結論が知り得る最善策であったため、それに従ったまでなのだ。皮肉なことに、Google、Microsoft、Facebook(現在はMeta)、その他の企業は、まさに経済的な制約に動機づけられてより巨大なモデルのために何百万ドルも「浪費」し、その過程で膨大な量の汚染物質を発生させた。

現在、DeepMindとOpenAIを筆頭に、各社は別のアプローチを模索している。彼らは、単に大きなモデルではなく、最適なそれを見つけようとしている。

最適なパラメータ化

先月、MicrosoftとOpenAIは、最適なハイパーパラメータでモデルを訓練すれば、GPT-3がさらに改善されることを証明した。彼らは、67億パラメータのバージョンのGPT-3が、オリジナルの130億のそれに匹敵するほど性能を向上させることを発見した。より大きなモデルでは実現不可能なハイパーパラメータのチューニングにより、パラメータ数を2倍にしたのと同等の性能向上が得られた。

彼らは小さなモデルに最適なハイパーパラメータが、同じ系列の大きなモデルにも最適であるという新しいパラメータ最適化法(μP)を発見した。μPにより、非常に小さな訓練コストで任意のサイズのモデルを最適化することが可能になった。そして、そのハイパーパラメータは、より大きなモデルに実質的にコストなしで移植できるのだ。

最適化された計算モデル

数週間前、DeepMindは(パラメータ数こそがモデル性能向上の最大要因という)カプランの発見を再検討したところ、信じられていたこととは逆に、訓練トークンの数がモデルサイズと同じくらい性能に影響を及ぼすことに気づいた。彼らは、より多くの計算予算が利用できるようになれば、それをパラメータとデータのスケーリングに等しく割り当てるべきだと結論づけた。彼らは700億パラメータのモデルであるChinchilla(前回の最先端モデルであるGopherの4分の1)を、GPT-3以降のすべての大規模言語モデルの4倍のデータ(通常の3,000億から1兆4,000億トークン)で訓練し、仮説を証明した。

その結果は明々白々だった。Chinchillaは多くの言語ベンチマークにおいて、Gopher、GPT-3、MT-NLG、その他すべての言語モデルを「一様に、かつ有意に」上回った。現在のモデルは訓練不足な一方で、サイズが大き過ぎるのだ。

GPT-4がGPT-3よりわずかに大きいことを考えると、(DeepMindの調査結果に従って)最適な計算を行うために必要な学習トークン数は約5兆個で、現在のデータセットより一桁多くなる。また、学習損失を最小にするためにモデルを学習させるのに必要なFLOPsの数は、GPT-3で使用した10〜20倍程度になる(Gopherの計算構成を流用して試算)。

アルトマンは、Q&Aで「GPT-4はGPT-3よりもずっと多くの計算量を使うだろう」と述べたのは、このことを指していたのかも知れない。

OpenAIがGPT-4に最適化関連の知見を実装することは間違いないだろうが、計算予算が不明なため、どの程度かは予測できない。ただ確実なのは、モデルサイズとは別の変数の最適化に注力するだろうということだ。最適なハイパーパラメータのセット、最適な計算モデルサイズとパラメータ数を見つけることで、すべてのベンチマークで信じられないような改善が見られるかも知れない。言語モデルに関する性能予測は、以上に述べた最適化のアプローチを1つの説明モデルにまとめてしまうと、失敗してしまう。

またアルトマンは「モデルを大きくしなくても、どれだけ優れたモデルができるのか、人々は信じないだろう」とも述べている。彼の発言は、スケーリングの努力はひとまず終わったと示唆しているのかも知れない。

マルチモダリティ:GPT-4はテキストのみのモデルになるだろう

ディープラーニングの未来は、マルチモーダルモデルにある。人間の脳はマルチモーダルな世界に住んでいるため、マルチセンシティブでもある。一度に1つのモードでしか世界を認識しないと、世界をナビゲートしたり理解したりするAIの能力が大きく制限されてしまう。

しかし、優れたマルチモーダルモデルは、言語のみ、あるいは視覚のみのモデルよりも構築するのが非常に困難だ。視覚情報と文字情報を組み合わせて1つの表現にすることは、非常に困難な作業である。私たちの脳がそれをどのように行っているかについての知見は非常に限られているので(ディープラーニングコミュニティが、脳の構造と機能に関する認知科学からの洞察を考慮しているわけでもない)、ニューラルネットワークにどのように実装すればよいのかわかっていない。

アルトマンはQ&Aで、GPT-4は(DALL-EやMUM(※訳註7)のような)マルチモーダルではなく、テキストのみのモデルになると言った。私の推測では、OpenAIは次世代のマルチモーダルAIに移行する前に、モデルやデータセットのサイズなどの要素を調整しながら、言語モデルの限界に到達しようとしているようだ。

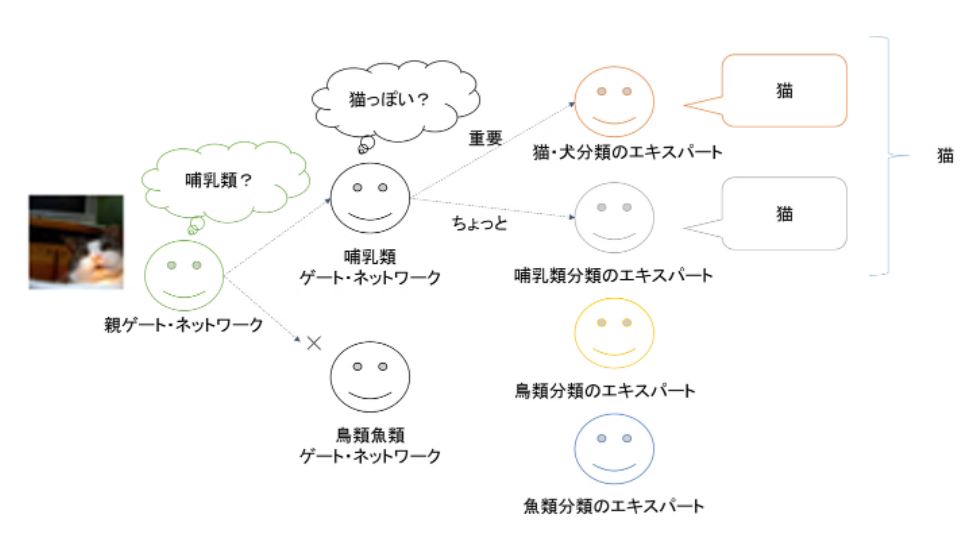

スパース性:GPT-4は高密度モデルになるだろう

異なるタイプの入力を処理するためにモデルの異なる部分を使用して条件付き計算を活用するスパースモデルは、最近大きな成功を収めている。これらのモデルは高い計算コストに悩まされることなく、1兆パラメータを容易に超えるスケールを実現し、モデルサイズと計算予算のあいだに直交する関係を作り出しているように見える。しかし、MoE (※訳註8)アプローチの利点は、非常に大きなモデルでは減少してしまう。

OpenAIが高密度言語モデルに注力してきた歴史を考えると、GPT-4も高密度モデルになると予想するのが妥当だろう。そして、アルトマンがGPT-4はGPT-3よりそれほど大きくならないと述べていることから、少なくとも現時点では、OpenAIのオプションとしてスパース性はないと結論づけられる。

AIのインスピレーション源である私たちの脳がスパース処理に大きく依存していることを考えると、マルチモダリティと同様に、スパース性が将来世代のニューラルネットワークを支配する可能性は高いだろう。

階層型MoEモデルの模式図

画像出典:Qiita記事「ディープラーニングでMixture of Experts、あるいは階層型ネットワークの階層型ネットワーク」より引用

アライメント:GPT-4は、GPT-3よりもアライメント性が高くなるだろう

OpenAIは、AIのアライメント問題(言語モデルをいかにして我々の意図に沿わせ、我々の価値観に従わせるか、それが何を意味するかは別として)に取り組むことに多くの労力を費やしてきた。これは数学的に難しいだけでなく(どのようにして私たちが望んでいることを正確にAIに理解させられるのか)、哲学的にも難しい問題だ(人間の価値観はグループによって大きく異なり、しばしば対立するため、AIを人間と一致させる普遍的な方法は存在しない)。

しかし、OpenAIはInstructGPTで最初の試みを行った。これは、人間のフィードバックによって訓練された新しいGPT-3で、指示に従うことを学習したものである(その指示が善意からのものであるかどうかは、まだモデルに織り込まれていない)。

InstructGPTの主なブレークスルーは、言語ベンチマークの結果に関係なく人間の判定者(OpenAIの社員と英語を話す人という非常に均質なグループを形成しているため、結論の抽出には注意が必要)により良いモデルとして認識されたことだ。この結果は、AIの能力を評価するための唯一の指標としてベンチマークを使うことを乗り越える必要性を強調している。人間がモデルをどのように認識するかは、ベンチマーク以上に重要なのかも知れない。

アルトマンとOpenAIの有益なAGIへのコミットメントを考えると、GPT-4はInstructGPTから得た知見にもとづいて構築され、実装されると私は確信している。

OpenAIは、同社の社員と英語を話すラベル付与者に限定していたモデルのアライメント適合方法を改善するだろう。真のアライメントは、性別、人種、国籍、宗教などに関するあらゆる出自と特徴を持つグループを含むべきだ。それは大きな挑戦であり、その目標に向けたどんなステップも歓迎されるだろう(ただし、ほとんどの人に適合しないのに、アライメントと呼ぶようなことに対しては警戒すべきである)。

まとめると…

モデルサイズ:GPT-4はGPT-3より大きくなるが、現在の最大モデル(MT-NLG 530BとPaLM 540B)と比べるとそれほど大きくはない。モデルサイズが際立った特徴とはならないだろう。

最適化:GPT-4はGPT-3よりも多くの計算を必要とする。また、パラメータ最適化(最適なハイパーパラメータ)とスケーリング則(学習トークン数はモデルサイズと同様に重要)に関する新しい最適化の知見を実装するだろう。

マルチモダリティ:GPT-4はテキストのみのモデルとなる(マルチモーダルではない)。OpenAIは、DALL-Eのようなマルチモーダルモデルに完全に移行する前に、言語モデルを限界まで活用することを検討している。こうしたOpenAIの計画によって、将来的にはユニモーダルモデルの限界が超えられるだろう。

スパース性:GPT-4では、GPT-2やGPT-3と同様、高密度モデル(すべてのパラメータが任意の入力を処理するために使用される)を目指す。将来的にはスパース性が(ニューラルネットワーク・アーキテクチャに関して)支配的になる。

アライメント:GPT-4は、GPT-3よりも私たちとの連携が強化される。GPT-4は、人間のフィードバックによって訓練されたInstructGPTの学習内容を実装するだろう。それでも、AIとの連携は長い道のりであり、努力は慎重に評価されるべきであり、過大評価されるべきではない。

・・・

Minds of Tomorrowを購読してください!AIとテクノロジーに関するニュース、リサーチ、洞察を2週間ごとに無料でお届けします。

また、こちらの私の紹介リンクを使ってMedium会員になれば、私の仕事を直接サポートし、無制限にアクセスすることができます!

原文

『GPT-4 Is Coming Soon. Here’s What We Know About It』

著者

Alberto Romero

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん