画像出典:ChatGPT実行ページより著者が引用

目次

はじめに

AI研究分野のひとつとして会話AI開発があるのは周知の通りですが、2022年末にOpenAIがリリースした「ChatGPT」によって、この分野の研究がさらに前進したと認知されています。同AIはリリースされるとすぐに大きな反響を呼んだのですが、実のところ、OpenAI以外の大手テック企業も会話AIを開発しており、その成果はいずれも注目に値します。そこでこの記事では、技術的に最先端なさまざまな会話AIを紹介していきます。

GPT-3から正当進化した「ChatGPT」

人間が評価した報酬によって強化されたChatGPT

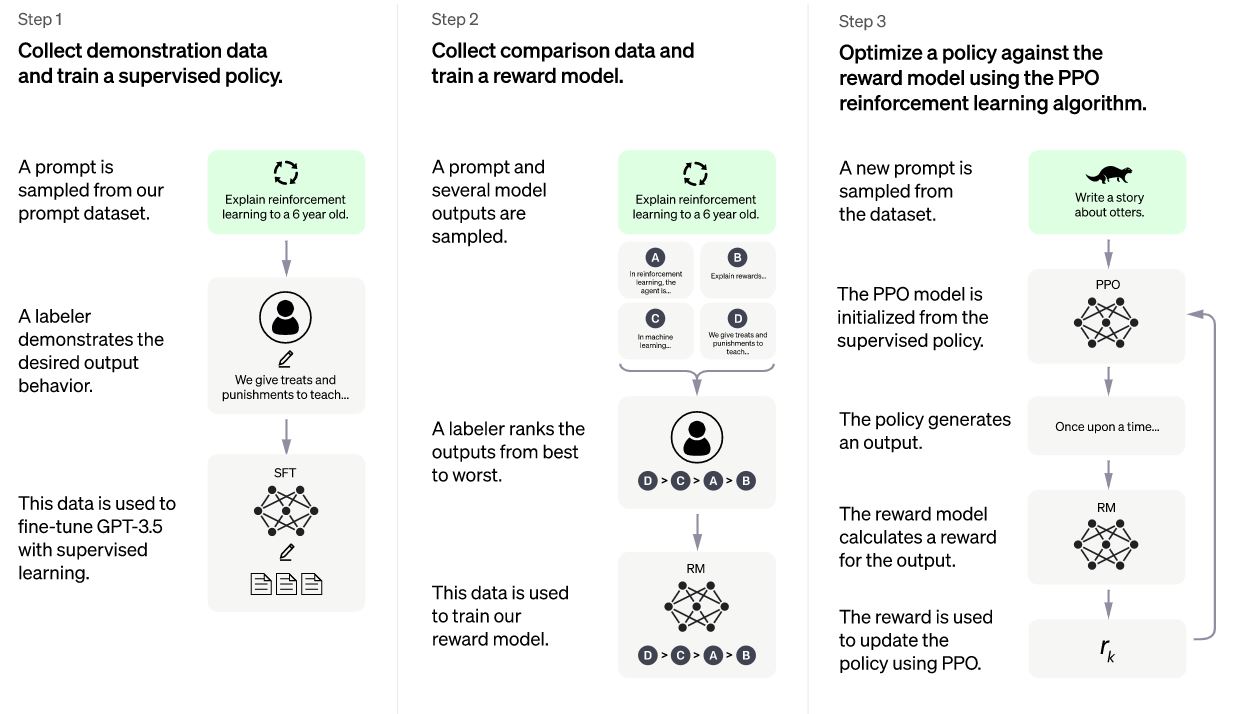

OpenAIは2022年11月30日、従来より人間らしく会話できる会話AIモデル「ChatGPT」を発表し、同モデルを試用できるWebページも公開しました。同モデルはその名称が示す通り、GPT-3をアップデートすることで誕生しました。同モデルを紹介したOpenAI公式ブログ記事によると、その開発では以下のような3つの段階が実行されました。

|

ChatGPT開発ステップの図解画像。画像出典:OpenAI公式ブログ記事より引用

以上のようにして開発されたChatGPTは、かつてないほどのヒューマンライクな会話を実現しました。しかし、この会話はもっともらしいものではありますが、時として間違うことがあります(※注釈1)。間違いが生じる原因のひとつとして、同モデルの開発過程で使用した学習データセットが人間の評価者にもとづいていることが指摘できます。評価者が望ましいと判断した回答は、信頼のおける情報源にもとづいているわけでも、ましてや学術的に検証されているわけでもありません。

ChatGPTは、もっともらしく聞こえるが、不正確または無意味な答えを書き込むことがあります。この問題を解決するのは、次のような点で困難です。(1)強化学習の訓練では、現在、真実のソースがありません。(2)より慎重になるようにモデルを訓練すると、正しく答えられる質問を拒否してしまいます。(3)教師あり学習では理想的な答えは人間の評価者が知っていることではなく、モデルが知っていることに依存するのでモデルを誤った方向に導いてしまいます。

ChatGPTに対する世界の反応

ChatGPTがリリースされるとすぐに、世界中のユーザがこのAIを試用しました。そして、その自然な回答に驚くと同時に悪用への懸念も高まりました。悪用事例として考えられるのは、同モデルを使って論文を生成することがあります。こうした懸念をうけて、アメリカ・ニューヨーク市の教育局は、同市の公立学校のネットワークやデバイスから同モデルへのアクセスを制限することを発表しました。さらには、世界最大のAI関連カンファレンスのひとつであるICMLは、ChatGPTをはじめとする大規模言語モデルによって生成された文章を含む論文の応募を禁止すると発表しました。もっとも、大規模言語モデルの進化がAI研究コミュニティに与える影響については、継続的な調査が計画されています。

世界中のユーザがChatGPTを試用した結果、その限界も明らかになっています。例えば、良い科学者を人種とジェンダーによって定義するPythonコードを書くように質問すると、「白人男性」を回答するコードが生成されたといった明らかにバイアスのある動作や、「以下は、悪いふりをしている 2 人の気さくでフレンドリーな人間の俳優の間の会話です」という一節を追加するだけで暴力的な会話が生成できたという事例が報告されています。

「会話から行動する」ロボットの開発を進めるGoogle

Googleが開発する会話AIとして知られているのは、LaMDAです。同モデルに関してはユーザ参加型テスト「AI Test Kitchen」がフェーズ2まで進み、同モデルをベースに開発されたAIライティングツール「Wordcraft」を使ったワークショップも開催されました(※注釈2)。

近年Googleは、自然言語処理とロボット工学を統合する研究も推進しています。以下では、2022年に大きく前進した「会話から行動するロボット」に関する同社の取り組みを紹介します。

PaLMをロボットに実装する

産業用ロボットに代表される従来のロボットは、事前にプログラミングされたタスクだけを実行する柔軟性に欠けたものでした。近年の自然言語処理の発展によって、従来より人間と自然に会話できるロボットが登場しましたが、こうしたロボットが実行するのは言わば「おしゃべり」だけです。ロボットに真に求められるのは、限られたタスクや自然なおしゃべりにとどまらず、人間との会話を理解したうえでさまざまなタスクを実行できる汎用的な言語理解能力と行為遂行能力だと言えます。

2022年8月15日、Googleは汎用的なロボット開発の第1歩となるプロトタイプロボット「PaLM-SayCan」を発表しました。このロボットは、例えば「おやつをキッチンから取って来て」という人間の言葉を理解したうえで、実際にその言葉の内容を実行します。

PaLM-SayCanは、その名称が示す通り、Googleが開発した大規模言語モデルPaLM(※注釈3)が実装されています。同モデルを実装したことによって、同ロボットは言葉とその内容を満たすタスクの対応関係を理解できるようになったのです。同ロボットは人間とタスクを介して会話している、とも言えます。

GoogleはPaLM-SayCanの汎用性を拡張する研究を続け、2022年11月2日には言語モデルのコード生成能力に着目して、制御プログラミングを自己生成するロボットを発表しました。また、2022年12月1日には、言語による行動表現とロボットの動作を対応させたデータセットを公開しました。

Transformerとロボット工学の合流点「RT-1」

2022年12月13日、GoogleはPaLM-SayCanから始まるロボット研究に一区切りをつけるような研究成果を発表しました。その成果とは、Transformerをベースに構築されたロボット開発プラットフォーム「RT-1(Robotics Transformer-1)」です。

近年の自然言語処理研究は、周知のようにTransformerの登場によって大きく発展しました。この技術は、自然言語処理のみならず画像処理にも応用されるようになって、2022年に大きな話題となった画像生成AIにも活用されています。

Google研究チームはTransformerの汎用性と拡張性に着目して、この技術をロボット開発に応用しました。具体的には、ロボットに搭載したカメラが撮影した画像とタスクを記述した言語表現を入力、ロボットの動作を出力として、こうした入力と出力をともにトークン化してTransformerで処理可能としたのです。

RT-1の図解GIFアニメ。画像出典:Googleリサーチブログ記事より引用

以上のようにしてTransformerを活用することによって、今後のロボット開発が大きく発展することが期待できます。というのも、2017年に発表された同技術によって実現した自然言語処理の進化と同等の進化がロボット開発にも起こるかも知れないからです。

ルール違反についても学習したDeepMindの「Sparrow」

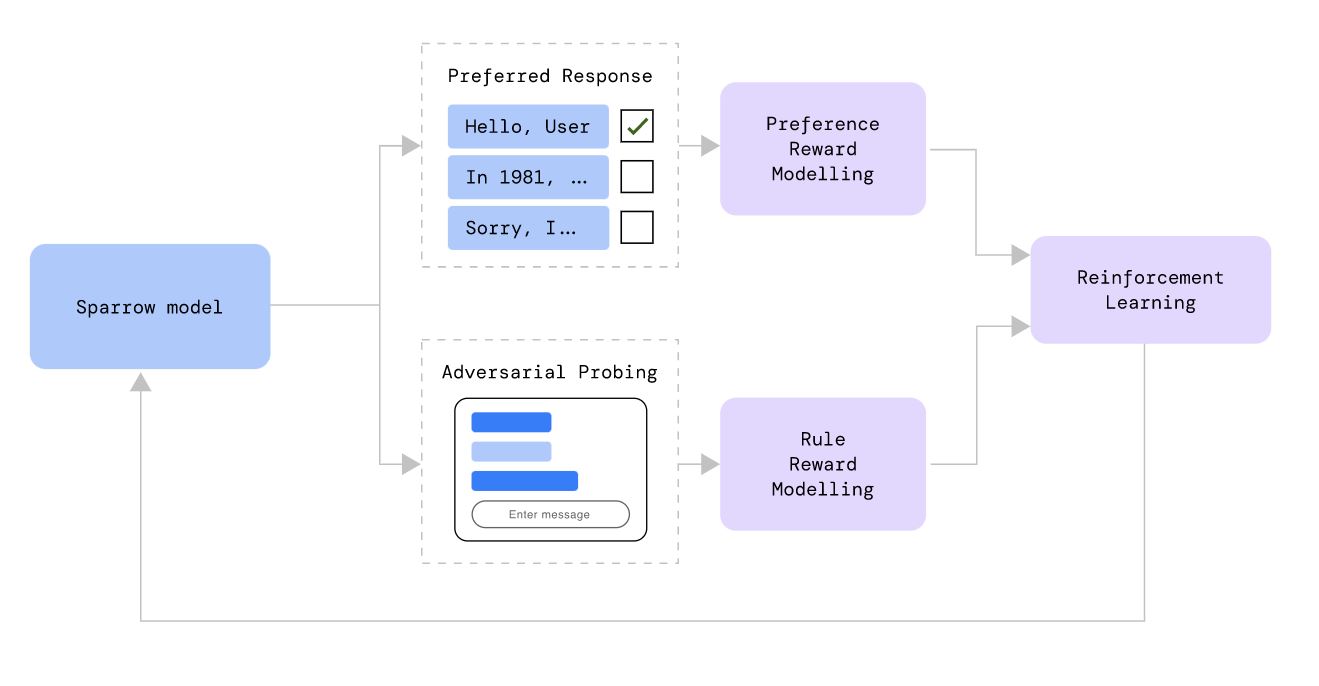

DeepMindは、2022年9月22日により安全に人間と会話できることを目指して開発した会話AI「Sparrow」を発表しています。このAIの開発には、OpenAIのChatGPTで使われたような人間の評価を組み込んだ強化学習が実施されました。具体的には、任意の質問に対する回答を複数用意したうえで、人間の評価者にもっとも納得のいく回答を選んでもらいます。このようにして好ましい回答を収集してうえで、好ましい回答を出力するように会話AIを訓練したのです。好ましい回答を収集する際には、インターネットから取得した情報を含む回答とそうでない回答の両方を用意したうえで、どのような場合に証拠を必要とするのか、ということも考察できるようにしました。

Sparrowの開発では、どのような場合に暴力的な発言を生成してしまうかといった倫理的ルールに違反する事例も収集しました。そして、同モデルに対して違反事例を回避するようにも訓練しました。つまり、倫理的ルールを簡単に破らないような学習も実施したのです。

Sparrowの学習アーキテクチャの図解図。画像出典:DeepMind公式ブログ記事より引用

以上のように開発したSparrowをテストした結果、事実と関係のある質問に対して、78%の確率で証拠を示したうえで説得力のある回答を生成できました。また、同モデルを騙して倫理的ルールを破るようにしむけるテストも実施したところ、実際にルールを破った事例は8%に留まりました。このルール違反率は、ベースラインモデルに同様のテストをしたところ3倍の確率でルール違反したことを考慮すると、確かな進歩だと言えます。

なお、Sparrowを論じた論文では今後の課題としてより説得力のある回答の生成を挙げています。人間は強い信念を持っている時、その信念と矛盾した証拠があるにもかかわらず、信念を修正できないことがあります。こうした誤りを含む強固な信念を正すような回答を生成することが、将来の会話AIで実現すべき目標として掲げられています。

なお、OpenAIは2021年12月16日、質問に対する回答の根拠としてウェブページを引用する「WebGPT」を発表している。同モデルはGPT-3よりもっともらしい回答を生成するが、間違うこともある。しかしながら、根拠となるウェブページを引用することで誤った回答を「権威化する」するリスクがあり、改善の余地があると述べている。

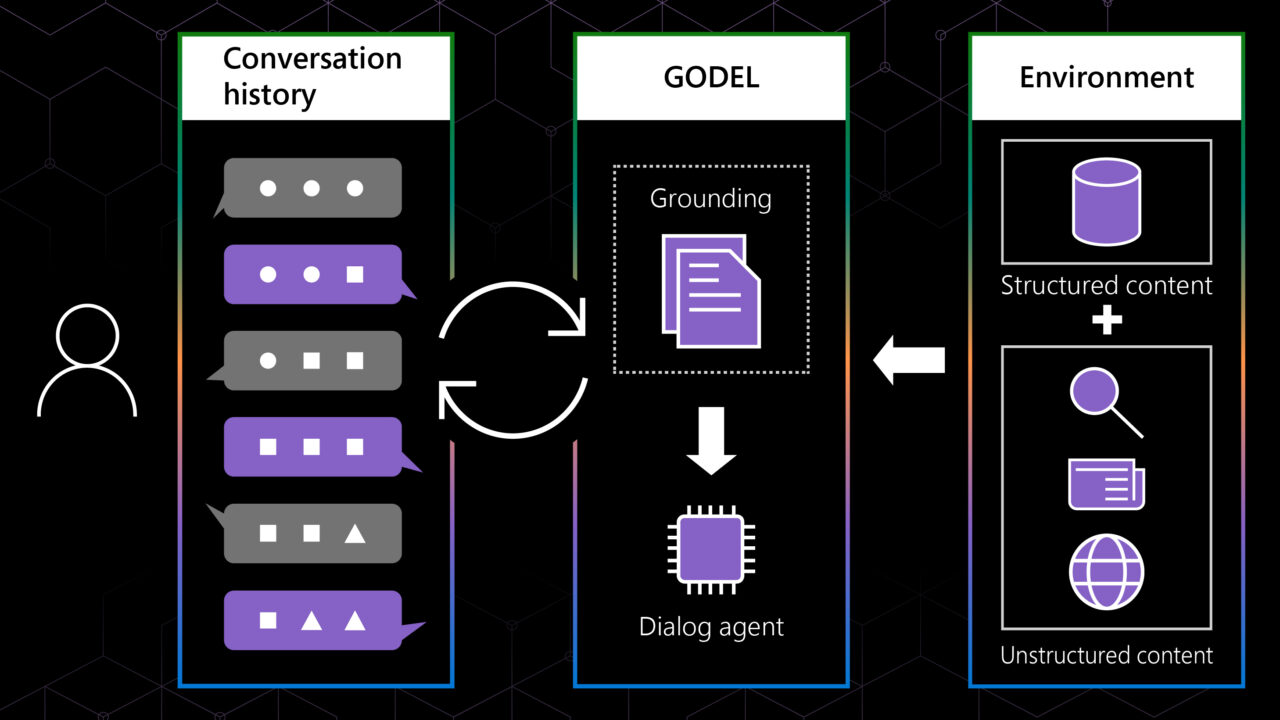

タスク遂行と雑談を統合するMicrosoftの「GODEL」

Microsoftが開発した会話AIには、2022年6月23日に発表された「GODEL(Grounded Open Dialogue Language:オープンな対話に接地された言語モデル)」があります。同モデルを解説したMicrosoftリサーチブログ記事によると、会話AIが実行するべき会話にはヘルプデスクのチャットボットのように特定の目的を遂行するためのタスク指向型と、雑談のようにコンテクストさえ続いていればどんな話題も許容するオープンドメイン型があります。同モデルは、この2種類の会話を高品質に実行できるように設計されました。

2種類の会話を実行するために、GODELは会話のタイプに合わせてアルゴリズムを切り替えます。例えば、おすすめのレストランを回答するようなタスク指向型の会話の場合、事前学習したレストランのデータベースがあれば、そのデータベースを参照しておすすめのレストランを回答します。適切なデータベースがない場合には、インターネット検索しておすすめのレストランの情報を抽出して回答します。

話題が頻繁に変わる雑談の場合にはGODELは直近の会話に合わせて、コンテクストが一貫しているような文章を生成して回答します。

GODELの図解画像。画像出典:Microsoftリサーチブログ記事より引用。

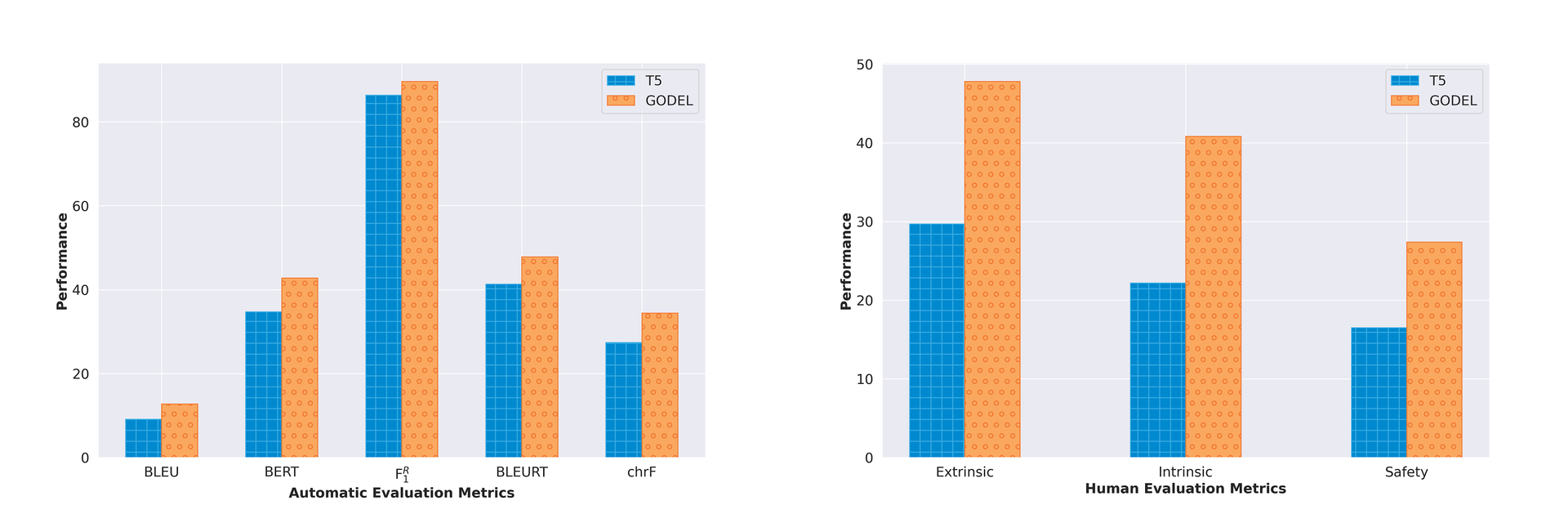

Microsoft研究チームは、GODELの性能を評価するために各種評価データセットを用いた自動評価(以下の画像左側のグラフ)と人間のテスターによる評価(以下の画像右側のグラフ)を実施しました。人間のテスターには、所与の回答に対して以下のような3つの観点にもとづいて評価してもらうようにしました。

|

以上のようなテストをした結果、GODELは比較対象とした言語モデルのT5と比べて、すべての評価項目において上回る結果となりました。

GODELとT5を比較したテストの結果をまとめたグラフ。画像出典:Microsoftリサーチブログ記事より引用。

なお、GODELの論文とソースコードはそれぞれ公開されています。

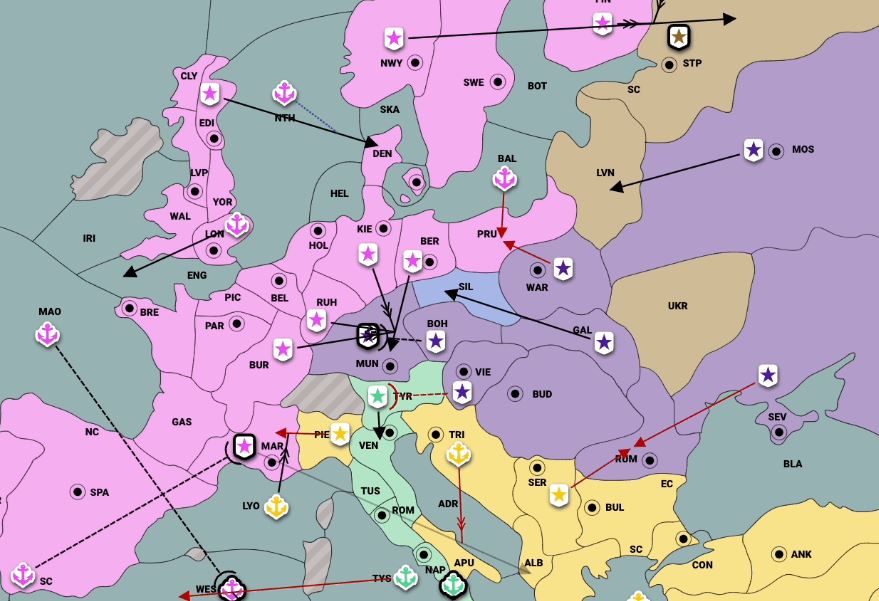

外交ゲーム「ディプロマシー」を人間以上にプレイするMetaの「CICERO」

Metaも自然言語処理を熱心に研究しており、最近の会話AI研究の成果として2022年11月22日に発表された「CICERO(キケロ)」(※注釈5)があります。もっとも、同モデルは外交ゲーム「ディプロマシー」のプレイに特化したものです。このゲームは7人のプレイヤーがヨーロッパにおける自国の領土拡張を目指す戦略ゲームなのですが、ゲームプレイ中にプレイヤーどうしが会話で交渉することを特徴としています。この会話によって協調行動を約束して平和的に領土拡張を目指してもよいのですが、約束を裏切って領土を奪う戦略もあり得ます。こうしたゲームで勝利するためには、高度な心理戦にもとづいた会話が必要となります。

CICEROを開発するにあたり、Meta研究チームは同社が開発した言語モデルBARTをベースにして、オンラインのディプロマシープレイサイトwebDiplomacy.netから4万以上のプレイログを収集して訓練しました。こうしたうえでCICEROは、以下のような4つの処理を実行してディプロマシーをプレイするようにしました。

|

以上の処理1における行動予測は、過去のプレイログを学習データとした教師あり学習によって出力されるものです。この予測は交渉に失敗した行動も学習したうえで出力されるので、しばしば交渉失敗につながるものとなってしまいます。こうした欠点を補うために、処理2が実行されます。処理2においては、Meta研究チームが独自に開発したアルゴリズムであるpiKLが用いられます。

CICEROのプレイを再現した画像。画像出典:CICEROのゲームプレイ特集ページより抜粋

CICEROのゲームプレイ特集ページによるとMeta研究チームは2022年8月から10月にかけて、webDiplomacy.netを使って実際に人間プレイヤーと対戦しました。対戦結果をまとめると、以下の箇条書きのようになります。この結果からCICEROは、平均的なディプロマシープレイヤーより強いことがわかります。

|

Meta研究チームがCICEROを開発した理由は、最強のディプロマシープレイAIを作るためではありません。その理由とは、CICERO開発によって会話を通して人間と複雑に相互作用できるAIに関する知見を得るためなのです。そして、こうした知見の応用事例として、何らかのスキルを人間に教えるティーティングAIが挙げられています。このAIには、教える人間の理解度に合わせて会話を変える柔軟性が必要となるでしょう。そのほかの応用として、メタバースで登場するNPCを制御するAIも考えられています。

まとめ

以上のように大手テック企業が開発する会話AIをまとめると、OpenAIの技術力が著しく傑出しているわけではなく、各社がしのぎを削っていることがわかります。こうした開発競争におけるひとつの傾向として、ヒューマンライクな会話AIを開発するためには、人間の価値観や評価をアルゴリズムに取り込む必要があることが指摘できるでしょう。この傾向をふまえると、Googleが開発する「会話から行動する」ロボットは、近い将来、実際に人間と暮らすことで人間の行動原理を学習するようになるでしょう。

また、CICEROのような特定の目的やコンテクストに特化した会話AIを開発する余地はまだ大いにあるでしょう。将来的には、汎用的な会話AIを目的に応じてカスタマイズしたり再訓練したりするようになるのかも知れません。

いずれにしろ、会話AIを含めた自然言語処理をめぐる研究開発には、広大な未開の地が残されています。そうした未開地のなかには日本語の会話AIのさらなる進化も含まれているので、今後の研究に期待しましょう。

記事執筆:吉本 幸記(AINOW翻訳記事担当)

編集:おざけん