生成AIの急速な普及によって、インターネットにはAIが生成したテキストが氾濫することになりました。こうしたなか、現状では任意のテキストがAIが生成したものか否かを識別するAI検出器がいまだ不完全です。それゆえ、今後インターネット上のデータを収集して学習データを作成する場合、AI生成テキストが含まれてしまいます。

AI生成テキストが学習データに含まれる場合、そうしたデータで訓練するとAIモデルが劣化する「モデル崩壊」が生じることが研究により明らかになりました。モデル崩壊を回避するためには、もはやインターネット上から学習データを収集するのを止めるべきです。

モデル崩壊を回避する方法には、インターネットからのデータ収集をやめるほかに、合成データを使うことが挙げられます。この文脈における合成データとは、AIによって学習データ用に生成されたデータを指します。こうしたデータは、インターネットから収集したデータより高品質となるポテンシャルがあります。もっとも、高品質な合成データを生成するには多大な人手を要するという欠点もあるので、「AI生成データが、新たな問題ではなく解決策をもたらすかどうか、もう少し様子を見なければならないだろう」とロメロ氏は述べています。

以下の翻訳記事では、日本語として読み易くするために原文記事にはなかった見出しを設けています。

なお、以下の記事本文はアルベルト・ロメロ氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、意訳やコンテクストを明確にするための補足を行っています。

大手AI企業はウェブ全体をスクレイピングし、今ではウェブを汚染する製品を販売している。

ChatGPTのようなモデルを商業化することの意外な結果とは、次のようなことだ。私たちユーザはインターネットを汚染し(※訳註1)、私たちも企業も、ウェブ上の「本物の」人間が作ったデータを信用できなくなっているのだ。

低品質なAI生成コンテンツの制作者が怠け者である点については、AINOW翻訳記事『こんなフレーズを見れば、AI生成コンテンツだと一目でわかる』も参照のこと。

この帰結は非常に大きなハードルとなっているのだが、これは今までに存在しなかったものだ。そして、企業は、次世代モデルを訓練するための新たなデータ源を緊急に必要としている。

AIが生み出すこの大きな汚染の洪水は、このテクノロジーを集団で使用することの必然的な効果である。軽く言ってしまえば、私たちは長期的な不都合(例えば、インターネットのデータが非常に信頼できなくなる)と短期的な利益(例えば、仕事の生産性向上)を交換しているのだ。こうした交換には、果たして価値があるのだろうか。

うまく行かないAI検出器

すぐに思いつく解決策のひとつは、AI検出器、つまり人間が作ったものとAIが作ったものを高い精度と信頼性で区別できる分類器である。これについては過去に何度か書いたが(※訳註2)、簡単に言えば、うまく行かないのだ。

独立した研究者だけでなく(※訳註3)、OpenAIやGoogleのような企業も信頼できる検出器を作ろうとしてきたが、効果はなかった。それは、彼らの努力が足りなかったということだろうか。別の記事で、信頼できるAI検知器によって、企業がユーザと同じように利益を得る理由を説明した。

「AIが生成したランダムなテキストが、何百万人ものユーザによってインターネット上に拡散されることは、教師にとっても良くないが、モデルを作っている企業にとっても良くない。しかし、それを正しく理解しようという強い動機があるにもかかわらず、最も人材が豊富で、大きな資金を持ち、AIに精通した企業でさえ、この問題を確実な信頼性をもって解決できていない(OpenAIは、正確さに欠けるとしてAI検出器を削除したが(※訳註4)、これは適切な動きだと私は考えている。この検出器を使用できたウェブページはもう見つからない。)」

「モデル崩壊」の確認

企業は、自社の利益のためにAI検出器を機能させる必要がある。検出不能に直面し、汚染されたデータ(つまり、人間が作成したと思われるデータだが、少なくとも部分的にはAIが作成したデータ)を使用した場合、「モデル崩壊」と呼ばれるモデルのパフォーマンスを低下させるリスクがある。

研究者たちがこうした訓練の失敗の影響を調査したところ、モデルの劣化が判明した(※訳註5)。

「モデルによって生成されたコンテンツを訓練に使用すると、結果として得られるモデルに不可逆的な欠陥が生じることがわかった。オリジナルコンテンツの分布の尾が消えるのだ。我々はこの効果をモデル崩壊と呼び、すべての学習済み生成モデルにおいて(それが)偏在していることを示す。ウェブからかき集めた大規模データから学習する利点を維持するためには、この効果を真剣に考慮する必要があることを示す。」

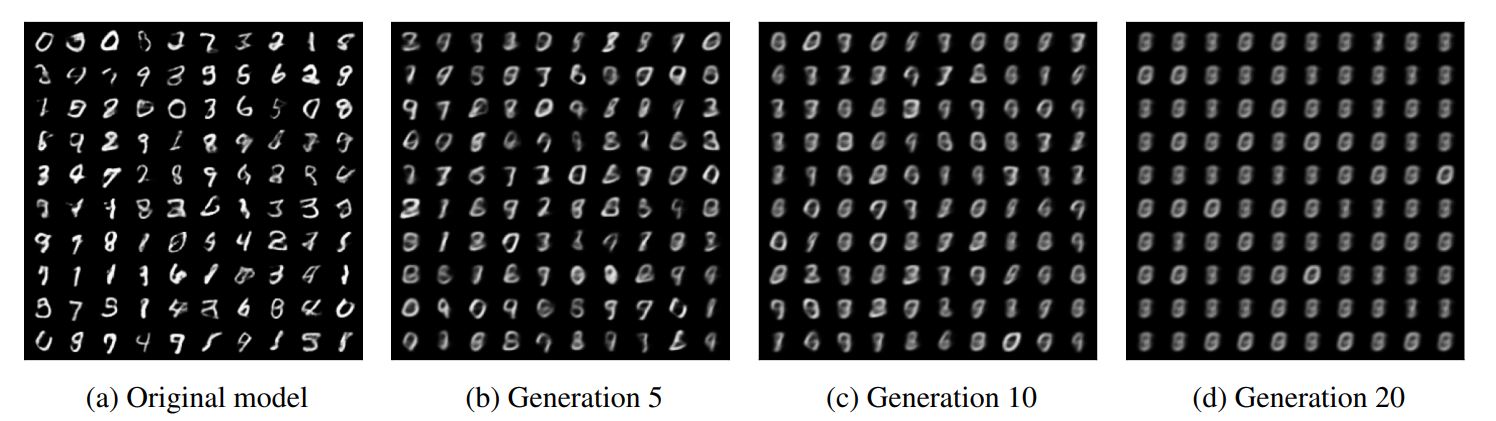

モデル崩壊の事例として、データからノイズを除去するVAE(Variational Autoencoder:変分自己符号器)を用いて実験した。実験手順は、以下の通り。

VAEを用いたモデル崩壊を実証する実験手順

|

以上の実験手順を繰り返した結果、20世代目では最初の数列画像と比較して数字の多様性が失われた画像が生成された。

VAEによる画像出力を20回繰り返した場合の数列画像の変遷

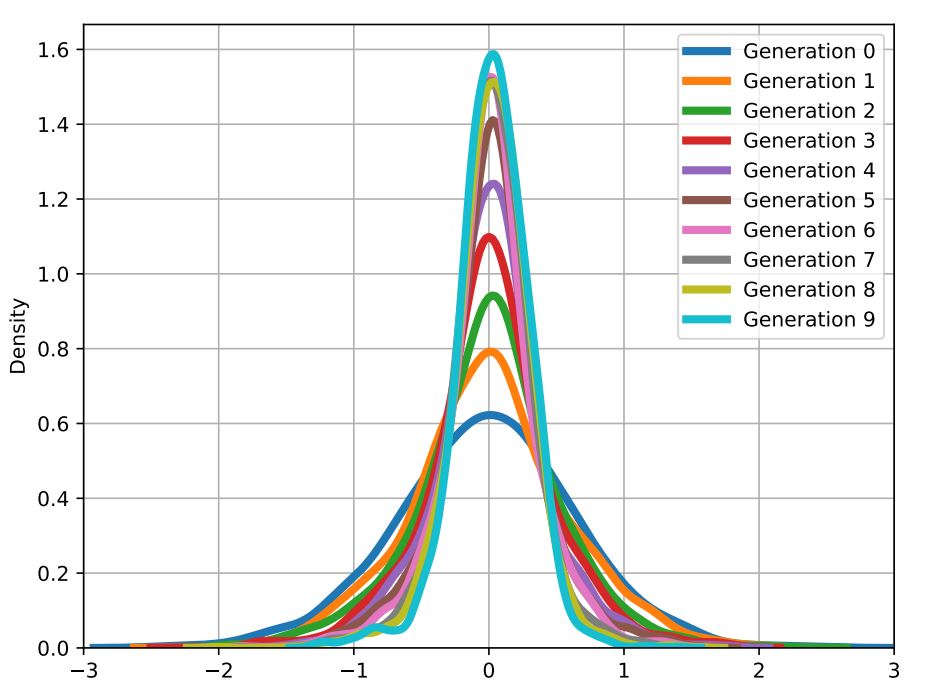

また、数列画像のデータ分布を画像生成の度にグラフ化して重ね合わせたところ、生成回数が多くなるにつれて、データ分布が平均に集まる一方で、両端(つまりデータ分布の尾)が短くなることも確認できた。

VAEによる画像出力を10回繰り返した場合のデータ分布の変遷

論文の著者の言葉を借りれば、「オリジナルコンテンツの分布の尾が消える」とき、新しいモデルが出力する生成物は時間の経過とともにますます平均的なものになり、よりつまらなく退屈で、最終的には人間が書くようなものとは関連付けられなくなる。共著者のロス・アンダーソン(Ross Anderson)がブログで書いているように、こうした劣化したモデルが「インターネットをつまらないもので埋め尽くす」ことになる。

「私たち人類が海にプラスチックゴミを撒き散らし、大気を二酸化炭素で満たしたように、今度はインターネットを退屈なもので埋め尽くそうとしている。こうした事態によって、ウェブをスクレイピングして新しいモデルを訓練することが難しくなるので、すでにモデルを訓練した企業や、ヒューマン・インターフェースへのアクセスを大規模に管理している企業が有利になる。」

状況を要約すると、以下のような3点にまとめられる。

第一に、インターネット上の人間が作ったデータは、少数の大手AI企業によって徹底的にかき集められた。その見返りに、私たちは彼らの製品でインターネットを汚染している。

第二に、人間が作ったデータとAIが作ったデータを見分けることを目的とした検出器が機能しないため、ウェブユーザはもはや本物と作られたものを見分けられない(※訳註6)。企業も同様だ。

第三に、OpenAIのようなモデルビルダーは、次世代モデルに供給するソース・データベースとしてインターネットを使用することを控えるべきである。というのも、汚染されたインターネット上のデータをモデルの訓練に使うとモデル崩壊を招き、モデルが劣化してしまうからだ。そして、劣化してしまったモデルは、もはや私たちとは相容れないものとなる。

合成データへの期待と課題

唯一の解決策は、合成データである。合成データは、人間が作成したデータを置き換えるだけでなく、その質を凌駕することさえできる。モデル同士が(人間の監督下で)会話するというのはSFのように聞こえるだろうが、MicrosoftやOpenAI、Cohereではすでに実現している。

合成データセットは、RedditやWikipediaのデータに見られるような制限を受けない。(また訓練のために会話する)モデルは、企業が必要とする限りターゲットを定めたままで(例えば、複雑な法律問題や専門的な医療分析に関するやり取り全体などのような)あらゆるトピックについて話すように誘導できる。それらのモデルは疲れず、感情的に反応せず、指示に忠実に従う…。それらはまだ混乱(して幻覚を出力)したりもするが、ループ内の人間は不正確さや事実誤認を取り除くために、後から(モデルを)チェックしたり編集したりできる。

ちなみに合成データはモデルによって作成されるため、合成データ生成モデルを使う企業は、同意、帰属、補償をしなくても著作権で保護されたデータをスクレイピングすることによる違法行為(※訳註7)を回避できる。

合成データが人間によって作成されたデータよりも優れていることが判明すれば(それを疑う批評家もいるが)、合成データの活用は、OpenAIや他の大手企業にとって完璧な動きとなるだろう。

しかしながら、このアプローチには以下のようないくつかの疑問が生じる。

- 合成データを注意深く管理できるのか。AIがフィルターにかけられずに会話している間に、ループ内の人間はAIが犯す間違いをすべて検出できるのか(混乱は解決不可能とも思われていることを覚えておいてほしい)。(※訳註8)

- このようなゆっくりとした骨の折れるプロセスによって(作成は速いがチェックや編集はそうは行かない)、人間が作成したデータの不足を補うだけのデータを作成できるのだろうか。

- 合成データによる訓練はファインチューニングとして機能するのか、それとも事前訓練(これには桁違いに多くのデータを必要とする)に取って代わることができるのか。

- 誰が合成データを作成するのだろうか(※訳註9)。

学習データをめぐって生じるハードルは実に高い。AI生成データが、新たな問題ではなく解決策をもたらすかどうか、もう少し様子を見なければならないだろう。

・・・

この記事は、AI、アルゴリズム、そして人々のあいだのギャップを埋めるための教育的ニュースレター「The Algorithmic Bridge」からの抜粋です。このニュースレターはAIがあなたの生活に与える影響を理解し、未来をより良くナビゲートするためのツールを開発するのに役立つでしょう。

Mediumのメンバーになって、私の仕事をサポートすることもできます。サポートはこちらから。

原文

『AI Companies Have Exhausted Human-Made Data. They’re Now Using AI to Make More』

著者

アルベルト・ロメロ(Alberto Romero)

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1、生成AIパスポート、JDLA Generative AI Test 2023 #2取得)

編集

おざけん