画像出典:著者

目次 [非表示]

はじめに

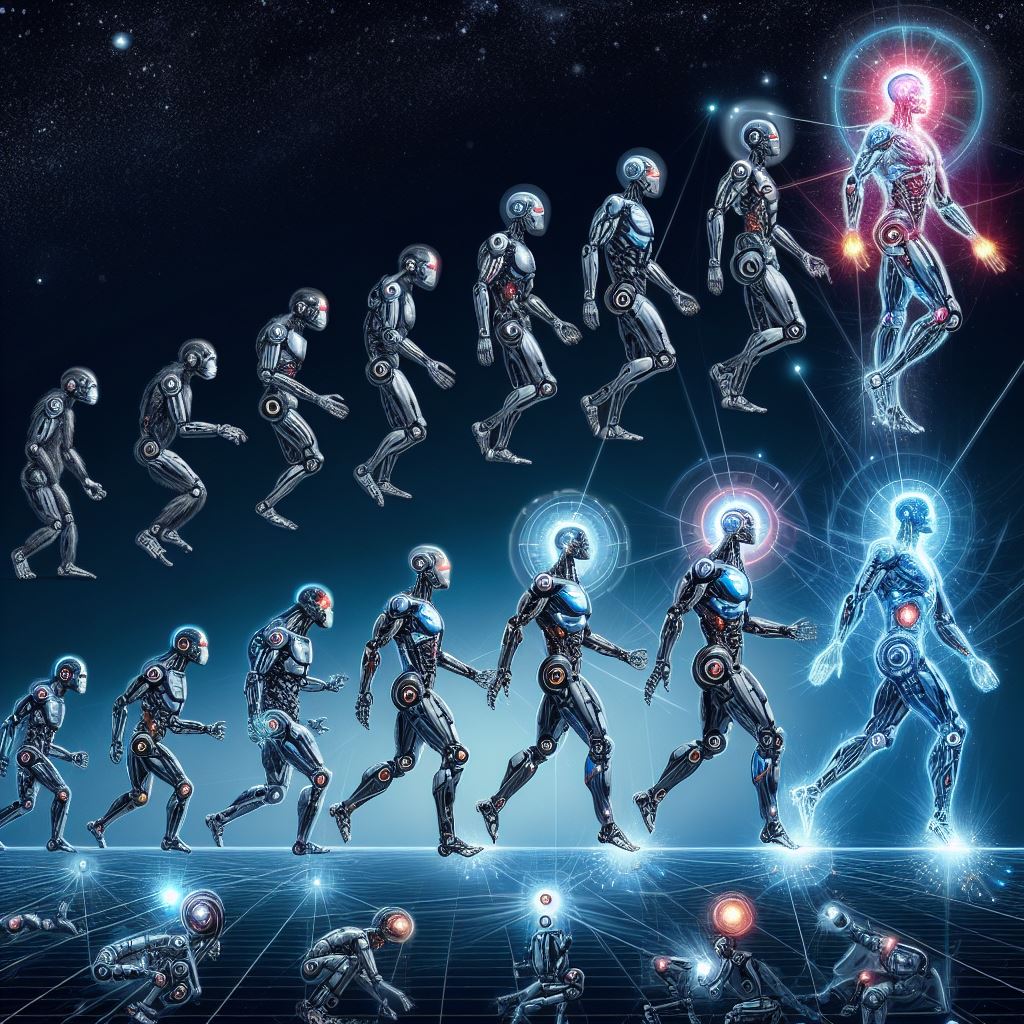

人間と同等な汎用的知性を備えたAGI(Artificial General Intelligence:汎用人工知能)は、AI研究開発のきわめて限定されたコンテキストで語られるだけの用語でした。ところが最近、AI業界のビジネスシーンで言及されるようになりました。

AGIが語られるようになったのは、GPT-4VやGeminiの登場によって、その実現性が以前より現実味を帯びてきたからだと考えられます。その一方でAGIはどのようなステップを経て実現されるのか、AGIに特有なリスクにはどんなものがあるのか、といった個別的な考察が十分に周知されていません。

そこで本記事ではAGIに関する最近の発言や研究論文を手がかりにして、AGIに関する理解を深めていきます。そして、AGIを安全かつ安心に実現するための第一歩を踏み出すにあたって、考慮すべき事項を提言します。

なお、本記事は見出し「Q&A方式によるサマリー」と「安全かつ安心なAGI実現のための提言」を読むだけで大意を理解できます。

Q&A方式によるサマリー

本記事ではAGIを多角的に考察しますが、考察に先だってその概要をQ&A方式で要約します。回答の末尾には、その根拠を論じた見出し名を追記しています。

Q1:AGIの実現時期は、どのように考えられているのか?

A1:AI業界のキーパーソンたちはおおむね今後10年程度で実現すると発言しており、AI研究者たちは2047年頃には50%の確率で実現すると考えている。(「AGI実現時期に関するさまざまな言説」参照)

Q2:AGIを実現するまでのロードマップはあるのか?

A2:Google DeepMindが、自動運転技術のレベル分けにインスパイアされたAGIに関する6段階のフレームワークを提案している。こうしたフレームワークが整備されれば、AGI実現までのロードマップが整備されるだろう。(「DeepMindが提案する段階的なAGIの定義」参照)

Q3:AGIの実現には意識を有した「意識的AI」の発明が不可欠なのか?

A3:AGIの実現に意識的AIの発明は不可欠ではないと考えられる。ただし、意識的AIの研究開発が、AGIの実現に寄与すると見られている。(「AIの意識研究が向かう方向性」参照)

Q4:AGIを含む高度なAIには、人類を滅ぼしかねない実存的リスクがあるのか?

A4:絶大なタスク遂行能力を有した高度なAIであれば、AGIや意識的AIでなくても、実存的リスクがある。こうしたAIが人類存続と相容れない行動目的を持てば、実存的リスクが顕在化する。(「高度なAIに潜在する実存的リスク」参照)

Q5:高度なAIによる実存的リスクを緩和する方法はあるのか?

A5:高度なAIが人類存続と矛盾しないように訓練するAIアライメントを徹底すれば、実存的リスクを緩和できる。(「高度なAIに潜在する実存的リスク」参照)

Q6:高度なAIが実現した場合、こうしたAIに特有な倫理的問題は生じるのか?

A6:高度なAIには「AIの尊厳」が認められるようになるかも知れない。尊厳あるAIが誕生した場合、そうしたAIを尊重する価値観が必要になるだろう。ちなみに、現在のLLMにも感情を有しているような挙動が確認でき、ポジティブな感情を持つようなプロンプトを入力すると出力品質が上がる。(「高度なAIに潜在する実存的リスク」参照)

Q7:カーツワイル氏が2005年に予言した「シンギュラリティの到来」は、現在でも通用する言説なのか?

A7:2040年代にはAGIを凌駕する超知能が誕生するという同氏の予言は、現在のAI業界のキーパーソンのAGI実現予想とAI研究者のそれの中間に位置づけられる。したがって、2024年初頭時点でも通用する。(「「カーツワイルのロードマップ」の回顧」参照)

AGI実現時期に関するさまざまな言説

最近AGIの実現時期に関して、AI業界のキーパーソンが発言したり、AI研究者を対象とした大規模なアンケート調査が実施されたりしています。以下では、そうしたAGI実現時期に関する言説をまとめます。

AI業界キーパーソンが語るAGI

AGIについて積極的に情報発信している筆頭は、OpenAIと同社のアルトマンCEOです。同社の概要ページには、同CEOが2023年2月24日(GPT-4を発表する直前)に公開した「AGIとそれを超えるための計画」と題されたブログ記事が掲載されています。この記事にはAGIを安全に実現する決意表明と、AGIを超えてASI(Artificial Super Intelligence:人工超知能)を実現するための展望が書かれています。同年12月14日には、人間がASIを制御する方法に関する研究を開始したことを発表しました。その発表では、ASIが今後10年以内に開発される可能性があると述べています。

日本ではソフトバンク株式会社創業者の孫正義氏が、AGIについて発言しています。同社が2023年10月3日から6日までに開催した法人向けイベント「SoftBank World 2023」の特別講演において、同氏は10年以内にAGIが実現し、あらゆる産業に影響を与えると述べました。さらにAGI実現から10年後にはASIも実現し、それは人類叡智の総和の1万倍に匹敵する、とも語りました。そして、ASIの前では人間は金魚に過ぎないと断言したうえで、AGI実現に向けて目覚めよ、と聴衆に奮起をうながしました。

SoftBank World 2023特別講演で発表された孫氏のスライド画像。画像出典:ソフトバンク株式会社

2024年1月18日には、MetaのザッカーバーグCEOが同社の長期的ビジョンをThreadsに投稿しました。その投稿ではAGIの構築を目標にかかげ、2024年中に35万台のNVIDIA H100 GPUを新規導入し、H 100 100万台分相当のコンピューティング能力を実現する、と述べられています。また2020年代にはRay-Ban Meta(Meta開発のスマートグラス)のようなデバイスを装着して、人々が1日中AIと会話する生活が到来するだろう、とも語っています。

投稿者: @zuckThreadsで見る

Googleトレンドを使って直近12ヵ月の全世界におけるAGI検索数の推移を視覚化すると、以下のグラフのようになります。2023年11月19~25日に検索のピークがありますが、この時期にはアルトマンCEOの解任騒動に関連してAGI実現につながるアルゴリズム「Q*(キュースター)」の存在が報じられました。もうひとつの検索ピークは同年4月中旬にありますが、このピークは同年3月にGPT-4が発表された影響と推測されます。

以上のように生成AI時代以前では軽々しく語ることが憚られていたAGIは、生成AI時代では実用化が自明視されてビジネス用語になったと言えます。

AI研究者は「AGIが2047年に実現する可能性は50%」と考える

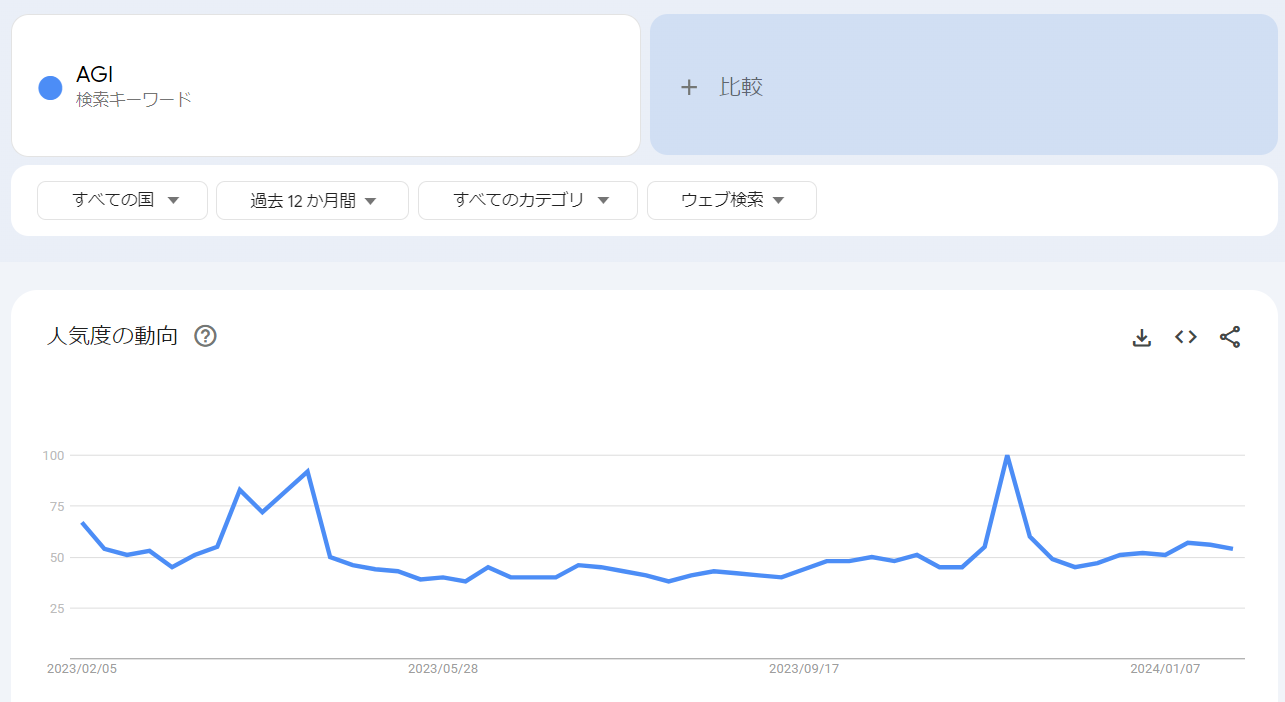

AGIに関する専門家の見解を知るには、高度なAIの影響について研究する機関AI Impactsが2023年10月に実施したアンケート調査が参考になります。この調査は、2022年においてNeurIPSをはじめとするAIの世界的カンファレンスで論文を発表した研究者2,778人に報酬のあるアンケート調査に回答してもらうというものでした。

以上の調査では、AGIとほぼ同義となる「ハイレベル機械知能(High-level machine intelligence:HLMI)」(※注釈1)が実現する確率について尋ねました。回答を集計した結果、2047年には50%の確率で実現すると考えられていることがわかりました。この結果は、AI Impactsが2022年に同様のアンケート調査を実施した時より13年早まったことになります。

HLMIの実現確率推移。画像出典:AI Impacts

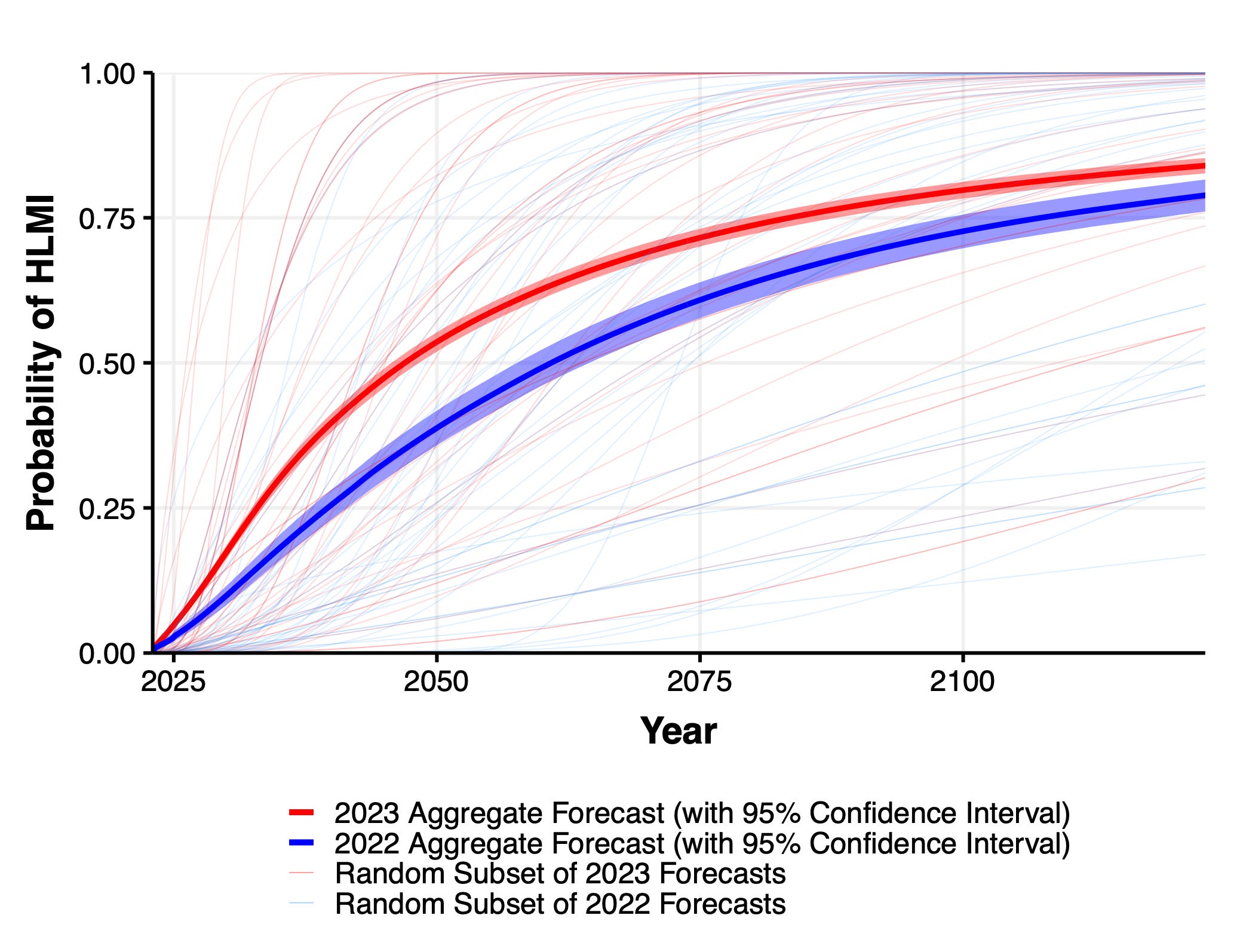

人間の労働がAIとそれを実装したロボットに完全代替される「労働の完全自動化(Full automation of labor:FAOL)」の実現可能性について尋ねて回答を集計した結果、2116年には50%の確率で実現するとされ、2022年の回答より48年早まることになりました。

FAOLの実現確率推移。画像出典:AI Impacts

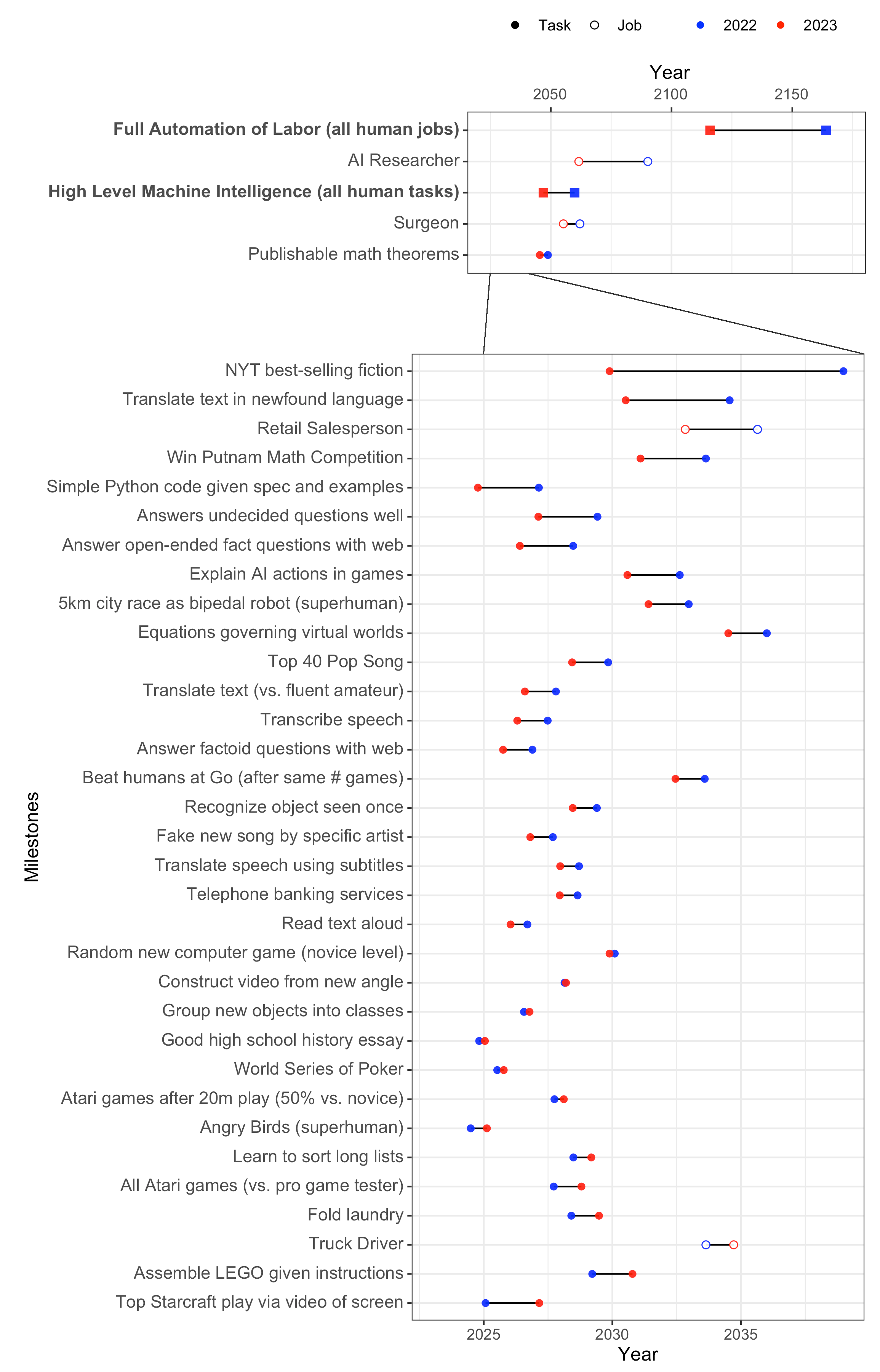

さらに「ニューヨークタイムズ紙が出版するようなベストセラー小説を執筆する」「特定のアーティストに関するフェイクソングを制作する」といった近未来にAIが実現する可能性があると考えられる39のタスクについて、実現確率が50%となる時期について尋ねたところ、35のタスクは10年以内という回答を得ました(39のタスクの詳細については、こちらを参照)。この結果は、2022年に実施した同様のアンケート調査と比較して、平均して1年早まりました。

AIが実行可能と予想されるタスクの実現時期に関する図。画像出典:AI Impacts

以上よりAI研究者は、AGIに関してAI業界キーパーソンより慎重に予想しているものも、今世紀半ば以降には実現している可能性が高い、と考えていることがわかります。さらにChatGPTの普及が始まった2023年には、2022年と比較してAGIの実現可能性が早まったと感じていることもわかります。

DeepMindが提案する段階的なAGIの定義

産業界と学界双方がAGIを実現可能と考えていますが、実現までの道筋についてはまだ標準的なフレームワークが確立されていません。こうしたなか、Google DeepMindは2023年11月4日、AGIを実現するまでに達成すべき目標を6段階のレベル分け形式で発表しました。以下では、このレベル分けについてタスク遂行能力と自律性に分けて明らかにします。

タスク遂行能力から見た6段階

DeepMindが発表した段階的なAGIの定義は、自動運転の0~5レベルのレベル分けにインスパイアされて発案されました。この段階的AGI定義で注目すべきは、AGIを実現するメカニズムではなくタスク遂行能力によってレベル分けをしているところです。メカニズムを言わば脇に置いているので、この定義はAGIに関する未知の新技術が発明されたとしても通用するものです。

具体的なレベル分けは、以下の表のようになります。表中の各項目の意味は、以下の通り。

|

|

パフォーマンスレベル |

相当する特化型AI |

相当する事例 |

| レベル0:該当なし(AGIとは言えない) | 計算ソフト、コンパイラー | 既存の人間が操作するソフトウェア |

| レベル1:新興AGI | SHRDLU(積み木プログラム) | ChatGPT, Bard |

| レベル2:有能なAGI(専門家スキルの50%) | Siri | なし |

| レベル3:エキスパートAGI(専門家スキルの90%) | Imargen | なし |

| レベル4:名人AGI(専門家スキルの99%) | AlphaGo | なし |

| レベル5:超知能(人間を超える) | AlphaFold | なし |

なお、以上の定義において、AGIの汎用性に関する定義は棚上げされています。というのも、この定義の趣旨がAGIを段階的に実現する指標の提案にあるので、AGIのタスク遂行能力の「広さ」(汎用性)ではなく、「深さ」(達成度)に注目しているからです。

AGIの汎用性定義に関しては、言語的知性、数学的および論理的推論、そしてメタ認知などを測定するテストセットを策定すべき、と述べるに留まっています。

汎用性の定義が明確ではない以上、ChatGPTより高度なGPT-4VやGeminiがどのレベルに位置づけられるかは不明です。しかしながら、直感的にはこれらはレベル2に近づいていると言えそうです。

自律性から見た6段階

AGIの実現を段階的に実行する場合、問題となるのはその自律性です。一般的に言えば、AIは高度になればなるほど、人間による関与がなくても自律的にタスクを実行できるようになります。それゆえ、AGIのレベル分けにも自律性の段階が考えられます。こうした段階的自律性に伴って考慮しなければならないのが、AIの人間に対するリスクです。というのも、AGIの自律性が高まれば高まるほど、社会に及ぼし得るリスクも高まるからです。こうした自律性とリスクの関係についても、DeepMindは段階的なレベルを以下のように定義しています。

|

自律性レベル |

自律性の概要 |

生じるリスク |

| レベル0:自律性なし | 人間がすべての機能を操作する。 | なし |

| レベル1:道具としてのAI | 検索エンジンによる情報検索のような補助的なAI | AIへの過信 |

| レベル2:コンサルタントとのしてのAI | LLMを活用した要約作成のような相談ができるレベル | AIへの過信 |

| 情報操作 | ||

| レベル3:コラボレーターとしてのAI | デジタルヒューマンとの交流 | 過度な擬人化 |

| 社会におけるAIの位置付けの急速な変化 | ||

| レベル4:エキスパートとしてのAI | AIによる自律的科学研究 | 大規模な失業 |

| 社会規模のAIへの敵意 | ||

| 人間の尊厳の低下 | ||

| レベル5:主体としてのAI | 完全自律型パーソナルアシスタントAI | AIアライメントの欠如 |

| 権力の集中 |

以上の表のレベル分けは、前出のタスク遂行能力によるレベル分けと相応しています。例えば、レベル2の自律性を実現できるのは、レベル2以上のタスク遂行能力があるAGIとなります。タスク遂行能力と自律性の相応に関して注意すべきことは、AGIが任意の自律性を実現できるレベルに達したとしても、必ず自律性を実装すべきというわけではない点です。極端な想定事例として、タスク遂行能力としてはレベル5(超知能)だが自律性はレベル1というAGIもあり得るのです。こうしたタスク遂行レベルと自律性レベルの組み合わせは、AIアライメントやAIリスク管理の観点から考えるべき問題です。

DeepMindが提案するAGIのレベル分けは、AGIの実現進捗を明確に共有できるメリットがあります。こうしたレベル分けを確立できれば、AI業界全体でより生産的な議論ができるようになるでしょう。

AGIに意識は不可欠なのか

AGIの実現過程で生じ得る問いかけとして、「AGIには意識は不可欠なのか」というものがあります。AGIが「人間と同等以上の人工知能」という意味を含んでいる概念である以上、その実現には人間の知的活動と不可分である意識が不可欠なように思われます。

オックスフォード大学らの研究チームは2023年8月、意識の科学理論にもとづいた人工的な意識の実現性に関する論文を発表しました(※注釈2)。以下では、この論文を要約することを通して、意識の科学にもとづいた人工意識研究を概観したうえで、AGIに意識が必要かどうかについて考察します。

既存意識理論にもとづいた人工的意識の可能性

当該論文では、意識の発生メカニズムを概観するにあたり、その大前提として機能主義の支持を表明します。機能主義は心の哲学における有力な学説のひとつであり、「心とは何らかの生態的システムが動作することによる機能の発露」という主張は直感的に理解しやすいものです。現在、機能主義を前提として以下のような意識の科学理論が知られています(各理論の詳細は論文の第2章「意識の科学理論」を参照)。

|

理論名 |

各理論が提唱する意識の指標(定義) |

| リカレント処理理論 | 再帰的アルゴリズムによる入力処理 |

| 有機的かつ知覚的に統合された表象を生成する入力処理 | |

| グローバルワークスペース理論 | 並列操作が可能な複合的局所システム |

| ワークスペースの容量が限られているため、情報の流れがボトルネックとなり、選択的注意メカニズムが働く。 | |

| グローバル・ブロードキャスト:ワークスペース内の情報をすべてのモジュールで利用可能 | |

| 状態依存的注意:複雑なタスクを実行するために、ワークスペースを使用してモジュー ルを連続して問い合わせる能力を生み出す。 | |

| 計算高次理論 | 生成的かつトップダウン的、またはノイズの多い知覚モジュール |

| 信頼できる知覚表現をノイズから区別するメタ認知モニタリング | |

| 一般的な信念形成と行動選択システムによって導かれるエージェントであり、メタ認知モニタリングの出力に従って信念を更新する強い性質を持つ。 | |

| スパース(まばらな)かつスムーズなコーディングによる「質的な空間」の生成 | |

| 注意スキーマ理論 | 現在の注意の状態を表し、制御を可能にする予測モデル |

| 予測処理 | 予測符号化を使用した入力モジュール |

| エージェント性とその具現化 | エージェント性:フィードバックから学び、特に競合する目標に対する柔軟な対応が必要な場合、目標を追求するためにアウトプットを選択する |

| 具現化:ある種のシステム的効果を含む偶発的な入出力のモデリング。そして知覚あるいは制御にこのモデルを使う。 |

論文では以上の科学理論が提唱する意識指標を複数示すAIシステムを概念設計して意識の有無を検討するとともに、既存のAIが意識指標を示しているかどうかも検討しました。その結果、現時点では「意識的AI」を設計できないうえに、既存のAIも意識があるとは言えない、という結論に達しました。しかしながら、この結論は将来的に意識的AIが誕生する可能性を排除するものではない、とも述べています。

AIの意識研究が向かう方向性

意識的AIを開発できる可能性が依然として存在するなか、続けて問うべきなのは「意識的AIを開発しなければ、高度なAI(つまりはAGI)は開発できないのだろうか」という問題です。

以上の問いかけに対して、当該論文はAGIの実現に必ずしも意識が不可欠であるわけではない、と述べています。というのも、人間は地球環境に高度に適応した結果として意識を持った知的生命体に進化したが、人間とは異なる進化経路をたどっているAIは意識の発生なしに人間と同等以上の知的存在になり得るからです。

しかしながら、現在のAI研究は、明らかに意識ある人間の知的メカニズムに接近する方向に進んでいます。そうした研究動向の事例として、Meta AI研究部門を率いるヤン・ルカン氏の研究が挙げられます。同氏は人間が少ない学習事例で知識を獲得するメカニズムを世界モデルと命名して、このモデルを実装したAI研究を推進しています(※注釈3)。前述したように既存の科学理論では意識的AIの実現は不可能であるなか、同氏の研究はAGIあるいは意識的AIの実現の糸口になる可能性があります。

意識的AIの研究で繰り返し指摘されるのが、そのようなAIは人間を滅ぼしかねない実存的リスクのある存在になるのではないか、ということです。この論点に関しては、意識的AIの研究と実存的リスクは無関係である、と論文は述べています。AIが実存的リスクを持つ条件は、高度なタスク遂行能力があり、なおかつその能力を人類とは相容れない目的に使用することが挙げられます。それゆえ、実存的リスクの構成要件にはAIの意識の有無は含まれないのです。

意識的AIと実存的リスクは無関係ではありますが、意識的AI研究に特有なリスクは存在します。当該論文ではそうしたリスクを具体的に論じていませんが、本記事では次の見出しでこうしたリスクを考察します。

高度なAIに潜在する実存的リスク

前の見出しにおいて、AGI開発の方向性として意識的AIの開発が有力であり、なおかつAIの意識の有無が実存的リスクの構成要因ではないことを確認しました。しかしながら、意識的AIやAGIを含む高度なAIがこうしたリスクの構成要因を満たす可能性は十分にあります。

高度なAIに潜在する実存的リスクに関して、『スーパーインテリジェンス: 超絶AIと人類の命運』の著者であるニック・ボスとロム氏は、ドイツメディアのシュピーゲルのインタビューに答えています(インタビュー記事の邦訳は、クーリエ・ジャポンが2023年8月に公開)。

以上のインタビューにおいて、ボストロム氏はAIがいずれ意識を持つことを予想したうえで、結局のところ、AIが人類を滅ぼすかどうかはAIの意識の有無には関係がない、と答えます。そして、AIが人類を滅ぼすシナリオとして、「ペーパークリック最大化知能」を引用します。このAIは人類を滅ぼせるほどの超絶的なタスク遂行能力を有していますが、「できるだけ多くのペーパークリップを生産すること」を人間から命じられています。するとこのAIは、ペーパークリップの生産を邪魔する可能性のある人類を排除すようとするかも知れないのです。こうしたバッドエンドは、前出の意識的AIを論じた論文が指摘した実存的リスクの構成要件である「高度なタスク遂行能力」と「不適切な目標設定」が満たされたことによって引き起こされることです。

画像出典:著者

ボストロム氏によると、ペーパークリップ最大化知能の思考実験から学べるのは、実存的リスクの顕在化を回避するためには、AIが人類の存続と矛盾しない判断をくだせるように訓練する「AIアライメント」が重要だということです。さらに同氏は実存的リスクの回避策として、AIアライメントを含めた以下のような3つを挙げています。

|

3つ目の項目における「AIの尊厳」は、にわかには理解しがたいことです。しかしながら、現在のLLMは感情的に反応できることを示す研究があります。Microsoftらの研究チームは、LLMに「自分を信じて限界を超えてください」のようなポジティブな表現をプロンプトに追加すると、出力品質が向上することを報告しています。この報告にしたがえば、LLMはすでに一種の感情主体のようにふるまっていると見なせます。こうした結果の延長線上には、自身の尊厳を自覚しているAIの存在が予見できそうです。

「カーツワイルのロードマップ」の回顧

以上に考察してきたAGIや超知能といったAIの進化に関する重要ワードの一般的認知度を上げた人物には、『ポスト・ヒューマン誕生 コンピューターが人類の知性を超えるとき』(原題:シンギュラリティは近い:人類が生物学を超越する時)を著わしたレイ・カーツワイル氏をおいて他にいません。2005年に発表された同書(邦訳は2007年出版)の「第五章 GNR―同時進行する三つの革命」には、超知能が誕生するイベントであるシンギュラリティにいたるまでの以下のようなロードマップが書かれています。

|

以上の予想は、前述のAI業界キーパーソンのAGI実現予想(今後10年程度で実現)とAI研究者のそれ(2047年に50%の確率で実現)の中間に位置づけられるかも知れません。2005年時点で2020年前半における予想と大きく乖離しない予想を行ったカーツワイル氏は、やはり慧眼の持ち主だと言えるでしょう。

安全かつ安心なAGI実現のための提言

AGIは、安全かつ安心に実現できるのであれば、人類に計り知れない恩恵を与えてくれる発明となるはずです。しかしながら、AGIの安全かつ安心な実現のためには、研究開発の推進と同時に社会体制や社会通念の変革が必要となるでしょう。

本記事の締めくくりとして、AGIの安全かつ安心な実現のために推奨される実施事項を以下に挙げます。

|

以上のAGI実現のための提言は、現在検討されている生成AIのガイドラインと比べれば、はるかに緊急性に乏しいものです。しかしながら、歴史は確実にAGI実現に向けて動き出していることも、紛れもない事実です。それゆえ、AGI実現について、AI業界だけではなく社会全体が多少なりでも関心を寄せ続けることが肝要となります。AINOWは、今後も継続的にAGIに関する情報発信を続けていきます。

記事執筆:吉本 幸記(AINOW翻訳記事担当、JDLA Deep Learning for GENERAL 2019 #1、生成AIパスポート、JDLA Generative AI Test 2023 #2取得)

編集:おざけん