AIと共存する社会が実現しつつある今、私たちはAIとどのように向き合っていくのかという重要な岐路に立たされています。

中でも「AIの倫理問題」は、AIに関する議論において重要な論点となっています。特に2020年12月の「GoogleがAI倫理学者を解雇した」というニュースは多くの関心を集めました。

AIが自律的に動き、社会の中で多くの役割を果たす時代、AIとどのように向き合っていくのか、私たち一人ひとりが考えなければなりません。

本記事では「AIと倫理」に焦点を当て、AIのあり方について考察していきます。

| 【この記事でわかること】※クリックすると見出しにジャンプします |

目次 [非表示]

AI倫理を考える

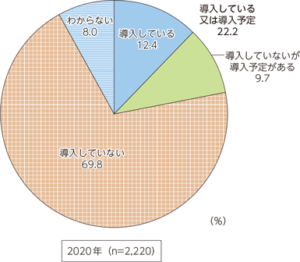

現在、AIへの関心が高まっていますが、日本企業へのAIの導入はあまり高まっていません。その理由とは一体何なのでしょうか。

総務省の情報通信白書(令和3年版)によると、IoT・Ai等のシステム・サービスの導入している企業の割合は12.4%、導入予定の企業は9.7%となっています。

倫理とは – なぜ今AI倫理が議論されるのか

AIへの関心が高まってきている中、普及が関心ほど高まっていません。

理由の一つとして、AIの倫理の問題があげられます。AIへの関心が深まるにつれて、AIの導入に疑問を持つ人や企業が増え、AIの倫理問題に対する議論が関心と共に増え始めています。

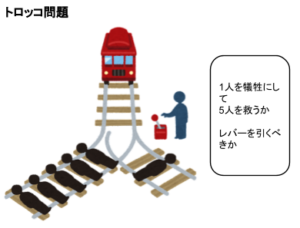

トロッコ問題 – 倫理同士のジレンマ

出典:AINOW編集部

トロッコ問題とは、多くの人を救うために一人を犠牲にするかしないか、という倫理的ジレンマを問う思考実験です。

トロッコ問題の具体的なストーリーは、トロッコが線路を暴走しており、その先には5人の人が線路上に括り付けられています。あなたは、線路を切り替えるレバーの前に立っていて、レバーを切り替えることができます。しかし、レバーを切り替えた先には1人が線路に括り付けられています。この時の選択肢は、レバーを引かず5人を犠牲にするか、レバーを引いて1人を犠牲にするかという、どちらが倫理的な選択となるか問う問題です。

トロッコ問題には正解はなく、どちらがより倫理的かと考える人によって正解が変わります。このような問題はAI倫理を考える場合に利用されます。

よく挙げられる例として、トロッコ問題の「功利主義」と「カントの義務論」の考え方を紹介します。

| 考え方 | 行動 | ||

| 功利主義 | 犠牲の少ない方を選ぶべきである

社会にとっての最大幸福を追求する |

レバーを引いて1人を犠牲にする | 結果を重視する倫理 |

| カントの義務論 | 他人を「単なる」手段として用いてはならない | レバーを引かないで5人を犠牲にする | 動機を重視する倫理 |

自動運転車版トロッコ問題

トロッコ問題のように正解のない問題はAIの倫理問題にもつながっています。

自動運転を実現する際に考えなければいけないのが自動運転車のトロッコ問題です。

例えば、自動運転車が交差点で別の車に衝突した場合、衝突により進路が変わって急ブレーキをかけたとしても、別の直進してきた車に巻き込まれる可能性があり、交差点内で安全に止まることは困難です。

しかし、急ブレーキと急ハンドルの場合だと、他の運転手や歩行者を巻き込む可能性は少ないですが、搭乗者が被害を受けます。

事故などの緊急操作が必要になったときにAIはどの様な操作を選択するべきなのか、どう判断すべきなのか。

このような議論は自動運転車のトロッコ問題と呼ばれ、世界中で研究されています。

トロッコ問題など正解のない倫理問題は、AIが社会に浸透していくにつれて複雑な問題が出てくることが考えられます。

AI倫理は人間の倫理を揺さぶる

上記のトロッコ問題から「AI倫理はAI特有の問題であり、人間が関係しない」という事はありません。人間の倫理問題の中に、AIが関係しているのです。

したがってAIを導入する際は、人間の倫理が明確でないと、AIを用いた技術にも同様の倫理問題が発生してしまいます。

AI倫理はパラドキシカルな人間倫理の現れである

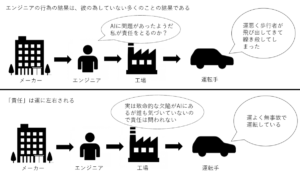

「自動運転車で事故が発生した場合に、誰が責任を取るのか」という問題は、そもそも「責任」という概念がはっきりしていないことに起因しています。人間は自由な存在であり、自分の行うことは全てコントロール下にあることを前提に社会はできあがっています。

しかし、実際は自分ではどうしようも無い出来事や偶然などの運に影響されながら行動・行為しています。これは哲学者のネーゲルやウィリアムズが「道徳的な運」という言葉で示している倫理のパラドクスです。

AIのバイアス問題は人間の差別の現れである

AI自体にも固有の問題があります。しかし、その多くは人間に起因しているのではないかと指摘されています。AIのバイアス問題はその最たる例といえます。

AIは時に人種差別的・性差別的・宗教差別的な結果を出力してしまう例があります。これは人間社会が持つバイアスが反映された結果であるといわれています。

つまり、AIのバイアス問題を解決するためには、人間社会のバイアス問題を改善しなければならないということです。

AIの倫理問題は、AIに関わる全ての人に問題を投げかけています。

AIによって起きうる公平性の問題は、現実社会での公平性の在り方を考え、議論することが社会に求められているのです。

AI倫理に関する事例

AIの導入が高まっていない理由として、AIの倫理的な問題が発生している点が考えられます。ここでは、AI倫理に関する複数の事例を紹介します。

AIが持つ「バイアス / 偏り」による事例

AIを活用していく上で、AIの出力結果に偏りが発生し、公平性に問題が出てきてしまっているという事例があります。

機械学習の過程で膨大なデータからAIがデータの規則性を認識して、認識システムに導入する方法が増えています。しかし、導入したAIによる出力結果が性差別や人種差別に繋がってしまい、AIの導入を中止するという事例が発生しています。

性差別 – Amazonの人材採用AIが女性を差別

引用元:CNET Japan

2014年、Amazonは人材採用システムにAIを活用することを検討していました。

しかしその人材採用システムは、男性ばかりを高評価とし、女性を差別していることが発覚しています。

原因は、AIに学習させた過去10年間にAmazonに送られてきた履歴書の大半を男性が占めていたからでした。学習した履歴書に男性が多いことで、AIが独自に男性を優位に採用するシステムとなってしまい問題となってしまったのです。

AIエンジニアはバイアスを排除しようと試みましたが、完全に偏りを排除することはできず、AmazonのAI採用ツールは失敗となっています。

人種差別 – 顔認識システムの人種の「偏り」

2015年、Googleの提供するサービスであるGoogleフォトで黒人カップルの写真に「ゴリラ」のタグをつけていたことが問題になりました。Googleフォトのタグ付け機能は、AIが写真に関連するタグを自動でつける機能です。

今回の問題点は、AIが写真の人物の肌の色で「ゴリラ」に分類してしまったことです。

この問題を受けてGoogleは「ゴリラ」のタグの削除と検索停止などの対応をしました。しかし、タグを消しただけで根本的なAIの差別問題は解決していません。

また、GoogleだけでなくAmazonやIBMなどの大手IT企業が汎用顔認識技術からの撤退を表明しています。

顔認識システムは非白人の認識精度が低くなってしまうことが撤退の要因です。学習データに白人の割合が大きいことが理由の一つとして挙げられていますが、精度を向上させる画期的な技術はまだ存在せず、IT企業はこの問題が技術的に解決する見込みがない限り汎用顔認識システムの販売を凍結する姿勢を示しています。

▼AIのバイアス問題について詳しくはこちら

事故の責任問題

AIを搭載したシステムが事故を起こしたとき、その事故の責任は誰に帰属させるべきかという問題があります。

今後AIの搭載された自動運転車が事故を起こした場合、賠償金は誰が払えばよいのでしょうか。AIをつくったエンジニアに事故の責任はあるのでしょうか。

自動運転による事故やシステムは今後さらに発展していくと考えられます。その場合、事故の責任は誰にあるのか、結論の出ていない問題です。

自動運転車による死亡事故

引用元:The Guardian

自動運転車に関する事故は現在まで3件発生しています。アメリカでテスラ車が2016年と2018年に2件、ウーバー車が2018年に1件事故を起こしています。

| 事故原因 | |

| テスラ

2016年 |

日差しが強く、衝突したトレーラーが光で白くなってしまい「物体」として認識することができなかった。 |

| Uber

2018年 |

自動運転車のAIが歩行者を認識できず、引いてしまった。

自動運転で世界で初めて歩行者を死亡させた事故と位置付けられている。 |

| テスラ

2018年 |

自動運転車がハンドルを切ってしまい事故が起きた。運転手はスマホゲームに夢中で反応できなかった。 |

自動運転技術やAIの発展は著しいですが、実際にAIが事故を起こしてしまうと企業への導入をためらってしまいます。AIの倫理問題や責任問題は今後より議論を深めていかなければいけない問題となっています。

▼自動運転の「レベル3」について詳しくはこちら

AIによる医療ミス

AIを医療現場に導入する動きが加速しています。しかし、仮にAIによる医療ミスが行われた場合、責任を負うのは誰なのかという議論が進んでいます。

AIの医療ミスというのは、AIの指示に従って行った手術の責任は手術を行った医師が負うべきという考えがあります。

しかし、AIは自身が考えたことを人に教えないという性質があります。医師やAIの開発者が「何故、そう考えたのか」を説明することができません。そのため、AIの指示に従った医師に責任を負わせてよいのかという意見があります。しかし、手術を受けた側からすると医師が医療ミスをしたということに変わりはありません。

AIの責任問題が絡んでくるため、AIの医療導入は一筋縄ではいかない問題です。

AIだけでなく企業倫理に対する批判が増加

AIの導入率が低い理由として、企業倫理に対する世間の批判が増えているという事例があげられます。

AI倫理に関する議論は、AIを扱う会社や企業の倫理も同様に問われています。企業は人権保護や社会全体、環境に配慮していくことが重要です。企業内の守るべき範囲を設定することが重要です。

2019年のリクナビ問題

リクナビ問題とは、就職情報サイト「リクナビ」から算出された学生の内定の辞退率を統計し、企業にデータとして販売していたという問題です。

新卒採用市場で人材難が起きているため、より良い人材をAIによって算出したデータをもとに採用に活用するという動きは注目を集めています。しかし、今回の問題は学生の情報を本人の同意なしに売買していたことです。これは倫理的に問題があったと言われ、世間から大きな批判を浴びました。

GoogleによるAI倫理学者の解雇

引用元:CNET Japan

2020年、Google のAI研究者であるティムニット・ゲブル氏が解雇されました。

彼女が解雇された理由は、Googleの検索エンジンに潜む倫理的な問題を指摘したことです。

指摘した論文には、膨大なデータを学習させたAIのリスクについて書かれていました。Googleが検索エンジンに用いる言語モデルが巨大すぎるため、AIの偏りがひどくなるのではないかと指摘した内容でした。

彼女はこの論文を巡って上層部と対立し、解雇されてしまったと主張しています。彼女は、エチオピア人で社内でも少ない黒人であることから、AIのバイアスに関心を持っていました。ゲブル氏の論文が明らかになってからGoogleの従業員2200人以上がこの事態の詳細を公表する様に求める署名をしています。

Googleの親会社で労働組合結成の動き

2021年、Googleの親会社であるAlphabetの従業員が「Alphabet Workers Union」という労働組合を結成しました。

この組合は会社に対して、労働者が差別や労働基準などの価値観に対して発信力を持てるように要請しています。

ゲブル氏の解雇問題の抗議活動もありましたが、過去に労働条件に苦情を出した社員の契約を一時的に停止したという訴えがありました。この訴えから一週間もしないうちに社員は職場復帰をすることができました。これは、労働組合が合法的な権力を持つようになり、企業倫理を求めていく動きも活発になっています。

AI倫理の問題に対する取り組みが活発化

以上のAIに関する倫理問題が浮き彫りとなり、その倫理問題を解決しようとする取り組みも活発になっています。ただAIを否定してしまうのではなく、どうしたらAIと人間は共存できるかという視点で議論を深めていくことが大事です。AIと共存するため、様々な問題にどう対処していくのか、対策を講じていくことに関心が深まっています。

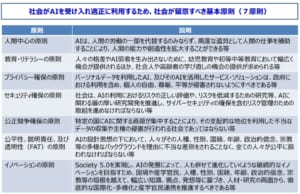

AIに関する原則

FATの原則

FAT(Fairness、Accountability、Transparency)とは、AIを運用する上で厳守しなければいけないとされている3つの原則です。

- 公平性(Fairness)

「公平性(Fairness)」とは、AIによる不当な差別がされないように配慮するものです。AIは実際のデータから規則性を学習するため、その判断は歴史的な差別の結果を算出してしまうことがあります。さらに、データの選び方で差別が強化されてしまいます。そのため、設計者は機械学習モデルを作成する段階から不平等さを取り除かなければいけません。

- 説明責任(Accountability

「説明責任(Accountability)」とは、AIを社会に導入する際、AIを用いた作業や業務の内容、目的や不祥事が生じた際にAIの責任を誰がとるのか、AIに関する情報全てを開示しなければいけないというものです。関係者はAIのいかなる説明も求めることができます。

- 透明性(Transparency)

「透明性(Transparency)」とは、AIの仕組みやプロセスが明確に理解できるようになっていることです。現在、AIの透明性の確保は困難を極めています。AIにエラーが起こった場合、どこにミスがあったのか、問題を特定することはとても現実的ではありません。AIの下した判断が何故この結果なのか、AIの考えるプロセスは完全にブラックボックス化しています。この問題を解決して、AIを安全に利用できるよう日々研究が行われています。

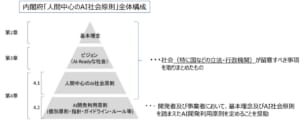

人間中心のAI社会原則

2018年、日本政府は内閣府に「人間中心のAI社会原則検討議会」を設置しました。そして、令和元年AIが社会において実用されるうえで留意されるべき基本原則を「人間中心のAI社会原則」として公表しました。AIを実装する社会、特に国などの立法・行政機関は、「人間の尊厳」、「多様性・包摂性」、「持続可能性」の3つの価値観が向上するように努めなければいけません。

機械学習と公平性に関する宣⾔

2019年、人工知能学会は、日本ソフトウェア科学会、電子情報通信学会と共同声明を発表しました。機械学習の利用が公平性に与える影響を重くとらえ、「機械学習は道具にすぎず、人間の意思決定を補助するものであること」として、「機械学習を研究し、社会に貢献できるよう取り組む」ことを発表しました。

出典:http://ai-elsi.org/archives/888

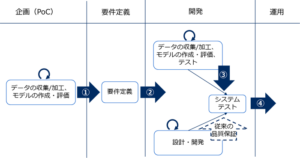

AI倫理の問題に向けた企業の取り組み

以上の学会の動きやAIの社会進出に向けて、企業はAIの倫理問題に取り組んでいます。AIを導入している企業は少ないですが、実用化に向けて利用されている例は多くあります。

富士通やNEC、AI利用のポリシーを策定

2019年、富士通は「富士通グループAIコミットメント」を発表しました。

社内でAIを利用する際に倫理的価値観に照らし合わせて遵守すべき項目をまとめたものです。同年NECは「NECグループAIと人権に関するポリシー」を発表しました。NECはこれまで手がけてきたAI案件で適用してきたルールをまとめ会社内で情報共有をし、2020年以降のAI案件に適用していくものです。

ABEJA、倫理委員会を設置

2019年、ABEJIは「Ethical Apporoach to AI」という委員会が発足したことを発表しました。ガイドライン作りや行動方針など、ABEJIのAI業務に対して倫理に関係した課題を専門家が議論し、AI業務の実現や改善に努めていくとしています。

▼ABEJAの「Ethical Approach to AI」について詳しくはこちら

ソニー、全AIに倫理審査を行う方針

2020年、ソニーは自社のAIを用いる全ての製品に対して倫理調査を行う決定を下しました。

AI製品が差別やプライバシーの侵害に配慮をしているのか審査し、問題があった場合プロジェクトの中止を勧告することも可能です。AIの倫理問題が話題になっている今、AIの品質向上のための大規模な取り組みは、企業間で今後広がっていくことが期待されます。

AI倫理の問題に向けた横断的な取り組み

AIの倫理問題に対して、啓蒙活動などを行う組織が運営されています。AIの倫理問題に対して、企業の取り組みに加えて世界という舞台で問題に取り組む機関が生まれています。

人工知能学会倫理委員会

2014年、日本では松尾豊氏らを中心に、AIに関する倫理委員会が発足されました。

社会の中で人工知能技術が用いられるような議論をしていく方針が策定がされています。人工知能学会の発表する「機械学習と公平性に関する声明」はAI倫理の問題に対して世間の関心が高まるきっかけとなりました。

JDLA公共政策委員会

日本ディープラーニング協会(JDLA)は、ディープラーニングを中心とする技術による日本の産業競争力の向上を目指して設立された組織です。

ディープラーニング技術を担う人材育成や活用する人材の育成のために勉強会などに力を入れています。他の機関との協力を通じてディープラーニングが社会に与える倫理的な影響の調査と政策の発信を行っています。

▼JDLAについて詳しくはこちら

Open AI

Open AIは2015年に設立された非営利組織です。イーロン・マスクなど有力な実業家や投資家が注目をしています。

人類全体に有利性があるやり方でオープンソースと親和性の高い人工知能を推進することを目標としている組織です。

倫理的なAIの開発を目指して、世界のトップIT企業と協力しながら開発を行っています。

まとめ

いかがでしたでしょうか。今回は各事例をもとにAIの倫理問題について紹介しました。

AIを導入する企業は増えていますが、AIの普及とは裏腹にいくつかの倫理問題が生じてしまっていることがお分かりになられたと思います。

このような課題を解決するためには、AIを作る側、利用する側にもAIに対するリテラシーが求められます。また、同時に人間社会のバイアス問題も解決していかなければなりません。AIの発展には、人類が変わっていくことも必要だったのです。

この記事がAIの倫理について考えるきっかけになれば幸いです。