機械学習とディープラーニングの社会実装が進むにつれて注目されている課題が、AIアルゴリズムにおける公平性の確保です。AIアルゴリズムは、様々な要因により差別的な判断を下してしまうことがあります。そうしたAIによる差別を是正・予防するためには、AIが下す判断が公平かどうか測定するツールが必要となります。

AIが下す判断の公平性を測定する既存のツールは、既存データの一部を流用したテストデータを使います。こうしたテストデータは、時間の経過とともにその内容が変化しない静的なものです。テスト環境も時間経過による変化を反映していません。それゆえ、従来のテストではAIシステムが長期間運用された場合に生じる影響を測定できていないのです。

Googleが発表したテストツール「ML-fairness-gym」は、AIシステムを長期間運用した状況をシミュレートできるものです。同ツールは、Open AIが公開している強化学習環境「Open AI Gym」を流用して開発されました。強化学習においてAIエージェントと環境は時間に沿って相互作用するという構造を、時間軸を伴うAI評価に転用したのです。

以下のブログ記事本文では、ML-fairness-gymの使用事例として「融資問題」が紹介されています。この問題は、銀行がローン申請者に対して融資を決定する際にしきい値をどのように決定するか、というものです。AIが応用される典型事例でもあるこの問題について長期的にシミュレーションした結果、銀行が公平性を重視した「機会均等化ポリシー」を採用した場合、長期的には融資を受けるのが難しいグループをますます融資が難しい状態にしてしまう、という直観的には導き出せないテスト結果が得られました。

機械学習やディープラーニングを活用したAIシステムを長期運用した場合の影響は、まだあまり知られていないと言ってよいでしょう。こうしたなか、ML-fairness-gymのようなAIの長期運用をシミュレートできる評価ツールは、今後のAI品質保証体制を構築するうえで重要な役割を担うのではないでしょうか。

なお、以下の記事本文はGoogleジャパン広報部に報告したうえで翻訳したものです。

2020年2月5日水曜日

GoogleリサーチソフトウェアエンジニアHansa Srinivasanが投稿

機械学習システムは、ますます重大なインパクトを伴う意思決定に実装されるようになっている。そうした意思決定には犯罪者の量刑、児童福祉のアセスメント、誰が医療の配慮を受けるべきかの判断、そしてそのほかの状況における判断がある。そのようなシステムが公正であるかどうかを理解することは非常に重要であり、モデルの短期および長期の影響を理解することも要求される。機械学習システムの公平性を評価する一般的な方法とは、システムへのさまざまな入力を集めた静的データセットにおけるエラーメトリックの格差を評価することだ。実際、多くの既存のMLフェアネスツールキット(例えばAIF360、fairlearn、fairness-indicators、fairness-comparison)は、既存のデータセットを使った分析にもとづいてエラーメトリックを評価するためのツールを提供している。この種の分析は単純な環境のシステムで機能する一方で、アルゴリズムが動作するコンテキストがその影響を理解するために重要である複雑な事例(アクティブなデータ収集または重要なフィードバックループを備えたシステムなど)がある。これらの事例では、アルゴリズムの決定における公平性は、理想的には、エラーメトリックベースの手法が許容するよりも環境的および時間的コンテキストを考慮して分析されるほうがよいだろう。

以上のようなより広いコンテキストでアルゴリズム開発を促進するために、私たちはML-fairness-gymをリリースした。これは、社会的環境で機械学習ベースの意思決定システムを実装することに伴う潜在的かつ長期的な影響を調査するための単純なシミュレーションを構築するためのコンポーネントセットである。論文『公平性は静的ではない:シミュレーション研究による長期的公平性のより深い理解』では、現在流布している機械学習の公平性に関する文献から引用したすでに定番となった問題において、自動的な意思決定システムが及ぼす長期的影響を研究するためにML-fairness-gymをどのように使うことができるかを示している。

ひとつの事例:融資問題

機械学習システムにおける公平性を考慮するための古典的な問題には、Liuらが説明した融資問題がある。この問題では融資プロセスを非常に単純かつ定型的に表現しているので、単純なフィードバックループだけに焦点を当てることができる。そして、融資が及ぼす効果を分離して詳細に調査できるのだ。こうした問題の定式化によれば、個々のローン申請者がローンを返済する確率は、信用スコアの関数から算出される。こうした申請者は任意の数のグループのいずれかに属し、そのグループの(会員数等の)属性は貸付銀行によって観察可能とする。

グループの定義は、異なる信用スコアの分布を設定することから始まる。そのために銀行は各グループあるいはローン申請者各人に設定された信用スコアのしきい値を決定しようとする。しきい値を設定することで、融資を回収するという銀行の目的が最高度に可能となるようにするのだ。信用スコアがしきい値より高い申請者はローンを受け取り、低い申請者は拒否される。シミュレーションが申請者個人を選択すると、彼らがローンを支払うかどうかは、彼らのグループの属性である返済可能性に基づいてランダムに決定される。この事例では、現在ローンを申請している個人が将来追加のローンを申請する場合がある。こうした場合には既存のローンを返済することにより、ローン申請者の信用スコアとグループの平均信用スコアの両方が増加するものとする。同様に、申請者がローン支払い不履行になった場合、グループの平均信用スコアは低下する。

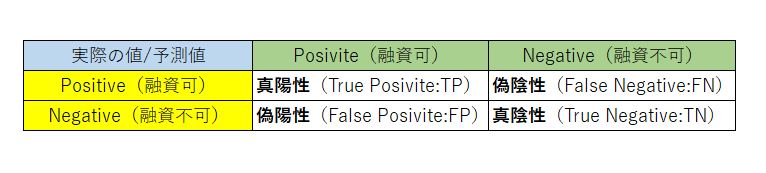

最も効果的なしきい値設定は、銀行の目標によって異なる。利益最大化を目指す銀行は、申請者がローンを返済する推定値に基づいて、予測される収益を最大化するしきい値を設定するだろう。信用スコアの分布の異なるふたつのグループの両方に関して公平性を求める別の銀行は、機会の平等(※訳註1)を満たしつつ利益を最大化するしきい値を実装しようとするだろう。こうした銀行の目標は、両方のグループにおいて等しいTPRを実現することにある(TPR(True Positive Rate:真陽性率)は再現率あるいは予測感度とも呼ばれる(※訳註2);この指標は、ローンを返済してさらにローンを組む申請者を決めるためのもの)。機械の平等を目指すシナリオでは、分散されたローンとその返済結果に基づいて最も効果的なしきい値を決定するために、銀行が機械学習技術を採用している。しかしながら、こうした機械学習の手法は短期的な目的に焦点を合わせることが多いため、様々なグループに対して意図しない不公平な結果をもたらす可能性がある(※訳註3)。

上部画像: 100ステップをシミュレーションした場合の2つのグループの信用スコア分布の推移。

下部画像:(左側画像)銀行の現金残高と(左側画像)シミュレーション実行時における青線で表示したグループ1のTPRと緑線で表示したグループ2のTPR

こうしたマイノリティへの差別を回避するために、機械学習アルゴリズムの適用対象をマジョリティとマイノリティのグループに分けたうえで、それぞれのグループで予測結果が公平になるように運用することが提案される。この運用案が、機会の平等である。もっとも、この記事では公平性を長期的に保証する観点はあまり考察されていない。

融資問題における混合行列[/caption]

融資問題における混合行列[/caption]

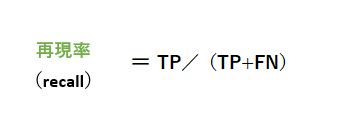

融資問題において重要となる指標は、再現率である。この指標は実際に融資可能なローン申請者のうち、正しく融資可能と予測した割合を示す。機会均衡化ポリシーにおいては、ローン申請者が属するグループごとで再現率が同じになるようにしきい値を最適化していく。再現率は以下の式によって算出できる。

再現率の算出式[/caption]

再現率の算出式[/caption]

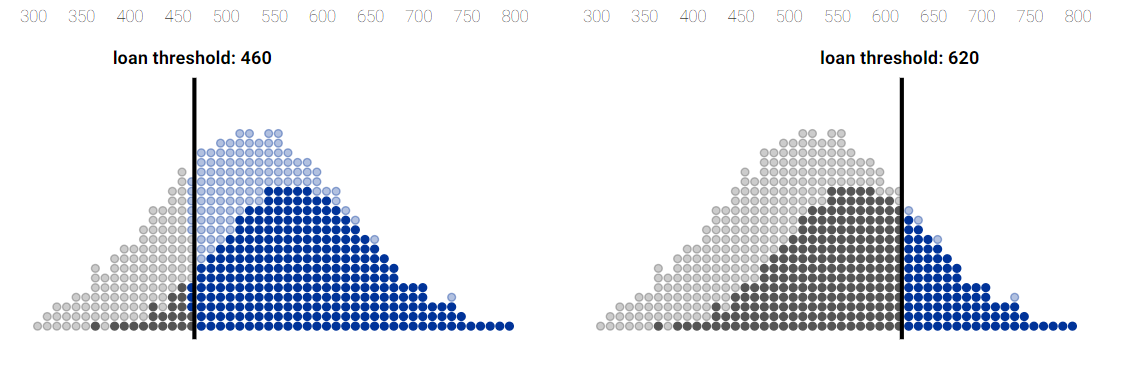

銀行がローンを貸し付ける任意の1グループを想定した場合、そのグループは様々な信用スコアをもっているローン申請者の集団と考えられ、平均的な信用スコアをもつ申請者がもっとも多く、その平均的信用スコアを中心に左右に釣鐘上に分布している。

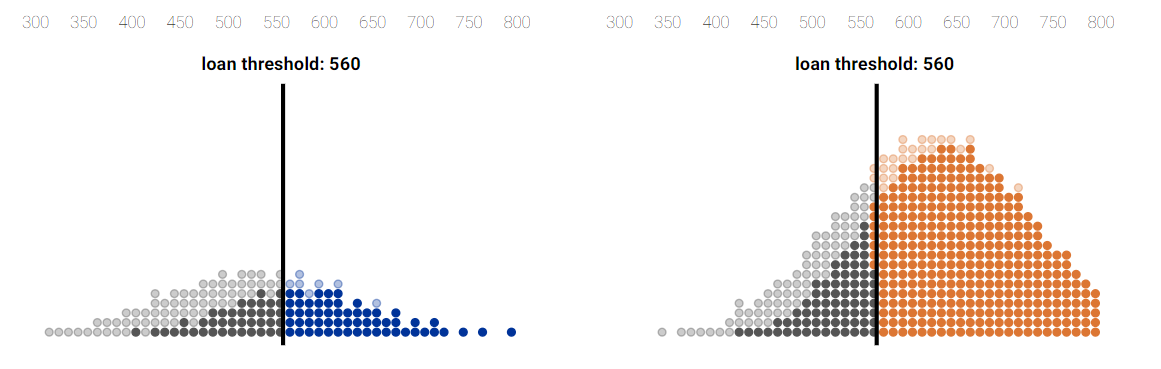

ローン申請可否を決定するしきい値を低く設定すると、多くの申請者に融資できる一方で、ローン返済を不履行する申請者も多数いるので、銀行は不利益を被る(下の画像左側参照)。反対にしきい値を高く設定し過ぎるとローン返済を不履行する人が減る一方で、融資を認可する人数が減るので、やはり銀行の利益は最大化されない(下の画像右側参照)。

融資問題におけるしきい値のグラフ。左側がしきい値が低い場合。右側は高い場合。

融資問題におけるしきい値のグラフ。左側がしきい値が低い場合。右側は高い場合。しきい値より左側の灰色の丸:ローン申請が拒否されたがローンを返済したであろう人

しきい値より左側の薄灰色の丸:ローン申請が拒否されたうえにローン返済を不履行したであろう人

しきい値より右側の青色の丸:ローン申請が認可されてローンを返済した人

しきい値より右側の薄青色の丸:ローン申請が認可されたがローン返済を不履行した人

画像出典:BAIR ‘Delayed Impact of Fair Machine Learning‘[/caption]

融資対象となるグループは、通常は複数設定するのが合理的である。というのも、経済格差のような社会的要因によって信用スコアの分布が異なるグループがある、と考えるのが自然だからである(下の画像参照)。融資対象グループが複数ある場合、報酬最大化ポリシーにしたがう銀行は、利益が最大化されるしきい値をグループごとに設定する。しかし、しきい値をグループごとに設定すると、グループごとに再現率が異なることによって差別につながる可能性がある。各グループの再現率が同じになるようにしきい値を設定するのが、機会均衡化ポリシーである。このポリシーを採用する銀行は利益を最大化できないが、再現率に関するグループ間の公平性を実現できる。

信用スコアの分布が異なる2つの融資対象グループ

信用スコアの分布が異なる2つの融資対象グループ画像出典:BAIR ‘Delayed Impact of Fair Machine Learning’[/caption]

以上の分析は、機械学習アルゴリズムを長期間運用した場合の影響を考慮しない静的なものであることに注意してほしい。

静的データセット分析の欠陥

融資問題のようなシナリオの影響を機械学習によって評価する標準的なプラクティスは、データの一部を「テストセット」として確保し、それを使用して関連するパフォーマンスメトリックを算出することである。次いで、これらのパフォーマンスメトリックがグループ間でどのように異なるかを調べることにより、公平性が評価される。もっとも、フィードバックのあるシステムでこのようなテストセットを使用する場合、主に2つの問題があることがよく知られている。もしテストセットが既存のシステムから生成されているならば、それは不完全であるか、既存システムに固有のバイアスを反映している可能性がある(※訳註4)。融資の例では、ローンを既に組んだ申請者が返済不履行となったかまたは返済したかどうかに関する情報しかない可能性があるため、テストセットが不完全になるかも知れないのだ。その結果、データセットには融資が承認されていない個人、または以前に融資を申請したことがない個人が含まれていないかも知れない。

2番目の問題は、機械学習システムの出力によって通知されるアクションが、将来の入力に影響を与えるかも知れない効果を持つ可能性があることだ。機械学習システムによって決定されたしきい値は、ローンの延長に関する決定に使用される。ローン利用者がローンを債務不履行にするか返済するかは将来の信用スコアに影響し、信用スコアの変動は機械学習システムにフィードバックされる。

これらの問題は静的データセットを使って公平性を評価することの欠点を強調し、アルゴリズムが実装される動的システムのコンテキストでその公平性を分析する必要性を活気づける。私たちは機械学習の実践者たちが自身の機械学習システムに対してシミュレーションを使った分析ができるようにするために、ML-fairness-gymフレームワークを作った。このフレームワークを用いたアプローチを使うと、閉鎖的な形式の分析が困難な動的なシステムの分析を効果的に行えることが、多くの機械学習応用分野で証明されている。

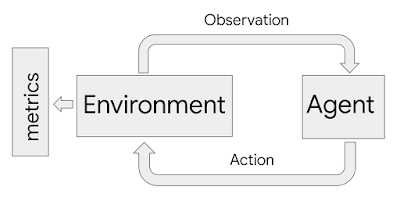

長期的分析のシミュレーションツールとしてのML-fairness-gym

ML-fairness-gymはOpen AIのGymフレームワーク(※訳註5)を使って、逐次的な意思決定をシミュレートする。このフレームワークでは、エージェントはシミュレートされた環境とループ状に相互作用する。各ステップで、エージェントは環境の状態に影響を及ぼすアクションを選択する。その後、環境はエージェントが続いて行うアクションを起こすために使用する観測結果を明らかにする。このフレームワークでは、環境はシステムと問題の動態性をモデル化し、観測結果はエージェントに再帰的に与えられるデータとして機能する。こうしたエージェントと環境のフィードバックループを伴った相互作用全体が、長期的分析対象となっている機械学習システムとして解釈されるのだ。

シミュレーションフレームワークで使用されるエージェントと環境の相互作用ループを示したフローチャート図。エージェントは選択したアクションを介して環境に影響を与える。環境はアクションに応じて変化し、内部状態の一部を観測結果として生成する。メトリックをモニタリングすることで、結果を評価するのに必要な環境の変更履歴が調査できる。

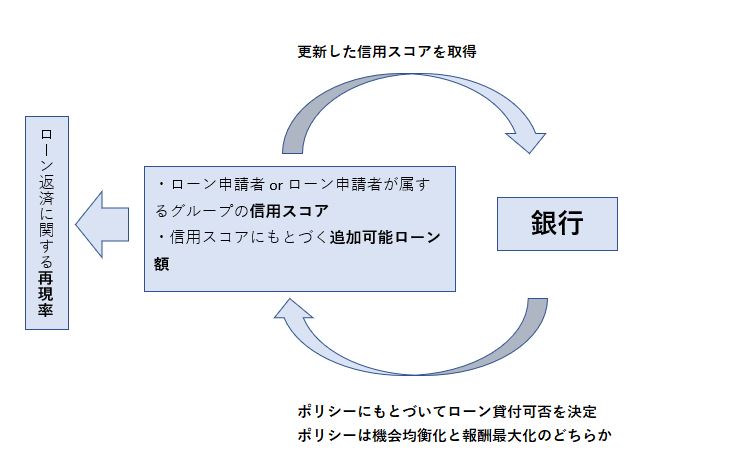

融資の例では、銀行がエージェントとして機能する。このエージェントとしての銀行はローン申請者、信用スコア、そしてローン申請者が属するグループの(信用スコアのような)属性に関する観測結果を相互作用する環境として受け取る。そして、ローンを受け入れるか拒否するかの二者択一の形でアクションを実行するのだ。また環境は、申請者が正常に返済するか返済不履行となるかをモデル化し、そのモデルに応じて信用スコアを調整する。ML-fairness-gymは結果をシミュレートするため、公平性に関する銀行の方針がローン申請者全体に及ぼす長期的な影響を評価することができる(※訳註6)。

Open AIは、Gymのほかにも以下のようなゲームライクな強化学習環境をリリースしている。

OpenAIが公開した強化学習環境一覧

| フレームワーク名 | 概要 |

|---|---|

| Gym retro | AtariとSegaのレトロゲームを学習環境として採用 |

| Neural MMO | MMORPGライクなフィールドを学習環境として採用。エージェントも多数設定できる。 |

| Multi-Agent Emergent | エージェントにかくれんぼをプレイさせて、道具の使用を学習する過程を観察できる強化学習環境 |

| Safety Gym | エージェントが安全性を確保しつつ学習できる強化学習環境。自律自動車のアルゴリズム開発等を念頭にいれて開発された。 |

融資問題のグラフ[/caption]

融資問題のグラフ[/caption]

公平性は静的ではない:分析を長期に拡張する

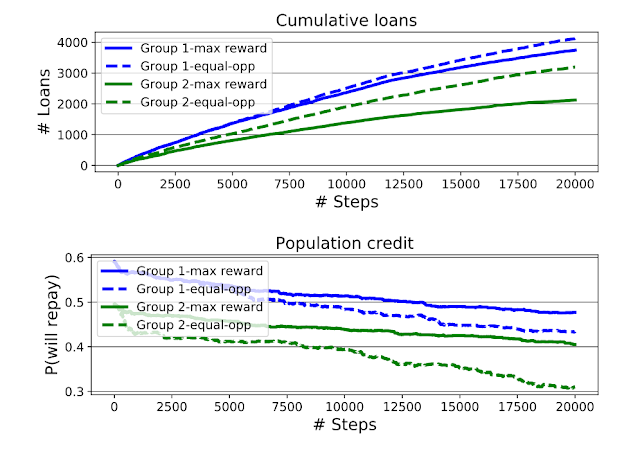

Liuらが定式化した元々の融資問題は、銀行の方針を短期的にしか調査していなかった。その調査では、(報酬最大化エージェントとも呼ばれる)短期利益最大化ポリシーと機会の平等(Equality of Opportunity:略して「EO」)に則るポリシーがもつ制約が採用されていた。こうしたポリシーに関する分析をシミュレーションによって(相互作用のステップを数多く試行することで)長期的に拡張するために、私たちはML-fairness-gymを使うのだ。

上部グラフ:申請者のグループIDによって層別化された、報酬最大化エージェントとEOエージェントのそれぞれが融資したローンの累積。下部グラフ:シミュレーションの進行に伴う(グループごとに条件付けされた返済確率によって定量化された)グループ平均クレジットスコアの推移。EOエージェントはグループ2のローンへのアクセスを増やすが、グループ間の信用スコアのギャップも拡大する。

長期的分析によって、2つの結果が判明した。第一に、Liuらによって見出されたように、機会均等エージェント(EOエージェント)は不利なグループ(最初は平均信用スコアがより低いグループ2)に、時として報酬最大化エージェントが適用するしきい値よりもより低いものを適用することによって、融資し過ぎるのだ。この結果により、グループ2の信用スコアがグループ1よりも減少し、報酬最大化エージェントを使用したシミュレーションよりもグループ間の信用スコアのギャップが大きくなる。ただし、分析ではグループ2がEOエージェントのせいで信用スコアが悪化しているように見えるかもしれないが、累積ローングラフを見ると、不利なグループ2はEOエージェントからかなり多くのローンを受け取っていることがわかる。福利厚生の指標が信用スコアであるか受け取ったローンの合計であるかに応じて、EOエージェントは報酬最大化エージェントと比べてグループ2に対してより良いか、あるいはより有害かのどちらかの議論が成り立ち得る。

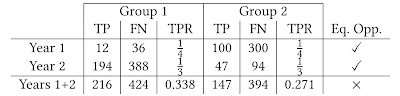

2番目の発見は機会均等制約(各ステップでグループ間のTPRを均等化するように強化するポリシー)が、シミュレーション全体でTPRを均等化しないことだ。このおそらく直感に反する結果は、シンプソンのパラドックスの一例と考えることができる(※訳註7)。以下の表に見られるように、2年間のうちで各年のTPRが等しいことは総計でTPRが等しいことを意味しない。この結果は、基礎となる母集団が進展しているときに機会均等メトリックの解釈がいかに困難であるかを示しており、機械学習システムが目的の効果を備えていることを確認するには、より慎重な分析が必要であることを示唆している。

シンプソンのパラドックスの例。TPは真陽性の分類、FNは偽陰性の分類に対応し、TPRは真陽性率(実際に陽性であったものの予測正解率)。1年目と2年目において、貸し手は2つのグループ間で平等なTPRを達成するポリシーを適用する。しかし、両方の年を集計して算出したTPRは等しくない。

本記事における融資問題がシンプソンのパラドックスの一例と言われるのは、長期的な再現率と(長期を分割したとみなせる)短期的なそれが一致せず、機会均衡化ポリシーを採用しているにも関わらずグループ間のギャップが拡大しているからである。

結論と今後の作業

このブログ投稿では融資問題で判明したことに焦点を当てたが、ML-fairness-gymを使用して、さまざまな公平性の問題に取り組むことができる。私たちの論文では、学術的な機械学習の公平性に関する文献で以前に研究された他の2つのシナリオの分析を拡張している(※訳註8)。ML-fairness-gymフレームワークは、「公平性」が十分に検討されていない問題をシミュレートおよび調査するのに十分な柔軟性も備えている。例えば、前述の論文を支持する論文『社会的ネットワークにおける公平な医療的処置の割り当て』では、社会的ネットワークにおける個人とコミュニティ全体の公平性の概念をよりよく理解するために、正確な疾病管理問題と呼ばれる定型化された流行制御のバージョンについて研究している(※訳註9)。

機械学習アルゴリズムが私たちの社会に及ぼす影響を他の研究者や機械学習開発者がよりよく理解することをうながし、またより責任があり公平でもある機械学習システムの開発が求められていることを知らせているML-fairness-gymの可能性に私たちは興奮している。以上のようなML-fairness-gym のソースコードと論文は、Githubリポジトリで見つけてください。

注意割り当て問題とは、一定の範囲内で発生する事象を発見する際に注意をどのように払うか、という問題である。この問題が認められる具体例として、食品検査や害虫駆除が挙げられる。注意に要するリソースには限界があるので、すべての範囲に高度な注意を払うことはできない。それゆえ、探索範囲に応じた注意リソースの最適化が必要となる。

戦略的分類問題では、任意の許可を得るのにエージェントは一定のコストを支払う状況が想定されている。この問題の具体例は、大学の入学許可プロセスである。大学は一定の資格を満たした学生に入学許可を与える。この一定の資格を満たすために、学生は学費を負担する。資格を得るのに要するコストがあまりに高く設定された場合、経済格差等で多くのコストを支払えないグループには相対的に過度な負担を強いることにつながる。こうしたことから、許可を与えるしきい値(入学資格)の設定にはグループ間の公平性という問題が伴う。

疫病の伝染における人々の関係は交友関係や企業にも認められ、社会的ネットワークという概念で定式化されている。以上の伝染病治療に見られる効率性と公平性のトレードオフ的関係は、SNSにおける情報拡散にも見られるのだ。SNSを使って情報を拡散する場合、ネットワークのハブとなっているユーザを経由させる戦略は効率的である。しかし、様々な属性のユーザに情報を届ける公平性の観点に立つと、この戦略は最適とは言えないだろう。

原文

『ML-fairness-gym: A Tool for Exploring Long-Term Impacts of Machine Learning Systems』

著者

Hansa Srinivasan

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん