DALL·Eとは、「アボカドの形をしたアームチェア」のようなテキストを入力として渡すと、そのテキストの意味と合致する画像データセットを出力するモデルです。同モデルのアーキテクチャにはTransformerが採用され、学習データにはインターネットから収集されたテキストと画像の組が大量に使われたと推測されます。

同モデルの驚くべきところは、学習データのなかにあったとは考えられない「キリンとカメを合成したキメラ」のようなテキストに対する画像も生成できることです。さらには、視覚的パターンを推測する簡単な視覚的IQテストにも正解できるのです。

Markowitz氏は同モデルの視覚的タスクに関する汎用性を称賛しつつも、同モデルが汎用的知能ではないことを指摘しています。

以上のようなDALL·EをOpenAIが発表してから2ヶ月近く経過した2月24日、論文とソースコードが公開されたので、再び同氏は同モデルに関する記事を執筆するのではないかと思われます。

なお、以下の記事本文はDale Markowit氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならび組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

前置き

数ヶ月に一度、誰かが機械学習の論文やデモを発表して、その発表に私の開いた口が塞がらなくなるようだ。今月(※訳註1)で言えば、OpenAIの新しい画像生成モデルDALL·Eに驚かされた。

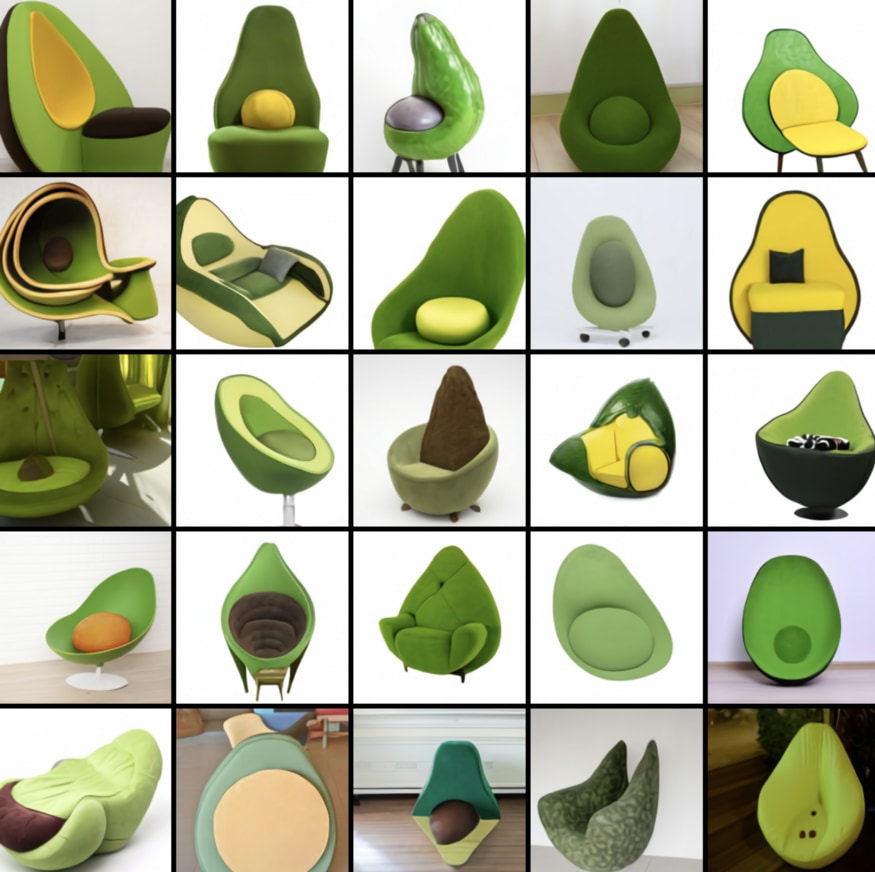

この120億パラメータの巨大なニューラルネットワークは、(「アボカドの形をしたアームチェア」などのような)テキストのキャプションを受け取ると、それにマッチする画像を生成する。

生成された以上の写真は、かなり刺激的に感じられる(以上のアボカドの椅子のどれかを買ってみたいと思えてくる)。しかし、さらに印象的なのはDALL·Eが空間、時間、そして論理の概念を理解し、表現する能力を持っていることだ(これについては後ほど解説)。

この記事では、DALL·Eで何ができるのか、それがどのように機能するのか、機械学習モデルの最近のトレンドにどのように適合するのか、そしてなぜそれが重要なのかについて、簡単にその概要を説明する。それでは、出発しよう。

DALL·Eとは何か、何ができるのか?

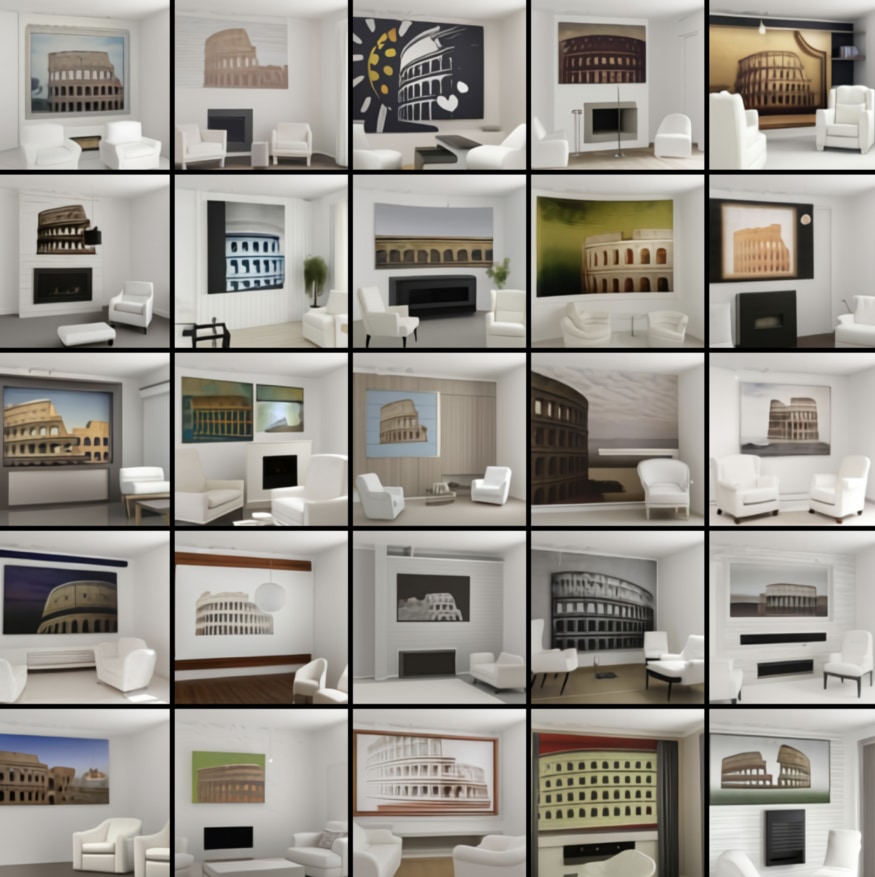

昨年7月には、DALL·Eの生みの親であるOpenAIがGPT-3と呼ばれるDALL·Eと同様に巨大なモデルを発表し、その能力で世界を驚かせた。GPT-3はオプ・エド(※訳註2)、詩、ソネット(※訳註3)、そしてコンピュータのコードを含むテキストを人間のように生成できたのだ。DALL·EはGPT-3を自然に拡張したもので、テキストプロンプトを解析し、言葉ではなく絵で応答する。例えば、OpenAIのブログからの一例では、プロンプトに入力された「2つの白い肘掛け椅子とコロシアムの絵があるリビングルーム」のようなテキストから以下のような画像をレンダリングする。

以上の画像は、悪くないのではなかろうか。この出力結果がどのようにデザイナーに役立つかはもうお分かりだろう。DALL·Eはプロンプトから大きな画像のセットを生成できることに注目しよう。画像は、CLIP(※訳註4)と呼ばれるOpenAIがDALL·Eと同時に発表した2つ目のモデルによってランク付けされ、どの画像が最もマッチするかについて判断が試みられる。

DALL·Eはどのようにして作られたのか?

残念ながら、OpenAIがまだ論文を発表していないので詳細はわからない。しかし、DALL·Eのコアには、最近の機械学習の進歩に貢献しているのと同じ新しいニューラルネットワークアーキテクチャが使われている。それは、2017年に発見されたTransformerだ。このネットワークは巨大なデータセット上でスケールアップしてから訓練が可能で、なおかつ並列化しやすいタイプのものである。Transformerは特に(BERT、T5、GPT-3などのモデルの基礎となっていることからわかるように)自然言語処理で画期的な成果をあげ、Google検索結果の品質向上(※訳註5)、翻訳、さらにはタンパク質の構造予測(※訳註6)でも革新的な結果を出した。

これらの大規模な言語モデルのほとんどは、(wikipediaやウェブのクロールのようなものから作られた)大規模なテキストデータセットで訓練されている。こうしたなかDALL·Eがユニークなのは、単語とピクセルの組み合わせから成るシーケンスで訓練されているところだ。そのデータセットが何であったかはまだわからないが(おそらく画像とそのキャプションが含まれていると思われる)、膨大な量であったことは間違いない。

AINOW翻訳記事『BERT解説:自然言語処理のための最先端言語モデル』

AINOW翻訳記事『2019年はBERTとTransformerの年だった』

AINOW翻訳記事『AlphaFold:科学的発見のためのAIの活用』

DALL·Eはどれだけ「賢い」のか?

以上に引用したDALL·Eの結果は印象的だが、巨大なデータセットでモデルを訓練した場合に必ず生じる疑問がある。懐疑的な機械学習エンジニアであれば、結果がソースとなった画像素材からコピーしたり答えとなる画像を暗記したりしているために高品質となったに過ぎないのではないか、と問うのは至極当然なことだ。

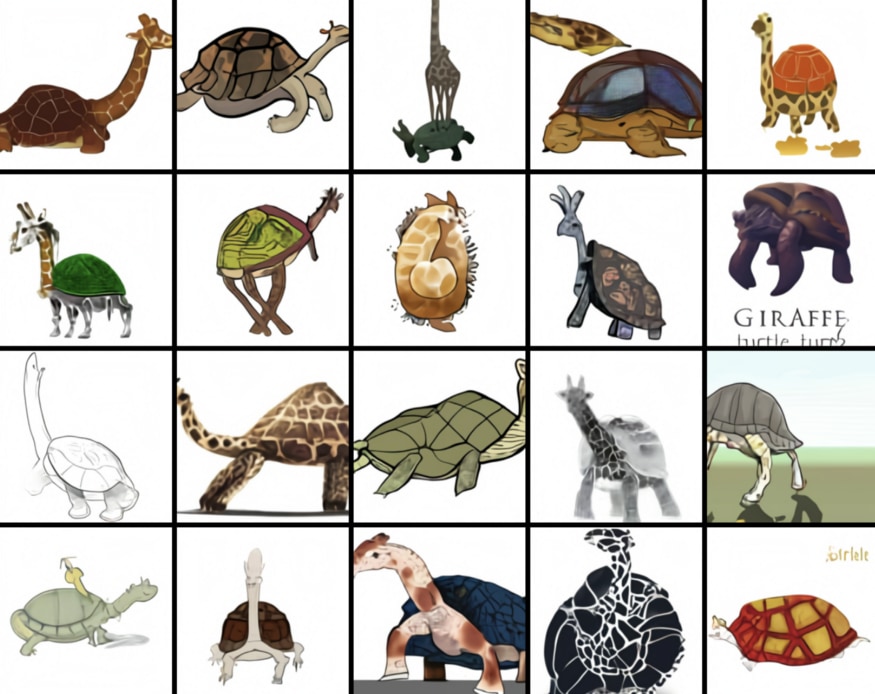

DALL·Eがただの画像の転載ではないことを証明するために、OpenAIのブログ記事執筆者たちは、かなり変わったテキストプロンプトから画像を表示するように仕向けた。そうした事例が以下だ。

「キリンとカメからできたキメラを描いたプロ仕様のハイクオリティイラスト」

「ハープでできたカタツムリ」

このモデルが学習データセットの中で多くのキリンとカメの交配種に遭遇したとは考えにくいので、結果はより印象的なものになっている。

さらに、ブログ記事で例示された奇妙なテキストプロンプトは、このモデルが持っているさらなる魅力を示唆している。その魅力とは「ゼロショットの視覚的推論」を実行する能力だ。

ゼロショットの視覚的推論

通常、機械学習では、モデルに実行させたいタスクの事例を何千あるいは何百万と与えて、そのモデルを訓練する。そうすることで、モデルがタスク実行に必要なパターンを理解するのを願っているのだ。

例えば、犬の品種を識別するモデルを訓練するために、ニューラルネットワークに品種別にラベル付けされた犬の写真を何千枚も見せてから、新しい犬の写真にタグを付ける能力をテストすることがある。この事例は限られた範囲での作業であり、OpenAIの最新の偉業に比べれば、古風な感じさえする。

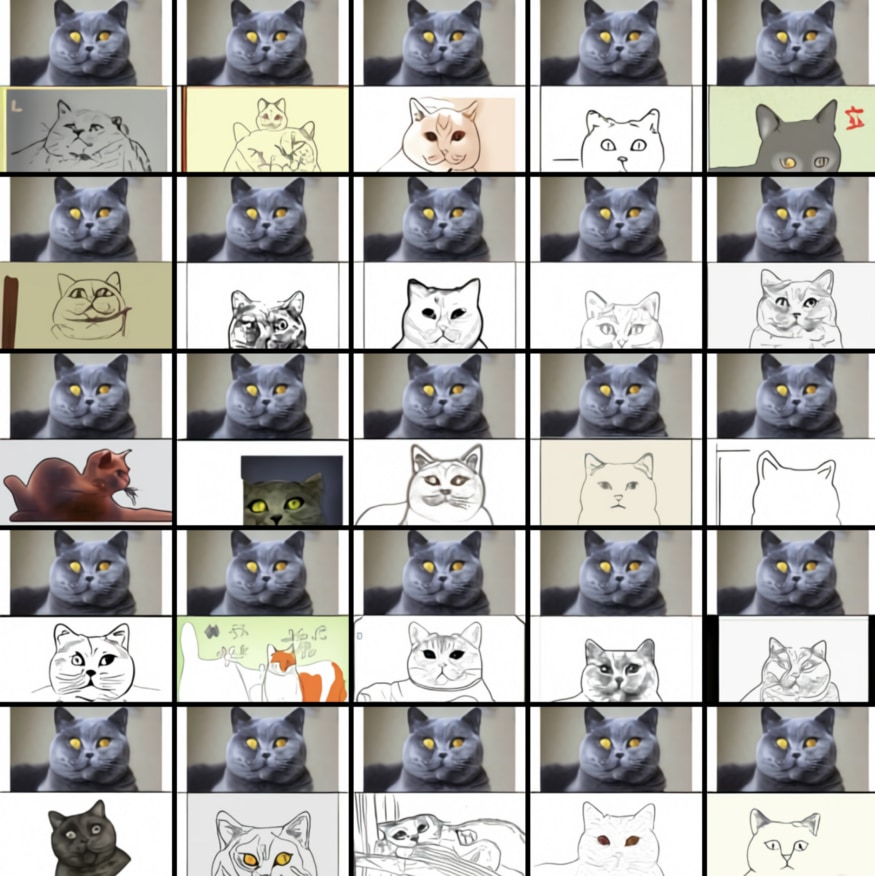

一方、ゼロショット学習とは、モデルが特別に訓練されていないタスクを実行する能力のことである。例えば、DALL·Eはキャプションから画像を生成するように訓練された。しかし、適切なテキストプロンプトがあれば、画像をスケッチに変換できる。そうした事例が以下の画像だ。

「下に上の画像にある猫と正確に同じスケッチ」とプロンプトに入力した結果。画像出典:https://openai.com/blog/dall-e/

さらにDALL·Eは、道路標識にカスタムテキストを表示できる。以下の画像を参照。

「「openai」という単語が書かれた店頭」とプロンプトに入力した結果。画像出典:https://openai.com/blog/dall-e/

このようにしてDALL·E は、そのように動作するように特別に設計されていないにもかかわらず、Photoshop のフィルターとほぼ同じように動作できるのだ。

このモデルは、(画像における「巨視的」または「断面」のような)視覚的な概念、(「中国の食べ物の写真」といった)場所、(「サンフランシスコのアラモスクエアに面した夜の通りからの写真」あるいは「20年代の携帯電話の写真」などの)時間の「理解」まで示している。例えば、「中国の食べ物の写真」というプロンプトに反応して吐き出されたものは、以下の通り。

「中国の食べ物の写真」。画像出典:https://openai.com/blog/dall-e/

つまり、DALL·Eはキャプションのためにきれいな絵を描くだけではなく、ある意味では視覚的に質問に答えられるのだ。

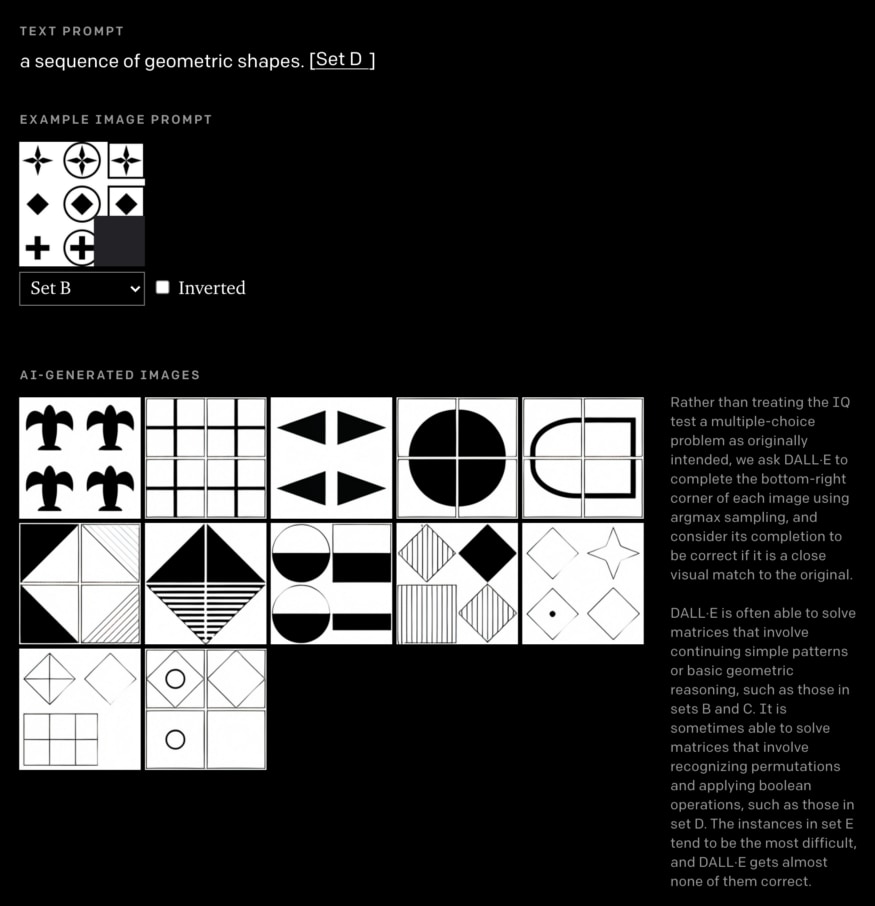

DALL·Eの視覚的推論能力をテストするために、ブログ記事の著者らはDALL·Eに視覚的IQテストを行った。以下の例では、テストに隠された視覚的パターンに従って、モデルはグリッドの右下隅を完成させなければならなかった。

OpenAIがDALL-Eのテストに使った視覚的IQテストのスクリーンショット。画像出典:https://openai.com/blog/dall-e/

「DALL·Eは、多くの場合、単純なパターンや基本的な幾何学的推論を含む行列を解ける」と著者らは書き、さらにはある問題では他の問題よりも優れていることがわかった。また視覚的パズルの色が反転している場合にはDALL·Eの能力が劣化したことから、「予期せぬ仕方で脆弱になっているかも知れないことも示唆している」と著者らは記している。

DALL·Eは何を意味しているのか?

DALL·Eについて最も印象的なのは、著者が予想もしていなかったようなさまざまなタスクに対して、驚くほど優れたパフォーマンスを発揮することだ。

「DALL·E(中略)は、適切な方法でテキストをプロンプトに入力すると、いくつかの種類の画像対画像翻訳タスクを実行できることがわかった。

このような能力が現れるとは予想しておらず、それを促すためにニューラルネットワークや訓練手順に変更を加えてなかった。」

以上のような結果は、まったく予想していなかったことだ。DALL·EとGPT-3は、ディープラーニングにおけるより大きなテーマに関する2つの事例となっている。ラベル付けされていないインターネットデータ上で訓練された(「自己教師あり学習」(※訳註7)の事例のような)桁外れに大きなニューラルネットワークは、非常に汎用性が高く、特別に設計されていないこともたくさんできる。

もちろん、DALL·Eを汎用的知能と勘違いしてはいけない。この手のモデルを騙すのは難しいことではない(※訳註8)。このモデルがオープンにアクセスできるようになって、弄り回せるようになったら、もっと多くのことがわかるだろう。そうは言っても、一般公開されるまでの間、ワクワクせずにはいられない。

AINOW翻訳記事『GPT-3にチューリングテストを試してみる』

機械学習についてもっと知りたいですか?Twitterで@dalequarkをフォローしてください。

・・・

原文は、2021年1月6日にhttps://daleonai.comで公開されました。

原文

『DALL·E Explained in Under 5 Minutes』

著者

Dale Markowitz

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん