以上のような技術的トレンドとして同氏が挙げているものは、以下の通りです。

- CNNの弱点の克服:画像認識モデルの基礎的技術であるCNNは、視野角や背景が変わると認識精度が低下したり、人間には識別できないノイズを画像に混入すると誤認したりする。こうした弱点は、ヒントンらが発表したカプセルネットワークで克服できるかも知れない。

- 自己教師ありディープラーニング:現在のディープラーニングモデルには、大量のラベル付けされた学習データが不可欠である。自己教師あり学習はラベル付けをデータ自体から学習するので、大量のラベル付き学習データが不要となる。

- ハイブリッドモデル:第2次AIブームで流行したルールベースAIとディープラーニングを併用するハイブリッドモデルは、非ハイブリッドモデルを凌駕する性能を発揮すると期待されている。

- システム2のディープラーニング:行動経済学で言うところの「システム2」の認知活動を実行するAIが実現すれば、AIがより多様な問題を解決できるようになる。

- 神経科学にもとづくディープラーニング:汎用人工知能(Artificial General Intelligence:AGI)の実現には、人工知能工学と神経科学の連携・融合が有効であると期待される。

以上の5つのトレンドは、6月14日にNEDOが発表した「人工知能(AI)技術分野における大局的な研究開発のアクションプラン(AIアクションプラン)」および6月14日に開催されたAIアクションプラン・シンポジウムでの討論内容と一部重複しています。具体的には、「自己教師ありディープラーニング」は「スモールデータ駆動」と、「ハイブリッドモデル」は「2階建て脳」、「システム2のディープラーニング」は「2階建て脳におけるシステム2」と重複します。このように、次世代型AIを実現するための技術研究は世界同時進行的と言えます。

なお、以下の記事本文はAlberto Romero氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならび組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

画像出典:UnsplashのSpencer Guから

目次

ディープラーニングはAIを支配しているが、その覇権を維持し、この分野を次のレベルに進めるためには更新が必要だ

人間とは、発明する種族である。世界は私たちに原料を提供し、巧みな技術でそれを作り変える。テクノロジーは無数の道具や装置を生み出してきた。車輪、印刷機、蒸気機関、自動車、電気、インターネット……これらの発明は、私たちの文明と文化を形成し、今もそうである。

私たちが生み出した最新の技術的な子供のひとつには人工知能があり、近年、生活に密着したツールとなっている。それが社会に与える影響は際立っており、今後数十年にわたって成長し続けると予想される。AIの代表的な顔の一人であるアンドリュー・ングは、「AIは新しい電気だ」とまで言っている。スタンフォード・ビジネス誌のインタビューでは、「100年前に電気がほとんどすべてのものを変えたように、今日、AIが今後数年のうちに変えないと思われる産業を考えるのはじつに難しい 」と彼は述べている(※訳註1)。

しかし、AIは新しいものではない。1956年にジョン・マッカーシーがAIという言葉を作り、AIを独自の研究分野として提案した時から存在している。それ以来、AIは無関心な時代と、絶え間ない資金提供や関心を持つ時代を交互に繰り返してきた(※訳註2)。現在では、機械学習とディープラーニング(Deep Learning:以下、「DL」はディープラーニングを意味する)がAIを独占している。2012年に始まったDL革命はまだ終わっていない。DLはAIの王冠を戴いているが、その王座を維持するためにはいくつかの変更が必要だというのが専門家の意見だ。以下ではDLの未来について見ていこう。

- AIの社会実装を遅らせているのは、人材不足とデータ不足。

- 「邪悪なAI」あるいは「キラーロボット」誕生への懸念は、火星の人口過多を心配するくらいナンセンス。

- アメリカ政府は、AIによる労働環境の再編に対応すべく、教育制度の改革とセーフティネットの整備をすべき。

『【5分でわかる】AI研究、60年の歴史を完全解説!』

『【資格対策にも!】ダートマス会議からシンギュラリティまでAIの歴史を年表でおさらい』

『世界AI研究者列伝 -AI史に名を残した研究者24人の業績を振り返る-』

・・・

畳み込みニューラルネットワークの撤廃

「AIのゴッドファーザー」と呼ばれるジェフリー・ヒントンのチームが、畳み込みニューラルネットワーク(CNN)をベースにしたモデルで2012年のImageNetチャレンジに優勝したことで、DLの人気が急上昇した。彼らは(非DLを採用した)ライバルを10%以上の誤差で消し去って、63.30%というトップ1の精度を達成した。この10年間にDLがもたらした成功と関心は、CNNのおかげだと言えるだろう。

CNNベースのモデルは、画像の分類、物体の検出、顔認識などのコンピュータビジョンのタスクで非常に人気がある。しかし、その有用性にもかかわらず、ヒントンはAAAI 2020の基調講演で1つの重要な欠点を指摘した。「(CNNは)回転や拡大縮小などの視点変更の影響を扱うのが得意ではない」、と彼は語ったのだ。

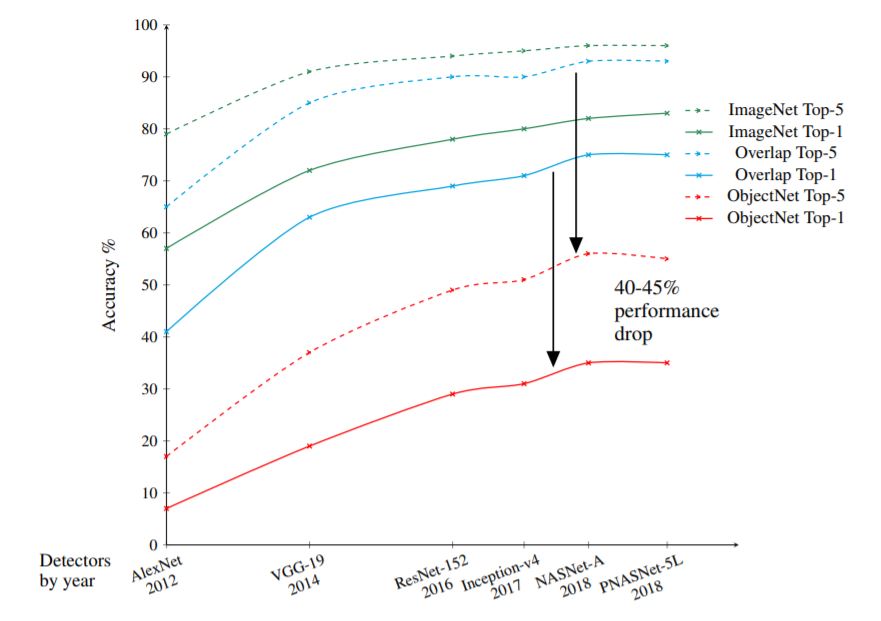

CNNは(画像の)変換を処理できる。しかし、人間の視覚システムは異なる視野角、背景、照明条件のもとでも物体を認識できる一方で、CNNはそれができない。ImageNetベンチマークで90%以上のトップ1精度を達成している現在最高峰のCNNシステムが、現実世界のオブジェクトデータセットの画像を分類しようとすると、40~45%の性能低下をきたすのだ(※訳註3)。

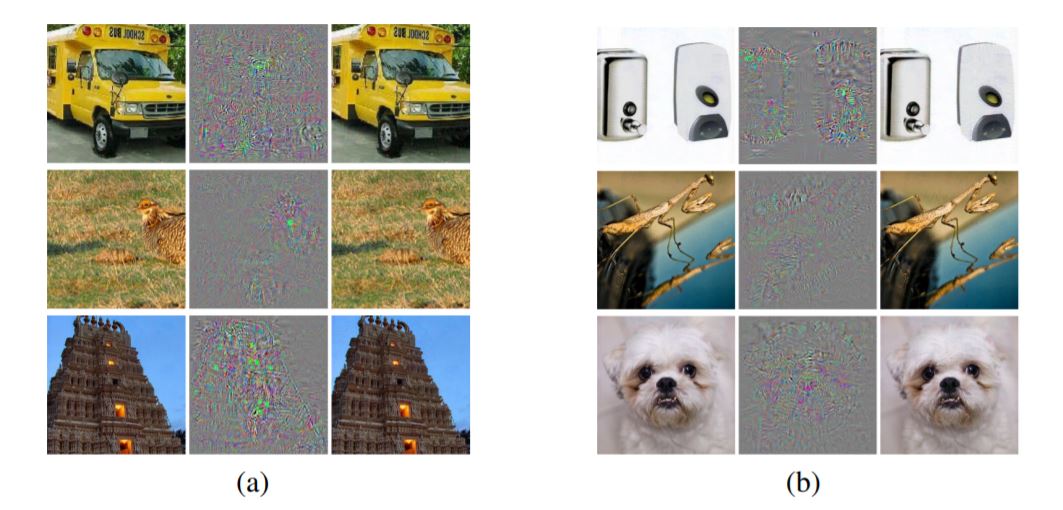

もうひとつの問題は、いわゆる敵対的な事例である(※訳註4)。ヒントンは、人間の視覚システムとCNNとの違いを改めて強調する。”画像にほんの少しのノイズを加えると、CNNはそれをまったく別のものとして認識するが、私にはそれが変わったことがほとんどわからない。(中略)このことは、CNNは実際には人間とはまったく異なる情報を使って画像を認識しているという証拠だと思う」。CNNは人間の視覚システムとは根本的に違う。予測不可能なため、単純にCNNを頼れない。

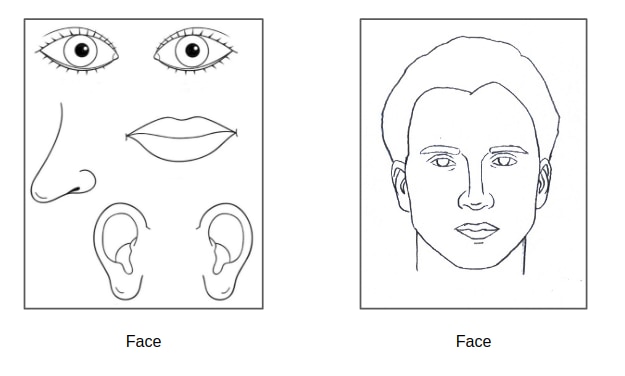

ヒントンはさらに一歩進んで、CNNシステムは画像のなかのオブジェクトを解釈できないと説明する。私たちは物体が世界に存在することを知っているし、それに関する経験もある。非常に幼い頃から、固体性、形状の恒常性、あるいは物体の永続性について知っている。私たちはこうした知識を使って奇妙な物体を理解できるが、CNNはピクセルの束しか見ていない。コンピュータビジョンのパラダイムを根本的に転換する必要があるかも知れず、その転換はもしかしたらカプセルネットワークかも知れない(※訳註5)。量子力学の父、マックス・プランクは以下のような言葉を遺した。

「科学はひとつの葬式ごとに進歩する」

画像出典:論文「ObjectNet: A large-scale bias-controlled dataset for pushing the limits of object recognition models」よりグラフを引用

画像出典:論文「Intriguing properties of neural networks」より画像を引用

画像出典:出典:Kendrick「Capsule Networks Explained」より画像を引用

・・・

自己教師ありディープラーニング

「AIの次の革命は、教師ありでもなく、強化学習でもまったくない」

– FacebookのチーフAIサイエンティスト、ヤン・ルカン

現在のDLにおける限界のひとつは、膨大な量のラベル付きデータとコンピューティングパワーに依存していることである。DLの先駆者であるヤン・ルカンは、ほとんどのDLシステムの学習方法である教師あり学習を、彼が言うところの「自己教師あり学習」に置き換える必要があると言っている。

(自己教師あり学習」とは)課題を学習する前に世界を表現することを学ぶという考え方だ。これは、乳児や動物が行っている。いったん世界をうまく表現できれば,課題の学習に必要な試行回数やサンプル数は少なくて済む。

ラベル付けされたデータでシステムを学習するのではなく、システムは生データからラベル付けを学習する。私たち人間は、教師あり(または強化学習)システムよりも桁違いに早く学習する。子供たちは、何百枚もの木の画像を見て木を認識できるようになるわけではない。1枚の画像を見て、直感的にそのカテゴリーに属すると分かったものに「木」というラベルを付ける。私たちは観察によって学ぶこともあるが、それはまだコンピュータにはできない(※訳註6)。

ヤン・ルカンは、2019年12月にこのトピックについて詳細な講演を行った。彼は、自己教師ありシステムは、「入力の任意の部分を他の任意の部分から予測」できるようになると主張した。例えば、過去から未来を、あるいは見える部分からマスクされた部分を予測できるのだ。しかし、この種の学習は、テキストなどの離散的な入力には効果を発揮するが(GoogleのBERTやOpenAIのGPT-3が好例)、画像や音声、動画などの連続的なデータにはあまり効果を発揮しない。そのためには、世界に内在する不確実性を扱うのに適した潜在変数エネルギーベースのモデル(※訳註7)が必要であると説明した。

自己教師あり学習は、教師あり学習を駆逐するだろう。まだまだ課題は残っているが、その差を埋めるための橋渡しはすでに始まっている。いったん自己教師あり学習のある世界にたどり着いてしまえば、もう後戻りできないのは確かだろう。

「ラベルは機械学習研究者のアヘンである」

– ジテンドラ・マリク、カリフォルニア大学バークレー校電気工学&コンピュータサイエンス学科教授

画像出典:論文「Implicit Generation and Modeling with Energy-Based Models」より画像を引用

・・・

ハイブリッドモデル:シンボリックAI+ディープラーニング

シンボリックAI(別名:ルールベースAI)とDLという2つのパラダイムは、AIの創世記から圧倒的な人気を誇っている。シンボリックAIは50年代から80年代まで一世を風靡したが、現在ではほとんどの専門家がこのフレームワークに反対している。ジョン・ハウゲランドはその著書『人工知能:この素晴らしいアイデア』の中で「GOFAI(Good Old-Fashioned Artificial Intelligence:古き良き伝統的な人工知能)」と呼んでいる。

(シンボリックAIは)主に数理論理学にもとづいた表現言語でモデル化された現実世界の抽象的な表現を扱う。

シンボリックAIは、トップダウン型のAIだ。これは、アレン・ニューウェルとハーバート・サイモンが提唱した「物理記号システム仮説」(※訳註8)にもとづき、「問題を高レベルの記号で表現する」ことで機械に知能を持たせようとするものである。例えば、この類のAIの代表格であるエキスパートシステムは、人間の意思決定をif-thenルールにもとづいてエミュレートするように設計されている。

ハイブリッドモデルは、シンボリックAIとDLの長所を組み合わせた試みである。マーティン・フォードは著書『知能の建築家』のなかで、このアプローチについてAIの専門家たちにインタビューしている。アンドリュー・ングは、少量のデータセットしかない問題に取り組む際の有用性を強調している。MITの計算論的認知科学の教授であるジョシュ・テネンバウムは、彼のチームと共同で「視覚的な概念、単語、文章の意味解析をいずれも明示的な教師なしに学習する」ハイブリッドモデルを開発した。

ニューヨーク大学の心理学教授であるゲイリー・マーカスは、常識的な推論にはハイブリッドモデルを用いた方がよいと主張している。最近の論文で、彼は人間の知性を引き合いに出して自分の主張を強調している。

「妹」のような無数の家族に適用できる言葉の意味を(中略)子供が学ぶ時のように、何らかの形でシンボルを操作することは、人間の認知には不可欠であると思われる。

その将来性にもかかわらず、ハイブリッド・アプローチには重大な反論者がいる。ジェフリー・ヒントンは、シンボリックAIでDLを台無しにしようと意図する人々を批判している。「ハイブリッドモデル推進派は、ディープラーニングが驚くべきことを為しているのを認めなければならない。しかし、彼らは記号的推論を機能させるために必要なものを提供する低レベルの使用人のようなものとして、ディープラーニングを使おうとしている」と彼は言っている。とは言え、うまくいくかどうかは別にして、ハイブリッドモデルは今後数年間、目が離せないものになるだろう。

「数年以内に、多くの人が、なぜディープラーニングは長い間、記号操作という素晴らしい価値のあるツールを使わずに、これほどまでに大きな成果を上げようとしていたのか、と思うようになるだろうと私は予測している」

– ゲイリー・マーカス

・・・

システム2のディープラーニング

2018年のチューリング賞受賞者トリオ(ヒントン、ルカンとともに)を成すヨシュア・ベンジオは、2019年に「システム1のディープラーニングからシステム2のディープラーニングへ」と題した講演を行った。彼は、より大きなデータセット、より大きなコンピュータ、より大きなニューラルネットなど、すべてを大きくすることがトレンドとなっているDLの現状について語った。そして、この方向性ではAIの次のステージには行けないと主張した。

「私たちは、非常に狭い範囲で学習する機械を持っています。この機械は人間知能の学習事例よりもはるかに多くのデータを必要とし、(それでも)愚かな間違いを犯すのです」

ベンジオは、ダニエル・カーネマンが主著『シンキング、ファスト&スロー(邦題『ファスト&スロー あなたの意思はどのように決まるか?』(上)(下))』で提唱した2つのシステムの枠組みを採用している。カーネマンは、システム1を「ほとんど、あるいは全く努力することなく、自発的に制御しているという感覚もなく、自動的に素早く動作する」と表現する一方で、システム2は「しばしば主体性、選択、集中といった主観的な経験に関連しており、努力を必要とする精神活動に注意を配る」と述べている。

ロブ・トーズがDLの現状を次のようにまとめている。「現在の最先端のAIシステムは、システム1のタスクには優れているが、システム2のタスクには非常に苦労している」。ベンジオも同じ意見だ。「我々(人間)は、アルゴリズムやレシピを考え出し、計画し、推論し、論理を使える。こうした課題のいくつかをコンピュータが実行するのに要する時間をほかのタスクと比較した場合、非常に遅い。こうした課題についても、未来のディープラーニングでうまくできるようになって欲しいと望んでいる」。

ベンジオは、システム2のDLは「異なる分布のデータ」、いわゆるアウトオブオーダー分布に一般化できるようになると主張している。現在、DLシステムは同じ分布のデータセットでトレーニングとテストを行う必要があり、この必要性は独立同分布のデータ(※訳註9)という仮説に対応している。「不均一なデータに対しても継続的な学習を行えるシステムが必要なのだ」とも彼は言っている。System 2のDLは、均一ではない現実世界のデータを使うことに成功するだろう。

そのためには、より優れた転移学習機能を持つシステムが必要になるだろう。ベンジオは、attentionのメカニズムとメタ学習(学習するための学習)が、システム2の認知における基本的な構成要素であると示唆している。システム2のAIに求められる変化し続ける世界に適応するための学習の重要性を強調した言葉として、ダーウィンの名著『種の起源』における中心的なアイデアを表現した一節を引用しよう (彼が言ったとしばしば誤解されているのだが(※訳註10))。

「生き残るのは最も強い種でもなく、最も知的な種でもなく、最も変化に対応できる種である」

IIDが観察される事例には、サイコロの出目がある。サイコロの出目が連続20回「6」が出たとしても、21回目に「6」が出る確率は以前の出目から独立しておりかつ同一な「6分の1」である。IIDは、AIモデル構築時に収集したデータを学習データとテストデータに分割して性能を評価する交差検証の前提となっている。

・・・

神経科学にもとづくディープラーニング

「人工ニューラルネットワークは、脳の働きを大まかに表現したものに過ぎない」

– デイヴィッド・スシーロ、Google ブレイングループ所属

1950年の10年間に、いくつかの重要な科学的ブレークスルーがあり、それがAIを誕生させる基礎となった。神経科学の研究により、脳は「すべてかゼロか(all-or-nothing)を示すパルスで発火する」神経ネットワークで構成されていることがわかった。この発見は、サイバネティックス、情報理論、アラン・チューリングの計算理論などの理論的記述と相まって、人工的な脳を作る可能性を示唆するものだった。

AIは人間の脳に起源を持つが、現在のDLは人間の脳のようには動いていない(※訳註12)。DLシステムと人間の脳の違いについては、すでにこの記事でもさりげなく触れている。CNNは人間の視覚システムのようには動かない。私たち人間は、ラベリングされたデータから学習するのではなく、世界を観察する。ボトムアップの処理とトップダウンの記号操作を組み合わせてもいる。そして、システム2の認知を行っている。AIの最終的な目的は、私たちの脳をシミュレートできる電子頭脳、つまり汎用人工知能(強いAIと呼ぶ人もいる)を構築することだった。神経科学は、この目標に向けてDLを助けられる。

脳の構造をシミュレートしたハードウェアを意味するニューロモーフィック・コンピューティングは、重要なアプローチのひとつだ。私は以前の記事で「生物学的なニューラルネットと人工的なニューラルネットには大きな違いがある」と書いた。「脳内のニューロンは、信号の強さ(電圧)を一定に保ちながら、スパイクのタイミングと頻度で情報を伝達する。人工ニューロンはその逆である。それは、タイミングと頻度ではなく入力における(電圧の)強さでのみ情報を伝達しようとする」。ニューロモーフィック・コンピューティングは、この違いを小さくしようとしている。

人工ニューロンのもうひとつの欠点は、その単純さだ。人工ニューロンは、生物のニューロンが「基本的な計算しかしないお粗末な計算機」であることを前提に作られている。しかし、この前提は、真実から大きく外れている。ドイツの研究者グループは、Science誌に掲載された研究で、「単一のニューロンで複雑な機能が実際に実行できるかも知れず、例えば、たったひとつのニューロンそれ自体でオブジェクトを認識できるかも知れない」ことを示したのだ。

「もしかしたら、(脳の)1つのニューロンの中に、深いネットワークがあるかも知れない」

– ヨイタ・ポイラジ、 分子生物学&バイオテクノロジー研究所所属 (ヘラス研究技術財団, ギリシャ)

DeepMindのCEO兼共同創業者であるデニス・ハサビスは、Neuron誌に掲載された論文のなかで、AIを前進させるために神経科学を利用することの重要性を表明した。彼の論文は前述したいくつかのアイデアとは別に、2つの重要な側面を際立たせている。直感的な物理学とプランニングだ。

ジェームス・R・クブリチと彼の同僚は、直感的物理学を「物理的環境を理解し、動的に状態が変化する物体や物質と相互作用し、観測された事象がどのように展開するかを少なくとも近似的に予測する人間の能力の基礎となる知識」と定義している。DLシステムにはこうした知識がない。DLシステムは世界のなかに存在せず(※訳註13)、具現化されておらず、人間が周囲の環境に適応するのに有利であった進化の手荷物(※訳註14)も持っていないからだ。ジョシュ・テネンバウムは、この能力を機械に植え付けることに取り組んでいる。

プランニングとは、「与えられた目標を達成するために、どのような行動を取るべきかを決めるための探索 」と理解できる。私たちは日常的にこれを行っているが、現実の世界は機械にとって複雑すぎる。DeepMindのMuZeroは、プランニングによって世界的に有名ないくつかのゲームをプレイできるが、これらのゲームは完璧に定義されたルールと境界線を持っている(※訳註15)。

有名なコーヒーテストは、プランニング能力を持つAIが、平均的な家に入り、キッチンに行き、材料を取ってきて、コーヒーを作れるかどうかを試すテストを提案している。計画を立てるためには、複雑なタスクをサブタスクに分解する必要があるのだが、この能力は現在のDLシステムの能力を超えている。ヤン・ルカンはこのテストを「どうやって解いていいのかわからない」ことを認めている。

神経科学からDLが得られるアイデアはたくさんある。もし私たちが知能に近づこうとしているのなら、私たちが持っている唯一の知能のサンプルである人間の脳を調べずに何をすると言うのだ。デミス・ハサビスは以下のように言っている。

「人工知能が多くの問題を抱えている現在、神経科学とAIの分野が一緒になる必要性は以前にも増して高まっている」

|

人間の脳 |

人工ニューラルネットワーク |

|

|

サイズ |

860億の神経細胞 | 10~1,000のニューロン |

|

学習機能 |

曖昧な概念も学習可 | 曖昧な概念を学習するためには精確にして構造化されたデータが必要 |

|

トポロジー |

非同期的な接続による複雑なトポロジー | 層となった木構造的なトポロジー |

|

消費エネルギー |

出力より少ない消費エネルギー。20ワット程度 | 出力より大きい消費エネルギー |

・・・

結論

DLシステムは非常に便利だ。ここ数年、DLシステムは単独で技術をめぐる光景を変えてきた。しかし、真の意味での知的機械を実現するためには、「大きいことは良いことだ」という概念を捨て、DLシステムを質的に刷新する必要がある。

このマイルストーンを達成するために、今日ではいくつかのアプローチが存在する。CNNとその限界の撤廃、ラベル付きデータの撤廃、ボトムアップとトップダウンの処理を組み合わせ、システム2の認知機能の機械への実装、神経科学と人間の脳からアイデアと進歩を取り入れる、などだ。

真に知的なシステムを実現するためには、どの道が最適なのかはわからない。ヤン・ルカンの言葉を借りれば、「誰も完全な正解を持っていない」。しかし、私はいずれ完全な正解にたどり着けると大いに期待しているのだ。

・・・

おすすめの記事

原文

『5 Deep Learning Trends Leading Artificial Intelligence to the Next Stage』

著者

Alberto Romero

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん