テキスト要約は、自然言語処理研究のなかでもあまり成果があがっていない分野です。というのも、テキスト要約はどんな人が読者なのか(専門家か一般読者か)、どんな文体でまとめるのか(報告書のようにか、それとも感情に訴えるようにか)といった要約に求められるコンテクストによってその内容を変えなければならないからです。こうした難しさにより、GoogleやMicrosoftといった大手テック系企業も初歩的な要約AIしか開発できていません。

テキスト要約には、テキストにおける重要箇所を抽出してつなぎ合わせる抽出型要約とテキストの内容をまとめた短文を生成する抽象型要約の2種類があり、それらの特徴は以下のような表にまとめられます。

抽出型要約と抽象型要約の長所・短所

|

長所 |

短所 |

|

| 抽出型 | 開発が比較的容易 | 内容の全体的把握には限界がある。 抽出されなかった箇所は、決して読まれない。 |

| 抽象型 | 人間の専門家が作成した要約に近くなる。 内容の全体的把握が可能。 |

文章生成モデルの開発が前提とされるので、開発が困難。 |

前述のようにテキスト要約はコンテクストを考慮しなければならないので、どんなテキスト内容とコンテクストにも対応した汎用要約AIを開発するのは極めて困難です。しかし、こうした困難があるため特定の内容とコンテクストにフォーカスした特化型要約AIを開発する余地があり、この余地にこそスタートアップが要約ビジネスで成功するチャンスがあります。以下の記事本文では、要約ビジネスを展開するスタートアップが紹介されています。

要約ビジネスは、テキストだけではなく音声や動画を対象にスケールアップできる可能性があります。もっとも、音声や動画の要約技術は、テキスト要約以上に研究が遅れています。しかしながら、音声や動画に関する実用的な自動要約AIの開発は時間の問題かも知れない、とTurc氏は予想しています。

なお、以下の記事本文はJulia Turc氏に直接コンタクトをとり、翻訳許可を頂いたうえで翻訳したものです。また、翻訳記事の内容は同氏の見解であり、特定の国や地域ならびに組織や団体を代表するものではなく、翻訳者およびAINOW編集部の主義主張を表明したものでもありません。

以下の翻訳記事を作成するにあたっては、日本語の文章として読み易くするために、意訳やコンテクストを明確にするための補足を行っています。

画像出典:UnsplashのSteve Johnsonより

目次

そして、その難しさがスタートアップ企業にどのような機会をもたらすのか。

自然言語処理(NLP)のタスクのなかで、要約は間違いなく最も見出しを飾らないタスクの1つだ。記事の内容を縮小することは、GPT-3がスタートアップのアイデアを自動的に生成することに比べれば、ずっと目新しさがない(※訳註1)。しかし、その知名度の低さにもかかわらず、テキストの要約は、特に産業界において、解決には程遠いところにある。Microsoftのような大企業が提供する初歩的なAPIには(※訳註2)、小さな会社がさまざまな角度から要約に取り組む余地がたくさん残っており、要約に関する明確な勝者はまだ見えていないのだ。この記事では、テキスト要約が依然として難題である理由について考察する。

要約はテキスト-to-テキスト以上のもの

直感的には、要約は非可逆圧縮によるテキストからテキストへの変換と見なせる。現実的には、要約は(テキスト+コンテクスト)-to-テキストの問題である。

要約とは長い文章を短くすることであり、その過程で重要でない情報は捨てられる。しかし、重要な情報とは何だろうか。その答えは、テキストが論じている分野、対象読者、要約自体の目標に大きく依存するため、普遍的な判断を下すことは非常に困難である。例えば、COVID-19に関する科学論文について考えてみよう。要約は生物学の専門用語を含むべきか、それとも素人にも理解できるものであるべきだろうか。それとも主な発見した事実に関する無味乾燥な羅列であるべきか、あるいは読者に論文全体を読んでもらうために、簡潔でサスペンスフルなものにすべきなのだろうか。

言い換えれば、何が良い要約を構成するかはコンテクストに依存する。要約は単なるテキストからテキストへの変換ではなく、むしろ(テキスト+コンテクスト)からテキストへの問題なのである。MicrosoftのAzure Cognitive Serviceのような汎用要約APIは、素朴なテキスト-to-テキストの定義に準拠している。現状の汎用要約APIは求められる要約の長さ以外には、求められる出力に関するいかなる指定も許可していない。こうした理由により現在の要約APIは、コンテクストのニュアンスを汲むことが製品の良し悪しを決めるような実用的なアプリにはなっていないのだ。

抽出は素朴、抽象は無根拠

要約の分野では、要約は抽出型(すなわち、原文からの抜粋)か抽象型(すなわち、新たに生成されたテキスト)の二者択一であることが確立されている。 抽出型要約は、原文のなかから重要な文章を探し出すので、(文章を誤魔化すようにして悪意のある抽出をしない限り)大意を正確に反映する傾向がある。しかし、抽出型要約は内容を完全に把握するには限界があり、要約から欠落した文章は永遠に失われることになる、という欠点がある。

一方、抽象型要約は人間が要約する方法を模倣している。私たち人間が要約する時は、より高いレベルの視点から、全体のストーリーを伝えることを目的として(元の文章を)新しい文章にまとめる。しかし、抽象型要約はGPTファミリーのような生成モデルが必要なため、技術的に困難である。現在、このようなモデルは妄想に悩まされており、その出力は事実と異なっていたり、原文によってサポートされていなかったりすることがある。入力テキストに忠実であることは議論の余地がないことなので、原文に依拠しないことは要約にとって大きな障害となる。妄想を防ぐことは活発な研究分野であるが、ある一定の品質水準を保証する批判の余地のないような解決策は存在しない。Googleが提供する抽象型要約APIがまだ実験段階にある(つまり、Google Cloud Platformを通じて提供される製品のように公式にはサポートされていない)のは、以上のような事情のためである。

自然言語処理はまだ長い文書に苦労している

その定義からして、要約は長い入力テキストを想定している。長いテキストでなければ、そもそも要約の必要性がない。しかし、自然言語処理の分野では、サイズの大きな文書の処理に苦労しているのが現状である。

支配的なモデルアーキテクチャであるTransformerでは、入力トークンの最大数を数千に制限している。このトークン数を超える文書は、個別に要約されるべき断片に分割される必要がある。最終的な結果は、独立したサブサマリーの単なるつなぎ合わせになる。ニュース記事のように、ある程度独立したセクションに分割されている文書タイプでは、この手法で済むかもしれない。しかし、小説のような、章と章の間に複雑な依存関係がある文書に適用すると、この手法は使いものにならなくなる。例えば、(小説に登場する)ある人物の歩みは本全体にまたがることが多い。サブサマリーは単純に連結されるため(そして互いに意識されない)、サマリー中の人物の軌跡も断片的なものとなってしまう。一文では彼らの旅路を簡潔に捉えられないのだ。

企業の要約への取り組み方

要約には普遍的なソリューションがないため、対象となる文書の性質に応じて、手作業から完全自動化まで、各社が全く異なる方法で取り組んでいる。

人間が作成した書籍の要約

Blinkistや12minのような会社は、ノンフィクションの本に関する高品質の要約を作成するために人間の専門家を雇い、15分以内に読めるようにしている。このアプローチでは高品質のコンテンツが保証される一方で、(要約リストの規模が)人間が監修したベストセラーのリスト以上にはならないため、嗜好がかなり特殊な読者には役に立たないだろう。

中型コンテンツの自動要約

ブログ記事、ニュース記事、研究論文、社内文書などのような中規模のコンテンツの要約を作成することは自動処理による恩恵を受けやすいのだが、依然として手間のかかる作業のままである。入力ドメイン(ニュース、法律、医療など)と出力形式(箇条書き、ハイライト、一節の要約など)で定義される各ユースケースには、個別の学習データセットと、潜在的には個別の学習モデルが必要となる。

Googleドキュメントで自動生成される要約の新機能を発表したGoogle AIの最近のブログ記事では(※訳註3)、特定の入力ドメインに焦点を当てたクリーンな学習セットを収集し、収集した要約全体に一貫したスタイルを強制したことが解説されている。

[…](自動要約の)初期バージョンのコーパスにはさまざまなタイプの文書とさまざまな仕方で書かれた要約が含まれていた。例えば学術的な要約は一般的に長く詳細な一方で、経営陣向けのそれは簡潔でパンチが効いていた。それゆえ、そうしたコーパスには一貫性のなさや多くのばらつきが見られた。その結果、あまりにも多くの異なるタイプの文書や要約について学習したため、モデルが簡単に混乱してしまい、それらのあいだの関係を学習するのに悪戦苦闘していた。[…]そこで私たちは、より一貫性があり、まとまりのある要約の定義を表すような学習事例を含むように、ファインチューニング用データに対してクリーニングとフィルタリングを慎重に行った。その結果、学習データの量を減らしたにもかかわらず、より質の高いモデルの開発につながった。(Google AIブログ記事より抜粋)

Google開発のテキスト要約機能には、要約モデルPEGASUSが活用されている。同モデルの革新性は、GSP(Gap Sentence Prediction:ギャップとなる文の予測)と命名された事前学習が実施されたことにある。この学習は、ラベル付けされていないニュース記事やウェブ文書の一部をマスクしたものを入力として与えたうえで、マスクされていない残りの文章を予測するというものである。

PEGASUSをGoogleドキュメントに実装するにあたっては、この記事で引用されているようにファインチューニング用データを整備して、要約品質を向上させた。

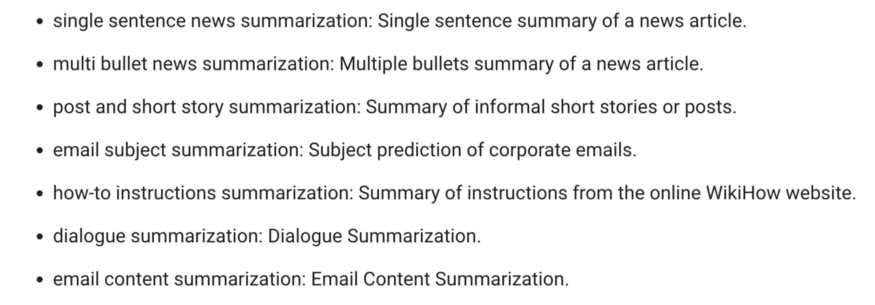

Googleは抽象型要約に関する実験的APIが達成すべきさまざまな目標を設定している。それらは以上の同社によるアドバイスと矛盾してなく、以下のようにより狭い応用に焦点を当てている。

Googleの実験的な抽象型要約API(現在プライベートアクセス版状態)で提供される個別的な要約モデル。

Googleが開発中の実験的抽象型要約モデルが遂行するタスク一覧

|

スタートアップのケーススタディ:Summari

(この記事は、Summariやその他の紹介した製品によってスポンサードされていない)

どんなコンテクストにおいても要約を実行できる堅牢なモデルがないことは、スタートアップにとって大きなチャンスとなる。スタートアップは、大手ハイテク企業があまり魅力を感じないニッチな分野にレーザーフォーカスできるのだ。

例えばSummariは、インターネットの消費者が記事を最後まで読む前に、それを選別できるようにすることを使命としている。以前のインタビューで、同社創業者は要約の最先端技術に失望し、当初は人間が作成した要約を提供することを選択したと話した。

残念ながら、AI技術から期待したような品質を得られませんでした。私たちは、優れた要約には芸術性があると信じています。優れた要約に必要なのは単に文章からフレーズを選んでコピーすることではなくより深い理解であり、それには少なくとも今のところ人間が必要です(Ed Shrager、Summari創業者、Ness Labsのインタビュー記事より)。

Shrager氏によると、あらゆるコンテンツはそれを消費した後にしかその価値がわからないという「コンテンツ消費のパラドックス」に悩まされている。このパラドックスは、コンテンツ過多の時代を生きる消費者にとって非常に不都合である。この問題に対して、例えば映画産業は予告編を制作するという解決策を採ってきた。同氏がSummariを創業したのは、あらゆるコンテンツについて映画の予告編のような要約を制作して、消費者がコンテンツを消費する前にその価値を知れるようにしたかったからである。

Shrager氏は、要約は生産性向上にも寄与すると述べている。例えば、10人のチームメンバーに読むのに10分を要する文書を読むように指示した場合、チーム全体で合計して100分の時間を文書理解に費やすことになる。対して1分で読める要約を読むように指示すると、チーム全体で文書理解に費やす時間は10分に短縮される。

インタビューから約1年後、Summariはテキストコンテンツを含むほぼすべてのWebサイトのハイライトを生成するChrome拡張機能を提供するようになった。人間が作成した要約は間違いなくクリーンな学習セットとなり、本来の使命を自動化し、スケーリングするモデルを構築することを可能にした。 こちらのリンクから、Summariが生成したこの記事の要約が読める。

テキストを超えて:音声と動画の要約

音声や映像に比べて、テキストは間違いなく要約しやすいモダリティである。音声や映像に関する最先端のモデルや業界の慣行が、テキストに遅れをとっていても驚きではない。

例えば、ポッドキャストを短縮するための自動化は、ほとんど行われていない。一般的な慣行のひとつに、ポッドキャスターが本編のエピソードから切り取った短いYouTubeクリップを公開することがある(例えばJoe Roganのチャンネルを視聴してみよう)。この事例は、手作業による抽出型要約に相当する。これに対して、Blinkistはポッドキャスト・クリエーターと直接協力して、「ショートキャスト」と呼ばれるエピソードの短縮版を追加制作している。これは、手作業による抽象型要約に相当する。

しかし、自動化の目処は立っている。Snackableのようなスタートアップは、今のところ純粋に抽出的な方法で、音声と動画のファイルから重要な断片を自動的に抽出してつなぎ合わせることを目指している。動画を操作したり生成したりする技術の進歩により、これらのモダリティで抽象型要約が可能になるのは時間の問題かもしれない。

結論

テキストの要約はコンテクストに大きく依存するため、難しいタスクである。そのため、単一の普遍的なソリューションに収束したり、全能のGPTモデルに頼ってあらゆる状況に対して正しい要約を作成したりすることは、ほとんど不可能である。こうしたソリューションが断片化された状況により、非常に特殊なユースケースに焦点を当てたクリーンな学習セットに投資し、大手テック系企業が提供するものを補完する機会がスタートアップに与えられるのだ。

・・・

いつも思慮深い視点を私と共有してくれるGaurav Nemadeに特別な謝意を捧げます。

原文

『Why Text Summarization Is Still Hard』

著者

Julia Turc

翻訳

吉本幸記(フリーライター、JDLA Deep Learning for GENERAL 2019 #1取得)

編集

おざけん