目次

- (前回の記事)

- 4回目の記事に続く。

(前回の記事)

では、情報解析技術の進歩は、GNR技術の発展をどのような形で牽引しているのか?

ところで、上記のHatena Blogの記事は、カーツワイル氏の著書について、次のような問題提起も投げかけています。

カーツワイル氏が主張するあらゆるテクノロジーの指数関数的成長は現在のところ実証的には観察できず、指数関数的に成長しているものは情報テクノロジーに限られています。

小野寺もこの見方に賛同します。

カーツワイルの著書は、単位時間あたりの演算回数や、演算に要するエネルギーの量や放熱量や、計算機が物理空間を占有する空間の大きさ(端的に言うと、計算機のサイズ)といった尺度で評価しうる「演算技術」としての「情報技術」(ハードウェアとしての計算機に関する技術)に、多くの紙幅(ページ数)を割いています。

それと比べると、「記号」の配列(記号系列)が担っている「意味」を「読み解」いたり、意味を理解した記号の配列順序(配列構造)を並び替えることで、これまでになかった新しい「意味」を担う(新しい)記号列を生み出す「情報解析技術」が、「近未来論」として、今後、どのように技術進歩していくのか、という主題には、あまり多くのページ数を割いていないように思われます。

以下、こうした点を丁寧に論じていきます。

カーツワイルにおける「情報技術」は計算技術(Computing)が中心

カーツワイル氏の著書 Singularity is Nearの中で、「情報技術」・「情報テクノロジー」として述べられている文章の大部分は、

記憶メモリと(時間と金銭的コスト当たりの)演算量とデータ転送能力などを評価指標とする「コンピューティング」(計算ハードの技術)であり、データの解析・操作(改変)技術を、人工知能アルゴリズムによって行う「情報処理技術」ではありません。

この「コンピューティング」としては、以下が取り上げられています。

- ナノ・コンピューティング(炭素原子をらせん状に並べたナノ・チューブ上によるビット演算とデータ記憶等)

- 「岩」などのありふれた物質(巨大な分子構造体)を構成する個々の原子・素粒子の性質を利用して、計算機として用いる技術

- DNAコンピュータ

- 3次元立体構造の半導体構築技術

- 可逆的な論理回路の組成により、エネルギー消費量がゼロで、熱放射もゼロを達成すうる計算機技術

このように、「情報技術」・「情報テクノロジー」として述べられている文章の大部分は、ハードウェアとしての計算機における「演算技術」としてのInformation Technologyが中心です。

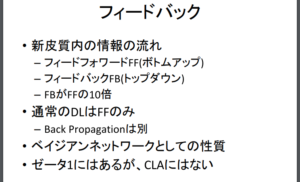

公平を期すと、AI(人工知能)について、カーツワイル氏の著書 Singularity is Nearの邦訳書『ポスト・ヒューマン誕生』(NHK出版)も、たしかに言及してはいます。

それも、327ページ目~378ページ目という、ある程度まとまったページ数を割り当てています。

しかし、そこで述べられているのは、以下を一例とする人工知能アルゴリズムの概説的な紹介であり、「記号」列の解読・組み替え記述としての「遺伝子編集技術」や「ナノ・テクノロジー」や「特徴表現ベクトルを用いる機械学習・深層学習モデルの技術」が持つ、「記号」列の解読能力と組み替え能力が、今後、技術として、どのような軌跡をたどりながら向上・発展していくのかという技術論ではないのです。

【 取り上げられているA.I.手法(アルゴリズム)の例 】

- マルコフ・モデル

- ベイジアン・ネットワーク

- ニューラル・ネットワーク

- 遺伝的アルゴリズム

同書で述べられているのは、上記のAI手法が、同書出版当時(2005年)に「特化型AI」として、医療業界や人工衛星画像の解析業務、軍事用ロボットの開発現場などの個別の専門領域で、どのように用いられ、力を発揮しているのか、という事例です。

また、自己意識をもつ「強いAI」が、近い将来、どのような形で出現しうるのかについて、展望が述べられています。

上記で取り上げられている人工知能技術との関係で見た時、同書では、G・N・R、それぞれにおける「情報パターン」の解析・解読と操作・改変に、上記の各種の人工知能アルゴリズム(マルコフ・モデル等)が、具体的に、どのように活用されているのかという事柄については、主題的に取り組んでいないように見受けられます。

- [G] 遺伝情報の解読能力と操作・改変能力の向上に与える、AI技術の影響

- [N] 分子・原子スケールでの物質の組成の解析能力と操作能力の向上に与える、AI技術の影響

- [R] 人工知能搭載型(自律稼働型)ロボットの開発能力の向上に与える、AI技術の影響

なぜ、AIによる「情報パターン」の解読・改変は主題的に論じられていないのか?

GNR論を提唱したカーツワイル氏の著書 “Singularity is Near” (邦題 『ポスト・ヒューマン誕生』)は、どうして、計算技術(「コンピューティング技術」)に大半のページ数を費やす反面、「情報解析技術」(AIアルゴリズム)による「パターン情報」の「解読・解析」と「改変」技術については、主題的に論じていないのでしょうか。

「GNR」論を論じた著書の出版年は、2005年である

AIアルゴリズム技術の進展が、遺伝子情報や、物質組成構造、特徴表現ベクトルがもつ「パターン情報」を解読して、操作・改変(編集)する技術(テクノロジー)の進歩に対して、どのような影響を与えているのか、という主題が、明示的に取り上げられていない理由は、この文献が出版された時期に求めることができると考えることができます。

カーツワイルが「GNR」論を論じた『ポスト・ヒューマン誕生』の英語原書と日本語翻訳書が出版されたのは、2005年のことでした。

ということは、原稿の執筆が行われたのは、2005年か、2004年になされたことになります。

「ディープ・ラーニング」技術の飛躍は、2012年に起きた

ところで、「ディープ・ラーニング」に世の脚光が集まるきっかとなった出来事が起きたのは、2012年と2013年でした。

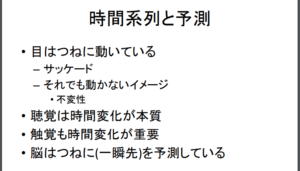

まず2012年に、画像認識(一般物体認識タスク)の世界で、「畳み込みニューラル・ネットワーク(CNNモデル)」が驚異的な能力を秘めていることが明らかとなり、世界を驚かせました。

次に、翌2013年には、今度は自然言語(英文)を処理する自然言語処理(NLP: Natural Language Processing)の世界で、個々の英単語が文書(document)の中でどのような意味合いで用いられているのかを、数学のベクトル形式でデータ表現で符号化することができることが認識されました。同時に、個々のベクトル(=個々の英単語)どうしの意味の足し算や引き算をすることができることも知られるようになりました。

この2つの出来事は、A.I.人工知能技術を飛躍的に高めたことで、AIの世界で「歴史的な出来事」として位置づけられています。これらの出来事は、AI技術の産業界における利活用を一気に推し進めることになりました。

2012年:ILSVRCコンテスト & 「Googleの猫」がもたらした衝撃

両年のうち、前者の2012年に起きたのは、「ディープ・ラーニング」アルゴリズムを用いた「CNNモデル」が(画像認識のタスク領域において秘めていた)驚異的な能力の発見と、社会からの注目です。

この年、2012年に開催された「ILSVRC 2012」(物体認識チャレンジ競技会)で、「畳み込みニューラル・ネットワーク(CNNモデル)」を用いたチームが、2位以下のチームが出したスコアを圧倒的に引き離す驚異的なスコアで優勝(Krizhevsky Alexほか(2012) “Imagenet classification with deep convolutional neural networks.” Advances in neural information processing systems”)したのです。

この「2012年」は、『ポスト・ヒューマン誕生』が出版された年(2005年)の7年後です。

また、「2012年」には、「Googleの猫」として知られることになったGoogle社の技術ブログ(と論文)が掲載されるや否や、情報解析の研究者や、情報解析業界のエンジニアたちから、瞬時に注目されるという歴史的な出来事が起きた年でもあります。

「Googleの猫」として知られるようになった出来事とは、以下のようなものです。

Google社はこの年、公式技術ブログと発表論文を通じて、CNN(畳み込みニューラル・ネットワーク)モデルが、「猫の顔」の特長部位を、人間から明示的に教え込まれなくても、アルゴリズムの動きだけによって、自力で(自律的に)見つけ出すことができるた、という解釈に結実する研究成果を公表しました。

具体的には、(「猫」の顔画像を学習させた)CNNモデルの「ある中間層」の「数値の並びパターン」を可視化(数値の値を色に変換した)した結果を、画像として公表したのです。

その画像には、「鼻」や「目」や「耳」などの「猫」の顔の各部位(各パーツ)の「特徴」(輪郭、色合いの変化、など)をとらえた(と、人の目からみて解釈できる)画像が、写っていました。

この「画像」は、CNNモデルが、人間から明示的に教え込まれることがなくとも、アルゴリズムの動きだけによって、自力で、(「猫」を、他の動物や、非生物の事物と見分ける上で手がかりとなる)「猫の顔」の各部位が持つ(複数の)特徴を見つけ出すことができるという「解釈」につながりました。

こうした「自力」で特徴を導き出す能力は、画像認識の領域で提案されてきたそれまでの手法技術は持たない「能力」でした。

(これまでの手法では、人間が識別モデルに対して、「猫を犬と見分けるときは、顔のこの部位に注目しなさい」、でも、「同じ猫どうしを見分けるときには、例えばアメリカン・ショートヘアとペルシャ猫を見分ける場合は、別のあそこの部位をみなさい」というように、識別すべき対象ごとに、注目すべき部位と、属性(色合いなのか、輪郭の形なのか、など)を、ひとつひとつ、人間が定義して、識別モデルに教え込ませなくてはなりませんでした)

CNNモデルが持つこのような驚くべき能力が高く評価されて、CNNモデルは、画像認識タスクの世界で、これまで提案されてきた他の数々の統計的機械学習・パターン認識手法(アルゴリズム)の中でも、抜きん出た能力を持つモデル(手法)として、圧倒的な注目を集めることとなったのです。

2013年:Word2Vecモデルの登場(単語の「分散表現」の時代の幕開け)

さらに、翌年の2013年には、今度は、英語を扱う自然言語処理のタスク領域で、単語の「足し算」と「引き算」を(「特徴ベクトル空間」の中で、ベクトルの加算・減算演算として)行うことができる「Word2Vec」モデルが、Mikolov氏らによって、論文として提案されました。

この「Word2vecモデル」は、2013年に発表された3本の論文の中で、提案されました。

- Tomas Mikolovほか(2013), Linguistic Regularities in Continuous Space Word Representations

- Tomas Mikolovほか(2013), Efficient estimation of word representations in vector space

- Tomas Mikolovほか(2013), Distributed representations of words and phrases and their compositionality

「Word2Vecモデル」の登場によって、画像データだけではなく、英語の文章(における各単語の持つ意味合い)データまでもが、(画像と文章は見た目が大きく異なるにもかかわらず)「特徴表現ベクトル」という、同じ「数値の並び」を持ったデータ形式(ベクトル)で表現できることが明らかになりました。

さらに、この「Word2Vecモデル」は、ベクトルどうしを足し引きしあうことで、「特徴表現ベクトル」によって表現(符号化、・記号化、encode)された2つの事柄(情報エンティティ)の中間にある意味をもつ事柄や、差分に相当する意味の事柄などを、人工的に、(高次元の)特徴空間ベクトル内で、(計算機上でデジタル計算される)数学演算によって、「生成」することが、高い精度で可能であるをも、明らかにしたのです。

ここから、画像や文章だけでなく、他のあらゆる属性を持つデータを、「分散表現」(distributed representation)による「特徴表現ベクトル」という同一のデータ形式によって、表現(encode)することができることが、明らかになりました。

さらに、このようにして得られた「特徴表現ベクトル」どうしを、(符号化する前の)元データの属性が同じ(画像どうし、文章どうし、等)であっても、異なる場合(画像と文章、など)であっても、特徴表現ベクトル空間という「共通の土俵」で、相互に比較したり、演算しあうことができることが、人工知能研究者の間での共通了解になりました。

ここから、「画像」と「音声」、「温度」、「加速度」、「Twitterにおける流行キーワードの頻度分布」といった、属性がまるで異なる(複数の)データどうしを、俯瞰的に(統合的に)解析することで、(属性の異なる複数の手がかりデータから)なんらかの「傾向」を検出・抽出するといった、いわゆる「マルチ・モーダル」タスクに、(「ディープ・ラーニング」以前の機械学習モデルによる手法よりもはるかに)高い精度で、取り組むことにも、道が開けたのです。

この「マルチ・モーダル」タスクですが、一例として、「画像」データと「音声」データを、単一の「ディープ・ラーニングモデル」(深層学習モデル)に入力させて、単一のモデルの中で、統合的に取り扱うことができます。

例えば、”この画像が得られたときには、この音声が流れている”という「画像と音声の対応パターン」を学習させることができます。そのような「対応パターン」を学習させた「ディープ・ラーニングモデル」(学習済みのモデル)に対して、新しい「画像」を入力することで、(学習済みモデルを用いた「推論」が自動的に行われて、)その画像に写っている場所では、画像が撮影された時点で、どのような音が流れていたのかの推定音が、(モデルから出力されて)得ることができます。

上記のモデルについて、詳しくは、Ainowの記事「Googleなど各社は、画像から音響や材質質感・3次元立体映像を推定する技術をどう商用展開するか」を参照してください。

このように、CNNモデルや、Word2Vecモデルなどの「ディープ・ラーニング」手法が、華々しく登場したことで、A.I.(人工知能)技術が一気に飛躍しはじめたのは、『ポスト・ヒューマン』が出版されてから、7年後の2012年(とその翌年の2013年)であったのです。

なお、Google社発のこの「出来事」は、「Googleの猫」として日本では知られており、米国では、その成果をまとめて発表された論文は、「キャット・ペーパー」と呼ばれています。

このあたりのいきさつは、COURRIER誌の記事「グーグル翻訳の礎となった伝説の論文「キャットペーパー」の衝撃 「グーグルと人工知能」最前線│集中連載第4回」が参考になります。

その後、画像認識以外の分野でも、「ディープ・ラーニング」の数々の「威力」を示す論文が次々に学会誌やArxiv.サイトに投稿・査読通過されることとなり、今日の「深層学習」の隆盛につながっています。

このように、2012年と2013年以後、「アテンション」機構を持ったディープ・ラーニングモデルや、Neural Turing Machineモデルや、Differential Neural Computingモデルなどの「外部記憶メモリ」接続型のディープ・ラーニングモデルなど、AIの研究・技術コミュニティで話題となった数々の歴史を画す(epoch makingな)深層学習モデルが、矢継ぎ早に論文として発表されて、AI業界がいまに至ることは、皆さま、ご周知の通りです。

「GNR論」は、ディープ・ラーニング旋風が世に登場する7年前に提唱された

以上、みてきたように、『ポスト・ヒューマン』誕生のなかで、カーツワイル氏が「GNR」論を唱えた2005年から起算して、7年も経ってから起きたのが、「ディープ・ラーニング」アルゴリズムの進展と、その技術的な成果への学会・産業界・一般世論の大々的な注目という社会現象でした。

遺伝子解読・編集技術(「G」)や、ミクロ・レベルの物質の組成構造の解析・操作技術(「N」、ナノ・テクノロジー)や、周囲の状況を「特徴表現ベクトル」によって認識して、行動系列も「特徴表現ベクトル」で(内部的に)表現する自律稼動ロボット(「R」)という「3つのテクノロジー」に対して、情報「解析・改変」技術としてのA.I.「人工知能」技術が、(これまで以上に)飛躍的に大きく影響を与えはじめたのも、カーツワイルが「GNR」論を世に唱えた2005年から数えて「7年後」からであった、ととらえることができそうです。

本連載:ディープ・ラーニングが、GNRの「パターン解読・書き換え」技術の発展に与えつづけている影響を俯瞰する

そこで、この連載記事では、2012年以降に発生した、「ディープ・ラーニングモデル」による「情報解析技術」の急速な進展によって、「G」・「N」・「R」の3つの分野における「情報パターン」の「解読」・「編集・改変」技術が、どのように進展しているのかを、いくつか論文を取り上げながら、具体的に示していくことにしたいと思います。

カーツワイル氏の2005年以降の情報発信も詳しく見ていく

カーツワイル氏の2012年刊行の著書(2018年10月現在、邦訳書は未刊行)

なお、Singularity is Near (邦訳『ポスト・ヒューマン誕生』)の刊行後に、カーツワイル氏が書いた著作としては、How to create a mindがあります。この著書は、2012年に出版されています。

Amazonの書評によると、同書の主題は、「人間の脳の動作原理を理解するために、脳をリバース・エンジニアリングした結果、得られた知見を、人間よりもさらに知的なマシン(知能機械)を生み出すために活用する」ことと設定されているようです。

In How to Create a Mind, Kurzweil presents a provocative exploration of the most important project in human-machine civilization—reverse engineering the brain to understand precisely how it works and using that knowledge to create even more intelligent machines.

2012年は、画像認識の領域で、CNNモデルが従来手法を圧倒する正解率を叩き出した記念碑的な年でした(ILSVRCコンテストと「Googleの猫」という2つの出来事の発生)。

同書は、人間と同等の知性(ある程度のパフォーマンスで、なんでもこなせる知性。「汎用」的な知性)を持った人工知能の「アルゴリズム」ないし「アーキテクチャ」(脳と同じく、複数のアルゴリズムが同時並列・非同期的に相互連結して構成させる機構)を実現するための候補技術について、カーツワイル氏が『ポスト・ヒューマン誕生』を出版してから7年後の時点で、どのような認識に到達していたのかを知ることができる一次資料です。

なお、人間と同等の知性(ある程度のパフォーマンスで、なんでもこなせる知性。「汎用」的な知性)は、Human-level artificial general intelligence, Human-level AGI.と表現されることが多いように見受けられます。

同書を読み込むことで、”脳の動作原理”と、”Human-level AGI”の候補モデルについて、2012年時点のカーツワイル氏の認識を追うことができます。

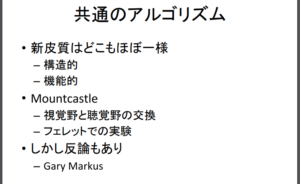

この本を解説している和文ウェブページとしては、Hatena Blog Matter Mind Meaning (2015年10月20日付け)「<書評> Ray Kurzweil 著 “How to Create a Mind”」があります。 この記事では、同書を以下にように要約しています。(以下、上記ウェブページより転載)

カーツワイルの主張で印象的だったのは以下の点だった。

- 人間の脳は基本的なパターン認識モジュールがいくつも繰り返されたものである。

- 人間の知能は階層的で、情報は低い階層から徐々に高い階層へと伝達される。

- 基本的なモジュールの動作さえ解明すれば、そのモジュールを組み合わせることにより脳のような複雑なシステムを構成する事が出来る。

- 脳が行っている計算は本質的にはコンピュータで再現できる。

- 2020年代には人間の脳全体のコンピュータシミュレーションが可能になる。

- 人間の意識は物質そのもの(ハードウェア)ではなく物質の動きのパターン(ソフトウェア)である。

特にカーツワイルの、人間の知能がいくつもの基本的なパターン認識モジュールによって構成されるという主張は説得力がある。

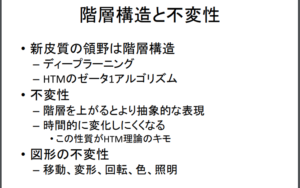

上に挙げられている各項目の中では、「人間の知能は階層的で、情報は低い階層から徐々に高い階層へと伝達される」という点が、一つ注目すべきポイントです。

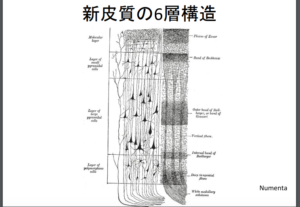

人間の大脳新皮質が6つの層(皮質)によって構成されていることは、脳の研究によって明らかにされた事実ですが、カーツワイル氏がこの点に着目していることがうかがわれます。

関連: HTM理論

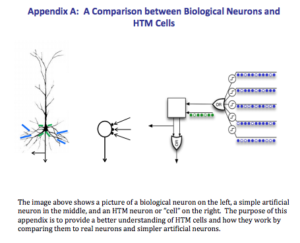

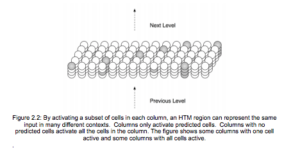

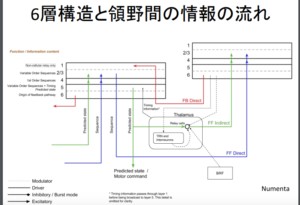

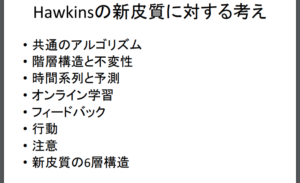

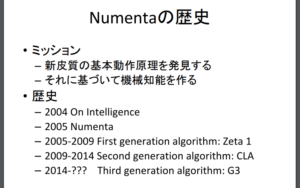

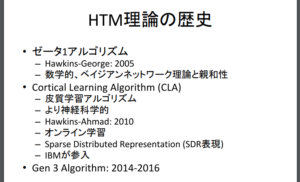

なお、このような複数の皮質が層構造をなして折り重なっている(連結している)トポロジー構成を、人工知能モデル(数理アルゴリズム・モデル)に置き換える試みとしては、J.Hawkins氏らによるHTM理論(Hierarchical temporal memoryモデル)があります。

このHTMモデルには、それぞれ機構の設計コンセプトが異なる複数のバージョンのモデルがあります。

しかし、Hawkins氏が(カーツワイル氏のThe singularity is Nearの刊行年と同じ)2005年に著した主著 On Intelligence (邦訳書は、『考える脳 考えるコンピュータ』ランダムハウス講談社)を含めて、これら各バージョンのモデルについては、いずれも、断片的な情報しか公開されていません。

提唱者であるHawkins氏が2002年に設立したNumenta社から、各バージョンのHTMモデルが提案されています。一例として、 同社からは、HIERARCHICAL TEMPORAL MEMORY including HTM Cortical Learning Algorithms, VERSION 0.2.1, SEPTEMBER 12, 2011が公開されています。

なお、このHTMモデルについては、物理学者の松田 卓氏による以下の解説スライド(講演で発表されたもの)があります。

上記のスライドで解説されているように、HTMモデルは、人間の大脳新皮質がもつ「6層構造」を、”Hierarchical”な数理モデル(=人工知能モデル)として表現しようとしているようです。

人知能モデルの研究開発には、人間の思考の原理を忠実に再現しようとする動機をもつものと、人間の思考の原理とどれだけ近いのかには関心を払わず、とにかく工学モデルとして、定義された領域で高い知的パフォーマンスを示しさえすればそれでよいという考え方に立つものの2つがあります。

以下のモデルは、上記のどちらに該当するのかは様々な捉え方がありますが、現在主流の深層ニューラル・ネットワークモデルとは異なり、ニューロン(ノード)間の結合関係を立体構造(3次元)に張らせたり、ニューロン間の結合関係に「カプセル」の包含関係を取り入れたりと、工夫を加えた例です。

Capsule Networkモデル

- [原論文] Sara Sabour & Nicholas Frosst(Google Brain)Dynamic Routing Between Capsules

- [解説記事] Aidemy Blog (2017年12月3日)「ニューラルネットワークの新技術 世界一わかりやすい”カプセルネットワーク”とは?」

- [解説記事] Qiita @hiyoko9t氏(最終更新日:2017年12月12日)「カプセルネットワークはニューラルネットワークを超えるか。」

- [英語版Wikipedia] Capsule neural network

最初に挙げた解説記事(Aidemy Blog)では、同論文を以下のように要約しています。

・従来のニューラルネットワークとの違い

では、何が従来のニューラルネットワークと違うのでしょうか?

一言でいうと、従来のニューラルネットワークが全体をその大きさで見ていたのに対して、カプセルネットワークが特徴ごとに”ベクトル”で見ているという点です。

もう少し詳しく説明します。

例えば顔を認識する際に、従来のニューラルネットワークであるCNN(Convolution Newral Network) はそれが目なのか、鼻なのか、口なのかにしか着目していませんでした。(画像左)

(中略)

しかし、今回のカプセルネットワークはそれらの特徴がどのような関係で配置されているのかまで認識します。(画像右)

つまり、カプセルネットワークは個々の特徴を独立的に捉え、それぞれがどのような関係にあるのかということにまで着目します。カプセルネットワークの名前の由来がここにあります。ひとつひとつのカプセルに詰まったニューロンが個々の特徴に着目し、それぞれの関係に着目するのです。

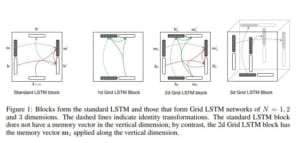

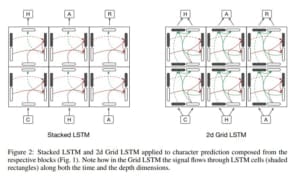

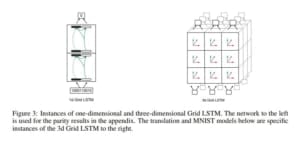

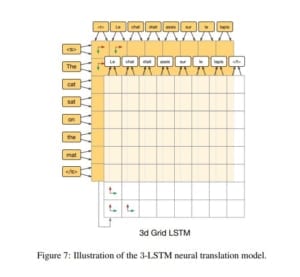

Grid-LSTMモデル

- [原論文] Nal Kalchbrennerほか (Google DeepMind)Grid Long Short-Term Memory

カーツワイル氏の公式ウェブページ

2018年現在の同氏の認識・見解を知るためには、リアルタイムに掲載内容が更新されているウェブページがもっとも効果的です。カーツワイル氏は、自身のNGR論とシンギュラリティ論について、最新の認識を発信するためのウェブページ “Kurzweil accelerating intelligence” を運用されています。

このウェブページ(トップページ)には、2018年10月27日現在、以下の特設ページへのリンクが張られています。

上記は、「N」(ナノテクノロジー)技術の成果を取りまとめたレポート(2018年10月現在)のようです。その冒頭部分は、以下で始まります。

Dear readers,

Today’s novel materials are crafted in modern labs, with innovations in molecule-level engineering. As our knowledge of nature’s fundamentals grows, and our tools get better — scientists are able to reach deep into the atoms of everyday matter and transform it into something new.

We’re exploring the atomic frontier. Researchers split-up and combine basic molecules to make ever-more complex substances: coatings, fibers, fabrics, plastics, silicon, liquids, gels, crystals, metals, organics, synthetics. They make super-substances and building blocks: with futuristic performance, durability, flexibility, miniaturization, and strength. But along with the benefits, these new materials — that aren’t found in nature — pose risks or challenges to the environment, the economy, and the planet’s ability to sustain its delicate ecology.

また、このレポートの導入部分(Introduction)は、以下の書き出しで始まっています。

Getting It Right — from the start

Developing a circular economy for novel materials.A new generation of products from novel materials.

Novel materials go hand-in-hand with improving technologies. For example:

- carbon fiber enables lighter weight, more fuel efficient vehicles

- bio-plastics promise to be superior to fossil fuel derived plastics

真っ先にあげられている成果として、次の2点が挙げられています。

Novel materials go hand-in-hand with improving technologies. For example:

- carbon fiber enables lighter weight, more fuel efficient vehicles

- bio-plastics promise to be superior to fossil fuel derived plastics

「N」(ナノテクノロジー)については、先述のウェブページのトップページからは、以下へのリンクも張られています。

また、「R」(ロボット工学+人工知能技術)については、以下へのリンクが張られています。

小野寺によるこの連載記事「カーツワイルの「GNR」に「I」(情報科学・情報工学)が含まれていない理由を考える」では、GNR論(シンギュラリティ論)を提唱した『ポスト・ヒューマン誕生』(原題:The singularity is Near)では主題として語られたなかった、「情報パターン」の生成・解読・書き換え技術であるGとNとRの技術発展に対して、2012年以降に飛躍したディープ・ラーニング手法の各種技術(深層学習モデル関連技術)がどのように影響を与えているのかを、紹介します。

その際、カーツワイル氏当人の”その後の見解”を、2012年当時の著書How to create a mindと同氏のウェブページ “Kurzweil accelerating intelligence” を主な情報源として、追いかけていきます。

また、カーツワイル氏が言及していない技術論文の中で、関連する論文(膨大な本数の論文があります)のうち、ごく一部の論文をサンプリング的に取り出して、紹介していきます。